Celery配置详解:打造高效稳定的任务队列系统

发布时间: 2024-10-04 10:16:57 阅读量: 31 订阅数: 41

# 1. Celery任务队列系统概述

在现代的网络应用中,特别是高流量、高并发的环境下,对任务处理的效率和稳定性要求日益提升。Celery是一个异步任务队列/作业队列,基于分布式消息传递。它专注于实时操作,同时也支持任务调度。本章我们将介绍Celery的基本概念、优势以及它的应用场景,为后续章节深入探讨其配置、优化和实践应用打下基础。

## 1.1 Celery简介

Celery是由Python编写的开源任务队列框架,其核心是基于消息代理的系统来实现异步任务的分发与执行。它具有以下几个显著特点:

- **简单易用**:通过简单的配置即可上手,支持快速部署和集成。

- **灵活高效**:灵活的任务执行策略、高度可配置的任务调度、以及广泛的消息代理支持。

- **可扩展性**:可轻松扩展到成千上万的机器,处理大量消息。

## 1.2 Celery的优势

在处理长时间运行的任务或者大量数据的处理任务时,同步执行方式可能会导致系统阻塞或超时。Celery的优势主要体现在以下几个方面:

- **异步执行**:任务可以被放入队列,立即返回结果,提升用户体验。

- **任务调度**:支持定时任务的执行,可以用来替代传统的cron作业。

- **并行处理**:支持在多台机器上分布式运行任务,提高整体处理能力。

- **容错处理**:遇到任务执行失败时,Celery可以重新执行任务,减少数据丢失的风险。

通过以上介绍,我们可以看到Celery是一个功能强大且灵活的任务队列系统。在接下来的章节中,我们将进一步探索Celery的安装、配置以及如何将其运用到实际项目中以解决复杂问题。

# 2. ```

# 第二章:Celery基本配置与安装

## 2.1 Celery的工作原理和架构

### 2.1.1 异步任务处理机制

异步任务处理是Celery任务队列系统的核心功能之一,它允许用户将耗时的任务发送到消息队列中,而不是在Web服务器上直接执行。这样,Web服务器可以立即返回响应给客户端,而实际的任务处理将在后台由一个或多个工作进程(worker)完成。

**工作流程**:

1. 用户发起一个任务请求,将任务提交给Celery。

2. Celery将任务信息序列化后发送到消息代理(Broker)。

3. Celery worker从消息代理中获取任务并执行。

4. 执行结果会被存储在结果后端(Result Backend)中,等待查询。

5. 最终用户可以查询这个结果。

### 2.1.2 Celery核心组件解析

- **Broker**: 负责接收任务并将其分发给工作节点。常见的Broker有RabbitMQ, Redis等。

- **Worker**: 实际执行任务的进程。它可以并行处理多个任务。

- **Task**: 应用程序定义的一个可重用的任务。每个任务都继承自`celery.Task`类。

- **Result Backend**: 存储任务执行结果的地方,可选的后端有数据库、缓存系统等。

- **Beat**: 一个定时调度器,用于周期性地发送任务到Broker。

## 2.2 Celery的安装与环境准备

### 2.2.1 Celery的依赖关系

在安装Celery之前,需要安装其依赖包,包括但不限于以下几种:

- Python环境(建议使用Python 3.6及以上版本)

- 消息代理(例如RabbitMQ或Redis)

- 一个结果后端存储(例如Redis或数据库)

安装依赖的常见方法是使用`pip`包管理器:

```bash

pip install celery

```

### 2.2.2 搭建开发环境的步骤

搭建Celery开发环境可以按照以下步骤进行:

1. **安装消息代理**:

- RabbitMQ:可以使用Docker容器快速安装。

- Redis:同样可以通过Docker或者使用系统包管理器安装。

2. **创建Celery应用**:

```python

from celery import Celery

app = Celery('my_project',

broker='pyamqp://guest@localhost//',

backend='db+sqlite:///results.sqlite')

```

3. **定义任务**:

```python

@app.task

def add(x, y):

return x + y

```

4. **启动Worker**:

```bash

celery -A my_project worker --loglevel=info

```

5. **添加任务到队列**:

```python

result = add.delay(4, 4)

print(result.get())

```

## 2.3 Celery基础配置方法

### 2.3.1 配置文件的结构和内容

Celery可以通过配置文件来自定义设置。配置文件通常是一个Python模块,它包含了一系列的变量赋值语句。例如,一个简单的`celery.py`配置文件如下:

```python

broker_url = 'pyamqp://guest@localhost//'

result_backend = 'db+sqlite:///results.sqlite'

timezone = 'UTC'

enable_utc = True

```

### 2.3.2 配置参数详解

配置参数是Celery灵活性的体现,下面是一些重要的配置参数及其用途:

- **broker_url**: 指定消息代理的URL。

- **result_backend**: 指定结果存储的后端。

- **timezone**: 设置默认的时区,以解析ETA和到期时间。

- **enable_utc**: 是否使用UTC时间作为内部时钟。

**表格:基础配置参数对比**

| 参数名 | 描述 | 默认值 | 可用值 |

|-----------------|-----------------------------------|------|--------------------------|

| broker_url | 消息代理的连接字符串。 | None | 例如:'pyamqp://guest@localhost//' |

| result_backend | 结果存储的后端类型及连接字符串。 | None | 例如:'db+sqlite:///results.sqlite' |

| timezone | Celery内部时间设置。 | UTC | 'UTC', 'America/New_York'等 |

| enable_utc | 是否使用UTC作为内部时钟。 | False| True, False |

以上这些参数在实际部署和使用过程中,应根据实际的业务需求和运行环境进行相应调整。

```

这是第一章“Celery基本配置与安装”的详尽内容。接下来的内容将会继续深入探讨Celery的高级配置与优化策略。

# 3. Celery进阶配置与优化

在深入探讨了Celery的基础配置后,本章节将把关注点集中在进阶配置与优化上。随着应用程序的发展和任务的复杂化,合理地配置Celery将极大提高任务的执行效率,并确保系统的稳定性和可靠性。

## 3.1 高级消息传输选项

### 3.1.1 不同消息代理的配置

Celery支持多种消息代理服务,包括RabbitMQ、Redis和Amazon SQS等。合理选择消息代理对于提高系统的整体性能至关重要。

以RabbitMQ为例,它的性能和稳定性都非常优秀,适合大规模部署。配置Celery使用RabbitMQ作为消息代理的过程如下:

1. 安装RabbitMQ服务器。

2. 修改Celery的配置文件,指定broker_url为'amqp://', 这是RabbitMQ的默认URL方案。

3. 确保Celery worker和Beat进程都能访问RabbitMQ。

示例配置代码如下:

```python

# celery.py

from kombu import Queue, Exchange

from celery import Celery

app = Celery('tasks', broker='amqp://')

# 配置消息队列的交换机和队列

app.conf.task_queues = (

Queue('default', Exchange('default'), routing_key='default'),

)

app.conf.task_routes = {

'tasks.my_task': {'queue': 'default', 'exchange': 'default'},

}

```

上述配置定义了一个名为'default'的队列,所有未明确指定队列的任务都会被发送到这个队列。

### 3.1.2 消息队列的性能调优

调优消息队列主要涉及消息代理的配置,以确保消息吞吐量和稳定性。以RabbitMQ为例,以下是一些常用的性能调优方法:

- **队列持久化**:确保队列在RabbitMQ重启后依然存在。

- **消息持久化**:确保即使RabbitMQ重启,消息也不会丢失。

- **连接限制**:通过设置最大连接数,控制资源使用。

- **内存和磁盘警告阈值**:根据服务器能力设置合理的内存和磁盘使用警告阈值。

这些设置可以在RabbitMQ的配置文件中进行调整,例如:

```properties

# rabbitmq.config

[{rabbit, [{queue_master_locator, min_memory}]},

{rabbitmq_management, []}].

```

这里指定了队列主节点位置的策略为最小内存使用,有助于性能优化。

## 3.2 任务调度与定时执行

### 3.2.1 Beat的工作机制

Celery Beat是Celery的一个组件,它负责周期性地检查定时任务,并将任务推送到消息队列。了解Beat的工作机制对于确保任务准时执行至关重要。

Beat通过读取配置文件或指定的任务列表,周期性地检查任务的调度信息。每当到达预定的时间点,Beat就会发送调度任务到消息队列中。

通常,Beat运行在独立的进程中,不断循环检查任务的调度时间,并进行任务的派发。

### 3.2.2 任务的周期性和准时性配置

任务的准时性和周期性配置是通过在Celery任务定义中设置`crontab`或`IntervalSchedule`实现的。这允许任务在预定的时间间隔执行,或者按照特定的cron时间表执行。

例如,设定一个任务每天早上9点执行:

```python

from celery.schedules import crontab

@app.on_after_configure.connect

def setup_periodic_tasks(sender, **kwargs):

# 每天的9:00执行

sender.add_periodic_task(86400.0, my_task.s(), name='add every day')

```

这里使用了`crontab`的替代方法`add_periodic_task`,其中`86400.0`代表每天的秒数,`my_task.s()`代表要执行的任务。

## 3.3 异常处理和监控

### 3.3.1 错误重试与任务状态跟踪

在Celery中,任务可能因为各种原因失败,包括网络问题、服务器故障等。正确配置错误重试机制和任务状态跟踪,对于提升用户体验和系统鲁棒性至关重要。

通过设置任务的`retry_backoff`参数,可以控制任务失败后重试的时间间隔。例如,可以让任务在失败后先等待10秒钟再重试,如果再次失败,则每次等待时间翻倍。

```python

@app.task(bind=True, retry_backoff=True, retry_backoff_max=60)

def my_task(self):

# 任务实现代码

```

在任务状态跟踪方面,可以利用Celery提供的结果后端(如Redis或数据库)来记录每个任务的状态和执行结果。

### 3.3.2 系统监控和告警设置

有效的系统监控和告警机制是保证Celery系统稳定运行的关键。通过监控任务执行时间、重试次数和错误率,可以及时发现并解决潜在问题。

设置监控和告警的常用工具包括Prometheus、Grafana以及Celery自己的监控面板。以下是使用Prometheus来监控Celery的一些基本步骤:

1. 安装Prometheus和相关插件。

2. 修改Celery的配置文件,启用Prometheus监控。

3. 配置Prometheus服务器,添加Celery为监控目标。

4. 启动Prometheus服务,并在Grafana中创建相应的仪表板。

监控任务的执行状态和性能指标,能帮助开发者快速定位问题并进行优化。

# 4. Celery实践应用案例

## 4.1 Celery在Web应用中的集成

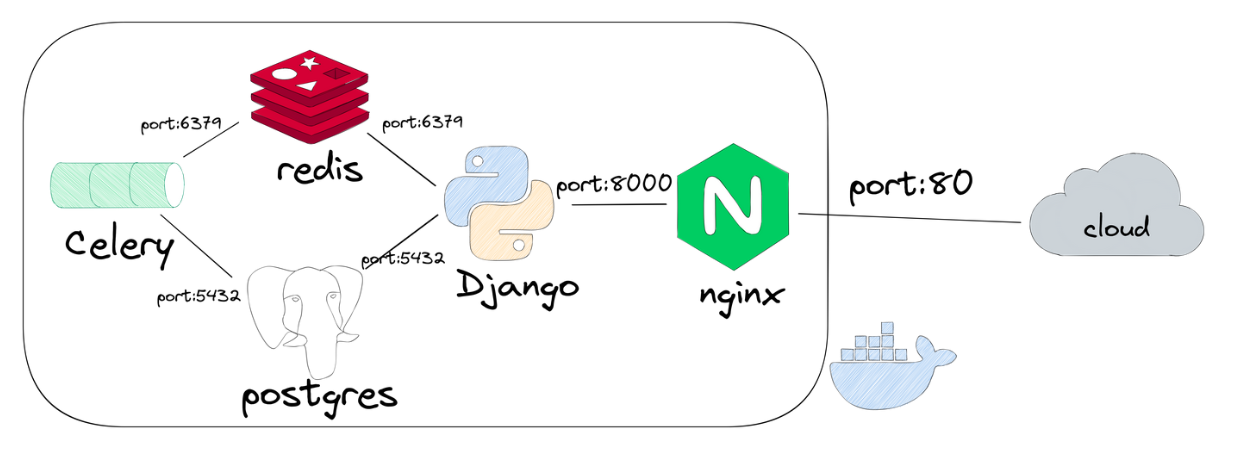

### 4.1.1 Django与Celery的集成示例

Django作为一款强大的Python Web框架,其与Celery的集成可以极大地提升后台任务处理的效率。我们将通过一个简单的例子来展示如何将Celery集成到Django项目中,并实现一个异步任务处理。

首先,确保你的Django项目已经安装了Celery。如果还没有安装,可以通过以下命令安装:

```shell

pip install celery

```

然后,创建一个Celery实例,并在Django的`settings.py`文件中配置它:

```python

# settings.py

# 添加Celery配置

CELERY_BROKER_URL = 'redis://localhost:6379'

CELERY_RESULT_BACKEND = 'redis://localhost:6379'

# 自动发现Django应用中的任务

CELERY_APP_NAME = 'my_project'

CELERY_AUTODISCOVER_TASKS = True

```

接下来,我们定义一个简单的任务:

```python

# my_project/tasks.py

from celery import shared_task

@shared_task

def add(x, y):

"""简单的加法任务"""

return x + y

```

在Django视图中调用这个任务:

```python

# my_project/views.py

from django.http import HttpResponse

from .tasks import add

def my_view(request):

# 启动异步任务

result = add.delay(4, 4)

return HttpResponse(f"Task result will be here: {result.id}")

```

以上就是集成Celery到Django的基本步骤。通过这种方式,你可以将耗时的数据处理操作、发送邮件、执行定时任务等操作异步化,提高Web应用的性能和响应速度。

### 4.1.2 Flask与Celery的集成示例

Flask是一个用Python编写的轻量级Web应用框架。同样地,Celery可以与Flask集成,实现任务的异步处理。以下是集成Flask和Celery的步骤。

首先,安装Celery包:

```shell

pip install celery

```

然后,创建一个Celery实例:

```python

# celery.py

from celery import Celery

app = Celery(__name__)

app.config_from_object('celery_config') # 导入配置

```

在`celery_config.py`文件中配置Celery:

```python

# celery_config.py

BROKER_URL = 'redis://localhost:6379'

CELERY_RESULT_BACKEND = 'redis://localhost:6379'

```

定义一个Celery任务:

```python

# tasks.py

from celery import shared_task

@shared_task

def multiply(x, y):

"""简单的乘法任务"""

return x * y

```

最后,在Flask应用中调用这个任务:

```python

# app.py

from flask import Flask

from celery import current_app

from tasks import multiply

app = Flask(__name__)

@app.route('/multiply')

def multiply_view():

# 启动异步任务

task = multiply.delay(5, 5)

return f'Task ID: {task.id}'

if __name__ == '__main__':

app.run()

```

通过上述示例,我们可以看到Celery与Flask的集成过程也非常直接,其核心在于创建任务并调用它们。

## 4.2 分布式任务处理实例

### 4.2.1 多进程和分布式计算

Celery支持多进程分布式任务处理,允许开发者将任务分配到多个工作节点上执行,非常适合于需要进行大规模并行计算的场景。Celery使用消息代理来协调任务的分发,而工作节点(也称为workers)则从队列中取出任务进行处理。

下面将展示如何设置一个分布式任务处理环境:

首先,启动多个Celery worker:

```shell

celery -A my_project worker --concurrency=4 -n worker1@%h

celery -A my_project worker --concurrency=4 -n worker2@%h

```

这里,`--concurrency=4`参数设置了每个worker同时执行四个任务。`-n`参数后面跟随的是worker的名称,这有助于识别不同的worker。

然后,配置任务以在所有可用的workers之间平均分配:

```python

from celery import shared_task

@shared_task

def average(numbers):

return sum(numbers) / len(numbers)

# 启动分布式任务处理

from celery import group

from random import sample

numbers = sample(range(1000), 100)

job = group([average.s(numbers) for _ in range(10)])

job.apply_async()

```

在这个例子中,我们使用了Celery的`group`功能来创建一个任务组,并平均分配了多个任务。每个`average`任务都会计算一个随机数字列表的平均值。通过`apply_async`方法,这些任务可以被分散到所有worker上并行处理。

### 4.2.2 大数据处理与任务分发策略

在处理大数据集时,有效地分发任务至关重要。Celery提供了一个灵活的策略,可以根据任务的负载和工作节点的性能来调整任务分配。为了优化数据处理,开发者可以设计特定的分发策略。

例如,可以基于任务负载的大小或者数据分片来决定任务的分发。一个简单的策略是,对大数据集进行分片,并为每个分片分配一个独立的任务。

```python

@shared_task

def process_data(data_slice):

# 处理数据分片

return process(data_slice)

def distribute_tasks(data, num_workers):

# 分发任务到多个worker

slices = [data[i::num_workers] for i in range(num_workers)]

group = [process_data.s(slice) for slice in slices]

return group.apply_async()

```

在这个例子中,`process_data`函数接受一个数据分片并进行处理。`distribute_tasks`函数负责将整个数据集切分成多个分片,并为每个分片创建一个`process_data`任务,然后将这些任务通过`group.apply_async`方法异步执行。

## 4.3 Celery生产环境配置

### 4.3.1 部署Celery到生产环境

在生产环境中部署Celery任务队列需要谨慎规划和精细配置。生产环境的部署涉及到多个方面的考量,包括任务的持久性、高可用性、监控以及安全等等。

确保配置了高可用的消息代理,如RabbitMQ或Redis集群,来保证消息队列的可靠性。接着,配置工作节点在系统崩溃或重启后能自动恢复运行。此外,任务的监控和告警也应被设置好,以便及时发现和响应问题。

一个基本的生产级部署步骤如下:

1. **消息代理部署**:确保消息代理服务如RabbitMQ或Redis能够提供高性能和高可用性。

2. **Celery worker配置**:根据任务负载,配置合理数量的Celery worker和它们的并发任务数。

3. **任务队列的监控**:集成监控工具,如Celery Flower,来实时监控任务队列和worker状态。

4. **日志与告警**:配置日志记录和告警系统,以监控和记录任务执行情况及潜在问题。

### 4.3.2 性能监控与日志记录

性能监控和日志记录对于维护一个健康的Celery生产环境至关重要。Celery提供了多种工具和方法来监控任务执行情况和系统状态。

使用Celery Flower,管理员可以实时监控任务队列,检查任务的状态,重启失败的任务,以及查看历史任务记录等。以下是一个基本的配置示例:

```shell

flower -A my_project --address=*.*.*.* --port=5555

```

在Flower的Web界面中,可以查看到所有Celery worker的状态,排队和执行中的任务列表,以及任务执行的历史记录。

关于日志记录,Celery支持多种日志系统,如Python内置的`logging`模块。以下是配置Celery日志的基本步骤:

```python

# settings.py

LOGGING = {

'version': 1,

'disable_existing_loggers': False,

'formatters': {

'standard': {

'format': '[%(asctime)s] %(levelname)s [%(name)s:%(lineno)s] %(message)s',

'datefmt': '%d/%b/%Y %H:%M:%S'

},

},

'handlers': {

'console': {

'level': 'DEBUG',

'class': 'logging.StreamHandler',

'formatter': 'standard'

},

},

'loggers': {

'celery': {

'handlers': ['console'],

'level': 'DEBUG',

},

},

}

```

在这个配置中,我们将日志输出到控制台,同时包含时间戳和日志级别等信息。这样做可以方便地跟踪任务执行过程中的所有事件。

在实际部署中,Celery的日志配置可以根据需要进一步细化,例如使用文件记录日志,或者集成到外部的集中式日志系统中。

通过合理的配置和监控,我们可以确保Celery任务队列的高可用性和性能,为应用提供稳定可靠的后台任务处理能力。

# 5. Celery安全性和可靠性

Celery作为一款强大的异步任务队列系统,其在实际应用中不仅需要保证任务执行的效率,更需要确保系统的安全性和可靠性。在处理敏感信息或关键任务时,安全性显得尤为重要。而系统的可靠性则直接影响到业务的连续性和稳定性。本章将深入探讨Celery的安全配置要点,以及如何处理任务失败和重启策略,确保系统的安全和稳定运行。

## 5.1 Celery的安全配置要点

安全是任何应用系统都不可忽视的一个方面,特别是在分布式系统中。Celery虽然不是专门设计用来处理敏感数据的工具,但合理的安全配置可以让它变得更加可靠和安全。

### 5.1.1 权限控制和认证机制

为了保证Celery系统的安全,首先需要考虑的是权限控制和认证机制。在默认情况下,Celery的消息代理是不进行任何认证的,因此可能面临恶意用户或程序的攻击。在生产环境中,你应当启用消息代理的认证机制,例如RabbitMQ中的用户名和密码认证,或者Redis的requirepass配置指令,以确保只有授权的用户才能访问任务队列。

```yaml

# RabbitMQ配置示例

rabbitmq:

host: 'localhost'

port: 5672

user: 'celeryuser'

password: 'celerypass'

```

### 5.1.2 消息加密和传输安全

消息的加密可以防止数据在传输过程中被截获。虽然Celery本身不提供消息加密的功能,但可以通过配置消息代理来实现,比如使用STOMP协议进行传输时,可以启用SSL/TLS来加密传输数据。此外,也可以在消息发送前在应用层进行加密,接收端解密。

```python

import requests

from requests.packages.urllib3.util.ssl_ import create_urllib3_context

# 创建SSL上下文

context = create_urllib3_context()

context.load_cert_chain(certfile='/path/to/certfile.pem')

# 使用SSL上下文进行安全的HTTP请求

response = requests.get('***', verify=context)

```

## 5.2 处理任务失败和重启策略

在处理任务时,难免会遇到任务失败的情况。Celery提供了丰富的工具来处理这些失败的任务,并根据不同的策略进行重试或重启。

### 5.2.1 失败任务的自动重试机制

Celery允许你通过配置来设定任务失败时的自动重试机制。任务重试可以帮助处理临时的错误,比如网络波动或者短暂的服务不可用。通过`CELERY_MAX_RETRIES`和`CELERY_DEFAULT_RETRY_DELAY`等配置项,你可以定义任务的最大重试次数和重试间隔。

```python

# Celery配置项示例

CELERY_MAX_RETRIES = 3

CELERY_DEFAULT_RETRY_DELAY = 5 # 以秒为单位

# 任务定义示例

@app.task(bind=True)

def my_task(self):

try:

# 执行任务相关操作

pass

except Exception as exc:

raise self.retry(exc=exc)

```

### 5.2.2 灾难恢复和数据备份

除了重试机制,确保任务的可靠执行还需要考虑灾难恢复和数据备份。对于某些任务来说,失败后需要进行更复杂的恢复操作,或者需要手动介入。对于这种情况,Celery提供了任务失败后的回调机制,可以用来执行如发送警报邮件、记录日志等操作。

```python

@app.task(bind=True)

def my_task(self):

try:

# 执行任务相关操作

pass

except Exception as exc:

# 记录失败信息到日志系统

logging.error(f"任务 {self.request.id} 失败,原因: {exc}")

# 发送失败通知邮件

send_failure_email(self.request.id, str(exc))

# 可以选择重试或标记任务失败

self.retry(exc=exc)

```

在高可靠性的业务场景中,定期备份任务相关的数据是一个良好的实践。无论是任务的原始数据还是执行的结果,确保在出现重大故障时可以快速恢复到之前的状态,对于保障业务连续性至关重要。

本章通过介绍Celery的安全配置要点和任务失败处理策略,帮助读者确保Celery系统的安全性和可靠性,以应对生产环境中可能出现的各种情况。这些最佳实践能够为你的Celery应用提供更加安全和稳定的运行环境。

# 6. Celery的未来和扩展性

随着云计算和容器化技术的兴起,任务队列系统面临着新的挑战与机遇。Celery作为流行的异步任务队列/作业队列库,如何适应新的技术趋势并保持其在处理大规模、分布式任务时的领先地位至关重要。

## 6.1 Celery的新版本特性和展望

### 6.1.1 新版本中引入的新功能

随着每个新版本的发布,Celery不断增加新的特性和改进现有功能以提高效率和易用性。例如,在Celery 5.0中,开发团队引入了对Python 3.8的全面支持,并增强了任务调度器的可配置性。

此外,新版本中引入的其他特性还包括:

- 优化了内存使用,减少了不必要的缓存和对象创建。

- 引入了更详细的日志记录,帮助开发者更好地理解内部事件和潜在的性能瓶颈。

- 提高了可扩展性,使得Celery在大型分布式系统中更加强大。

开发社区也在为Celery贡献各种插件,增强了它在特定场景下的适用性,比如在大数据处理、机器学习任务调度等方面。

### 6.1.2 社区维护和未来发展方向

社区的贡献和反馈是Celery持续改进和发展的关键。未来,Celery可能会侧重于以下几个方向:

- **增强与云原生技术的兼容性**:随着Kubernetes等容器编排工具的流行,Celery的集成和支持会成为重点,以便更容易地在云环境中部署和扩展任务。

- **智能化调度**:通过引入机器学习算法,Celery可以更智能地分配任务,提高资源利用率和任务执行效率。

- **安全性提升**:加强身份验证和授权机制,确保任务队列在不安全网络中的安全运行。

## 6.2 Celery与云服务的整合

### 6.2.1 云服务中的任务调度和扩展

云服务为任务队列系统提供了弹性和扩展性优势。Celery可以通过集成云服务来实现任务的自动扩展:

- **AWS EC2**:使用Auto Scaling Group与Celery结合,根据任务负载动态增加或减少实例数量。

- **Google Cloud Platform**:利用Google App Engine和Kubernetes Engine来运行Celery Workers,实现按需扩展。

- **Azure**:借助Azure虚拟机规模集功能,实现Celery任务的灵活调度和负载均衡。

### 6.2.2 自动扩展与资源优化策略

为了最大化资源利用效率,Celery需要与云服务的自动扩展功能紧密结合。例如,可以使用以下策略:

- **监控和触发器**:监控任务队列长度和完成时间,设置触发器来自动调整资源。

- **成本优化**:利用云服务的定价模型,对非高峰时段的任务执行进行成本优化。

- **任务优先级**:根据业务需求,为不同类型的Celery任务设置优先级,确保高优先级任务得到及时处理。

为了实现这些策略,可能需要开发或使用现有的Celery云扩展插件,这些插件能够与云服务API进行交互,实现资源的智能管理。

总结而言,Celery的未来在于它如何与新兴的云服务和容器化技术相结合,以及如何利用这些技术来提升性能、安全性和可维护性。随着技术的发展和社区的共同努力,Celery在未来继续保持其作为任务队列解决方案中的佼佼者是大有希望的。

0

0