Celery在微服务架构中的应用:分布式系统的任务处理

发布时间: 2024-10-04 10:51:46 阅读量: 40 订阅数: 34

架构解密.从分布式到微服务

# 1. 微服务架构与任务处理概述

在现代的软件开发领域,微服务架构已经成为了构建大型应用的主流范式。这种架构模式主张将复杂的单体应用分解为一组小型服务,每个服务运行在自己的进程中,并且通过轻量级的通信机制进行交互。这种架构的出现,使得分布式系统的开发、部署和运维变得更加高效。

微服务的核心优势在于其提供了高度的可伸缩性、敏捷性和弹性。然而,随着服务数量的增加,管理和协调这些服务所面临的挑战也在增加,特别是任务处理方面。在微服务架构中,处理异步任务变得至关重要。它不仅能够提升系统的响应性,还能提高资源利用率和系统的整体性能。

本章将详细介绍微服务架构下任务处理的重要性,并引入Celery——一个强大的分布式任务队列库,它是解决异步任务处理问题的理想选择。Celery能够轻松地集成到各种微服务环境中,为应用提供了一个可靠、高效和可扩展的任务队列系统。

# 2. Celery基础与安装配置

Celery是基于分布式消息传递的异步任务队列/作业队列,它专注于实时操作,同时也支持任务调度。在深入探讨Celery的高级特性和最佳实践之前,理解其基本组件和安装配置至关重要。

### 2.1 Celery简介与组件解析

#### 2.1.1 Celery的设计理念与适用场景

Celery的设计理念是使得任务可以异步执行,这样可以将耗时的操作从主程序流程中剥离出来,从而提高程序的响应性能。它被广泛应用于Web应用程序,可以用于处理邮件发送、文件上传、数据处理等耗时任务。

适用场景包括但不限于以下几点:

- 需要并行处理大量任务时,比如数据分析和处理。

- 网站用户请求响应时间敏感,需要将耗时操作异步处理。

- 处理高频率的定时任务,如发送周期性报告。

#### 2.1.2 核心组件:Broker、Backend与Worker

Celery由三个核心组件构成:Broker(消息代理)、Backend(结果后端)和Worker(工作进程)。

- **Broker(消息代理)**:负责接收任务并将其传递给Worker。Celery支持多种Broker,包括RabbitMQ、Redis等。Broker的选择取决于项目需求和性能考量。

- **Backend(结果后端)**:负责存储任务执行的结果。与Broker类似,Celery也支持多种Backend,可以是同一个Broker也可以是不同的服务,例如数据库、Redis。

- **Worker(工作进程)**:负责接收任务并执行,它们从Broker中获取任务,执行完毕后可能还会将结果存储到Backend中。

### 2.2 Celery的安装与环境搭建

#### 2.2.1 选择合适的消息代理

安装Celery之前,首先需要选择一个消息代理。RabbitMQ和Redis是Celery最常用的两种Broker。RabbitMQ使用AMQP协议,对消息的保证级别较高,但其在高并发场景下的性能不如Redis。Redis基于内存,读写速度极快,但在网络分区或者重启时可能会导致数据丢失。

#### 2.2.2 Celery环境的配置步骤

安装Celery非常简单,可以直接使用pip进行安装:

```bash

pip install celery

```

接下来,配置Celery环境通常涉及编辑一个名为`celery.py`的文件,该文件通常位于项目的主目录下。以下是一个基础的配置示例:

```python

from celery import Celery

# 设置默认的 broker URL 和结果后端

app = Celery('myproject', broker='redis://localhost:6379/0', backend='redis://localhost:6379/0')

# 从 settings.py 中自动从CELERY_ 设置加载配置

app.config_from_object('django.conf:settings', namespace='CELERY')

# 自动发现任务

app.autodiscover_tasks()

```

#### 2.2.3 常见问题及解决方案

在安装和配置Celery时,常见问题及解决方案如下:

- **问题**:Broker连接问题。

- **解决方案**:确保Broker服务正在运行,比如检查RabbitMQ和Redis服务状态,并尝试修复网络连接问题。

- **问题**:任务执行超时或无法在后台运行。

- **解决方案**:检查配置文件中是否有语法错误,确保Celery工作进程被正确启动。

### 2.3 Celery的启动与管理

#### 2.3.1 Worker的启动与任务分配

启动Celery Worker是通过命令行完成的,启动命令如下:

```bash

celery -A myproject worker --loglevel=info

```

这条命令会启动一个Worker实例,它会从指定的Broker中获取任务,并根据任务类型分配给相应的任务队列。

#### 2.3.2 高级配置:任务队列与优先级

在Celery中,可以通过队列来管理不同优先级的任务。配置方法如下:

```python

app.conf.task_queue_max_priority = 10

```

然后为任务指定队列和优先级:

```python

@app.task(queue='high')

def send_email(users):

# 发送邮件给用户

pass

```

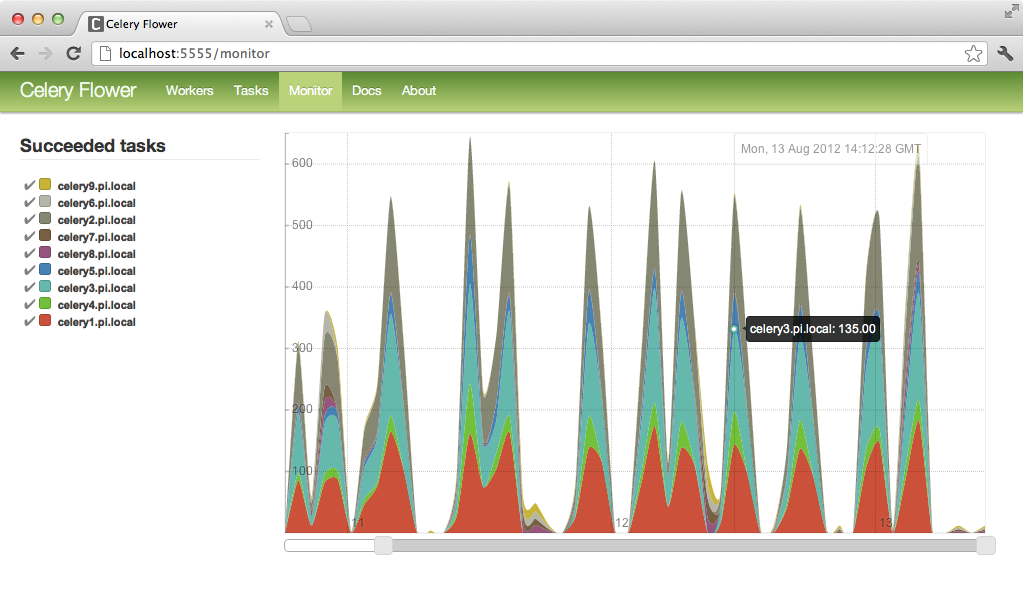

#### 2.3.3 监控与维护:日志和状态检查

监控Celery任务执行情况和Worker状态是确保系统稳定的关键。Celery提供了一个命令` celery status`来检查Worker状态,而日志则可以记录详细的执行过程,对于问题诊断至关重要。

```bash

celery status

```

监控日志的级别和输出可以配置在`celery.py`中的`app.conf`里:

```python

app.conf.update(

task_serializer='json',

accept_content=['json'], # Accept JSON content

result_serializer='json',

timezone='UTC',

enable_utc=True,

worker_log_color=False, # Set this to True to get colorized logs

)

```

在本章节的介绍中,详细探讨了Celery的基础知识,包括其设计理念、核心组件以及安装配置步骤。下一章节将深入探讨Celery的进阶实践技巧,包括任务定义、错误处理和性能优化等重要主题。

# 3. Celery进阶实践技巧

## 3.1 任务定义与参数传递

### 3.1.1 定义任务:函数、类与装饰器

在微服务架构中,任务通常是一些需要被异步处理的函数或方法。在Celery中,任务的定义是通过装饰器来实现的,其中 `@app.task` 是最常见的装饰器,用于将普通函数转换成Celery任务。此外,任务也可以通过类的形式进行定义,这种形式通常用于需要保持状态的任务。

```python

from celery import Celery

app = Celery('tasks', broker='pyamqp://guest@localhost//')

@app.task

def add(x, y):

return x + y

class MyTask(Task):

def run(self, x, y):

return x + y

```

- 在上述示例中,`add` 函数使用了 `@app.task` 装饰器来定义为一个Celery任务。此方式简单明了,适合快速定义简单的任务。

- `MyTask` 类是一个继承自 `celery.Task` 的自定义任务类,适合实现更复杂的业务逻辑,例如任务重试、状态跟踪等。

任务定义后,可以通过Celery应用实例来调用这些任务:

```python

result = add.delay(4, 4) # 使用延迟执行

result = MyTask().apply_async((10, 20)) # 类任务也可以通过apply_async方法异步执行

```

### 3.1.2 参数序列化与压缩

在分布式系统中,任务的参数需要在不同节点间传输。为了确保高效和安全地传输,Celery默认使用JSON序列化数据。然而,对于非基本类型数据(例如大型对象或二进制数据),JSON序列化可能不够高效或直接不支持。

这时可以考虑使用其他序列化方法,例如 `

0

0