【支持向量机:理论进阶深度讲解】:软间隔与核函数的秘密完全揭露!

发布时间: 2024-09-03 18:24:20 阅读量: 153 订阅数: 61

支持向量机:理论、算法与拓展 电子书

# 1. 支持向量机简介与核心概念

支持向量机(SVM)是一种强大的机器学习模型,广泛应用于分类和回归任务中。本章旨在简要介绍SVM的核心概念,帮助读者建立起对SVM基本原理的初步了解,并为进一步深入学习打下坚实基础。

## 1.1 SVM的分类机制

SVM通过寻找最优的决策边界(超平面)来实现分类任务。在最简单的情况下,即线性可分问题中,SVM的核心在于最大化两类样本之间的间隔。这一决策边界被称作最大间隔超平面,它使得距离最近的异类数据点(支持向量)之间的距离达到最大。

## 1.2 SVM的工作原理

本质上,SVM的工作原理可以概括为:

- **线性可分支持向量机**:当数据线性可分时,通过优化问题,找到最佳的分隔超平面。

- **软间隔与松弛变量**:当数据集存在噪声或重叠时引入软间隔概念,通过引入松弛变量调整每个样本点的间隔,允许一定程度的分类错误。

- **核函数的引入**:对于非线性问题,通过核函数将数据映射到更高维空间中,从而在新空间中实现线性分割。

SVM的这些核心概念共同构成了其在各种场景下高效分类的理论基础,为后续章节中深入探讨SVM的数学原理及应用提供了铺垫。

# 2. 支持向量机的数学基础

### 2.1 线性可分支持向量机

#### 2.1.1 最大间隔分类器

线性可分支持向量机(SVM)的核心思想是寻找一个决策边界,该边界能够将不同类别的数据尽可能地分开,同时确保间隔最大化。在数学上,这可以被表达为一个二次优化问题,目标函数是最大化两个类别之间的边界距离。

为了形式化这个概念,我们考虑一个二维空间中的数据集。假设我们的数据集包含两个类别的点,分别是正类和负类。我们想要找到一条直线(在高维空间中是一个超平面)来分开这两类点,而且要求这条直线能够尽可能地远离最近的数据点。

用数学语言来描述,假设有一个超平面方程为 `wx + b = 0`,其中 `w` 是超平面的法向量,`b` 是偏置项。对于数据点 `x_i`,它与超平面的距离可以通过以下公式计算:

```

距离 = |w*x_i + b| / ||w||

```

我们的目标是最大化最近点到超平面的距离,即最小化 `||w||`,同时保证所有正类点在超平面的一侧,所有负类点在另一侧。这可以通过求解以下优化问题来实现:

```

minimize: ||w||^2

subject to: y_i(w*x_i + b) >= 1 for all i

```

这里的 `y_i` 是类别标签,取值为正或负1。上述优化问题可以通过拉格朗日乘子法来求解。

#### 2.1.2 对偶问题与拉格朗日乘子法

拉格朗日乘子法是一种将有约束优化问题转换为无约束优化问题的方法。在支持向量机中,它被用来将原始问题转换为对偶问题,这样做不仅有助于求解,而且还可以引入核函数来处理非线性可分问题。

对于一个优化问题:

```

minimize: f(x)

subject to: g_i(x) <= 0, i = 1, ..., m

```

我们可以引入拉格朗日乘子 `α_i`,构造拉格朗日函数 `L`:

```

L(x, α) = f(x) + Σα_i * g_i(x)

```

其中 `α_i >= 0`。现在问题转化为寻找 `L` 的最小值:

```

minimize: max_α L(x, α)

```

对于SVM问题,拉格朗日函数可以写作:

```

L(w, b, α) = 1/2 * ||w||^2 - Σα_i * [y_i(w*x_i + b) - 1]

```

通过求解 `L` 关于 `w` 和 `b` 的最小值,然后对 `α` 求最大值,我们得到原问题的对偶形式:

```

maximize: Σα_i - 1/2 ΣΣα_i * α_j * y_i * y_j * x_i * x_j

subject to: Σα_i * y_i = 0, α_i >= 0

```

这个对偶问题是一个二次规划问题,可以通过标准的优化方法求解。求解后得到的 `α` 可以用来确定支持向量,并计算出最终的决策函数 `f(x)`。

### 2.2 软间隔与松弛变量

#### 2.2.1 软间隔的概念

在现实世界的应用中,数据往往不是完全线性可分的。即使在理想条件下,数据也可能因为噪声或异常值而无法被完美分开。这时候,我们需要一种机制来允许一些数据点违反间隔的约束,这被称为软间隔支持向量机。

在软间隔支持向量机中,我们引入松弛变量 `ξ_i` 来衡量每个点违反间隔约束的程度。对于每个数据点,如果它满足 `y_i(w*x_i + b) >= 1 - ξ_i`,则认为该点是被正确分类的。`ξ_i` 越大,表示该点离决策边界越近或者分类错误的程度越大。

我们的目标变成了最小化 `||w||^2` 和 `Σξ_i` 的组合,同时控制 `ξ_i` 的值以确保不会过度放松约束。这可以通过优化以下问题来实现:

```

minimize: ||w||^2 + C * Σξ_i

subject to: y_i(w*x_i + b) >= 1 - ξ_i, ξ_i >= 0

```

这里的 `C` 是一个超参数,它决定了对违反间隔约束的惩罚程度。

#### 2.2.2 Hinge损失函数

为了更容易求解带有松弛变量的优化问题,我们可以引入Hinge损失函数。Hinge损失是一个非凸、分段线性的函数,定义为:

```

L(y_i(w*x_i + b)) = max(0, 1 - y_i(w*x_i + b))

```

当数据点被正确分类时,即 `y_i(w*x_i + b) >= 1`,Hinge损失为0。如果数据点的间隔小于1,损失线性增加,这与松弛变量 `ξ_i` 成正比。

因此,软间隔支持向量机的目标可以表达为最小化下面的优化问题:

```

minimize: ||w||^2 + C * Σmax(0, 1 - y_i(w*x_i + b))

```

这个问题可以通过梯度下降或其他优化算法来求解。

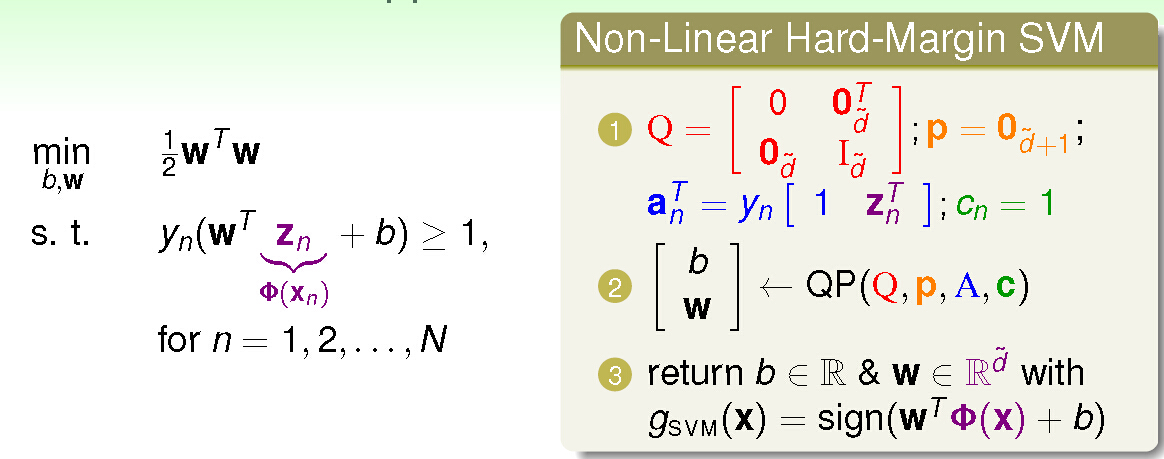

### 2.3 核函数的引入

#### 2.3.1 核技巧的理论基础

核函数的概念来源于再生核希尔伯特空间理论。核函数允许我们在原始空间中计算数据点在高维特征空间中的内积,而无需显式地进行特征映射。这一技巧极大地简化了非线性SVM的计算过程。

设 `Φ: R^n -> H` 是从原始空间到高维特征空间的映射。核函数 `K(x_i, x_j) = <Φ(x_i), Φ(x_j)>` 允许我们在高维空间中计算数据点的内积。如果我们能够找到一个核函数 `K`,那么我们就可以在高维空间中应用线性SVM,即使我们不知道映射函数 `Φ`。

#### 2.3.2 常见核函数解析

核函数的选择取决于数据的特性以及问题的性质。以下是几种常用的核函数及其特点:

- 线性核:`K(x_i, x_j) = x_i * x_j`。适用于线性可分数据,是最简单的核函数。

- 多项式核:`K(x_i, x_j) = (x_i * x_j + 1)^d`。其中 `d` 是多项式的阶数,`d > 1` 时核函数能够捕捉特征之间的非线性关系。

- 高斯径向基函数(RBF)核:`K(x_i, x_j) = exp(-γ||x_i - x_j||^2)`。其中 `γ` 是一个超参数,RBF核能够无限维映射,适合于处理非线性问题。

- Sigmoid核:`K(x_i, x_j) = tanh(a <x_i, x_j> + c)`。其中 `a` 和 `c` 是超参数,Sigmoid核函数具有神经网络的性质。

选择合适的核函数通常需要结合先验知识以及通过交叉验证等方法进行实验。核函数的引入极大地提升了SVM的灵活性和应用范围。

# 3. 支持向量机的优化算法

## 3.1 序列最小优化(SMO)算法

### 3.1.1 SMO算法原理

SMO(Sequential Minimal Optimization)算法是由John C. Platt在1998年提出的一种用于训练支持向量机(SVM)的有效方法。它将大问题分解成一系列最小问题,这些问题可以快速并行地解决。

SMO算法的基本思想是:在每次迭代中,选择两个拉格朗日乘子(alpha)进行优化,同时固定其他参数不变。这种方法的优点在于可以简化问题,因为两个变量的优化问题可以解析求解,无需使用复杂的优化算法如二次规划(QP)求解器。此外,选择两个变量进行优化,可以更有效地处理大规模数据集。

### 3.1.2 SMO算法的实现细节

SMO算法的实现包括初始化、选择alpha对、计算误差、选择第二个alpha以及更新过程等关键步骤。具体实施时,需要进行以下操作:

1. 选择一对要优化的alpha对。SMO选择的是违反KKT条件最严重的一对alpha。KKT条件是指在最优解处,拉格朗日乘子必须满足某些条件。

2. 对选中的alpha对进行优化。该过程可以分为两步,首先确定一个alpha的优化区间,然后在该区间内找到最优的alpha值。

3. 更新模型参数。一旦找到最优的alpha值,就需要更新模型权重向量,以及偏置项。

下面是一个简化版的SMO算法伪代码实现:

```python

def SMO(train_data, labels, C, max_iter):

# 初始化alpha和误差缓存

alpha = [0 for _ in range(len(labels))]

errors = [0 for _ in range(len(labels))]

for _ in range(max_iter):

num_changed = 0

# 第一轮遍历所有alpha对

for i in range(len(labels)):

alpha_i = alpha[i]

E_i = error[i]

if (labels[i] * E_i < -tol and alpha_i < C) or (labels[i] * E_i > tol and alpha_i > 0):

# 在这里随机选择第二个alpha进行优化

j = select_second_alpha(labels, i)

alpha_j = alpha[j]

E_j = error[j]

# 保存旧的alpha值

alpha_i_old = alpha_i

alpha_j_old = alpha_j

# 计算两个alpha的上下界

if labels[i] != labels[j]:

L = max(0, alpha_j - alpha_i)

H = min(C, C + alpha_j - alpha_i)

else:

L = max(0, alpha_i + alpha_j - C)

H = min(C, alpha

```

0

0