【超参数调优:SVM性能极致提升】:手把手教你寻找最优解!

发布时间: 2024-09-03 18:05:16 阅读量: 196 订阅数: 56

# 1. 支持向量机(SVM)简介

支持向量机(Support Vector Machine,简称SVM)是机器学习领域中一个强大且应用广泛的分类和回归模型。SVM的原理基于统计学习理论中的结构风险最小化原则,它旨在寻找能够正确分类数据的最优决策边界。在分类问题中,最优决策边界指的是能够使得分类间隔最大化的超平面,即寻找数据间最大间隔的边界,从而达到良好的泛化能力。

在SVM中,数据点被视作n维空间中的点,其中n是特征的数量。其关键在于如何确定这些数据点之间的边界。对于非线性可分的数据,SVM通过使用核函数来将原始特征映射到高维空间,从而寻找到在这个新空间中线性可分的超平面。

SVM在多种应用场景中表现突出,比如在文本分类、生物信息学、手写识别等领域都有广泛的应用。然而,要实现SVM的最佳性能,调优其超参数至关重要。下一章将深入探讨SVM的超参数以及它们对模型性能的影响。

# 2. 理解SVM超参数及其影响

### 2.1 SVM超参数概述

#### 2.1.1 核函数的选择与作用

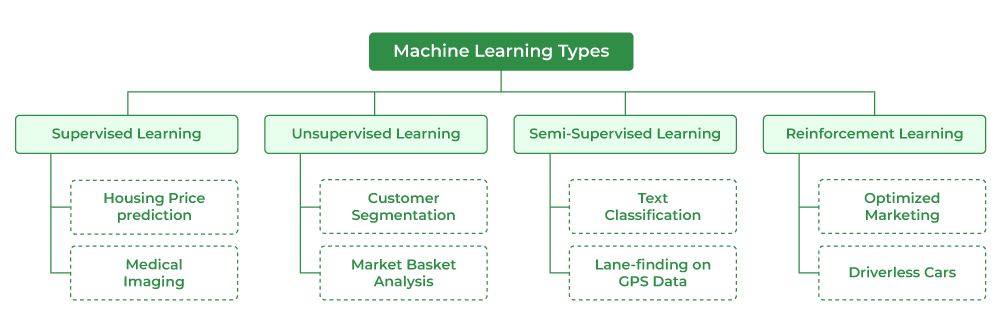

支持向量机(SVM)是一种强大的监督式学习模型,广泛用于分类和回归分析。SVM的超参数中,核函数的选择对于模型的表现至关重要。核函数的作用是将数据从原始空间映射到更高维的空间中,使得原本在原始空间线性不可分的数据在新的空间中可以被一个超平面所分割。

核函数常见的有线性核(linear)、多项式核(polynomial)、径向基函数(radial basis function, RBF)以及sigmoid核等。不同的核函数有其特定的用途和参数,比如RBF核通过参数γ(gamma)来决定数据映射的复杂度。选择合适的核函数可以让模型在特定的任务中表现得更优秀。

下面是一个使用不同核函数的代码示例:

```python

from sklearn import svm

import numpy as np

# 创建一个简单的数据集

X = np.array([[2, 0], [1, 1], [2, 3], [3, 3], [1, 2]])

y = np.array([0, 1, 1, 1, 0])

# 使用不同的核函数

kernels = ['linear', 'poly', 'rbf', 'sigmoid']

for kernel in kernels:

clf = svm.SVC(kernel=kernel)

clf.fit(X, y)

print(f"Kernel: {kernel}")

print("Coefficients:", clf.coef_)

print("Intercept:", clf.intercept_)

print("Support vectors:", clf.support_vectors_)

```

在这段代码中,我们创建了一个简单的二维数据集,并分别用四种不同的核函数对SVM进行训练。输出结果可以帮助我们理解不同核函数下模型的权重系数、截距和支撑向量的变化。

#### 2.1.2 正则化参数C的影响

在SVM模型中,正则化参数C是另一个重要的超参数,它用于控制对错误分类的惩罚程度。参数C的值越小,代表对错误分类的容忍度越高,模型的复杂度越低;反之,C值越大,模型对错误分类的惩罚越严厉,可能导致模型过拟合。

参数C的作用可以这样理解:它控制了模型对数据集中的每个样本点的关注度,以及允许多少比例的样本点位于边界错误的一侧。因此,在选择C值时需要权衡模型的泛化能力和对数据的拟合度。

接下来,我们通过调整C值,观察模型的决策边界如何变化:

```python

import matplotlib.pyplot as plt

from sklearn.datasets import make_moons

from sklearn.svm import SVC

X, y = make_moons(n_samples=100, noise=0.15, random_state=42)

h = .02 # 网格中的步长

# 建立SVM模型,使用RBF核

svc = SVC(kernel="rbf", C=1E6)

# 训练模型

svc.fit(X, y)

# 绘制决策边界

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, s=20, edgecolors='k')

lim = plt.axis()

xx, yy = np.meshgrid(np.arange(lim[0], lim[1], h), np.arange(lim[2], lim[3], h))

Z = svc.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.pcolormesh(xx, yy, Z, cmap=plt.cm.coolwarm)

plt.axis(lim)

plt.show()

```

这段代码创建了一个SVM模型,并使用了较大的C值(1E6),意味着模型尝试最大化间隔宽度,从而得到更严格的间隔分类。通过观察决策边界和数据点的关系,可以看到C值对模型决策边界的影响。我们还可以修改C值,观察结果如何变化。

### 2.2 SVM超参数对模型性能的影响

#### 2.2.1 C参数与模型复杂度

正则化参数C在SVM中直接关联到模型的复杂度和过拟合的风险。随着C值的增加,模型对训练数据中的每个数据点的偏差施加更强的惩罚。这迫使SVM找到一个更小的间隔(即支持向量之间的距离更小),以更精确地分类训练数据,从而导致模型可能更复杂,泛化能力降低。

从直观上理解,一个较小的C值意味着模型倾向于有较大的间隔和较少的支持向量,也就是说模型更简单。而在C值较大时,为了尽可能减少分类错误,模型会选择更小的间隔,最终可能只包含很少甚至一个支持向量,导致模型复杂度增加。

为了更好地了解这一点,我们可以考虑下面的示例:

```python

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import classification_report

import matplotlib.pyplot as plt

from mlxtend.plotting import plot_decision_regions

X, y = make_classification(n_samples=200, n_features=2, n_redundant=0, n_informative=2, random_state=1, n_clusters_per_class=1)

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=10)

# 不同C值的模型训练

for C in [0.1, 1, 100]:

svc = SVC(kernel='rbf', C=C)

svc.fit(X_train, y_train)

y_pred = svc.predict(X_test)

print(f"C={C}")

print(classification_report(y_test, y_pred))

plot_decision_regions(X_test, y_test, clf=svc, legend=2)

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.title(f'SVM with C={C}')

plt.show()

```

在这段代码中,我们首先生成了一个具有两个特征的分类数据集,并将其分割为训练集和测试集。然后使用不同的C值训练SVM模型,并绘制了决策区域的图形,以此来观察C值变化对模型复杂度和决策边界的影响。通过输出的分类报告,我们也能评估不同复杂度模型在测试集上的性能。

#### 2.2.2 核函数与数据分布适应性

核函数的选择与数据的分布直接相关。不同类型的数据集可能需要不同的核函数来获得最佳性能。如果数据集的特征之间存在线性关系,那么线性核可能就足够了;如果数据是线性不可分的,那么使用RBF或其他非线性核函数可能更加合适。

核函数实际上是将输入空间映射到一个新的特征空间,从而使得原本线性不可分的数据在这个新

0

0