大数据与数据挖掘:集成挑战与未来机遇

发布时间: 2024-09-08 08:30:27 阅读量: 28 订阅数: 66

# 1. 大数据与数据挖掘概述

随着信息化时代的快速发展,大数据已成为企业竞争与决策的重要资产。数据挖掘作为分析大数据核心价值的技术之一,引起了各界的广泛关注。本章将为你展开大数据与数据挖掘的概览,从而为理解整个领域打下坚实的基础。

首先,大数据与数据挖掘并不是孤立的概念,而是相互依存,相互促进。大数据涵盖了从不同来源收集的大量、多样化的数据集合,它不仅包含传统数据库中的结构化数据,还包括半结构化和非结构化数据。数据挖掘则是从这些数据中发现模式、趋势、关联及其它有用信息的过程。

数据挖掘在今天已经不是一个新鲜的术语,它在商业智能、市场分析、网络安全等多个领域拥有广泛的应用。在下一章,我们将深入探讨数据挖掘的定义、目的、技术框架及其在模式发现中的具体应用。通过理解数据挖掘的核心原理和方法,我们可以更加高效地探索和利用大数据的潜力,为决策提供科学依据。

# 2. 数据挖掘的基础理论

### 2.1 数据挖掘的定义与目的

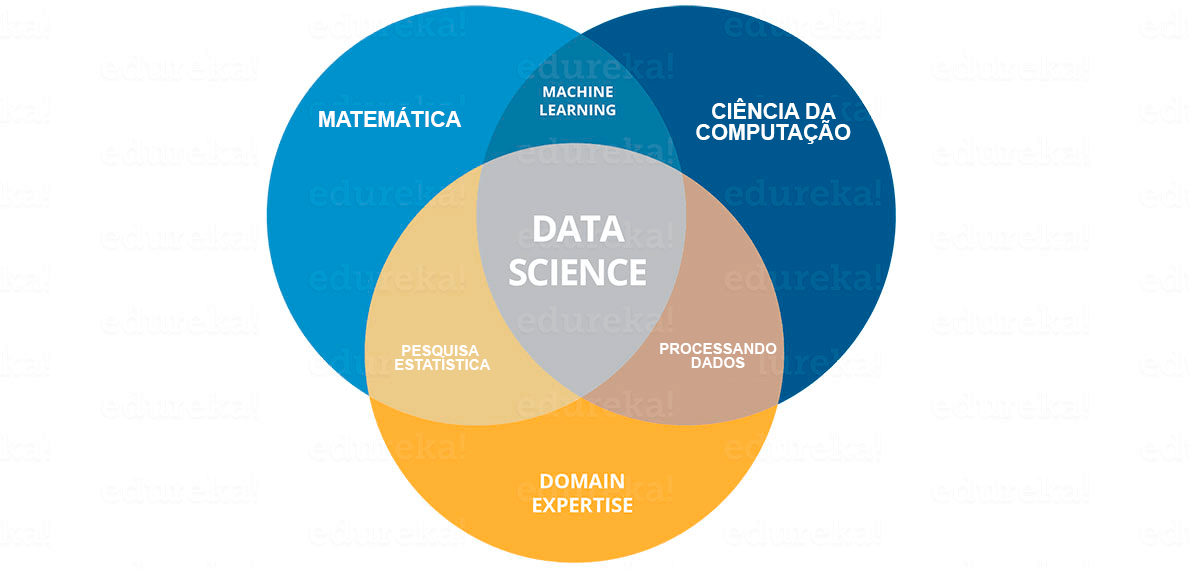

#### 2.1.1 数据挖掘的学科背景

数据挖掘是一个交叉学科领域,它起源于数据库系统、统计学、机器学习、信息检索、模式识别、人工智能以及数据可视化等多个学科。在20世纪80年代,随着计算机技术的快速发展和数据存储能力的大幅提高,人们开始探索如何从大量数据中提取有价值信息的方法。数据挖掘技术的核心在于从数据集中发现隐藏的、有价值的知识,它能够揭示数据间的复杂关联和模式,进而为决策提供支持。

在定义上,数据挖掘是从大量、不完全、有噪声、模糊的实际数据中,提取隐含在其中的、人们事先不知道但又潜在有用的信息和知识的过程。它采用数学算法,通过模式识别、统计分析以及机器学习等手段,对数据进行处理,目的是揭示隐藏在数据背后的有用信息和知识。

#### 2.1.2 数据挖掘的主要任务

数据挖掘的主要任务可被概括为以下几点:

- **分类**:将数据项分配到预定义的类别或标签中。例如,在银行信贷审核系统中,预测客户贷款是否能够按时还款,将客户分为“可信赖”和“不可信赖”两类。

- **聚类**:将相似的数据项分组在一起。聚类分析不依赖预定义的类标签,而是试图在数据中发现自然的分组。如市场细分,将相似的客户行为分组,以便更有效地定向营销。

- **关联规则学习**:发现数据项之间的有趣关系。在购物篮分析中,通过挖掘顾客购买商品之间的关联规则,可以用来进行交叉销售或捆绑销售。

- **回归分析**:预测数值型数据的目标变量。例如,通过历史销售数据预测未来某段时间内的销售量。

- **序列模式发现**:在时间序列数据中发现数据随时间变化的趋势和模式。例如,在股票交易数据中寻找价格波动的模式。

- **文本挖掘**:从非结构化的文本数据中提取知识。例如,从社交媒体上的帖子中分析公共情绪趋势。

- **网络挖掘**:从网络结构和网络流数据中提取信息。例如,识别社交网络中的关键影响者或者网络结构中的异常行为。

### 2.2 数据挖掘的技术框架

#### 2.2.1 数据预处理方法

数据预处理是数据挖掘中非常关键的一个环节,它涉及到数据清理、数据集成、数据变换、数据规约等步骤,目的是将原始数据转化为适合进行数据挖掘处理的数据形式。高质量的数据预处理可以提高挖掘结果的准确性和效率。

- **数据清理**:包括处理缺失值、异常值、噪声等。例如,使用均值、中位数或众数填充缺失值,或者用统计方法识别和处理异常值。

- **数据集成**:将来自多个数据源的数据合并到一个一致的数据集中。这涉及到解决数据不一致性、数据冗余等问题。

- **数据变换**:将数据缩放到特定范围,或者转换为适合挖掘的形式。常见的方法有标准化、归一化等。

- **数据规约**:减少数据集的大小但尽量保持数据的完整性。可以采用抽样、维度规约、数据压缩等技术。

```python

# Python 代码示例:数据预处理

import pandas as pd

from sklearn.impute import SimpleImputer

from sklearn.preprocessing import StandardScaler

# 加载数据集

data = pd.read_csv("dataset.csv")

# 处理缺失值

imputer = SimpleImputer(strategy='mean')

data_imputed = imputer.fit_transform(data)

# 数据标准化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data_imputed)

```

在上述代码中,`SimpleImputer`用于处理缺失值,而`StandardScaler`用于标准化数据,使其均值为0,标准差为1。

#### 2.2.2 数据挖掘算法的分类

数据挖掘算法可以按照不同的标准分类,但通常根据算法的功能和应用领域,将其分为以下几类:

- **预测模型**:包括回归分析、分类算法等,这些算法在历史数据的基础上建立模型,预测未来数据的值。

- **描述性模型**:关联规则学习、聚类分析等属于描述性模型,它们用来发现数据中的模式和结构,但不直接用于预测。

- **混合模型**:结合预测和描述性模型的特点,提供更复杂的分析,例如分类树结合了规则发现和预测能力。

#### 2.2.3 数据挖掘结果的评估

评估数据挖掘模型的性能是数据挖掘流程中的重要步骤,这可以帮助数据科学家判断模型的优劣,并对模型进行调整优化。

- **分类模型的评估**:通常使用混淆矩阵、准确率、召回率、F1分数、ROC曲线等指标。

- **回归模型的评估**:通过计算均方误差(MSE)、决定系数(R²)等来评估模型。

- **聚类模型的评估**:轮廓系数、Calinski-Harabasz指数、Davies-Bouldin指数等指标用于聚类模型的评估。

### 2.3 数据挖掘中的模式发现

#### 2.3.1 关联规则学习

关联规则学习是数据挖掘中用于发现大规模数据集中不同项之间有趣关系的方法。一个典型的关联规则形式是“如果A发生,则B也发生”,其中A和B是数据集中的事件。

一个著名的算法是Apriori算法,它通过迭代方式,逐层搜索频繁项集。频繁项集是指在数据集中出现次数超过一定阈值的项集。通过频繁项集,可以发现项集之间的强关联规则。

```mermaid

flowchart LR

A[开始] --> B[设置最小支持度]

B --> C[生成候选项集]

C --> D{检查频繁项集}

D -- 是 --> E[生成关联规则]

D -- 否 --> B

E --> F[评估规则]

F --> G[结束]

```

在上述的mermaid流程图中,描述了关联规则学习的一个简单流程。在实际应用中,频繁项集的生成可能涉及复杂的算法细节。

#### 2.3.2 聚类分析

聚类分析是一种无监督学习方法,它将数据集中的对象根据相似性分成多个类或簇。聚类旨在使得同一簇内的对象相似度最大化,而不同簇内的对象相似度最小化。

最常用的聚类算法包括K-均值算法(K-means)、层次聚类(Hierarchical clustering)、DBSCAN等。每种算法都有其特定的应用场景和优缺点。

```python

# Python 代码示例:K-means聚类

from sklearn.cluster import KMeans

# 假设data_matrix是数据集矩阵

kmeans = KMeans(n_clusters=3)

kmeans.fit(data_matrix)

# 聚类结果

labels = kmeans.labels_

```

#### 2.3.3 分类与回归分析

分类和回归分析是预测模型的两种主要

0

0