【深度学习透明度挑战】:专家揭秘如何实现深度模型的透明化

发布时间: 2024-09-03 08:10:48 阅读量: 161 订阅数: 49

# 1. 深度学习透明度的必要性

在当今高度依赖数据驱动决策的世界中,深度学习已经成为推动技术创新的核心力量。然而,随着这些技术的普及和应用范围的扩大,人们开始越来越关注模型的透明度问题。透明度不仅关系到技术的可解释性,更直接影响到用户的信任和接受程度。

## 1.1 透明度在深度学习中的作用

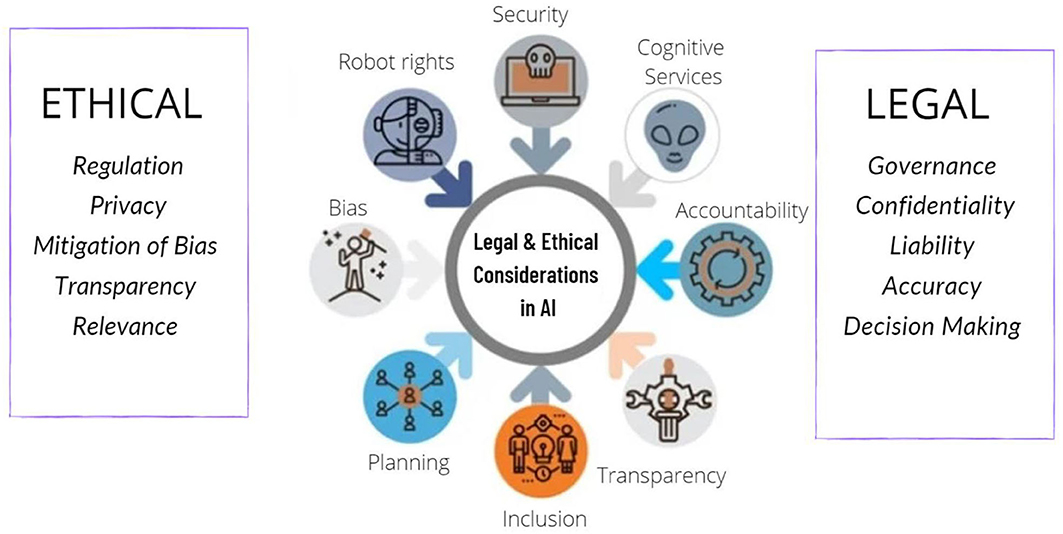

透明度在深度学习领域至关重要,它涉及到模型的决策过程能否被清晰地解释给用户或监管机构。缺乏透明度的模型可能被视为“黑箱”,这不仅会导致信任危机,还可能带来伦理和法律方面的问题。

## 1.2 透明度与社会责任

在敏感领域,如医疗、金融和自动驾驶,透明度更是承担着重要的社会责任。例如,医生和患者需要理解一个AI诊断系统的推荐依据,银行需要解释其信贷评分模型的决策逻辑,自动驾驶系统需要向监管机构证明其安全性。

透明度问题的解决不仅仅是一个技术挑战,更是深度学习模型获得广泛社会接受和长期发展的关键。

# 2. 深度学习模型的理论基础

在当今高度数字化的世界,深度学习已经成为推动科技进步的重要力量。然而,随着模型复杂度的增加,深度学习模型的“黑箱”特性越来越引起人们的关注。为了确保这些模型的公正性、可靠性和可解释性,了解深度学习模型的理论基础至关重要。本章将详细探讨深度学习模型的工作原理,以及如何从理论层面来评估和提高模型透明度。

## 2.1 深度学习模型的工作原理

### 2.1.1 神经网络的基本组成

神经网络是深度学习模型的核心,由输入层、隐藏层和输出层组成。每个层由多个神经元(节点)组成,神经元之间通过权重连接。神经元接收输入,进行加权求和和激活函数处理,最终产生输出。

#### 神经元模型

每个神经元可以看作是一个简单的信息处理单元。数学上,神经元的输出 \( y \) 可以表示为:

```math

y = f(\sum_{i=1}^{n} w_{i}x_{i} + b)

```

其中,\( x_{i} \) 是输入信号,\( w_{i} \) 是对应的权重,\( b \) 是偏置项,\( f \) 是激活函数。

#### 激活函数

激活函数为神经网络引入非线性因素,使得网络可以学习和模拟复杂的函数映射。常见的激活函数包括Sigmoid、ReLU和Tanh。

```python

import numpy as np

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def relu(x):

return np.maximum(0, x)

def tanh(x):

return np.tanh(x)

```

### 2.1.2 前向传播与反向传播机制

前向传播是神经网络处理输入数据并产生输出的过程,而反向传播算法则用于训练神经网络。它通过计算损失函数关于权重的梯度来调整权重,从而最小化损失函数。

#### 前向传播

在前向传播中,输入数据从输入层开始,逐层传递到隐藏层,最终到达输出层。每一层的输出都作为下一层的输入。

#### 反向传播

反向传播算法利用链式法则计算损失函数关于每个权重的导数,然后通过梯度下降法或其他优化算法更新权重。

```python

def backward_propagation(loss, weights):

# 计算损失函数关于权重的梯度

gradients = ... # 这里需要根据具体的损失函数和网络结构来计算梯度

# 更新权重

new_weights = weights - learning_rate * gradients

return new_weights

```

## 2.2 模型透明度的理论框架

### 2.2.1 透明度的定义和度量

模型透明度是指能够理解模型的决策逻辑和依据的程度。它分为面向开发者的透明度(内部透明度)和面向用户的透明度(外部透明度)。

#### 定义

透明度可以定义为对模型行为的观察和理解的能力。一个好的透明度指标能够直观地反映模型的工作原理和决策过程。

#### 度量

透明度的度量通常包括定性和定量两种方法。定性方法通过专家评估或用户调查来获取透明度信息,而定量方法则依赖于算法输出的一些量化指标。

```python

def calculate_transparency(model):

transparency = 0

# 通过模型的可解释性指标来计算透明度

# 例如,通过特征重要性评分或模型的复杂度来度量

return transparency

```

### 2.2.2 透明度与模型性能的关系

透明度和模型性能之间存在一定的权衡。一般来说,透明度较高的模型可能在性能上会有所牺牲,但透明度较低的模型则可能导致信任问题和理解难度。

#### 权衡

研究者和工程师需要在模型复杂度、性能和透明度之间寻找平衡点。例如,使用决策树模型可能相对透明,但在处理复杂任务时性能可能不如深度神经网络。

```mermaid

graph LR

A[模型选择] --> B[深度神经网络]

A --> C[决策树]

B --> D[性能高,透明度低]

C --> E[透明度高,性能有限]

```

#### 策略

提高透明度并不一定需要牺牲太多性能。采用适当的解释性工具和方法可以在保持高性能的同时提高透明度。

```python

def improve_transparency(model):

# 采取措施提高模型透明度

# 例如使用可视化技术或添加解释层

return modified_model

```

通过上述章节的讨论,我们对深度学习模型的基础和透明度的理论基础有了更加深入的理解。本章的内容为后续章节中探讨实现深度模型透明度的技术手段和实践案例分析奠定了坚实的基础。在接下来的章节中,我们将继续探索如何通过具体的工具和技术手段来提高模型的透明度,并分析在不同领域中透明度的实现和挑战。

# 3. 实现深度模型透明度的技术手段

## 3.1 可解释AI的工具和方法

### 3.1.1 特征重要性评分

深度学习模型的黑箱特性常常让研究者和应用者难以理解其决策过程,特别是涉及到复杂数据和任务时,例如金融风险评估和医疗诊断。特征重要性评分是提高透明度的关键技术之一,它可以帮助我们识别出对模型预测结果贡献最大的特征,从而使模型决策过程更加透明。

为了实现特征重要性评分,常用的方法包括:

- **基于梯度的方法**:例如,梯度加权类激活映射(Grad-CAM)通过分析神经网络中特定类别的激活图来可视化模型关注区域。

- **基于排列的方法**:例如,随机排列特征重要性(Permutation Feature Importance)通过破坏特征值与预测结果的关联性,测量性能指标的变化来评估特征的重要性。

- **基于模型的方法**:例如,使用贝叶斯模型或树模型集成等方法来提供特征重要性评分。

以随机排列特征重要性为例,代码实现如下:

```python

from sklearn.inspection import permutation_importance

from sklearn.ensemble import RandomForestClassifier

# 假设X_train是训练数据集,y_train是标签,model是训练好的模型

importances = permutation_importance(model, X_train, y_train)

sorted_idx = importances.importances_mean.argsort()

# 打印特征重要性评分

for idx in sorted_idx[::-1]:

print(f"Feature: {feature_names[idx]} Score: {importances.importances_mean[idx]}")

```

以上代码中,`permutation_importance`函数计算了每个特征对于模型预测性能的贡献,`importances_mean`属性提供了特征重要性的评分,并且根据评分对特征进行排序。

### 3.1.2 可视化技术

可视化技术是实现深度学习透明度的另一个重要手段。通过可视化,可以直观地展示模型的内部工作原理和决策边界,以及数据在模型内部的流动过程。

常见的可视化技术包括:

- **权重可视化**:可视化网络中每一层的权重分布,帮助理解模型学习到的特征。

- **激活图可视化**:例如Grad-CAM可以可视化卷积神经网络中的高级特征图,显示模型对特定类别的预测所关注的区域。

- **类激活映射(CAM)**:在图像分类任务中,CAM技术可以标识出图像中哪些区域对最终的预测结果起到了决定性的作用。

利用可视化技术,研究者可以更好地理解模型的决策过程,调整和优化模型结构和参数。下面是一个简化的CAM可视化代码示例:

```python

import torch.nn.functional as F

import numpy as np

import cv2

from torchvision import models

from torchvision.transforms import Compose, Resize, ToTensor

from PIL import Image

# 加载预训练的模型并设置为评估模式

model = models.resnet50(pretrained=True)

model.eval()

# 图像预处理

input_tensor

```

0

0