【企业AI透明化实践】:可解释性最佳实践秘籍

发布时间: 2024-09-03 08:53:41 阅读量: 64 订阅数: 49

# 1. 企业AI透明化概念与重要性

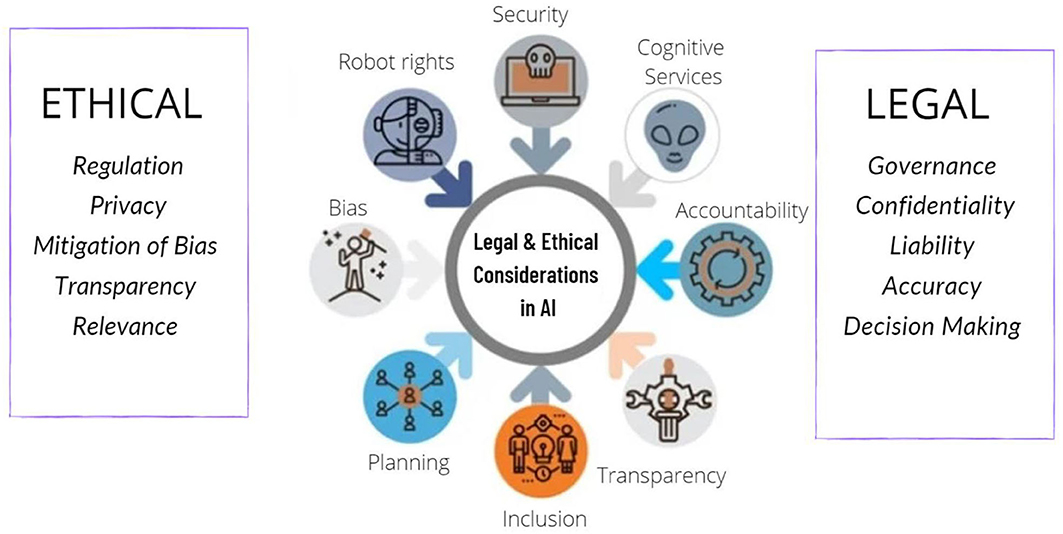

AI透明化是企业智能化转型的关键组成部分,它要求在AI系统的整个生命周期中,从数据处理、模型训练到最终决策的输出,都要做到可解释、可审查和可复现。透明化的AI系统能够增强用户信任,提高系统的可靠性和安全性,同时满足法规遵从性要求。

## 1.1 AI透明化对企业的必要性

在企业运营中,AI技术的应用越来越广泛,但随之而来的“黑盒”问题也越发凸显,这严重影响了企业决策的可信度和效率。通过实现AI透明化,企业可以:

- 提高内部决策的透明度,助力团队做出更加精准、高效的决策。

- 构建用户和利益相关者对AI系统的信任,从而更易于接受和推广AI解决方案。

- 遵循行业监管要求,有效避免潜在的法律风险和合规挑战。

## 1.2 AI透明化对企业的影响

AI透明化对企业的影响是深远的,它不仅涉及到技术层面,还涵盖了企业文化和战略层面:

- 技术层面上,企业需要确保AI系统的决策过程和结果可追溯、可理解。

- 文化层面上,企业需要培养一种开放、透明的运营文化,鼓励员工理解和质疑AI系统的决策。

- 战略层面上,企业应将透明化作为持续改进的一部分,确保AI技术的长远发展能够符合商业目标与社会责任。

通过深入了解AI透明化,企业能够更好地掌控AI技术,使之成为推动业务发展的强大引擎。接下来的章节将具体分析AI模型的可解释性,为企业实现透明化提供理论基础与实践指导。

# 2. AI模型可解释性理论基础

## 2.1 可解释性在AI中的作用与意义

### 2.1.1 AI决策透明化需求分析

在AI模型被广泛应用于企业决策过程中时,透明化成为了企业的一项基本需求。这种需求不仅涉及到模型内部运作的透明,更涉及到模型输出决策的可解释性。透明化的需求来源于几个方面:

- **合规性要求**:随着法律法规的不断完善,对于AI决策过程的可解释性要求也越来越高。例如,在金融、医疗等敏感行业,模型的决策过程需要可以向监管机构和用户清晰地解释。

- **信任建立**:AI系统的决策透明可解释是建立用户和企业内部信任的关键。当用户了解模型是如何工作,以及如何做出特定决策的时候,更容易信任这个系统。

- **优化与调整**:明确AI模型的决策逻辑对于发现潜在的问题和模型的优化至关重要。可解释性可以指导我们如何改进模型以获得更准确或公正的结果。

### 2.1.2 可解释性对业务流程的影响

可解释性直接影响到企业的业务流程,包括但不限于:

- **决策制定过程**:可解释的AI模型允许业务决策者参与到模型的决策制定过程中,这将增强模型的实用性并减少意外的风险。

- **问题诊断与解决**:当AI系统出现错误时,可解释性使企业能够快速定位问题所在,并进行修复。

- **产品与服务创新**:可解释性可以推动基于AI产品的透明度,这可以增加客户的理解和接受度,从而带来新的商业机会。

## 2.2 可解释性理论框架

### 2.2.1 可解释性模型类型

在AI模型的可解释性理论框架中,模型类型大致可以分为以下几种:

- **全局解释性模型**:这类模型致力于解释AI系统在所有可能输入数据上的行为,例如决策树和线性回归模型。

- **局部解释性模型**:侧重于解释特定决策的原因,例如LIME(局部可解释模型-不透明)和SHAP(Shapley Additive exPlanations)。

### 2.2.2 模型解释性评价标准

模型的可解释性评价标准通常包括:

- **准确性**:解释应当准确反映模型的决策逻辑。

- **简洁性**:解释应当足够简单,以便于人类理解和采取行动。

- **相关性**:解释应当直接关联到模型预测。

- **稳定性**:解释应当在不同的输入数据上保持一致。

## 2.3 可解释性方法论

### 2.3.1 本地可解释模型与近似方法

本地可解释模型旨在为单个预测提供解释。它们通过简化模型或近似方法来实现解释性,例如:

- **LIME**:通过在输入数据附近扰动,找到可以解释给定预测的简单模型。

- **局部规则集**:生成一组条件规则来近似特定的模型预测。

### 2.3.2 全局可解释性策略

全局可解释性策略意在提供模型整体行为的洞见:

- **特征重要性分析**:使用诸如随机森林和梯度提升模型等集成方法来评估特征对模型预测的贡献度。

- **可视化技术**:例如使用t-SNE或UMAP等方法来可视化高维数据中模型的决策边界。

随着AI透明化的需求日益增长,下一章我们将深入了解在实际应用中如何使用工具和技术实践可解释性。

# 3. AI可解释性工具与技术实践

## 3.1 可视化技术在AI透明化中的应用

在AI系统的设计与应用中,可解释性和透明度不仅仅是一个技术要求,它也是确保系统得到广泛接受和信任的关键。可视化技术在提升AI透明化方面起着至关重要的作用。数据可视化和模型决策过程的可视化是AI透明化的两个主要方面。

### 3.1.1 数据可视化方法

数据可视化是将复杂的数据集转化为图形表示,使得人们能直观地理解和分析数据中的模式、趋势以及异常。在AI透明化的背景下,数据可视化可以帮助开发者、利益相关者和最终用户了解数据是如何被AI系统处理的。

以下是数据可视化的一些常见方法和它们在AI透明化中的应用:

- **散点图(Scatter Plots)**:用于展示两个变量之间的关系。在AI透明化中,散点图可以帮助理解输入特征和输出结果之间的相关性。

- **热图(Heatmaps)**:通过颜色渐变来展示矩阵或数据集中数据点的强度。在AI模型中,热图可以用来显示特征重要性。

- **决策树可视化(Decision Tree Visualization)**:直观地展示决策过程,有助于理解模型的决策逻辑。

- **特征重要性图表(Feature Importance Charts)**:展示了不同特征对模型预测贡献的大小。

### 3.1.2 模型决策过程可视化技巧

模型决策过程的可视化不仅涉及结果的呈现,

0

0