【LSTM模型透明度】:提升可解释性,构建可信AI

发布时间: 2024-09-05 23:35:34 阅读量: 74 订阅数: 60

大语言模型的工作原理与发展.pdf

# 1. LSTM模型简介与透明度需求

在当今的人工智能领域,模型的透明度是一个核心议题,尤其是在金融、医疗和法律等需要高准确性和可解释性的行业中。长短期记忆网络(LSTM)由于其在处理时间序列数据方面的独特优势,成为众多应用的首选。然而,LSTM结构的复杂性和决策过程的不透明性,却给这些需求带来了挑战。

## 1.1 LSTM模型简介

LSTM是一种特殊类型的循环神经网络(RNN),它能够学习长期依赖信息。在处理和预测关键时间点之间关系方面,LSTM由于其能够解决传统RNN遇到的长期依赖问题而备受欢迎。通过引入门控机制,LSTM能够在必要时保持信息不变,防止梯度消失或爆炸,这对于序列数据的分析至关重要。

## 1.2 透明度的重要性

在很多应用场景中,LSTM模型的预测结果需要向利益相关者明确解释,以建立信任。透明度不仅指模型的输入和输出的明确性,还包括了决策过程的可解释性。这种透明度对于遵守数据保护法规和提升用户信任尤为关键。例如,在医疗诊断、金融投资建议等领域,模型透明度能够帮助专业人士和用户理解和验证模型的决策逻辑,这对于模型的接受程度和实际应用至关重要。

在后续章节中,我们将深入了解LSTM的工作原理、面临的可解释性挑战,以及如何构建一个既高效又透明的可信LSTM模型。通过对模型结构、训练、优化,以及伦理与合规性等多方面的探讨,我们将逐步揭开LSTM模型的神秘面纱,探究其在不同行业应用中的透明度实现。

# 2. 理解LSTM模型的工作原理

理解LSTM(Long Short-Term Memory)模型的工作原理是掌握其应用和优化的基础。LSTM是一种特殊的循环神经网络(RNN),其设计目标是解决长期依赖问题。由于传统RNN在处理长期依赖问题时会遇到梯度消失或梯度爆炸的问题,LSTM通过引入门控机制,有效地调控信息的流动,使得模型能够学习到长期依赖关系。

### LSTM模型的基本结构

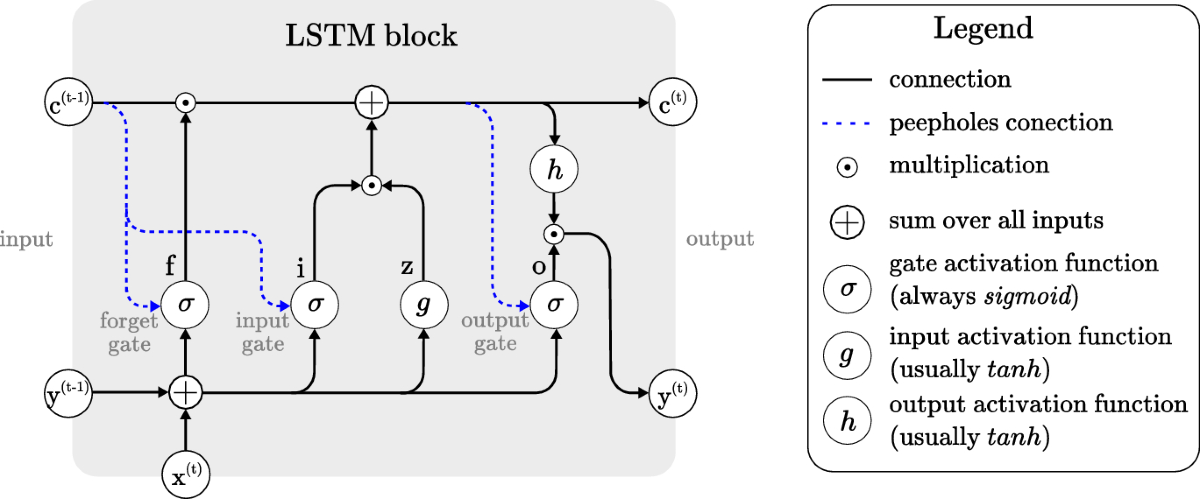

#### LSTM单元的构成与作用

LSTM单元主要由三个门控结构组成:遗忘门(forget gate)、输入门(input gate)和输出门(output gate)。每个门控结构使用sigmoid神经网络层来决定信息的保留或丢弃。具体来说:

- **遗忘门**:决定了哪些信息需要从单元状态中被遗忘。

- **输入门**:控制新输入数据中有多少信息可以添加到单元状态中。

- **输出门**:控制单元状态中哪些信息会被输出到隐藏状态,进而影响到下一个单元的输入。

每个门控结构由权重矩阵和偏置项组成,并通过 sigmoid 激活函数来输出介于 0 到 1 之间的值,表示信息被保留或遗忘的程度。

```python

import numpy as np

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def forgetting_gate(forget_weights, input_data, forget_bias):

forget_scores = sigmoid(np.dot(input_data, forget_weights) + forget_bias)

return forget_scores

```

在这段代码中,`sigmoid` 函数用于生成门控结构的输出,`forgetting_gate` 函数模拟了遗忘门的工作过程。`forget_weights` 是遗忘门权重矩阵,`input_data` 是输入数据,`forget_bias` 是遗忘门的偏置项。函数输出 `forget_scores` 是一个介于 0 和 1 之间的数值,决定了哪些信息应该从单元状态中被遗忘。

#### LSTM的前向传播过程解析

LSTM单元的前向传播过程可以分为以下步骤:

1. **遗忘门** 决定要从单元状态中丢弃的信息。

2. **输入门** 决定新输入数据中哪些信息应该被更新至单元状态。

3. **单元状态更新**:单元状态会根据遗忘门和输入门的指示进行更新。

4. **输出门** 决定下一个隐藏状态的输出。

这一过程中,前一个隐藏状态和当前的输入共同决定下一个隐藏状态。每个单元的状态都是在前一个状态的基础上,通过门控机制选择性地更新信息。

### LSTM模型的数学原理

#### 权重和偏置的影响分析

LSTM中权重和偏置是影响模型学习和预测能力的关键因素。权重矩阵决定了输入数据如何影响门控结构的输出,而偏置项则为门控提供了一个可调整的基线。在训练过程中,通过梯度下降算法更新这些权重和偏置,以最小化损失函数。

#### 激活函数的选择与作用

除了门控机制,LSTM中使用了三种激活函数:sigmoid、tanh和线性激活函数。Sigmoid和tanh用于门控结构的输出,因为它们的输出范围分别在0到1之间和-1到1之间,非常适合表示信息保留或丢弃的程度。线性激活函数主要用于输出门,保持输出数据的范围尽可能大。

### LSTM模型的训练与优化

#### 损失函数与优化器的选择

在训练LSTM模型时,损失函数的选择需要考虑预测任务的性质。例如,对于回归任务,均方误差(MSE)是常见的选择;对于分类任务,交叉熵损失函数会更加适用。选择合适的优化器也很关键,常用的优化器有SGD、Adam和RMSprop等,它们通过调整权重和偏置来最小化损失函数。

```python

# 假设 `y_true` 和 `y_pred` 分别是真实值和预测值

from sklearn.metrics import mean_squared_error

def mse_loss(y_true, y_pred):

return mean_squared_error(y_true, y_pred)

```

在上述代码中,`mse_loss` 函数计算了真实值和预测值之间的均方误差,这是一种常用的回归任务损失函数。

#### 过拟合与正则化技术

过拟合是机器学习中的一个常见问题,LSTM同样会面临这一挑战。使用L2正则化、dropout技术和提前停止(early stopping)是防止过拟合的常用技术。这些技术有助于提高模型在未见数据上的泛化能力。

```python

from keras.layers import Dropout

from keras.callbacks import EarlyStopping

# 在模型中添加dropou

```

0

0