【LSTM调参秘籍】:打造高性能模型,训练技巧大公开

发布时间: 2024-09-05 23:02:02 阅读量: 115 订阅数: 78

# 1. LSTM模型基础与应用背景

在当今的人工智能领域,长短期记忆网络(LSTM)是一种在处理序列数据方面特别有用的循环神经网络(RNN)架构。本章将为您梳理LSTM的基本概念,并探讨其在各行业中的应用背景。

## 1.1 LSTM的诞生与发展

LSTM由Hochreiter与Schmidhuber在1997年提出,目的在于解决传统RNN在学习长期依赖问题时遇到的难题。由于其独特的门控结构,LSTM能够有效地捕捉序列中的长期依赖关系,避免了传统RNN遇到的梯度消失问题。

## 1.2 LSTM的适用场景

LSTM因其卓越的记忆能力,广泛应用于自然语言处理(NLP)、语音识别、时间序列分析等领域。在处理文本、语音和各种时间相关的数据时,LSTM能展示其强大的序列学习能力。

## 1.3 LSTM的优势分析

相较于其他机器学习模型,LSTM主要优势在于其内部复杂的门控机制,这使得它能够调节信息流动,保留有用的信息并遗忘掉不相关的信息。这一点对许多实际问题,特别是那些需要记忆历史信息的问题至关重要。

在接下来的章节中,我们将深入探讨LSTM的网络结构、理论基础以及如何进行调参和优化,以适应更复杂的应用需求。

# 2. LSTM网络结构与理论基础

## 2.1 LSTM单元的工作原理

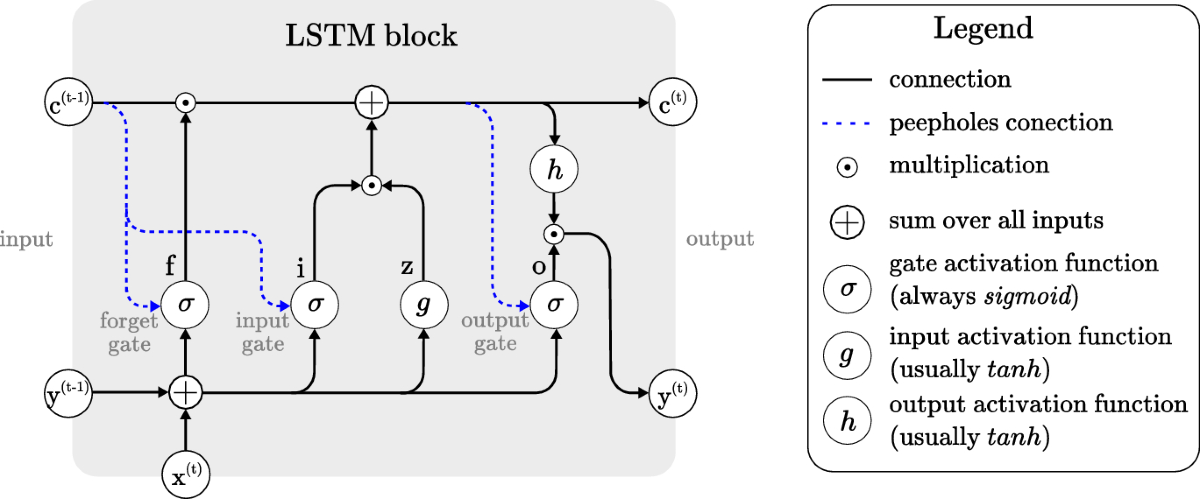

### 2.1.1 LSTM单元的结构介绍

长短期记忆(LSTM)网络是一种特殊的循环神经网络(RNN),能够学习长期依赖信息。LSTM的核心在于其精心设计的单元结构,每个单元包括一个细胞状态、三个门(忘记门、输入门、输出门)以及一个隐藏状态。这种结构使得LSTM能够在必要时保持信息不变,并在适当的时候添加或移除信息。

细胞状态类似于一个传送带,贯穿整个LSTM单元链,携带着长期状态信息。门控机制则由sigmoid神经网络层和点乘操作组成,它们决定信息的保留与传递。

一个典型的LSTM单元可以表示为以下数学公式:

- **忘记门**:决定要从细胞状态中丢弃什么信息。这个门使用sigmoid层生成0到1之间的数,表示每项信息的重要性。

\[ f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) \]

- **输入门**:决定新输入的数据中,哪些部分将被存储到细胞状态中。它同样使用sigmoid层,而候选值的更新则通过tanh层来进行。

\[ i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) \]

\[ \tilde{C}_t = \text{tanh}(W_C \cdot [h_{t-1}, x_t] + b_C) \]

- **细胞状态更新**:通过忘记门决定丢弃的信息和输入门确定的新信息来更新细胞状态。

\[ C_t = f_t * C_{t-1} + i_t * \tilde{C}_t \]

- **输出门**:决定输出什么信息,通常是基于当前细胞状态的信息,通过tanh函数进行规范化后,再乘以sigmoid门的输出结果。

\[ o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o) \]

\[ h_t = o_t * \text{tanh}(C_t) \]

其中,\( \sigma \) 表示sigmoid激活函数,\( \text{tanh} \) 是双曲正切函数,\( W \) 和 \( b \) 表示权重和偏置参数。

### 2.1.2 LSTM中的门控机制详解

LSTM的门控机制是其核心,它通过几个专门设计的门来控制信息的流动,包括哪些信息被遗忘,哪些新信息被添加到细胞状态中。这一机制可以有效地解决传统RNN在处理长序列数据时遇到的梯度消失和梯度爆炸问题。

- **忘记门**:此门负责审视当前输入和上一时刻的隐藏状态,决定哪些信息应该从细胞状态中删除。它学习到的数据范围介于0到1之间,0表示完全忘记,1表示完全保留。

- **输入门**:此门决定了哪些新的候选信息可以被添加到细胞状态。它的工作流程是两步:首先,一个sigmoid层决定了输入信息中哪些部分需要更新;然后一个tanh层创建了新的候选值向量,这个向量将被添加到状态中。

- **细胞状态更新**:细胞状态会根据忘记门和输入门的决定更新。它通过逐元素的方式结合旧状态和新候选状态来实现。忘记门控制了哪些信息需要丢弃,而输入门决定了哪些新信息要被添加。

- **输出门**:决定下一个隐藏状态的输出,这个隐藏状态包含了网络决定输出的信息。它首先通过sigmoid层决定哪些信息将被输出,然后将细胞状态通过tanh函数正规化后与这个信息相乘。

这种门控机制让LSTM单元能够有选择地记住或遗忘信息,从而捕捉长期依赖性,这是LSTM模型的关键优势。

## 2.2 LSTM与RNN的对比分析

### 2.2.1 循环神经网络(RNN)回顾

传统的循环神经网络(RNN)是为了处理序列数据而设计的网络结构,其核心在于循环连接。在时间步\(t\),RNN接收当前输入\(x_t\)和前一时间步的隐藏状态\(h_{t-1}\),通过一个简单的权重矩阵\(W\)和激活函数(如tanh或ReLU)来计算当前的隐藏状态\(h_t\)。

数学上,RNN的隐藏状态更新可以表示为:

\[ h_t = f(W \cdot [h_{t-1}, x_t]) \]

其中,\(f\)是激活函数,如tanh。

虽然RNN理论上具有处理序列数据的潜力,但是它存在两个主要问题:梯度消失问题和梯度爆炸问题。这些问题限制了RNN在长序列数据上的表现。

### 2.2.2 LSTM解决RNN的长期依赖问题

LSTM正是为了解决RNN在学习长期依赖时的不足而提出的。LSTM通过引入复杂的门控机制来有效地避免梯度消失和梯度爆炸问题。

LSTM不仅保留了RNN处理序列数据的优势,还通过其独特的门控单元结构增加了对长期依赖的捕获能力。相比RNN,LSTM能够更好地在序列的不同时间步之间传递信息,这使其在处理如自然语言处理、语音识别等依赖长期上下文的任务上表现出色。

LSTM的门控结构也允许它对序列信息进行有选择的记忆和遗忘,这为学习任务提供了更大的灵活性。例如,在自然语言处理任务中,LSTM能够记住句子中的关键部分,而忽略掉不重要的部分。

## 2.3 LSTM在各领域的应用案例

### 2.3.1 自然语言处理(NLP)

LSTM由于其强大的序列处理能力,在自然语言处理领域得到广泛的应用。它能够学习语言序列中的长期依赖关系,例如,用于句子分类、机器翻译、文本摘要、情感分析等任务。

使用LSTM的典型架构是将输入序列编码为固定长度的向量表示。例如,在机器翻译任务中,LSTM可以用于读取源语言句子,并将其编码为一个上下文相关的表示。然后,另一个LSTM或不同类型的解码器可以生成目标语言的翻译句子。

LSTM在NLP的成功应用主要得益于其能够通过门控机制记住和遗忘特定的信息,这对于理解复杂的语言结构和含义至关重要。

### 2.3.2 语音识别与合成

语音识别系统需要将连续的音频信号转换为文本,这涉及到对声音信号的时间序列进行建模和分析。LSTM网络在此任务中扮演了重要角色,尤其是在处理具有复杂时序动态变化的语音信号时。

LSTM可以通过对语音信号的时间序列进行有效的学习,来捕捉音频中的长期依赖和时序模式。这允许系统能够更准确地识别说话人的语音,并将其转换为文字。

在语音合成领域,LSTM同样扮演了核心角色,它用于生成自然听起来的语音波形。通过LSTM,可以学习文本到语音的映射关系,生成高质量的语音输出,从而改善如电子书朗读、语音助手和语音交互系统的用户体验。

### 2.3.3 时间序列预测

时间序列预测是分析时间序列数据,预测未来的数据点。LSTM特别适合这类任务,因为它能够记忆过去的信息,并将其用于对未来事件的预测。LSTM在金融市场分析、能源需求预测、库存管理等领域都有应用。

例如,在金融市场中,LSTM可以用来分析股票价格的历史数据,并预测未来的股价。LSTM网络可以捕捉价格变动的长期趋势和季节性模式,这对于制定投资策略非常有用。

在能源需求预测方面,LSTM能够理解天气变化、假期效应等因素对能源消耗的影响,然后预测未来一段时间内的能源需求量。通过有效的预测,能源公司可以更加高效地管理资源和减少浪费。

在这些应用中,LSTM的优势在于其对时间序列数据的长期依赖关系的建模能力,这使得它在处理非平稳时间序列数据时具有较高的准确性和鲁棒性。

# 3. LSTM模型的关键调参技巧

长短期记忆网络(LSTM)在时间序列分析、自然语言处理等领域取得了显著的成果。然而,要想从这些复杂的模型中获得最佳性能,关键在于调参技巧。通过理解模型的超参数作用与影响,掌握超参数调优方法论,以及深入探讨梯度消失与梯度爆炸的解决策略,我们可以实现LSTM模型性能的最优化。

## 3.1 理解超参数的作用与影响

### 3.1.1 超参数的基本概念

在机器学习模型的训练过程中,超参数是预先设定的参数,它们不能直接从数据中学习得到。超参数的选取对于模型的性能有着决定性的影响。在LSTM模型中,常见的超参数包括学习率、隐藏层单元数、批次大小(batch size)、序列长度、正则化系数等。理解这些超参数的含义及其对模型的影响是调参的第一步。

### 3.1.2 各超参数对模型性能的影响

- **学习率**:学习率决定了权重更新的速度。学习率过低会导致训练过程缓慢,而学习率过高可能会导致模型无法收敛。正确的学习率设置是模型能否快速收敛的关键。

- **隐藏层单元数**:隐藏层单元数影响模型的容量,即模型的复杂度。单元数太少可能无法捕捉数据中的复杂模式,太多又可能引起过拟合。

- **批次大小**:批次大小决定了每次迭代中使用的样本数。较大的批次大小可以加快训练速度,但也可能导致梯度估计的方差增大。

- **序列长度**:在处理时间序列数据时,序列长度的选择至关重要。过短的序列可能无法提供足够的上下文信息,过长则可能因为梯度消失问题

0

0