LSTM梯度问题破解:专家教你如何避免消失与爆炸

发布时间: 2024-09-05 23:05:50 阅读量: 98 订阅数: 65

博途1200恒压供水程序,恒压供水,一拖三,PID控制,3台循环泵,软启动工作,带超压,缺水保护,西门子1200+KTP1000触摸屏

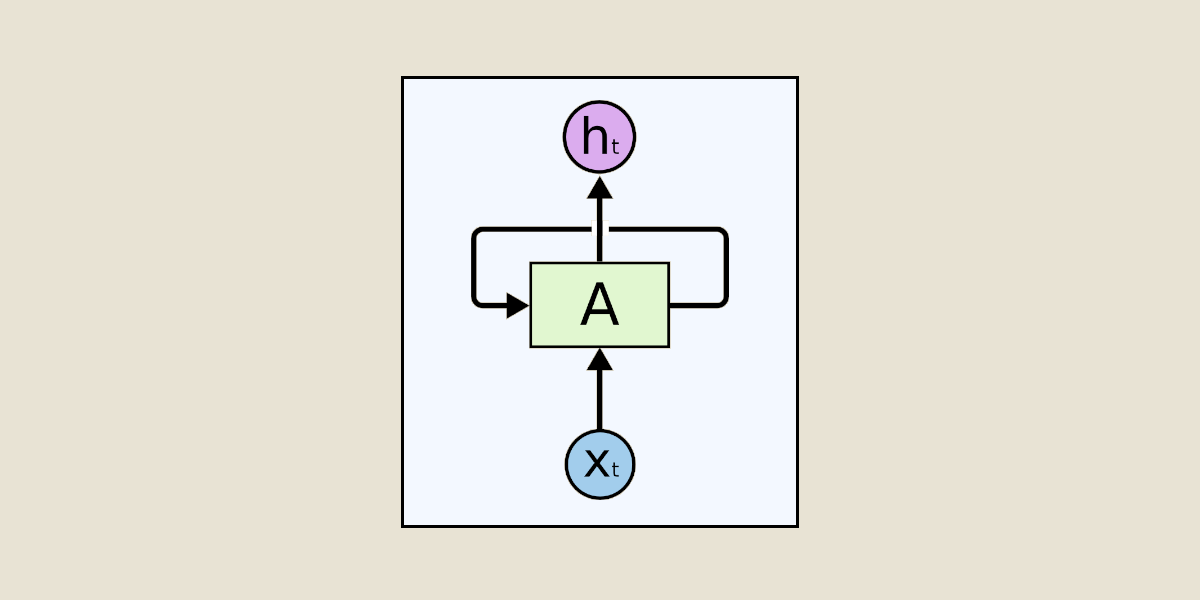

# 1. LSTM网络架构概述

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),由Sepp Hochreiter和Jürgen Schmidhuber于1997年提出,旨在解决传统RNN在处理长序列数据时遇到的梯度消失和梯度爆炸问题。LSTM的架构设计允许网络通过时间传递信息,同时通过引入门控机制来控制信息的流动,有效地保持长期依赖关系。

LSTM的关键组件包括细胞状态(cell state)和三个门结构:遗忘门(forget gate)、输入门(input gate)以及输出门(output gate)。遗忘门负责决定哪些信息应该从细胞状态中丢弃,输入门控制新输入信息的流入,而输出门则控制根据当前细胞状态和输出的计算结果。

在深度学习和自然语言处理领域,LSTM因其对时间序列数据和序列建模的强大能力,被广泛应用于语音识别、语言翻译、文本分类和情感分析等任务。尽管LSTM在许多方面表现出色,但梯度消失和梯度爆炸问题依然是优化和应用LSTM时必须考虑的重要因素。

```mermaid

graph LR

A[输入x_t] --> B[遗忘门]

B --> C[细胞状态]

C --> D[输入门]

D --> E[输出门]

E --> F[输出h_t]

```

以上Mermaid流程图简单表示了LSTM的数据流和门控机制。遗忘门(B)决定要丢弃的信息,输入门(D)决定新增的信息,最后输出门(E)生成当前步的输出(F),基于细胞状态(C)和当前输入(A)。

# 2. 梯度消失与梯度爆炸问题分析

梯度问题是深度学习中一个关键的技术难题,它影响到模型的训练速度和最终性能。在本章节中,我们将详细探讨梯度消失与梯度爆炸问题的成因、数学原理以及在LSTM网络中的具体表现。

## 2.1 理解梯度消失与梯度爆炸

### 2.1.1 梯度消失问题的原因和影响

梯度消失指的是在深度神经网络中,随着层数的增加,梯度会呈指数级减小,导致靠近输入层的参数几乎不更新,网络难以训练深层特征。这种现象主要由激活函数和网络权重共同作用产生。

**激活函数影响:** 比如Sigmoid和Tanh函数,在输入值远离0时,其导数值接近0,导致梯度逐渐消失。

**权重初始化影响:** 若初始化权重较小,则反向传播时的梯度更新会进一步缩小,加剧梯度消失问题。

梯度消失现象会导致以下影响:

1. 网络难以捕捉到低层的特征,因为靠近输入层的权重几乎不更新。

2. 网络训练速度缓慢,因为学习率需要设置得非常低,以免造成大的权重更新。

3. 网络性能受限,可能无法达到预期的准确率。

```python

import numpy as np

# 示例代码展示梯度消失

def sigmoid(x):

return 1 / (1 + np.exp(-x))

# Sigmoid函数在输入较大或较小时的梯度

x = np.arange(-5, 5, 0.1)

dx = sigmoid(x) * (1 - sigmoid(x))

print(dx)

```

代码解释:上述代码展示了Sigmoid激活函数的导数,即梯度。在x较大或较小时,导数值接近0,这说明在深度网络中,梯度会随着层数增加而迅速减小。

### 2.1.2 梯度爆炸问题的原因和影响

梯度爆炸则和梯度消失相反,它指的是在深度神经网络中梯度呈指数级增长,导致权重更新过大,网络无法收敛。

**权重初始化影响:** 若权重初始化过大,反向传播时的梯度会很大。

**梯度累积影响:** 当使用过大的学习率时,梯度在反向传播过程中会不断累积,造成梯度爆炸。

梯度爆炸现象会带来以下影响:

1. 训练过程中权重值会迅速增加,导致数值不稳定。

2. 网络可能在训练开始时就发散,无法收敛到损失函数的最小值。

3. 梯度爆炸可能掩盖损失曲面上真实的下降方向。

```python

# 示例代码展示梯度爆炸

W = np.random.randn(100, 100) * 10 # 初始化权重过大

Z = np.dot(X, W) # 假设X是输入数据

```

代码逻辑分析:在上面的代码片段中,权重W被初始化得很大,模拟梯度爆炸的场景。在实际应用中,需要控制权重初始化范围,避免这种情况。

## 2.2 数学原理背后的梯度问题

### 2.2.1 反向传播算法与梯度计算

反向传播算法是训练深度神经网络的核心,它通过计算损失函数相对于权重的梯度,来指导网络参数的更新。梯度计算依赖于链式法则。

链式法则是微积分中的一个规则,用于求复合函数的导数。在反向传播中,每个参数的梯度都是通过链式法则计算得到的。

```python

# 反向传播中梯度的链式法则计算示例

def derivative(f, x):

h = 1e-5

return (f(x + h) - f(x - h)) / (2 * h)

# 示例函数

def f(x):

return sigmoid(x) ** 2

# 计算函数f在x=0处的导数

df_dx = derivative(f, 0)

print(df_dx)

```

代码逻辑分析:这个代码片段展示了如何使用差分法近似计算函数导数,它遵循了链式法则的思想。在神经网络训练中,我们会使用更高效的梯度计算方法,如自动微分。

### 2.2.2 梯度的链式法则和影响因子

在链式法则的计算过程中,如果每个环节的导数都较小,那么最终的梯度就会呈指数级减小,导致梯度消失。相反,如果存在一个或多个环节的导数过大,那么梯度就会呈指数级增大,导致梯度爆炸。

影响梯度大小的主要因素有:

1. 激活函数的性质

2. 网络权重的初始化

3. 网络层数的深度

```mermaid

graph TD

A[损失函数] -->|链式法则| B[计算权重梯度]

B --> C[权重更新]

C --> D[参数优化]

D --> E[梯度减小]

E --> F[梯度消失]

D --> G[梯度增大]

G --> H[梯度爆炸]

```

流程图解析:这张流程图展示了梯度消失和梯度爆炸问题在梯度计算中的路径。梯度消失通常与权重梯度的不断减小相关,而梯度爆炸与权重梯度的不断增大相关。

## 2.3 梯度问题在LSTM中的具体表现

### 2.3.1 LSTM梯度问题与传统RNN的对比

LSTM(长短期记忆网络)是RNN(循环神经网络)的一种改进结构,旨在解决传统RNN在处理长序列时的梯度消失问题。

**LSTM的优势:** 通过引入遗忘门、输入门和输出门来控制信息流,缓解了梯度消失问题。

**LSTM的挑战:** 虽然LSTM在一定程度上缓解了梯度消失,但其复杂的门控结构有时也会导致梯度爆炸。

### 2.3.2 LSTM梯度问题的实际案例分析

在实际应用LSTM时,梯度问题仍然需要重视。例如,在股票价格预测、自然语言处理等任务中,梯度消失会导致模型无法捕捉长期依赖关系,而梯度爆炸则会使得模型难以稳定训练。

在股票价格预测中,如果使用LSTM模型进行时间序列分析,梯度消失问题可能会导致模型无法学习到过去时间点上的信息,影响预测准确性。

在自然语言处理中,梯度问题可能影响到语义理解的深度。例如,对于较长的句子,如果梯度消失,模型将难以学习到句尾的语义信息,导致理解不准确。

通过这些案例,我们可以了解到梯度消失与梯度爆炸对LSTM模型性能的实际影响,并在模型设计时考虑到适当的解决方案。

```python

# LSTM模型构建与梯度剪切示例(伪代码)

from keras.models import Sequential

from keras.layers import LSTM, Dense

model = Sequential()

model.add(LSTM(100, return_sequences=True, input_shape=(timesteps, input_dim)))

model.add(LSTM(100))

model.add(Dense(1, activation='linear'))

# 使用梯度剪切防止梯度爆炸

clip_value = 1.0

optimizer = keras.optimizers.SGD(lr=0.01, clipvalue=clip_value)

***pile(loss='mse', optimizer=optimizer)

```

代码逻辑分析:在上述伪代码中,构建了一个LSTM模型并应用了梯度剪切技术,以防止梯度爆炸。通过设置`clipvalue`参数,限制梯度值的最大大小,从而缓解梯度爆炸问题。

# 3. 避免梯度消失的策略与方法

## 3.1 权重初始化技术

在神经网络的学习过程中,权重初始化是至关重要的一步。如果初始化得当,可以加速网络的收敛速度,避免梯度消失和梯度爆炸的问题。权重初始化技术需要根据网络结构和激活函数的不同进行适当的选择。

### 3.1.1 权重初始化对梯度问题的影响

权重初始化过小可能会导致梯度消失问题,因为小的权重值在多层网络的反向传播中,梯度经过连乘会迅速趋向于零,使得深层网络的梯度几乎消失。相反,如果权重初始化过大,则可能导致梯度爆炸,因为大的权重值会导致梯度在反向传播时连乘后变得异常大,使得学习过程变得不稳定甚至发散。

### 3.1.2 不同初始化方法的比较与选择

在实践中,通常会用到几种权重初始化方法:

- **Xavier初始化**(也称为Glorot初始化):该方法考虑了输入和输出单元的数量,选择适当的初始化范围使得信号的方差在每层都保持一致,从而避免梯度消失或爆炸问题。

- **He初始化**:它是Xavier初始化的变体,特别适用于ReLU激活函数,因为ReLU的输出范围是0到正无穷,所以He初始化将权重的标准差调整为2倍的输入单元数量的倒数。

- **随机初始化**:从较小的随机值开始,例如使用高斯分布或均匀分布。

下面是一个简单的Python示例,展示如何使用不同的初始化方法:

```python

import tensorflow as tf

from tensorflow.keras.initializers import GlorotUniform, HeUniform

def create_layer(units, activation, kernel_initializer):

layer = tf.keras.layers.Dense(

units,

```

0

0