LSTM在机器翻译中的应用:面对挑战,抓住机遇

发布时间: 2024-09-05 23:38:22 阅读量: 63 订阅数: 49

# 1. 长短期记忆网络(LSTM)基础

在当今的深度学习领域中,长短期记忆网络(LSTM)作为一种特殊的循环神经网络(RNN),因其在处理和预测重要事件中的优势而受到了广泛关注。LSTM被设计用来避免传统RNN中的梯度消失或爆炸问题,并且能够捕捉长期依赖关系。

## 1.1 LSTM的基本概念

LSTM网络的核心在于其具有特殊结构的单元,称为“记忆单元”或“LSTM单元”。这些单元能够存储信息,并在需要时进行读取、写入或删除。LSTM的这些特性使其特别适合处理序列数据,如时间序列分析、自然语言处理等任务。

## 1.2 LSTM的工作原理

LSTM单元内部由几个主要部分组成:遗忘门、输入门、输出门,它们共同作用以控制信息的流动。遗忘门负责决定哪些信息应该从单元状态中丢弃;输入门管理新输入信息的添加;输出门控制哪些信息将被用来计算输出。

```python

# 简单的LSTM网络结构伪代码

from keras.models import Sequential

from keras.layers import LSTM, Dense

model = Sequential()

model.add(LSTM(50, activation='relu', input_shape=(timesteps, input_dim)))

model.add(Dense(num_classes, activation='softmax'))

```

上述伪代码展示了如何构建一个包含LSTM层的基本神经网络模型。在实际应用中,LSTM的这些属性使其成为机器翻译和其他序列预测任务的首选模型之一。

# 2. LSTM在机器翻译中的理论基础

### LSTM模型的架构和原理

#### LSTM单元的工作机制

长短期记忆网络(LSTM)是循环神经网络(RNN)的一个特殊类型,特别设计用来解决传统RNN在处理长序列数据时出现的梯度消失或梯度爆炸问题。LSTM引入了一个新的结构,即“记忆单元”或“细胞状态”,它允许网络在训练过程中保持长期依赖信息。

LSTM单元由三个主要部分组成:

1. **遗忘门(Forget Gate)**:决定哪些信息需要从细胞状态中删除。它查看上一个隐藏状态和当前输入,并输出一个介于0到1之间的值,这个值表示每个细胞状态值保留的程度。

2. **输入门(Input Gate)**:决定哪些新信息将被存储在细胞状态中。它由两部分组成,一部分是决定哪些信息需要更新的sigmoid层,另一部分是实际更新值的tanh层。

3. **输出门(Output Gate)**:决定细胞状态的哪些信息将被用于计算下一个隐藏状态和输出。最终,LSTM将根据当前细胞状态和遗忘门、输入门、输出门的信息来更新其内部状态和输出。

在具体实现上,LSTM单元使用了几个矩阵运算和激活函数,例如sigmoid和tanh函数,它们对于调节信息的保留和传递至关重要。

```python

# LSTM单元的简化的伪代码实现

def lstm_cell(input, state):

forget gate = sigmoid(W_f * input + U_f * state + b_f)

input gate = sigmoid(W_i * input + U_i * state + b_i)

cell gate = tanh(W_c * input + U_c * state + b_c)

output = forget gate * state + input gate * cell gate

return output

# 参数说明:

# W_ 为输入权重矩阵

# U_ 为隐状态权重矩阵

# b_ 为偏置向量

# sigmoid, tanh 为激活函数

```

#### LSTM与传统RNN的区别和优势

LSTM与传统RNN的一个显著区别在于其引入的“门”结构,这使得LSTM能够选择性地保留或遗忘信息。而传统RNN没有这种机制,往往会因为在时间序列上反向传播梯度时出现梯度消失或梯度爆炸,导致无法学习到长期依赖关系。

在面对机器翻译这类需要处理长序列输入的任务时,LSTM的优势就尤为明显。相比之下,传统RNN在长距离依赖上表现不佳,难以捕捉语言中的深层语义结构。LSTM则能够维持长距离的依赖,从而在翻译过程中保持信息的完整性,提升翻译质量。

LSTM通过其创新的架构,有效地解决了传统RNN的一些限制问题,因此在机器翻译、语音识别、文本生成等多个序列预测问题上都显示出了优异的性能。

### 机器翻译的挑战与需求

#### 机器翻译的技术演进

机器翻译的概念最早可追溯到上世纪50年代,但真正意义上的技术突破是在神经网络的发展之后。机器翻译技术经历了从基于规则的翻译到基于统计的翻译,再到当前的基于神经网络的翻译三个主要阶段。

基于规则的翻译依赖于预定义的语法规则和词典,受限于语言的复杂性和多样性,难以适应不同语言的细微差别。基于统计的翻译则采用了大量的平行语料库进行训练,通过统计方法学习不同语言之间的对应关系,相比基于规则的方法有所改进,但仍然有局限性,尤其是在语言的上下文理解上。

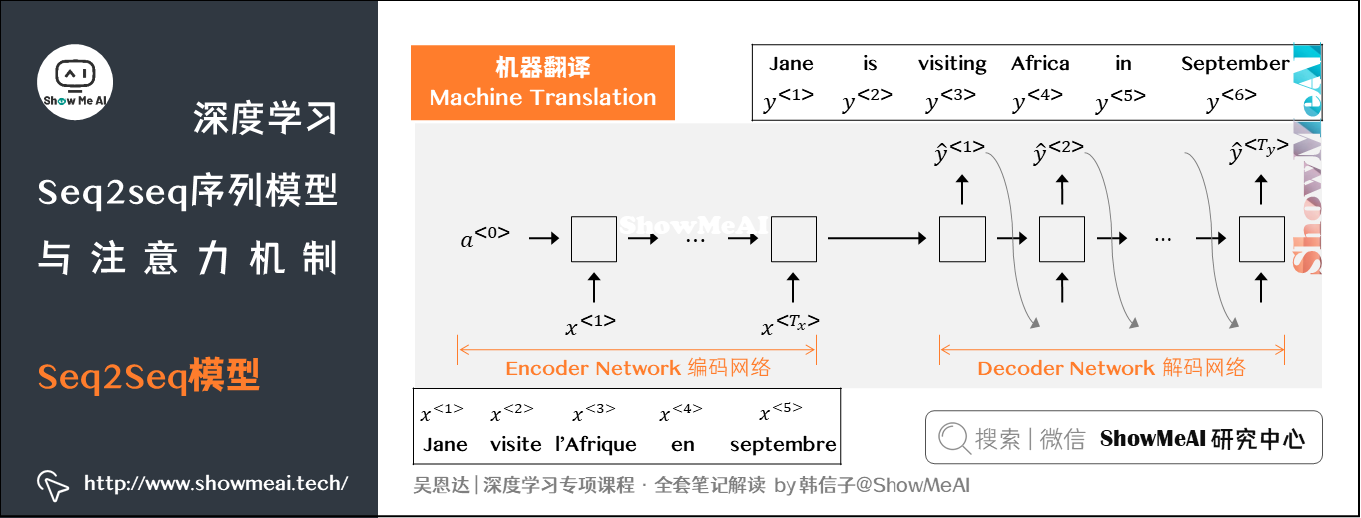

神经机器翻译(NMT)的出现,尤其是基于LSTM的NMT系统,革命性地提升了翻译质量,它能够自动学习语言中的复杂模式,并能更好地处理上下文信息。NMT采用端到端的学习方式,通过深度学习模型直接从输入语句到输出语句的映射,极大地提升了翻译的流畅性和准确性。

#### LSTM如何应对机器翻译的挑战

面对机器翻译领域的挑战,LSTM提供了强大的处理能力,特别是在理解长距离依赖关系和处理复杂语言结构方面。LSTM的门控机制使得模型能够在序列中传输、更新和维护有用的信息,同时丢弃那些不必要的信息。

LSTM在机器翻译中的应用,可以从以下几个方面来理解其应对挑战的能力:

1. **保持上下文信息**:通过其细胞状态,LSTM能够保持长距离的上下文信息,这对于翻译某些需要远距离上下文才能正确理解的语句尤其重要。

2. **动态记忆更新**:通过遗忘门和输入门,LSTM可以动态地更新其细胞状态,使得模型能够根据输入数据的变化灵活地调整其记忆内容。

3. **更好的并行化处理**:随着硬件技术的进步,LSTM模型可以更好地利用GPU并行计算的优势,加速训练过程,这对于处理大规模数据集尤为重要。

通过这些机制,LSTM能够显著提高翻译的准确性和流畅性,从而应对机器翻译领域中的多项挑战。

### LSTM在翻译质量评估中的应用

#### 翻译质量的衡量标准

在机器翻译领域,翻译质量的衡量标准主要分为自动评估和人工评估两种方式。

自动评估指标中最常见的是BLEU(Bilingual Evaluation Understudy)得分。BLEU得分基于n-gram重合度来计算机器翻译输出与一组人工翻译参考输出之间的相似性。然而,BLEU得分并不能完全准确地反映翻译的准确性和流畅性,因为它忽略了语法正确性和语境适应性等翻译质量的其他方面。

人工评估则侧重于更全面地评价翻译质量,包括准确性、流畅性、语境的合理性等多个维度。人工评估往往采用诸如METEOR(Metric for Evaluation of Translation with Explicit Ordering)和TER(Translation Edit Rate)等更精细的评价指标。

#### LSTM在评估模型中的角色和作用

在翻译质量评估中,LSTM可以用于构建质量评估模型,即使用LSTM作为基础网络结构来预测翻译质量的得分。LSTM在此类应用中的优势在于其长序列处理能力以及对复杂输入数据的建模能力。

LSTM质量评估模型的构建通常涉及以下步骤:

1. **特征提取**:从翻译的输入和输出文本中提取相关特征,包括语言学特征和统计特征。

2. **模型训练**:使用提取的特征和人工评估的质量得分来训练LSTM模型。该模型学习如何将翻译文本映射到质量评估得分。

3. **评估和优化**:评估模型的预测效果,并通过调整网络结构或参数来优化模型性能。

在实际应用中,LSTM模型可以被进一步扩展和优化,例如通过引入注意力机制(Attention Mechanism)来提高模型对于重要信息的识别能力。通过这些方法,基于LSTM的翻译质量评估模型能够更加准确地预测翻译质量,为翻译系统的改进提供重要参考。

```python

# 伪代码:构建LSTM质量评估模型

from keras.models import Sequential

from keras.layers import LSTM, Dense, Embedding

# 定义模型结构

model = Sequent

```

0

0