【LSTM并行计算】:GPU与TPU加速技术,专家带你飞速前进

发布时间: 2024-09-05 23:22:54 阅读量: 145 订阅数: 79

大模型基础技术资料集合.zip

# 1. LSTM并行计算基础概念解析

## 1.1 LSTM网络简介

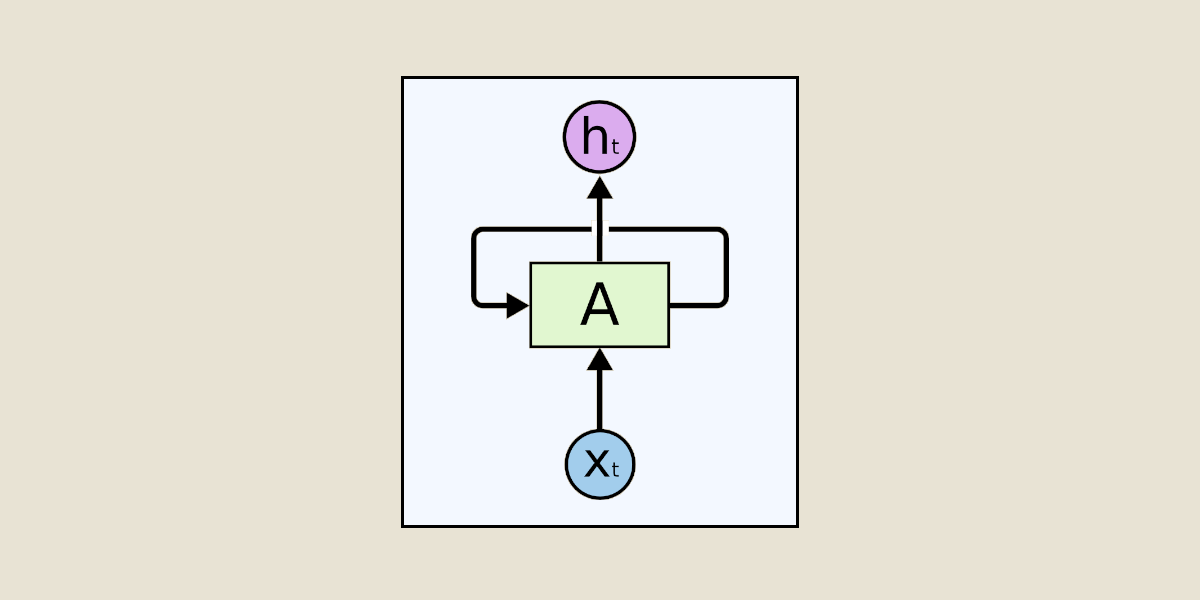

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),它能够学习长期依赖信息。LSTM通过引入三个门(输入门、遗忘门、输出门)和一个单元状态来克服传统RNN在处理长序列数据时面临的梯度消失或梯度爆炸问题。这种结构极大地提高了序列模型在多种任务中的性能,包括语言模型、语音识别、机器翻译等。

## 1.2 并行计算在LSTM中的重要性

LSTM模型在训练过程中需要大量的矩阵运算和数据处理,这些操作非常耗时。并行计算技术允许将这些运算分布在多个处理单元上同时执行,从而显著提高计算速度和效率。对于LSTM这类算法密集型的应用来说,采用并行计算不仅能够缩短训练时间,还能够处理更大规模的数据集,提升模型的性能。

## 1.3 并行计算的核心组件

并行计算主要依赖于高性能的硬件和优化的软件算法。在硬件方面,图形处理单元(GPU)和张量处理单元(TPU)等专用硬件提供了强大的并行处理能力。在软件方面,CUDA(针对NVIDIA GPU)和XLA(针对TPU)等编程模型和编译器优化了程序的执行效率。这些组件共同推动了LSTM并行计算技术的发展和应用。

# 2. GPU加速技术深度剖析

## 2.1 GPU硬件架构与LSTM计算

### 2.1.1 GPU的工作原理及其在LSTM中的作用

GPU(图形处理单元)最初是为图形处理而设计的,但其高度并行的计算能力使其非常适合于处理大规模矩阵运算,这是深度学习模型(包括LSTM)中常见的计算类型。LSTM(长短期记忆网络)是一种特殊类型的循环神经网络(RNN),适用于处理和预测序列数据中的重要事件,且具有长期依赖关系的记忆功能。在LSTM的每个时间步长中,需要计算多个矩阵运算,包括点积、激活函数的调用和点乘运算。

GPU可以通过其成百上千的计算核心并行执行这些运算,从而显著减少计算时间。与CPU相比,GPU核心数量更多,每个核心的处理能力虽然较低,但它们可以同时处理多组数据,这使得GPU在大规模数据处理方面具有明显的优势。

### 2.1.2 GPU内存管理与并行计算模型

在GPU上进行并行计算时,内存管理是一个关键因素。GPU有自己独立的内存空间,它与CPU内存之间通过PCIe总线进行数据交换。在GPU上运行计算任务时,需要显式地将数据从CPU内存传输到GPU内存,并在计算完成后将结果传回CPU内存。

为了优化性能,GPU编程模型引入了全局内存、共享内存和常量内存等概念。全局内存适用于所有线程,但存取速度较慢;共享内存的速度快于全局内存,但其大小有限,只适用于线程块内部的线程共享数据;常量内存用于存储在程序执行期间不改变的数据,且被线程缓存,可以提高读取速度。

在LSTM的实现中,输入数据(如单词嵌入)和网络权重经常被存储在GPU全局内存中。通过合理管理内存访问,例如使用共享内存缓存常用的权重,可以显著提高LSTM模型的运行效率。

## 2.2 CUDA编程模型详解

### 2.2.1 CUDA编程基础

CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种并行计算平台和编程模型,它允许开发者使用NVIDIA的GPU进行通用计算。CUDA提供了一种C语言风格的编程接口,可以用来开发在GPU上运行的并行算法。

CUDA的核心概念包括线程、线程块和网格。线程是执行CUDA程序的最小单位;线程块是包含一定数量线程的集合,这些线程可以协作执行任务;网格是由一个或多个线程块组成的集合,整个CUDA程序在执行时被组织成一个或多个这样的网格。

在LSTM的GPU实现中,通常将时间步长的处理分配给不同的线程块,每个时间步长内部的操作又由线程块内的线程并行执行。为了有效地利用CUDA进行并行计算,需要仔细设计线程的组织结构和内存访问模式。

### 2.2.2 CUDA中的线程组织和内存层次

在CUDA编程模型中,线程的组织方式对性能有着直接影响。线程的组织需要考虑到GPU上核心的物理排列和内存层次。通过将线程组织成逻辑上相邻的线程块可以减少内存访问的延迟,因为相邻线程可以更有效地利用共享内存。

内存层次在CUDA编程中至关重要,尤其是全局内存、共享内存、常量内存以及寄存器。全局内存的访问速度最慢,但容量最大;共享内存的访问速度较快,适用于线程块内的线程协作;寄存器内存访问速度最快,但数量有限,适用于存储临时变量。

对于LSTM,全局内存可以用来存储输入序列数据和网络权重,共享内存则可以在同一个时间步长内由多个线程共享临时计算结果,减少全局内存访问的次数,从而提高性能。

## 2.3 GPU加速的LSTM模型实现

### 2.3.1 GPU上LSTM模型的优化策略

为了在GPU上更有效地运行LSTM模型,需要采取特定的优化策略。这些策略包括但不限于:

- **内存带宽优化**:减少全局内存的访问次数,利用共享内存和寄存器来缓存数据。

- **计算并行化**:确保每个GPU核心尽可能保持忙碌状态,通过分配更多的计算任务给GPU。

- **内核融合**:将多个计算步骤合并到一个CUDA内核中执行,减少线程启动和上下文切换的开销。

在实际开发中,这些优化策略往往需要根据模型的具体情况以及GPU硬件特性进行细致调整。例如,对于LSTM,可以对网络的每个时间步长进行批处理,减少对全局内存的依赖,同时增加计算并行度。

### 2.3.2 实际案例分析:GPU加速LSTM的性能提升

通过一个具体的案例来分析如何实现GPU加速LSTM模型,并评估性能提升。考虑一个使用GPU来加速序列预测任务的LSTM网络。

首先,对LSTM模型进行并行化设计,将不同的时间步长分配给不同的线程块进行计算。在编写CUDA内核时,可以考虑将前向传播和反向传播的计算合并,以减少GPU启动内核的次数。

然后,设计内存访问策略,确保每个线程块能利用共享内存进行必要的中间计算,减少对全局内存的直接访问。

接下来,通过性能分析工具(如NVIDIA的Nsight或者nvprof)来分析并行代码的执行情况,识别瓶颈。根据分析结果,调整线程块的大小、线程组织结构、内存访问模式等,以达到更好的性能。

最后,进行实际的性能测试,比较优化前后的LSTM模型运行时间。通常情况下,优化后的GPU加速LSTM模型在处理大规模数据时,运行速度可以提升数倍甚至更多。

通过以上步骤,可以得到一个在GPU上运行速度显著提升的LSTM模型,适用于需要高效处理大量序列数据的应用场景,如自然语言处理、时间序列预测等。

# 3. TPU加速技术全面探究

## 3.1 TPU硬件架构概述

### 3.1.1 TPU的工作原理及其与LSTM的关系

Tensor Processing Units(TPUs)是由Google特别设计的集成电路,旨在加速机器学习工作负载,尤其是深度学习。它们通过提供大量的并行计算资源,显著提高了计算效率,特别是在矩阵运算上,这是深度学习中极其常见的计算类型。TPUs与传统CPU和GPU相比,可以提供更快的推理速度和更高效的能效比,使得机器学习模型,包括LSTM,能夜更快地运行。

TPU与LSTM之间的关系是相辅相成的。LSTM作为一种特殊的循环神经网络,其时间序列分析能力得益于大量的矩阵运算,尤其是在前向和后向传播过程中。TPUs能够处理这些矩阵运算,能够同时对数据的多个维度进行运算,这样的并行处理能力可以极大提升LSTM模型的训练速度和推理性能。由于TPUs能够在较低的延时下提供更高的吞吐量,它们特别适合于LSTM这类循环神经网络模型的应用场景,如语音识别、自然语言处理等。

### 3.1.2 TPU的编程模型和软件栈

TPUs的操作依赖于Google开发的一套软件栈,使得开发者可以更方便地利用TPUs进行模型训练和推理。TPU的编程模型基于XLA(Accelerated Linear Algebra)编译器,这是一个专门针对机器学习工作负载设计的领域特定编译器。它能够将高级的神经网络模型描述转换成高效的机器代码,直接在TPU硬件上运行。

TPU软件栈主要由以下组件组成:

- TPU运行时(Runtime):一个底层库,为开发者提供了与TPU硬件交互的接口。

- TPU驱动(Driver):操作系统级别的组件,负责管理TPU硬件资源。

- TPU固件(Firmware):位于硬件和操作系统之间的软件层,管理TPU硬件的配置和运行。

- TensorFlow框架:通过TPU插件与TPU运行时库交互,使得用户可以在TensorFlow框架内直接运行TPU支持的操作。

### 3.2 TensorFlow框架中的TPU应用

#### 3.2.1 TensorFlow中的TPU集成方法

在TensorFlow中集成TPU非常简单,只需要几个步骤。首先,需要确认TensorFlow的版本是否支持TPU。随后,利用TensorFlow提供的API,可以创建TPU策略(TPUStrategy),这样模型训练的每个部分就可以在TPU上执行了。下面是一个简单的代码示例,展示如何在TensorFlow中集成TPU。

```python

import tensorflow as tf

# 检查当前环境是否支持TPU

resolver = tf.distribute.cluster_resolver.TPUClusterResolver(tpu='')

tf.config.experimental_connect_to_cluster(resolver)

tf.tpu.experimental.initialize_tpu_system(resolver)

strategy = tf.distribute.experimental.TPUStrategy(resolver)

# 使用TPUStrategy构建模型

with strategy.scope():

model = tf.keras.Sequential([

# 模型的层定义...

])

```

### 3.2.2 在TensorFlow中部署TPU优化的LSTM模型

0

0