学习率问题分析与解决:避免性能过山车的终极指南

发布时间: 2024-11-25 15:43:33 阅读量: 31 订阅数: 37

Python入门指南:技术解析与应用实践

# 1. 学习率问题的理论基础

在深度学习的训练过程中,学习率(Learning Rate,LR)是一个至关重要的超参数,它决定了模型在优化方向上每一步的前进距离。本章将首先从理论层面探讨学习率的概念及其对模型训练的基本影响。

## 1.1 学习率的定义和重要性

学习率是一个控制权重更新步长的参数。在梯度下降算法中,学习率决定了在损失函数的梯度方向上更新参数的幅度。一个合适的学习率可以加速模型的收敛,而一个不合适的学习率则可能导致模型无法收敛或者收敛速度过慢。

## 1.2 学习率的数学表示

数学上,学习率可以表示为每次迭代中权重更新的大小,公式可以表达为:

```math

w_{new} = w_{old} - \eta \cdot \nabla_{w} J(w)

```

其中,`w`代表模型参数,`η`为学习率,`∇_{w} J(w)`为损失函数关于参数`w`的梯度。

## 1.3 学习率在训练中的作用

学习率不仅仅是更新步长的大小,它还影响到训练的稳定性和最终模型性能。一个过大的学习率可能导致模型无法收敛,而过小则可能导致训练过程陷入局部最小值或收敛速度过慢。通过适当地设置学习率,可以在保证稳定性和收敛速度的同时,寻找更优的模型参数。

随着技术的不断进步,学习率的调整和优化策略也在不断演进,为了解这些策略背后的原理和实践经验,我们将依次探讨学习率的作用、选择策略以及调整技术,并在后续章节中深入分析自适应学习率优化算法和调度器的应用。

# 2. 学习率对模型训练的影响

## 2.1 学习率的定义和作用

在机器学习和深度学习中,学习率是一个关键的超参数,它决定了在优化算法中参数更新的步长。学习率过高可能会导致模型无法收敛,而学习率过低则会使训练过程过于缓慢,甚至陷入局部最优。

### 2.1.1 学习率在梯度下降中的角色

梯度下降是一种最常用的优化算法,通过计算损失函数关于模型参数的梯度,以此作为方向来更新参数,旨在最小化损失函数。学习率定义了在梯度方向上参数更新的步长大小。以下是梯度下降更新参数的基本公式:

```python

theta = theta - learning_rate * gradient

```

在这个公式中,`theta`表示模型参数,`learning_rate`是学习率,而`gradient`是损失函数关于参数的梯度。学习率的大小直接影响参数更新的幅度。如果学习率过大,可能会导致更新的步骤超出最优解的附近区域,从而无法收敛;而如果学习率太小,虽然每次更新都较为谨慎,但需要更多的迭代次数,这会增加训练时间并可能导致过拟合。

### 2.1.2 学习率的大小对模型训练的影响

学习率对于模型训练的收敛速度和最终性能有着极其重要的影响。下面是一些关于学习率大小的影响的观察:

- **学习率过大**:参数更新步长过大,可能导致模型损失函数值在优化过程中出现大幅震荡,甚至发散,最终无法达到收敛状态。

- **学习率适中**:在训练初期,适当的较大学习率有助于快速下降到损失函数的某个局部最小值附近。随着训练过程的进行,学习率逐渐减小有助于在局部最小值附近进行细致的搜索。

- **学习率过小**:学习率太小可能会导致模型在训练过程中几乎没有进展,因为参数更新的步长非常小,这会使得模型在陷入局部最小值之前需要非常长的训练时间,而且容易受到随机梯度噪声的影响。

## 2.2 学习率的选择策略

### 2.2.1 常见的学习率选择方法

在实践中,学习率的选择往往需要一定的经验和实验。以下是几种常见的学习率选择方法:

- **经验法**:根据过往经验或者文献研究的推荐值来设定学习率。这种方法简单快捷,但缺乏针对性。

- **试错法(Grid Search)**:在可能的学习率区间内进行网格搜索,测试每一种学习率对模型性能的影响,最后选择性能最好的学习率。

- **学习曲线法**:观察模型在不同学习率下的学习曲线(损失函数值随训练过程的变化),从中选择导致模型性能最佳的学习率。

### 2.2.2 学习率的调整和优化技术

学习率调整技术是提高模型训练效率和性能的重要手段。以下是一些常见的学习率调整策略:

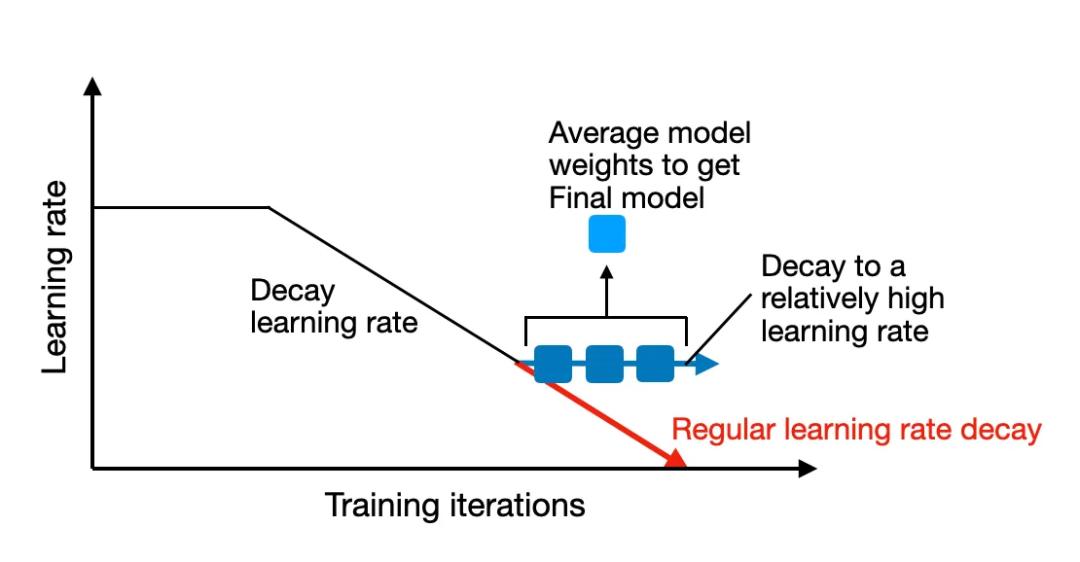

- **学习率衰减**:在训练过程中逐步减小学习率。可以通过预设衰减率或者在训练过程中根据验证集的性能来动态调整学习率。

- **学习率预热**:开始时使用较小的学习率,逐渐增加到一个较大的值。这可以防止模型在训练初期就陷入训练数据中的局部最小值。

- **循环学习率**:在训练过程中周期性地改变学习率的值,使其在高值和低值之间循环。这种方法旨在结合学习率较大时的快速下降和学习率较小时的精细调整。

- **自适应学习率算法**:如Adam、RMSprop等,这些算法能够根据梯度的历史信息和当前梯度的大小自动调整学习率。自适应学习率算法能在一定程度上减少对学习率精细调整的依赖。

接下来的章节将继续深入探讨学习率的调整技术和实践经验。通过实际案例的研究,我们将分析如何在不同任务和算法框架下进行有效学习率的调整。

# 3. 学习率调整技术的实践经验

## 3.1 学习率预热和衰减技术

### 3.1.1 学习率预热的必要性

在模型训练的早期阶段,由于权重初始化可能是随机的,此时如果使用较大的学习率,可能会导致模型权重更新过于剧烈,从而使得模型难以稳定下来。学习率预热(Learning Rate Warmup)是一种技术,旨在在训练初期逐渐增加学习率,从一个较低的值开始慢慢增大到目标值。这有助于模型更好地适应数据,使得梯度下降过程更为平滑。

使用学习率预热的好处包括:

1. **平滑的梯度下降:** 通过从一个较小的学习率开始,可以帮助梯度下降过程更加稳定,避免权重的大幅跳跃。

2. **更好的初始化收敛:** 在训练初期,权重往往需要时间来“适应”数据。预热学习率给权重提供了一个相对温和的开始环境,有助于更快地收敛到一个较好的局部最优解。

3. **减少初期的过拟合风险:** 如果初始学习率太大,可能会导致模型在训练数据上过拟合。预热学习率可以减少这种风险。

### 3.1.2 学习率衰减的策略

学习率衰减指的是在模型训练的过程中逐渐减少学习率的策略。这是为了在训练接近尾声时,使权重更新更加精细,避免模型在最小值附近震荡。学习率衰减可以帮助模型在训练的后期阶段收敛到更好的性能。

学习率衰减的常见策略包括:

- **固定衰减:** 在一定数量的epoch后,将学习率乘以一个固定的小于1的因子,如0.1。

- **步衰减:** 每隔固定数量的训练步骤或epoch后,将学习率衰减。

- **指数衰减:** 随着训练的进行,学习率按照指数形式衰减。

- **余弦退火:** 使用余弦函数作为学习率衰减的调度器,使得学习率按照余弦曲线的形态进行调整。

代码展示如何在PyTorch中使用学习率衰减:

```python

import torch.optim as optim

from torch.optim.lr_scheduler import StepLR

# 定义优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 定义学习率调度器,每20个epoch后衰减一次

scheduler = StepLR(optimizer, step_size=20, gamma=0.1)

# 训练循环

for epoch in range(num_epochs):

train(model, data_loader, optimizer)

scheduler.step() # 更新学习率

```

在上述代码中,我们首先导入了必要的模块,然后定义了一个Adam优化器,并且使用了`StepLR`作为学习率衰减的调度器。`StepLR`将会在每个epoch结束时调用`scheduler.step()`方法,根据步长(`step_size`)和衰减因子(`gamma`)来调整学习率。

## 3.2 循环学习率和周期性学习率

### 3.2.1 循环学习率的基本原理

循环学习率(Cyclic Learning Rates)是一种创新的学习率

0

0