学习率与正则化:训练中的平衡艺术

发布时间: 2024-11-25 16:24:37 阅读量: 43 订阅数: 38

调优的艺术:Transformer模型超参数调整全指南

# 1. 深度学习中的学习率基础

在深度学习模型的训练过程中,学习率是控制权重更新幅度的关键超参数。一个合适的学习率能够保证模型稳定且高效地收敛到最优解,而一个不当的学习率可能导致模型无法收敛,甚至发散。因此,理解并掌握学习率的基础知识,对于任何希望提高机器学习项目性能的从业者来说,都是至关重要的。

## 学习率的基本概念

### 学习率的定义与重要性

学习率(Learning Rate)通常被定义为在优化过程中参数更新的步长。它决定了在梯度下降算法中,模型权重更新的量。如果学习率设置得太小,模型可能会陷入局部最小值,并且训练过程会非常缓慢,甚至在未找到最优解之前停止。相反,如果学习率设置得过大,模型可能无法稳定收敛,可能会在最优解附近振荡,甚至发散。

### 学习率对模型训练的影响

学习率在模型训练过程中的影响是多方面的。它影响模型学习速度以及最终模型的性能。通过调整学习率,我们可以控制模型在参数空间中探索的速度和范围。一个合适的学习率能确保模型在训练过程中快速接近最优解,并在最优解附近进行精细调整。学习率的调整策略与模型的复杂度、数据集的大小和质量以及训练的深度等因素都有关系。因此,找到适合特定问题的学习率,是优化深度学习模型的关键一步。

# 2. 学习率调度策略详解

## 2.1 学习率的基本概念

### 2.1.1 学习率的定义与重要性

学习率是深度学习训练中非常关键的一个超参数,它决定了在优化过程中参数更新的步长。学习率的大小直接影响模型的收敛速度和模型性能。如果学习率设置得过高,可能导致模型无法收敛,或者在最优解周围震荡;相反,如果设置得过低,虽然可以保证模型的稳定收敛,但会使得训练过程非常缓慢,甚至陷入局部最小值。

学习率的重要性体现在其对梯度下降算法的影响上。在梯度下降或其变种(如随机梯度下降SGD)中,参数更新规则通常为:

```python

θ = θ - η * ∇θJ(θ)

```

其中,`θ` 是模型参数,`η` 是学习率,`∇θJ(θ)` 是参数梯度。学习率决定了每次迭代中参数更新的幅度,因此,它直接控制着模型对数据的学习速度和能力。

### 2.1.2 学习率对模型训练的影响

学习率不仅影响模型训练的稳定性,还对模型的最终性能有显著影响。理想的设置应当是在模型训练初期允许较大的步长以快速接近最优解,而在接近最优解时减小步长以精细调整参数。

在模型训练的不同阶段,调整学习率有其特殊的意义:

- **初期阶段**:大的学习率有助于快速探索参数空间,避免陷入局部最小值。

- **中期阶段**:随着训练的进行,学习率需要逐渐减小,以便在最小值附近进行精细搜索。

- **末期阶段**:在模型接近收敛时,非常小的学习率有助于微调模型,提高泛化能力。

## 2.2 学习率调度技术

### 2.2.1 固定学习率法

固定学习率是最简单的一种学习率调度方法,即在训练的整个过程中都使用同一个学习率。这种方法的优点是简单易实现,但其缺点也很明显,即无法适应训练过程中损失函数下降的速度变化。

对于使用固定学习率的SGD,其伪代码可以表示为:

```python

for epoch in range(num_epochs):

for batch in dataset:

gradients = compute_gradients(batch, model)

model.update_parameters(gradients, fixed_learning_rate)

```

其中,`num_epochs` 是总训练周期数,`compute_gradients` 是计算当前批次数据梯度的函数,`update_parameters` 是根据梯度和学习率更新模型参数的函数。

### 2.2.2 动态学习率调整法

动态学习率调整法包括学习率预热(warm-up)、周期性衰减等策略,能够根据训练进程动态调整学习率。这种方法有助于模型在训练初期快速收敛,并在训练后期避免过拟合。

学习率预热是一种常用的方法,它指的是在训练的早期阶段逐渐增加学习率,使得模型参数能够得到较好的初始化。例如:

```python

global_step = 0

initial_learning_rate = 0.001

warmup_steps = 500

learning_rate = initial_learning_rate * (global_step / warmup_steps)

```

其中,`global_step` 表示当前迭代步数,`warmup_steps` 是预热阶段的总步数。学习率随训练的进行而线性增加,直到达到预设的学习率。

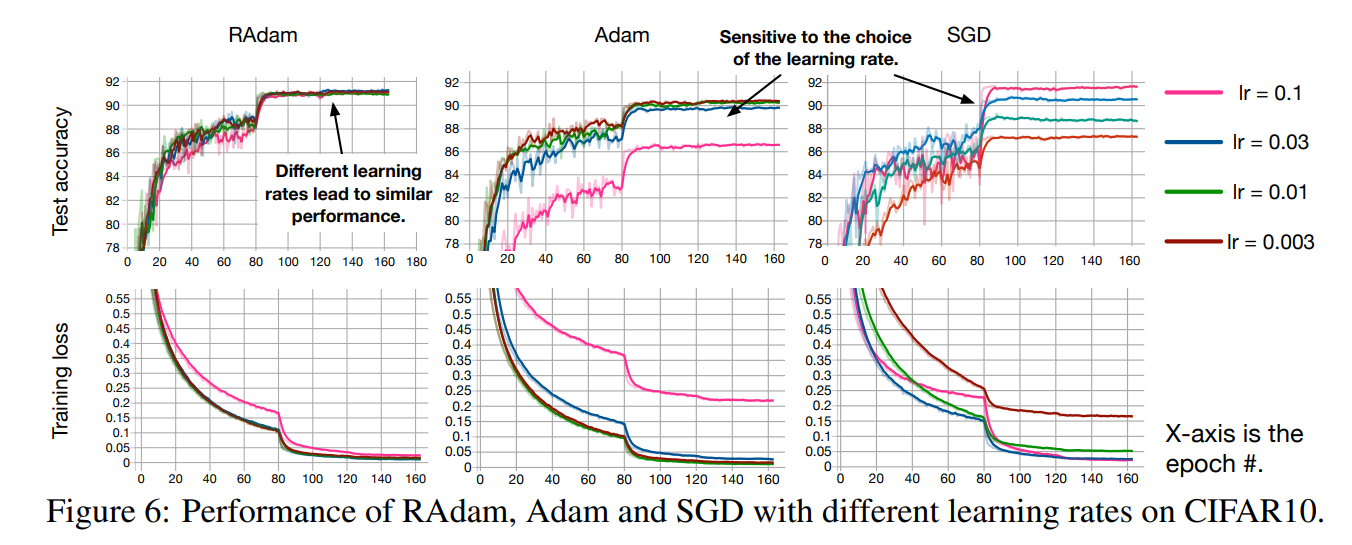

### 2.2.3 自适应学习率优化器

自适应学习率优化器,如Adam、RMSprop等,通过调整每个参数的学习率来加速训练过程。这些优化器会根据参数的历史梯度信息来动态调整学习率,使得训练更加稳定。

以Adam优化器为例,它使用一阶矩估计和二阶矩估计来动态调整每个参数的学习率:

```python

def adam_optimizer(params, grads, t):

beta1 = 0.9

beta2 = 0.999

epsilon = 1e-8

m = beta1 * m + (1 - beta1) * grads

v = beta2 * v + (1 - beta2) * (grads ** 2)

mt_hat = m / (1 - beta1 ** t)

vt_hat = v / (1 - beta2 ** t)

params -= learning_rate * mt_hat / (torch.sqrt(vt_hat) + epsilon)

```

其中,`params` 是模型参数,`grads` 是参数的梯度,`m` 和 `v` 分别是梯度的一阶矩估计和二阶矩估计,`t` 是当前迭代步数。

## 2.3 学习率调度实践案例

### 2.3.1 学习率预热与衰减

学习率预热(warm-up)和衰减(decay)策略可以结合起来使用,以获得更好的模型训练效果。预热策略可以帮助模型在训练初期避免梯度消失或爆炸问题,而衰减策略则有助于在训练后期避免过拟合。

例如,可以设置学习率随训练步数指数衰减,如下所示:

```python

global_step = 0

initial_learning_rate = 0.1

decay_rate = 0.96

decay_steps = 10000

learning_rate = initial_learning_rate * (decay_rate ** (global_step / decay_steps))

```

其中,`initial_learning_rate` 是初始学习率,`decay_rate` 是每经过 `decay_steps` 步后学习率衰减的比例。

### 2.3.2 循环学习率调度

循环学习率调度(cyclic learning rates)是一种更加灵活的学习率调度策略。它允许学习率在指定的最小值和最大值之间周期性地变化。在某些情况下,这种策略可以替代学习率预热,并且有助于模型探索更广泛的参数空间。

下面是一个循环学习率调度的示例,其中学习率随训练步数正弦变化:

```python

import numpy as np

global_step = 0

min_lr = 1e-5

max_lr = 1e-2

step_size = 2000

learning_rate = min_lr + (max_lr - min_lr) * (1 + np.cos(global_step * np.pi / step_size)) / 2

```

### 2.3.3 学习率退火技术应用

学习率退火技术通常在训练过程中将学习率降低到一个极小的值,以便在模型接近最优解时进行微调。这种技术经常在训练的后期阶段使用,以提高模型的泛化能力。

一个常用的学习率退

0

0