【降维在监督学习中的应用】:简化模型,提升学习效率

发布时间: 2024-09-01 19:19:28 阅读量: 96 订阅数: 57

# 1. 监督学习基础与降维概念

在数据科学和机器学习的领域中,监督学习是核心任务之一。它涉及使用标记的数据集来训练模型,使其能够预测或分类新数据点。然而,面对高维数据时,模型可能面临性能下降和效率低下的问题,这通常被称为“维度的诅咒”。为了克服这个问题,降维技术应运而生,它的目的是简化数据,减少参数数量,同时尽可能保留原始数据的关键信息。本章将为读者提供一个关于监督学习和降维技术的基础概念和原理的概述。

## 1.1 维度的诅咒概述

维度的诅咒是指在高维空间中,数据分布稀疏,导致样本数量相对于维度指数级增长,这会使得数据的统计特性难以估计,并且处理这些数据变得更加复杂和计算量巨大。简单来说,随着维度的增加,数据可用的信息实际上可能会减少,这在监督学习模型中会引起过拟合和泛化能力差的问题。

## 1.2 高维数据对机器学习的影响

高维数据会导致机器学习模型难以从数据中学习有效特征,并且在计算上极为昂贵。例如,在一个具有100个特征的数据集中,如果每个特征只有两个可能的值,那么所有可能的组合将达到2的100次方,这是一个天文数字。因此,在使用监督学习算法时,降维变得至关重要,它能够帮助我们减少计算成本,并提高模型的预测性能。

以上是第一章的基本内容,它为后续章节深入探讨降维技术提供了理论基础。接下来的章节将详细介绍降维技术的分类与原理,以及这些技术在监督学习中的具体应用。

# 2. ```

# 第二章:降维技术的理论基础

## 2.1 维度灾难与高维数据问题

### 2.1.1 维度的诅咒概述

在机器学习和数据分析领域,维度诅咒是指随着数据的维度增加,数据的容量呈指数级增长,然而可用的信息量却并没有相应的增加,反而导致计算量和存储空间需求成比例增加。高维空间的一个关键问题就是它在体积上的稀疏性:随着维度的增加,数据点之间的距离越来越远,导致传统的距离度量方法(如欧几里得距离)变得不再有效。这给数据建模带来了极大的挑战,尤其是在样本数量有限的情况下,高维数据集很容易变得稀疏和不均匀,从而影响机器学习模型的性能。

### 2.1.2 高维数据对机器学习的影响

高维数据集在机器学习应用中,常会遇到以下几个主要问题:

1. **过拟合**:模型在高维空间中很容易对训练数据过拟合,尤其是在样本数量有限的情况下,模型可能会记忆训练数据而不是学习数据之间的关系。

2. **计算复杂度**:高维数据的计算复杂度往往较高,对于许多机器学习算法而言,其时间复杂度和空间复杂度都会随着维度的增加而增加。

3. **可视化难度**:高维数据难以直观地展示和解释,这限制了我们对数据的理解和分析能力。

由于这些挑战,降维技术成为了数据分析和机器学习领域的重要工具,目的是减少数据维度的数量,同时保留尽可能多的原始数据信息。

## 2.2 降维技术的分类与原理

### 2.2.1 线性和非线性降维方法

降维方法可以分为线性和非线性两大类:

1. **线性降维方法**:假设数据可以通过线性变换来进行降维。这类方法比较典型的是主成分分析(PCA),它通过寻找数据的主成分来实现降维。线性降维方法通常计算效率较高,且数学理论比较成熟。

2. **非线性降维方法**:适用于数据的分布结构不适合线性假设的情况。这类方法包括核主成分分析(Kernel PCA)、等距映射(Isomap)、局部线性嵌入(LLE)等。它们通过考虑数据在高维空间中的局部或全局结构来实现降维,从而能够更好地揭示数据的内在结构。

### 2.2.2 特征选择与特征提取的区别

在降维技术中,我们可以将降维操作分为特征选择和特征提取两个子领域:

1. **特征选择**:是从原始特征中选择一部分子集,这些子集尽可能地代表原始特征集合的信息。特征选择不改变特征本身,只是挑选出更加有用的特征。

2. **特征提取**:则是通过某些转换(例如PCA中的主成分变换)从原始特征中提取新的特征,这些新的特征是原始特征的线性或非线性组合。特征提取可能会改变特征的本质,但其目的是为了降维和提升模型性能。

## 2.3 降维在监督学习中的作用

### 2.3.1 提高学习效率与性能

在监督学习任务中,降维能够显著提高模型的学习效率和最终性能:

1. **减少过拟合**:降维可以减少模型的复杂度,通过降低特征数量来减少模型对噪声和异常值的敏感性,降低过拟合的风险。

2. **加快训练速度**:模型训练时间和计算资源消耗会随着特征数量的减少而显著降低。

3. **改善模型泛化能力**:适当的降维能够帮助模型更好地泛化到未见过的数据。

### 2.3.2 降噪与数据可视化

降维不仅有助于提高学习效率和性能,还可以用于降噪和数据可视化:

1. **降噪**:降维技术有助于去除数据中的噪声和冗余信息,尤其是在特征提取过程中,通过对数据进行压缩和重构,可以分离出主要信号和噪声。

2. **数据可视化**:降维可以将高维数据转换为二维或三维空间,使得人们能够直观地观察和理解数据的结构和模式。

这些作用使得降维成为了处理高维数据的一个重要步骤,为后续的数据分析和模型训练奠定了坚实的基础。

```

# 3. 线性降维方法实践应用

## 3.1 主成分分析(PCA)实战指南

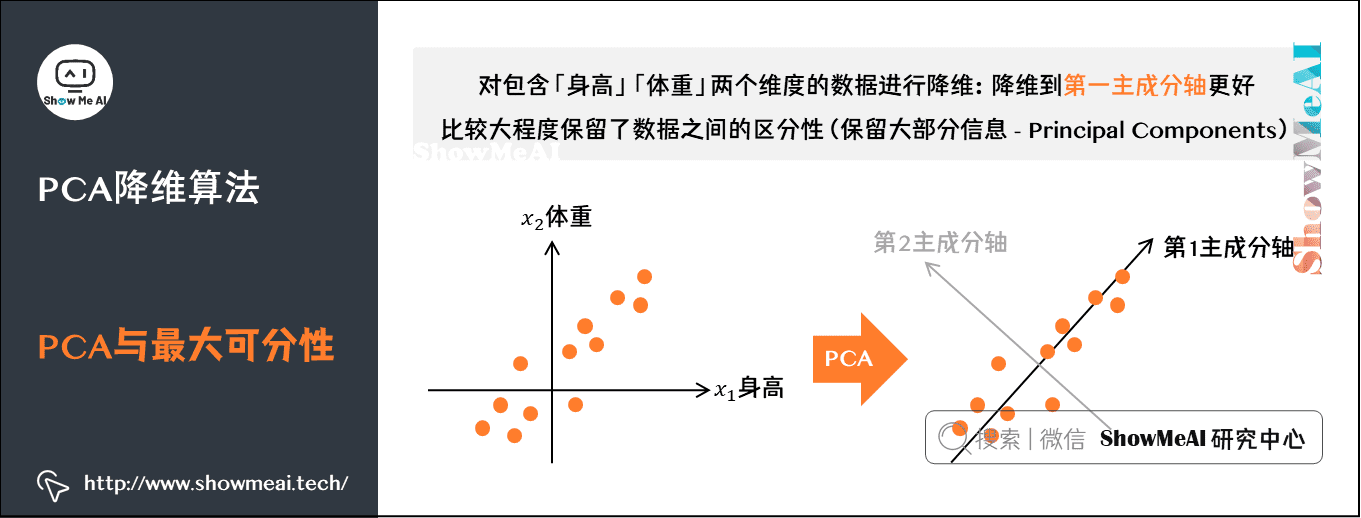

主成分分析(PCA)是最常用的线性降维技术,旨在将多维数据集转换成较低维度的数据空间,同时尽可能保留原始数据的特征和结构。PCA通过正交变换将可能相关的变量转换为一组线性不相关的变量,这些变量称为主成分。

### 3.1.1 PCA算法流程解析

PCA算法的核心步骤包括:

- **数据标准化**:为了使数据在PCA中有相同的量级,通常先对数据进行标准化处理,使得特征的均值为0,标准差为1。

- **计算协方差矩阵**:协方差矩阵能够表示各个变量之间的协方差,它反映了不同变量之间的变化趋势。

- **求特征值和特征向量**:对协方差矩阵进行特征分解,得到特征值和对应的特征向量。特征向量是原始数据降维后的新坐标轴,而特征值则表示了在这个轴上的方差大小。

- **选择主成分**:根据特征值的大小,选择最重要的n个特征向量构成投影矩阵,n通常小于原始特征的个数。

- **构造低维空间**:将原始数据投影到选择的n个特征向量上,得到降维后的数据。

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.preprocessing import StandardScaler

# 假设X是需要降维的数据集

# 数据标准化

scaler = StandardScaler()

X_std = scaler.fit_transform(X)

# PCA降维

pca = PCA(n_components=2) # 选择2个主成分进行降维

X_pca = pca.fit_transform(X_std)

# 查看每个主成分的解释方差比率

print(pca.explained_variance_ratio_)

```

在上述代码中,`StandardScaler`用于标准化数据,`PCA`类实现了PCA算法。`n_components`参数用于指定主成分的数量。`fit_transform`方法对数据集进行拟合并执行转换。`explained_variance_ratio_`属性用于查看每个主成分解释的方差比例。

### 3.1.2 PCA在监督学习中的应用案例

在监督学习任务中,PCA可用于数据预处理阶段,以减少特征数量,降低过拟合风险,提高模型的泛化能力。例如,在图像识别任务中,大量的像素值可以被转化为较少的主成分,而这些主成分仍然能够保留大部分的信息。

```python

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 加载数字数据集

digits = load_digits()

X, y =

```

0

0