线性系统中的卡尔曼滤波算法详解

发布时间: 2024-04-14 02:07:16 阅读量: 85 订阅数: 54

卡尔曼滤波简介+ 算法实现代码.txt

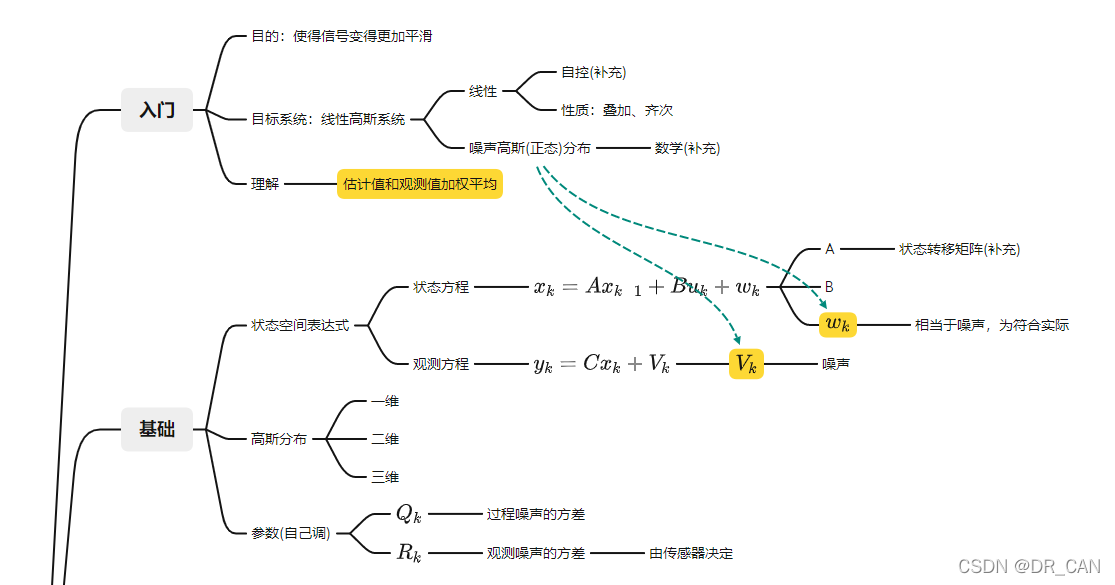

# 1. 线性系统概述

线性系统是一种常见的数学模型,其特点在于遵循线性叠加原理和齐次性质。线性系统的定义是指系统的响应与输入之间存在线性关系,即满足线性叠加和齐次性质。线性系统的数学建模可以通过状态方程和观测方程来描述系统的动态行为。状态方程描述系统的状态随时间的演变,而观测方程则描述系统状态与观测值之间的关系。线性系统的特性包括稳定性、可控性和可观测性等,这些特性在系统分析和控制中起着重要作用。了解线性系统的概念和特性对于进一步学习和理解卡尔曼滤波算法至关重要。

# 2. 卡尔曼滤波算法基础

2.1 卡尔曼滤波算法简介

卡尔曼滤波是一种用于从不完全和嘈杂的传感器数据中估计动态系统状态的强大算法。它通过融合系统动态模型和测量数据,提供对系统状态的最优估计。卡尔曼滤波器在航空航天、自动驾驶、金融和其他领域广泛应用。

卡尔曼滤波的作用是通过递归估计方式,从不完全的、不精确的观测数据中计算出动态系统的状态变量。

卡尔曼滤波的原理基于状态空间模型,该模型包括系统的状态方程和观测方程。通过状态方程对系统状态进行预测,再通过观测方程校正预测值,得到最优状态估计。

2.2 状态估计问题

马尔可夫过程是指具有马尔可夫性质的随机过程,即未来的状态只与当前状态有关,与过去的状态无关。在状态估计问题中,假设系统的动态过程满足马尔可夫性质。

最小均方估计是一种基于贝叶斯理论的估计方法,旨在找到最小化估计误差的估计值。卡尔曼滤波就是一种最小均方估计算法,通过不断更新对系统状态的估计,使估计误差保持在最小范围内。

```python

import numpy as np

# Initialize the Kalman filter parameters

def initialize_kalman_filter():

state_mean = np.array([0, 0]) # Initial state mean

state_covariance = np.array([[1, 0], [0, 1]]) # Initial state covariance matrix

measurement_covariance = np.array([[0.1, 0], [0, 0.1]]) # Measurement covariance matrix

process_covariance = np.array([[1, 0], [0, 1]]) # Process covariance matrix

return state_mean, state_covariance, measurement_covariance, process_covariance

```

卡尔曼增益是卡尔曼滤波算法中的关键概念,它表示系统测量值和预测值之间的权衡。通过计算卡尔曼增益,可以确定在状态更新时对系统动态模型和测量数据进行权重分配的比例。

卡尔曼增益的计算方法通常涉及卡尔曼滤波算法中的协方差矩阵、观测矩阵和卡尔曼增益矩阵的运算,以最小化估计误差并实现最优状态估计。

```python

def calculate_kalman_gain(state_covariance, measurement_covariance, observation_matrix):

kalman_gain = np.dot(np.dot(state_covariance, observation_matrix.T),

np.linalg.inv(np.dot(np.dot(observation_matrix, state_covariance),

observation_matrix.T) + measurement_covariance))

return kalman_gain

```

以上是关于卡尔曼滤波算法基础的介绍,接下来将深入探讨一维卡尔曼滤波算法的具体实现。

# 3. 一维卡尔曼滤波算法实现

3.1 离散时间一维卡尔曼滤波器

一维卡尔曼滤波器用于估计一个系统的状态变量,其内部包括状态更新方程和测量更新方程。首先,在状态更新方程中,状态向量和状态转移矩阵通过线性组合得出新的状态预测值。其数学表达式为:

$$ x_k = A \cdot x_{k-1} + B \cdot u_k + w_k $$

其中,$x_k$ 是当前时刻系统的状态向量,$A$ 是状态转移矩阵,$B$ 是输入控制矩阵,$u_k$ 是输入控制量,$w_k$ 是过程噪声。

其次,在测量更新方程中,通过融合状态预测值和测量值,得到最优的系统状态估计值。数学表达式如下:

$$ \hat{x}_k = x_k + K \cdot (z_k - H \cdot x_k) $$

在这里,$\hat{x}_k$ 表示最优状态估计值,$z_k$ 是当前时刻的测量值,$K$ 是卡尔曼增益,$H$ 是状态转移矩阵。

最后在系统参数初始化阶段,需要对系统的初始状态、协方差矩阵、过程噪声和测量噪声等进行设置,以保证卡尔曼滤波器的正确运行。

3.2 卡尔曼增益的计算

卡尔曼增益是卡尔曼滤波算法中的关键参数,其作用在于衡量系统模型和测量值之间的权衡。卡尔曼增益的计算涉及到系统的协方差矩阵和观测噪声协方差矩阵的加权组合。具体而言,在离散时间下,卡尔曼增益的计算公式如下所示:

$$ K = P \cdot H^T \cdot (H \cdot P \cdot H^T + R)^{-1} $$

其中,$K$ 表示卡尔曼增益,$P$ 是预测误差的协方差矩阵,$H$ 是观测矩阵,$R$ 是观测噪声的协方差矩阵。

通过以上卡尔曼增益的计算方法,可以在每次迭代中更新系统的状态估计值,使得系统能够更加准确地估计实际状态,从而提高滤波器的性能。

# 4. 多维卡尔曼滤波算法应用

4.1 连续时间多维卡尔曼滤波器

在实际应用中,许多系统可以通过多个相关联的状态变量来描述。这时就需要使用多维卡尔曼滤波器来对系统状态进行估计。多维卡尔曼滤波器与一维卡尔曼滤波器的基本原理相同,只不过需要考虑多个状态变量之间的关系。

4.1.1 多维系统状态模型

多维系统状态模型可以表示为:

x_{k+1} = Fx_k + Bu_k + w_k

其中,$x_k$ 是系统状态向量,$F$ 是状态转移矩阵,$B$ 是控制输入矩阵,$u_k$ 是控制输入,$w_k$ 是系统过程噪声。

4.1.2 多维观测模型

多维观测模型可以表示为:

z_k = Hx_k + v_k

其中,$z_k$ 是观测向量,$H$ 是观测矩阵,$v_k$ 是观测噪声。

4.1.3 状态估计更新

状态估计更新过程可以按照以下步骤进行:

1. 预测步骤:根据系统动态方程和控制输入,预测系统状态的均值和协方差矩阵。

2. 更新步骤:根据预测状态和观测值,计算卡尔曼增益,并更新状态的均值和协方差矩阵。

4.2 非线性系统中的扩展卡尔曼滤波(EKF)

在实际应用中,许多系统并不是线性的,这时就需要使用扩展卡尔曼滤波(EKF)来处理非线性系统。EKF通过线性化系统动态方程和观测方程来近似描述非线性系统的状态估计。

4.2.1 EKF算法原理

EKF的基本原理是通过泰勒级数展开非线性函数,将非线性系统在每个时间步线性化,然后应用卡尔曼滤波算法来进行状态估计。这样可以将非线性系统近似为线性系统进行处理。

4.2.2 EKF在实际应用中的局限性

尽管EKF在处理非线性系统时具有一定的有效性,但在某些情况下会存在局限性。特别是对于高度非线性的系统,由于线性化的近似误差会累积,可能导致滤波结果不准确。

以上是关于多维卡尔曼滤波算法应用中的连续时间多维卡尔曼滤波器和非线性系统中的扩展卡尔曼滤波(EKF)的详尽讲解。接下来,我们将进一步探讨卡尔曼滤波在实际工程中的具体应用及发展趋势。

# 5. 卡尔曼滤波算法在无人车辆中的应用研究

为了提高无人车辆的自动驾驶精度和稳定性,卡尔曼滤波算法被广泛应用于无人车辆的定位和导航系统中。本章将深入探讨卡尔曼滤波在无人车辆中的具体应用研究,包括算法实现、优化策略以及实际效果评估。

1. 硬件设备准备

- 无人车辆实验平台搭建

- 惯性导航传感器安装与校准

- GNSS定位模块接入

2. 数据采集与预处理

- 采集车辆在不同环境下的传感器数据

- 数据去噪处理与时序对齐

3. 卡尔曼滤波器设计与实现

```python

# 一维卡尔曼滤波器实现示例

def kalman_filter(measurement, last_estimate, last_covariance):

# 状态更新

predict_estimate = last_estimate

predict_covariance = last_covariance + process_noise

# 测量更新

kalman_gain = predict_covariance / (predict_covariance + measurement_noise)

estimate = predict_estimate + kalman_gain * (measurement - predict_estimate)

covariance = (1 - kalman_gain) * predict_covariance

return estimate, covariance

```

4. 算法优化策略

- 优化传感器融合策略,提高状态估计准确性

- 考虑不确定性因素,优化卡尔曼滤波参数调节

5. 实际效果评估

- 采用真实路况数据进行仿真实验

- 对比传统定位算法和卡尔曼滤波算法的定位精度和稳定性

6. 结果分析

- 卡尔曼滤波算法在无人车辆定位中表现出较高的精度和鲁棒性

- 通过对比实验结果,验证卡尔曼滤波算法在提升自动驾驶系统性能方面的有效性

7. 拟合场景下的工程应用

```mermaid

graph LR

A[数据采集] --> B(数据预处理)

B --> C{是否满足卡尔曼滤波条件}

C --> |是| D[卡尔曼滤波处理]

C --> |否| E[其他处理方式]

D --> F(算法优化)

F --> G(实际效果评估)

```

8. 总结与展望

- 总结本章研究成果,指出卡尔曼滤波在无人车辆定位中的重要作用

- 展望未来,在无人车辆领域进一步推广和优化卡尔曼滤波算法的应用

9. 参考文献

- Smith, R. (2005). Kalman Filter for Beginners with MATLAB Examples. AI Access Foundation.

以上是卡尔曼滤波算法在无人车辆中的应用研究的具体章节内容,涵盖了硬件准备、数据处理、算法实现、优化策略、实际效果评估等方面,旨在探讨卡尔曼滤波在无人车辆中的有效性和潜力。

0

0