【Feeds库高级功能解析】:精通feeds库,打造高效Python爬虫

发布时间: 2024-10-13 13:14:09 阅读量: 2 订阅数: 2

# 1. Feeds库概述与安装

## 1.1 Feeds库简介

Feeds库是一个用于处理网络数据抓取的Python库,它提供了一套完整的工具来简化数据抓取的过程。从简单的网页内容获取到复杂的数据结构解析,Feeds库都能提供高效、灵活的解决方案。

## 1.2 安装Feeds库

安装Feeds库非常简单,可以通过pip命令直接安装:

```bash

pip install feeds

```

安装完成后,你就可以在你的Python项目中使用Feeds库了。

## 1.3 Feeds库的优势

Feeds库的优势在于它的灵活性和强大的扩展性。它支持多种数据输出格式,如JSON、CSV等,同时也支持自定义输出器。此外,Feeds库的错误处理机制也十分完善,能够帮助开发者更好地处理网络抓取中可能遇到的问题。

以上内容仅为第一章的概述,详细内容将在后续章节中展开。

# 2. Feeds库核心组件解析

## 2.1 解析器(Parser)组件

### 2.1.1 解析器的基本用法

解析器是Feeds库中用于将原始数据(如HTML或XML)转换为Python可操作数据结构的关键组件。在本章节中,我们将探讨如何使用Feeds库中的解析器组件来处理不同类型的数据源。

首先,我们需要导入Feeds库,并创建一个解析器对象。假设我们正在处理一个XML数据源,我们可以这样初始化一个解析器:

```python

from feeds import Feeds

# 创建解析器对象

parser = Feeds()

```

接下来,我们定义一个XML源,并使用解析器来解析它:

```python

# 定义XML数据源

xml_data = """

<books>

<book>

<title>Effective Python</title>

<author>Brett Slatkin</author>

</book>

<book>

<title>Python Cookbook</title>

<author>David Beazley</author>

</book>

</books>

# 解析XML数据

parser.feed(xml_data)

```

解析完成后,我们可以访问解析后的数据:

```python

# 访问解析后的数据

print(parser.data)

```

解析器的基本用法通常涉及到数据的输入(`feed`方法)、解析过程以及数据的输出。在本章节的介绍中,我们将深入解析这些步骤,并展示如何使用解析器来处理更复杂的数据结构。

### 2.1.2 解析器的自定义与扩展

在本章节中,我们将探讨如何自定义和扩展Feeds库中的解析器组件。自定义解析器可以让我们处理特定格式的数据或优化解析性能。

假设我们需要解析一个自定义格式的数据源,我们可以创建一个继承自`ParserBase`的解析器类:

```python

from feeds.parser import ParserBase

class CustomParser(ParserBase):

def parse(self, content):

# 自定义解析逻辑

# ...

return parsed_data

```

在这个自定义解析器中,我们需要重写`parse`方法来实现特定的解析逻辑。接下来,我们可以使用这个自定义解析器来解析数据:

```python

# 创建自定义解析器对象

custom_parser = CustomParser()

# 使用自定义解析器解析数据

custom_parser.feed(custom_data)

```

自定义解析器提供了一种灵活的方式来扩展Feeds库的功能,使其能够适应各种不同的数据源。在本章节中,我们将展示如何实现自定义解析器,并讨论一些常见的自定义场景和最佳实践。

## 2.2 数据模型(Model)组件

### 2.2.1 数据模型的结构和作用

数据模型是Feeds库中的核心组件之一,它定义了数据的结构和如何存储这些数据。在本章节中,我们将深入探讨数据模型的结构和作用。

数据模型通常由一组字段和字段类型组成,用于表示数据的结构。例如,一个博客帖子的数据模型可能包含标题、作者、内容等字段。每个字段都有一个特定的类型,如字符串、整数或日期时间。

以下是一个简单的数据模型示例:

```python

from feeds.model import Model, StringField, IntegerField

class Post(Model):

title = StringField()

author = StringField()

content = StringField()

published_at = DateTimeField()

```

在这个例子中,我们定义了一个`Post`类,它继承自`Model`。我们为`Post`类添加了四个字段:`title`、`author`、`content`和`published_at`。每个字段都有一个类型,如`StringField`表示字符串类型。

在本章节的介绍中,我们将讨论如何使用数据模型来存储和操作数据,并展示一些常见的数据模型设计模式。

### 2.2.2 数据模型与数据库的集成

Feeds库支持将数据模型与多种数据库进行集成,包括关系型数据库如SQLite和MySQL,以及NoSQL数据库如MongoDB。在本章节中,我们将探讨如何将数据模型与数据库集成,以实现数据的持久化存储。

首先,我们需要为数据模型定义一个数据库连接。以下是一个使用SQLite数据库的示例:

```python

from feeds import Feeds

from feeds.store import SqliteStore

from feeds.model import Model, StringField

class User(Model):

username = StringField()

email = StringField()

# 初始化Feeds对象

feeds = Feeds()

# 创建SQLite存储

feeds.add_store(SqliteStore('my_database.db'))

# 创建数据模型对象

user = User()

user.username = 'john_doe'

user.email = '***'

# 存储数据模型对象

feeds.store(user)

```

在这个例子中,我们首先导入了必要的模块,并定义了一个`User`数据模型。然后,我们初始化了Feeds对象,并添加了一个SQLite存储。最后,我们创建了一个`User`对象,并将其存储在数据库中。

在本章节的介绍中,我们将展示如何将数据模型与不同的数据库进行集成,并讨论一些常见的数据库集成模式和最佳实践。

# 3. Feeds库的数据抓取实践

## 3.1 基于Feeds的数据抓取流程

### 3.1.1 初始化Feeds对象

在本章节中,我们将详细介绍如何使用Feeds库进行数据抓取。首先,我们需要初始化一个Feeds对象,这是进行数据抓取的第一步。初始化Feeds对象通常需要指定一个URL,这个URL是我们希望抓取的目标页面。

```python

from feeds import Feeds

feed = Feeds('***')

```

在上面的代码中,我们首先从`feeds`模块导入了`Feeds`类,然后创建了一个`feed`实例,并传入了目标页面的URL。这个URL是我们希望抓取的网页地址。

### 3.1.2 数据抓取与解析

一旦我们初始化了Feeds对象,接下来就是调用其方法来进行数据抓取和解析。Feeds库提供了一个`parse`方法,这个方法负责发送HTTP请求到指定的URL,并解析返回的HTML内容。

```python

entries = feed.parse()

```

在上面的代码中,我们调用了`feed`实例的`parse`方法,并将解析后的数据存储在`entries`变量中。`entries`是一个包含所有解析项的列表,每个项都是一个字典,包含了诸如标题、链接和内容等信息。

#### 代码逻辑逐行解读分析

- `from feeds import Feeds`:导入Feeds库中的Feeds类。

- `feed = Feeds('***')`:创建一个Feeds对象,指定目标URL为`***`。

- `entries = feed.parse()`:调用`feed`对象的`parse`方法,发送HTTP请求并解析HTML内容,将解析后的数据存储在`entries`变量中。

#### 参数说明

- `***`:目标网页的URL。

- `entries`:存储解析后数据的列表,每个元素是一个字典。

## 3.2 复杂数据结构的处理

### 3.2.1 嵌套数据的抓取

在实际的数据抓取过程中,我们经常会遇到嵌套数据的情况。嵌套数据指的是HTML元素内部还包含了其他HTML元素,这些内部元素同样需要被提取出来并进行解析。

```python

def parse_nested_data(feed):

entries = []

for entry in feed.entries:

# 假设每个entry都有一个嵌套的元素

nested_element = entry.find('.//div[@class="nested"]')

if nested_element:

data = {

'title': entry.title,

'nested_content': nested_element.text

}

entries.append(data)

return entries

entries = feed.parse()

parsed_data = parse_nested_data(feed)

```

在上面的代码中,我们定义了一个`parse_nested_data`函数,它接受一个Feeds对象作为参数,并返回一个包含嵌套数据的新列表。

#### 代码逻辑逐行解读分析

- `def parse_nested_data(feed):`:定义了一个名为`parse_nested_data`的函数,它接受一个`feed`对象作为参数。

- `entries = []`:创建一个空列表`entries`,用于存储解析后的数据。

- `for entry in feed.entries:`:遍历`feed.entries`中的每个条目。

- `nested_element = entry.find('.//div[@class="nested"]')`:使用XPath查找嵌套的`div`元素。

- `if nested_element:`:检查是否找到了嵌套元素。

- `data = {'title': entry.title, 'nested_content': nested_element.text}`:创建一个新的字典,包含条目的标题和嵌套元素的文本内容。

- `entries.append(data)`:将新字典添加到`entries`列表中。

- `return entries`:返回包含嵌套数据的列表。

#### 参数说明

- `feed.entries`:Feeds对象中的条目列表。

- `.//div[@class="nested"]`:XPath表达式,用于查找类名为`nested`的`div`元素。

- `entry.title`:当前条目的标题。

- `nested_element.text`:嵌套元素的文本内容。

### 3.2.2 动态内容的抓取策略

动态内容是指那些通过JavaScript动态加载的内容。对于这类内容,普通的HTTP请求无法直接获取,因为它们在服务器响应的初始HTML中并不存在。为了解决这个问题,我们需要使用一些特定的工具或库来模拟浏览器行为。

```python

from selenium import webdriver

def fetch_dynamic_content(url):

driver = webdriver.Chrome()

driver.get(url)

# 等待JavaScript加载完成

driver.implicitly_wait(10)

content = driver.find_element_by_xpath('//div[@id="dynamic-content"]').text

driver.quit()

return content

feed = Feeds('***')

entries = feed.parse()

dynamic_data = []

for entry in entries:

content = fetch_dynamic_content(entry.url)

entry['dynamic_content'] = content

dynamic_data.append(entry)

```

在上面的代码中,我们使用了`selenium`库来模拟浏览器行为,并抓取动态加载的内容。

#### 代码逻辑逐行解读分析

- `from selenium import webdriver`:从`selenium`库导入`webdriver`模块。

- `def fetch_dynamic_content(url):`:定义了一个名为`fetch_dynamic_content`的函数,它接受一个URL作为参数。

- `driver = webdriver.Chrome()`:创建一个Chrome浏览器实例。

- `driver.get(url)`:访问指定的URL。

- `driver.implicitly_wait(10)`:等待JavaScript加载完成,这里的等待时间是10秒。

- `content = driver.find_element_by_xpath('//div[@id="dynamic-content"]').text`:查找ID为`dynamic-content`的`div`元素,并获取其文本内容。

- `driver.quit()`:关闭浏览器。

- `return content`:返回动态加载的内容。

- `feed = Feeds('***')`:创建一个Feeds对象,指定动态内容的URL。

- `entries = feed.parse()`:解析页面内容。

- `dynamic_data = []`:创建一个空列表`dynamic_data`,用于存储包含动态内容的条目。

- `for entry in entries:`:遍历`entries`中的每个条目。

- `content = fetch_dynamic_content(entry.url)`:调用`fetch_dynamic_content`函数,抓取动态内容。

- `entry['dynamic_content'] = content`:将动态内容添加到条目中。

- `dynamic_data.append(entry)`:将包含动态内容的条目添加到`dynamic_data`列表中。

#### 参数说明

- `webdriver.Chrome()`:创建一个Chrome浏览器实例。

- `driver.get(url)`:访问指定的URL。

- `driver.implicitly_wait(10)`:等待JavaScript加载完成的隐式等待。

- `driver.find_element_by_xpath('//div[@id="dynamic-content"]').text`:通过XPath查找ID为`dynamic-content`的`div`元素,并获取其文本内容。

## 3.3 异常处理与日志记录

### 3.3.1 异常捕获机制

在数据抓取过程中,我们经常会遇到各种异常情况,如网络问题、目标网站结构变更等。为了确保程序的健壮性,我们需要合理地处理这些异常。

```python

from feeds import Feeds

import logging

logging.basicConfig(level=***)

def fetch_data(url):

try:

feed = Feeds(url)

entries = feed.parse()

return entries

except Exception as e:

logging.error(f"Error fetching data from {url}: {e}")

return []

feed = Feeds('***')

entries = fetch_data(feed.url)

```

在上面的代码中,我们使用了Python的`logging`模块来记录日志,并在`fetch_data`函数中添加了异常处理机制。

#### 代码逻辑逐行解读分析

- `from feeds import Feeds`:从`feeds`模块导入`Feeds`类。

- `import logging`:导入`logging`模块。

- `logging.basicConfig(level=***)`:配置日志,设置日志级别为INFO。

- `def fetch_data(url):`:定义了一个名为`fetch_data`的函数,它接受一个URL作为参数。

- `try:`:开始一个异常处理块。

- `feed = Feeds(url)`:创建一个Feeds对象。

- `entries = feed.parse()`:解析页面内容。

- `return entries`:返回解析后的数据。

- `except Exception as e:`:捕获异常。

- `logging.error(f"Error fetching data from {url}: {e}")`:记录错误日志。

- `return []`:返回一个空列表。

- `feed = Feeds('***')`:创建一个Feeds对象,指定目标URL。

- `entries = fetch_data(feed.url)`:调用`fetch_data`函数,抓取数据。

#### 参数说明

- `logging.basicConfig(level=***)`:配置日志,设置日志级别为INFO。

- `try...except`:异常处理机制。

### 3.3.2 日志配置与记录

在本章节中,我们将详细介绍如何配置和记录日志。日志记录是数据抓取过程中的一个重要环节,它可以帮助我们追踪程序的运行情况,及时发现并解决问题。

```python

import logging

# 配置日志

logging.basicConfig(

filename='scraper.log',

filemode='a',

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s',

level=***

)

# 记录日志

***('Starting the scraping process.')

try:

# 你的数据抓取代码

pass

except Exception as e:

logging.error('Error occurred during the scraping process:', exc_info=True)

finally:

***('Scraping process completed.')

```

在上面的代码中,我们首先配置了日志记录的基本信息,包括日志文件名、文件模式、日志格式和日志级别。然后在数据抓取的开始和结束时记录日志,并在发生异常时记录错误信息。

#### 代码逻辑逐行解读分析

- `import logging`:导入`logging`模块。

- `logging.basicConfig()`:配置日志记录的基本信息。

- `filename='scraper.log'`:日志文件名。

- `filemode='a'`:文件模式,`a`表示追加模式。

- `format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'`:日志格式,包括时间、模块名、日志级别和日志信息。

- `level=***`:日志级别,设置为INFO。

- `***('Starting the scraping process.')`:记录一条INFO级别的日志,表示开始抓取数据。

- `try:`:开始一个异常处理块。

- `pass`:这里可以放置你的数据抓取代码。

- `except Exception as e:`:捕获异常。

- `logging.error('Error occurred during the scraping process:', exc_info=True)`:记录一条ERROR级别的日志,包括异常信息。

- `finally:`:无论是否发生异常,都会执行的代码块。

- `***('Scraping process completed.')`:记录一条INFO级别的日志,表示抓取过程完成。

#### 参数说明

- `logging.basicConfig()`:配置日志记录的基本信息。

- `filename`:日志文件名。

- `filemode`:文件模式,`a`表示追加模式。

- `format`:日志格式。

- `level`:日志级别。

- `***()`:记录INFO级别的日志。

- `logging.error()`:记录ERROR级别的日志,`exc_info=True`表示包含异常信息。

# 4. Feeds库高级功能应用

在本章节中,我们将深入探讨Feeds库的高级功能,这些功能将帮助您在数据抓取任务中实现更高的效率和更好的数据管理。我们将分为三个主要部分来介绍这些功能:多线程与异步数据抓取、数据抓取策略优化以及高级数据处理技术。

## 4.1 多线程与异步数据抓取

### 4.1.1 线程池的使用

在数据抓取任务中,使用多线程可以显著提高抓取效率。Feeds库提供了内置的线程池支持,使得开发者可以轻松地在抓取任务中实现并行处理。下面是一个使用线程池的示例代码:

```python

from feeds import Feeds

from concurrent.futures import ThreadPoolExecutor

def fetch_data(feed_url):

feed = Feeds(feed_url)

feed.init()

for item in feed.parse():

# 处理每一条抓取到的数据

process_item(item)

def process_item(item):

# 这里是处理数据的逻辑

pass

def main():

urls = ['***', '***']

with ThreadPoolExecutor(max_workers=10) as executor:

for url in urls:

executor.submit(fetch_data, url)

if __name__ == "__main__":

main()

```

在这个示例中,我们首先导入了`Feeds`类和`ThreadPoolExecutor`。然后定义了`fetch_data`函数来处理单个feed的抓取和解析。`process_item`函数则是用于处理每一条抓取到的数据。在`main`函数中,我们创建了一个线程池,并将每个feed URL提交给线程池执行。

**代码逻辑解读分析:**

- `ThreadPoolExecutor(max_workers=10)` 创建了一个拥有10个工作线程的线程池。

- `executor.submit(fetch_data, url)` 将`fetch_data`函数提交给线程池执行,并传递feed URL作为参数。

- `fetch_data`函数初始化`Feeds`对象,解析feed,并对每条数据项调用`process_item`函数处理。

### 4.1.2 异步IO的应用

除了多线程,异步IO也是提高效率的有效手段。Python的`asyncio`库可以与Feeds库结合,实现异步的数据抓取。下面是一个示例:

```python

import asyncio

from feeds import Feeds

async def fetch_data(feed_url):

feed = Feeds(feed_url)

await feed.init()

async for item in feed.parse():

# 异步处理每一条抓取到的数据

await process_item(item)

async def process_item(item):

# 这里是异步处理数据的逻辑

pass

async def main():

urls = ['***', '***']

tasks = []

for url in urls:

tasks.append(fetch_data(url))

await asyncio.gather(*tasks)

if __name__ == "__main__":

asyncio.run(main())

```

在这个示例中,我们使用`async`和`await`关键字来定义异步函数。`fetch_data`函数和`process_item`函数都被定义为异步函数。在`main`函数中,我们创建了一个任务列表,并使用`asyncio.gather`来并发运行这些任务。

**代码逻辑解读分析:**

- `async def` 定义了一个异步函数,`await`关键字用于等待异步操作的完成。

- `asyncio.gather(*tasks)` 并发执行所有任务列表中的异步函数。

## 4.2 数据抓取策略优化

### 4.2.1 代理IP与请求头管理

为了避免IP被封禁,数据抓取任务中通常会使用代理IP。Feeds库允许在请求时设置代理IP和自定义请求头。以下是如何设置代理和请求头的示例代码:

```python

from feeds import Feeds

feed = Feeds('***')

feed.session.proxies = {'http': '***'}

feed.session.headers = {'User-Agent': 'Custom User Agent'}

feed.init()

```

在这个示例中,我们通过`feed.session.proxies`设置HTTP代理,通过`feed.session.headers`设置请求头。

### 4.2.2 请求频率控制与反爬虫策略

为了避免触发反爬虫机制,合理控制请求频率是必要的。Feeds库提供了`sleep`参数来控制请求间隔。下面是一个示例:

```python

from feeds import Feeds

feed = Feeds('***')

feed.sleep = 1 # 设置每个请求之间的间隔为1秒

feed.init()

```

在这个示例中,我们通过设置`sleep`参数为1秒,使得每次请求间隔1秒。

## 4.3 高级数据处理技术

### 4.3.1 数据清洗与转换

在数据抓取后,通常需要对数据进行清洗和转换。以下是一个使用Pandas库进行数据清洗的示例:

```python

import pandas as pd

from feeds import Feeds

feed = Feeds('***')

feed.init()

data = []

for item in feed.parse():

# 提取需要的数据

data.append(item['title'])

df = pd.DataFrame(data, columns=['Title'])

# 数据清洗

df['Title'] = df['Title'].str.strip().str.lower()

# 数据转换

df['Title Length'] = df['Title'].apply(len)

```

在这个示例中,我们使用Pandas库创建了一个DataFrame,并对数据进行了简单的清洗和转换。

### 4.3.2 数据分析与可视化

数据分析和可视化是数据抓取项目的重要环节。以下是一个使用Matplotlib库进行数据可视化的示例:

```python

import matplotlib.pyplot as plt

from feeds import Feeds

feed = Feeds('***')

feed.init()

titles = [item['title'] for item in feed.parse()]

title_lengths = [len(title) for title in titles]

plt.hist(title_lengths, bins=30)

plt.title('Title Length Distribution')

plt.xlabel('Length')

plt.ylabel('Frequency')

plt.show()

```

在这个示例中,我们统计了标题长度的分布,并使用Matplotlib绘制了直方图。

通过本章节的介绍,我们可以看到Feeds库在多线程和异步IO的应用、数据抓取策略的优化以及高级数据处理技术方面的强大功能。这些功能的合理应用,将大大提高数据抓取任务的效率和质量。在下一章节中,我们将通过实际的项目案例来展示这些高级功能的实战应用。

# 5. Feeds库项目实战案例

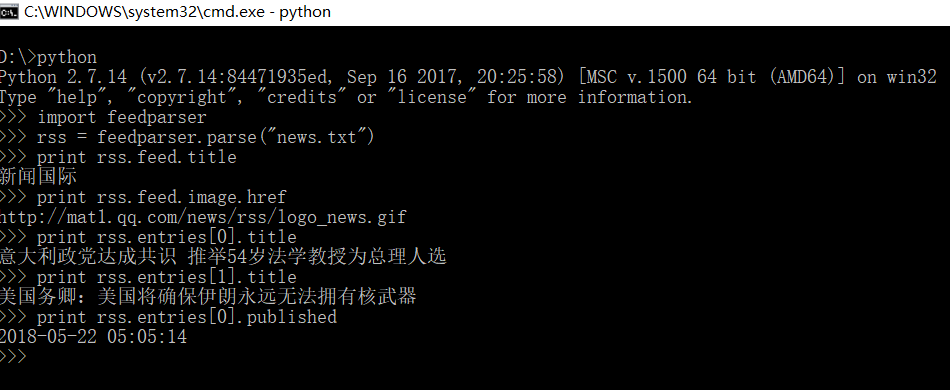

## 5.1 实战案例一:新闻聚合爬虫

在本章节中,我们将通过一个新闻聚合爬虫的实战案例,来展示如何使用Feeds库进行项目开发。这个案例将涵盖从需求分析到功能实现的全过程。

### 5.1.1 项目需求分析

新闻聚合爬虫的主要目的是从多个新闻网站自动收集新闻数据,并将其整合到一个中心平台。这样的平台可以为用户提供一个统一的新闻浏览体验,而不需要访问多个网站。

需求分析如下:

- **数据来源**:选择5个主流的新闻网站作为数据源。

- **数据类型**:收集每个网站的头条新闻标题、摘要、链接和发布日期。

- **抓取频率**:每小时自动抓取一次最新新闻数据。

- **数据存储**:将抓取到的数据存储到本地的JSON文件中。

- **异常处理**:设置日志记录,对抓取过程中的异常进行记录和报警。

### 5.1.2 代码实现与功能演示

#### *.*.*.* 安装Feeds库

首先,确保安装了Feeds库:

```bash

pip install feeds

```

#### *.*.*.* 初始化Feeds对象

接下来,我们初始化Feeds对象,并设置新闻网站的RSS源地址。

```python

from feeds import Feeds

# 新闻网站的RSS源地址

rss_urls = [

"***",

# 其他新闻网站的RSS源地址

]

# 创建Feeds对象

f = Feeds()

```

#### *.*.*.* 数据抓取与解析

我们通过遍历RSS源地址,使用Feeds库提供的方法抓取和解析新闻数据。

```python

for rss_url in rss_urls:

# 添加RSS源

f.add(rss_url)

# 抓取数据

entries = f.get_entries()

# 解析数据

for entry in entries:

# 提取需要的信息

title = entry.title

summary = entry.summary

link = entry.link

published_date = entry.published

# 存储到JSON文件

# ...

```

#### *.*.*.* 数据存储

我们可以将解析后的数据存储到本地的JSON文件中。

```python

import json

# 将解析后的数据存储到JSON文件

with open('news.json', 'a') as f:

for entry in entries:

# 转换数据为JSON格式

data = {

"title": entry.title,

"summary": entry.summary,

"link": entry.link,

"published_date": entry.published,

}

# 写入文件

json.dump(data, f)

f.write('\n')

```

通过上述步骤,我们完成了新闻聚合爬虫的基本功能实现。当然,实际项目中还需要考虑异常处理、日志记录、多线程抓取等高级功能,以提高爬虫的健壮性和效率。

请注意,上述代码仅为演示目的,并未包含所有的异常处理和日志记录逻辑。在实际应用中,您需要根据具体需求添加相应的异常捕获和日志配置代码。

0

0