图像识别算法的实时性能优化

发布时间: 2024-09-01 14:39:49 阅读量: 227 订阅数: 83

# 1. 图像识别算法的实时性能概述

## 1.1 实时性能定义

实时性能(Real-time Performance)在图像识别中指的是系统从接收图像输入到产生识别结果所需的时间,衡量标准通常包括响应时间(Latency)和吞吐率(Throughput)。高实时性能意味着系统能在极短的时间内,准确地完成图像处理与识别任务。

## 1.2 应用场景需求

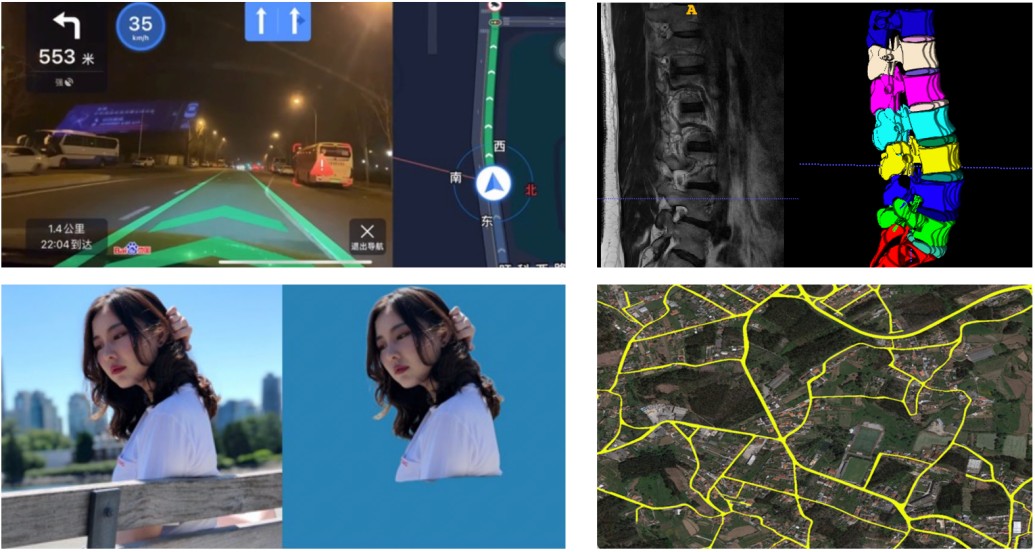

图像识别技术广泛应用于安防监控、自动驾驶、医疗成像等领域,这些场景对实时性能有着严苛的要求。例如,在自动驾驶中,车辆需要实时分析摄像头捕获的道路和环境图像,迅速做出决策以确保行车安全。

## 1.3 系统性能的衡量指标

衡量图像识别实时性能的指标主要包括帧率(Frames per Second, FPS),即每秒可以处理多少帧图像,以及延迟(Delay),即从图像输入到输出结果的时间差。提升这些指标,需要对算法进行深度优化,并在硬件和软件层面实施改进。

```mermaid

graph LR

A[开始] --> B[图像输入]

B --> C[实时处理]

C --> D[结果输出]

D --> E[性能评估]

E --> F{是否满足实时性要求?}

F -- 是 --> G[任务完成]

F -- 否 --> H[性能优化]

H --> B

```

在上述流程中,图像识别系统实时地接收输入,通过算法处理,并输出结果。系统评估实时性能指标,以确定是否需要进一步优化。

# 2. 理论基础与实时性能的关联

## 2.1 图像识别算法的基础理论

### 2.1.1 机器学习与深度学习简介

机器学习是计算机科学的一个分支,它赋予了机器从数据中学习的能力,无需通过明确的编程指令。它主要关注如何使用算法从大量历史数据中学习,并对新数据做出准确的预测或决策。机器学习的方法可以分为监督学习、非监督学习、半监督学习和强化学习等。

深度学习是机器学习的一个子集,它通过建立多层的复杂网络来模拟人脑进行分析和学习。深度学习模型,特别是卷积神经网络(CNN),在图像和视频识别、自然语言处理、语音识别等任务上取得了重大突破。通过构建和训练深度神经网络,深度学习在图像识别领域得到了广泛的应用。

深度学习模型的强大在于其能够自动学习到从输入到输出的复杂映射关系,而不需要人工设计特征。这一特性极大地降低了图像识别任务对专业知识的依赖,并提升了识别精度。

### 2.1.2 卷积神经网络(CNN)的基本工作原理

CNN是一种专门用来处理具有类似网格结构的数据(如图像)的深度学习模型。它能够自动和有效地从图像中提取特征,用于分类或其他任务。一个典型的CNN模型包括卷积层、激活函数、池化层、全连接层等。

- **卷积层**:卷积层是CNN的核心,它通过滤波器(卷积核)在输入图像上滑动来提取局部特征。每个滤波器专注于识别特定的视觉图案,如边缘或角点。

- **激活函数**:激活函数在CNN中被用来引入非线性因素,使网络可以学习和模拟更加复杂的函数。常用的激活函数包括ReLU(Rectified Linear Unit)。

- **池化层**:池化层是用来减少参数数量,防止过拟合,并提供一定程度的空间不变性。最大池化是最常见的池化操作,它通过取池化窗口中的最大值来实现下采样。

- **全连接层**:在CNN的最后阶段,全连接层通常用来将学习到的特征映射到样本标记空间。通过权重矩阵,全连接层能够将前面层学到的局部特征综合起来形成全局决策。

CNN模型通过堆叠这些层次的组合能够从简单的特征逐步抽象出复杂的特征,并最终完成如图像分类、目标检测等识别任务。

## 2.2 实时性能的重要性分析

### 2.2.1 实时性能的定义与衡量标准

实时性能,或称为实时性,是指系统对于输入数据做出响应的速度。在图像识别应用中,实时性是指系统能够以多快的速度处理图像数据并输出识别结果。衡量实时性能的两个关键参数是延迟(Latency)和吞吐量(Throughput)。

- **延迟**:延迟指的是从输入数据到达系统到系统输出结果的时间间隔。在图像识别任务中,低延迟意味着快速响应,对于许多实时应用场景至关重要。

- **吞吐量**:吞吐量是指单位时间内系统可以处理的数据量。在实际应用中,高吞吐量意味着系统能够处理更多的图像识别任务,这对于批量处理或大规模部署场景尤其重要。

在评估实时性能时,通常使用帧率(Frames Per Second, FPS)来衡量系统每秒钟可以处理的图像帧数。高帧率表示高吞吐量,对于实时识别任务至关重要。

### 2.2.2 实时性能对图像识别应用的影响

实时性能对图像识别应用的影响主要体现在用户体验和应用场景两个方面。

- **用户体验**:在移动设备、安防监控、自动驾驶等应用中,用户期望获得即刻的反馈。例如,一辆自动驾驶汽车需要快速识别道路标记以做出即时反应;移动设备上的图像识别应用需要迅速识别并响应用户的操作。低延迟的实时性能可以显著提升用户满意度和使用体验。

- **应用场景**:在紧急响应系统,如医疗影像分析、安全监测等场景中,实时性能直接关系到安全和效率。快速准确的图像识别可以辅助医生做出快速诊断,或者在安全系统中检测潜在威胁并立即采取行动。

因此,对于图像识别算法来说,实时性能不仅仅是效率问题,更是实现这些技术应用的前提条件。没有足够快的处理速度,许多应用将无法满足实际需求,失去其应用价值。

## 2.3 理论对实时性能优化的指导意义

### 2.3.1 理论模型对算法设计的影响

理论模型为图像识别算法的设计提供了科学基础和指导。例如,卷积神经网络模型的设计受到生物视觉系统的启发,通过多层卷积和池化操作来模拟视觉处理过程。深度学习理论的发展,如权重初始化、优化算法(例如SGD、Adam)、正则化技术(如Dropout),直接影响到了CNN模型的训练效率和识别准确性。

理论上,一个更优的模型设计能够更快地收敛,并在更少的训练数据上达到较高的准确度。这直接关联到实时性能,因为训练时间缩短了,模型部署到生产环境中的响应时间也会相应缩短。

### 2.3.2 理论与性能优化的关系

优化理论与实时性能的提升息息相关。通过深入理解算法背后的理论,开发者可以更好地调整模型参数和优化训练过程。例如,通过理论分析可以理解为什么某些层的深度和宽度对模型性能有特定的影响,并据此来设计更深或更宽的网络结构,从而提升性能。

此外,理论上的突破,如新型激活函数的设计或新的优化算法的提出,可以改进模型的训练效率和泛化能力。这使得模型能够更快地处理新输入,达到实时识别的要求。

理论指导实践,实践反过来又验证和丰富理论。这一过程推动了实时性能优化的持续进步,使得图像识别技术能够不断适应新的应用场景和挑战。

# 3. 实时性能优化的实践技巧

在当今的数据密集型世界中,实时性能是衡量图像识别系统能力的关键因素。第三章专注于探讨如何在实际应用中优化实时性能。本章将从硬件加速、软件优化策略和系统架构设计三个方面进行深入探讨,向读者展示从理论到实践的桥梁如何搭建,以及优化技巧的细节。

## 3.1 硬件加速与实时性能

硬件加速是提高实时性能的关键因素之一,特别是在图像识别领域,对于处理大量的数据和复杂的算法至关重要。

### 3.1.1 GPU在图像识别中的应用

GPU(图形处理单元)最初是为图形渲染而设计的,但它们强大的并行计算能力使其成为图像识别算法的理想选择。GPU能够同时处理数以千计的小任务,这种能力使其在处理矩阵运算和多维数据操作时表现出色,而这些正是深度学习和图像识别算法的核心部分。

```python

# 示例代码块:使用NVIDIA的CUDA库进行GPU加速

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch.utils.cpp_extension import load

# 加载CUDA扩展模块

my_extension = load(name='my_extension',

sources=['my_extension.cpp', 'my_extension_kernel.cu'])

class MyConvNet(nn.Module):

def __init__(self):

super(MyConvNet, self).__init__()

# 实例化一个使用CUDA扩展模块的层

self.conv = my_extension.MyConvLayer()

def forwa

```

0

0