【Python聚类代码优化】:艺术级效率提升技巧,一学就会

发布时间: 2024-08-31 14:50:01 阅读量: 117 订阅数: 75

代码实操:Python聚类分析

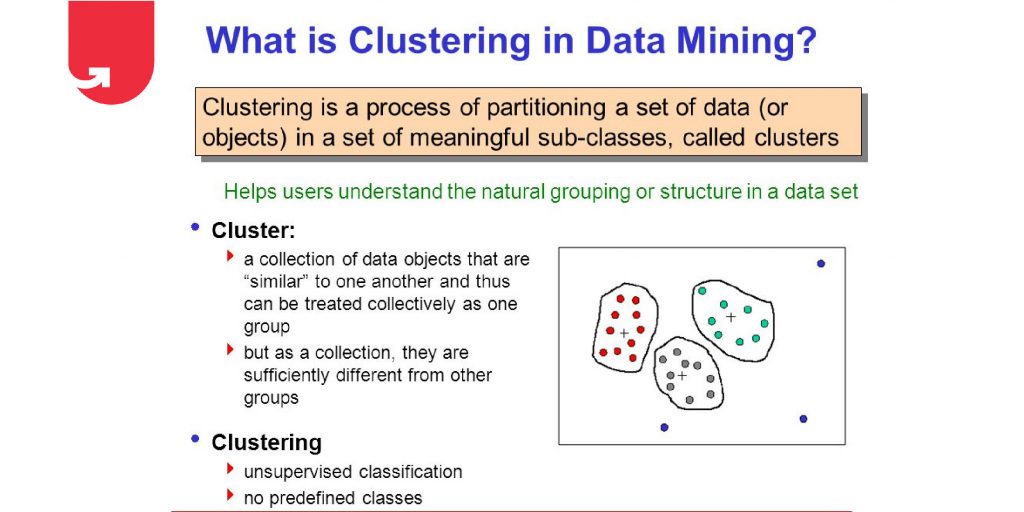

# 1. Python聚类算法概述

## 1.1 聚类算法的定义与重要性

聚类算法是无监督学习的核心算法之一,旨在将数据集中的样本根据相似性划分为若干个类别或簇。在许多领域,如市场细分、社交网络分析、图像处理和生物信息学中,聚类算法都扮演着至关重要的角色。通过自动识别数据中的结构,聚类帮助我们更好地理解数据、预测趋势,以及为决策提供科学依据。

## 1.2 Python在聚类算法中的优势

Python语言因其简洁的语法、强大的社区支持和丰富的数据科学库(如NumPy、Pandas、Scikit-learn等)而成为数据科学领域的首选语言。在聚类算法的实现方面,Python不仅提供了高效的数据处理能力,还拥有易于实现各种聚类策略的环境,这对于数据分析师、机器学习工程师而言,极大地降低了算法实现的门槛。

## 1.3 本章小结

本章旨在为读者提供一个聚类算法的概览,并强调Python在聚类算法实现中的重要性。下一章将深入介绍基础聚类算法的实现与优化技巧,为读者构建坚实的技术基础。

# 2. 基础聚类算法的实现与优化

### 2.1 K-Means算法的原理与实现

#### 2.1.1 K-Means算法基础理论

K-Means算法是一种典型的划分聚类方法,其核心思想是通过迭代过程将数据集划分为K个簇,使得每个点所属的簇内距离之和最小化。算法首先随机选择K个点作为初始簇中心,然后根据距离最近的原则将每个点分配到一个簇中。之后,算法计算每个簇的新中心并更新簇的分配。重复这个过程直到收敛,即簇中心不再发生变化或达到预设的迭代次数。

#### 2.1.2 算法实现步骤

1. **初始化**:选择K个数据点作为初始簇中心。

2. **分配**:对于数据集中的每个点,根据欧氏距离等距离度量将点分配给最近的簇中心。

3. **更新**:重新计算每个簇的中心点,即将簇中所有点的坐标平均值作为新的中心。

4. **重复**:重复第2和第3步直到满足停止条件(中心点位置稳定或达到最大迭代次数)。

以下是使用Python实现K-Means算法的代码示例:

```python

from sklearn.cluster import KMeans

import numpy as np

# 假设有一个二维数据集

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 指定簇的数量

kmeans = KMeans(n_clusters=2, random_state=0).fit(X)

# 输出簇中心点

print("Cluster Centers:")

print(kmeans.cluster_centers_)

# 输出每个点的簇标签

print("Labels for each point:")

print(kmeans.labels_)

```

以上代码首先导入了`KMeans`类和`numpy`库,然后创建了一个二维数据集`X`和一个`KMeans`实例。通过`fit`方法,算法计算并输出了簇中心点和每个数据点所属的簇标签。参数`n_clusters=2`指定了我们期望得到的簇的数量,`random_state`用于初始化的随机种子,确保结果的可复现性。

### 2.2 层次聚类的原理与实现

#### 2.2.1 层次聚类基础理论

层次聚类通过构建一个簇的层次来组织数据,进而形成一个树状图(Dendrogram),树状图中的每个节点表示一个簇,最终聚类结果的选择依赖于树状图的剪切位置。根据合并或分裂簇的顺序,层次聚类分为两种方法:凝聚(自底向上)和分裂(自顶向下)。凝聚层次聚类首先将每个点视为一个单独的簇,然后合并最相似的簇,逐步形成一个更大的簇;分裂层次聚类则相反,从一个包含所有点的簇开始,逐步分裂成更小的簇。

#### 2.2.2 算法实现步骤

1. **初始化**:每个数据点自己形成一个簇。

2. **合并**:计算每对簇之间的相似度,合并最相似的簇。

3. **更新**:更新簇的相似度矩阵。

4. **重复**:重复合并步骤直到达到预定的簇的数量或相似度阈值。

使用Python的`scipy`库可以实现层次聚类:

```python

import numpy as np

from scipy.cluster.hierarchy import dendrogram, linkage, fcluster

# 假设有一个二维数据集

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 使用ward方法构建层次聚类

Z = linkage(X, 'ward')

# 剪切树状图以得到4个簇

clusters = fcluster(Z, 4, criterion='maxclust')

# 输出每个点的簇标签

print("Labels for each point:")

print(clusters)

```

在这段代码中,`linkage`函数用于构建层次聚类的树状结构,`fcluster`函数根据设定的簇数量对树状图进行剪切,得到每个数据点的簇标签。`'ward'`是合并时使用的距离度量方法,它试图最小化合并后的簇内的方差。

### 2.3 密度聚类的原理与实现

#### 2.3.1 密度聚类基础理论

密度聚类方法基于密度的概念,它将具有足够高密度的区域划分为簇,并能在噪声中发现任意形状的簇。DBSCAN是最常见的密度聚类算法之一,它将簇定义为由核心对象及其直接密度可达的对象组成的区域。核心对象是指在给定半径ε内至少有最小数量点的点;直接密度可达是指在ε范围内有核心对象;密度可达是指通过一系列密度可达点可以到达的对象。

#### 2.3.2 算法实现步骤

1. **邻居搜索**:对于数据集中的每个点,确定其在半径ε内的邻居点。

2. **核心点判定**:如果一个点的邻居数量达到最小点数,将其标记为核心点。

3. **边界点处理**:对于非核心点,将其标记为边界点。

4. **簇构建**:连接所有核心点及其邻居点,形成簇。

5. **噪声点处理**:未被任何簇包括的点被标记为噪声点。

以下是DBSCAN算法的Python实现:

```python

from sklearn.cluster import DBSCAN

import numpy as np

# 假设有一个二维数据集

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 实例化DBSCAN模型

db = DBSCAN(eps=3, min_samples=2).fit(X)

# 输出簇标签

print("Labels for each point:")

print(db.labels_)

# 输出核心样本点的索引

core_samples_mask = np.zeros_like(db.labels_, dtype=bool)

core_samples_mask[db.core_sample_indices_] = True

print("Core samples mask:")

print(core_samples_mask)

```

在这段代码中,`DBSCAN`类用于构建密度聚类模型,其中`eps`参数表示邻域半径,`min_samples`参数表示成为核心点所需的最小邻居数量。`fit`方法计算并输出了每个点的簇标签和核心样本点的索引。核心样本点在构建簇的过程中起到了关键作用。

### 2.1 K-Means算法的原理与实现表格对比

为了更好的对比K-Means算法和其它聚类算法,我们创建了下面的表格:

| 聚类算法 | 特点 | 适用情况 | 优点 | 缺点 |

| --- | --- | --- | --- | --- |

| K-Means | 划分聚类,寻

0

0