【Python聚类算法进阶技巧】:高级参数调整,性能再升级

发布时间: 2024-08-31 15:08:23 阅读量: 169 订阅数: 70

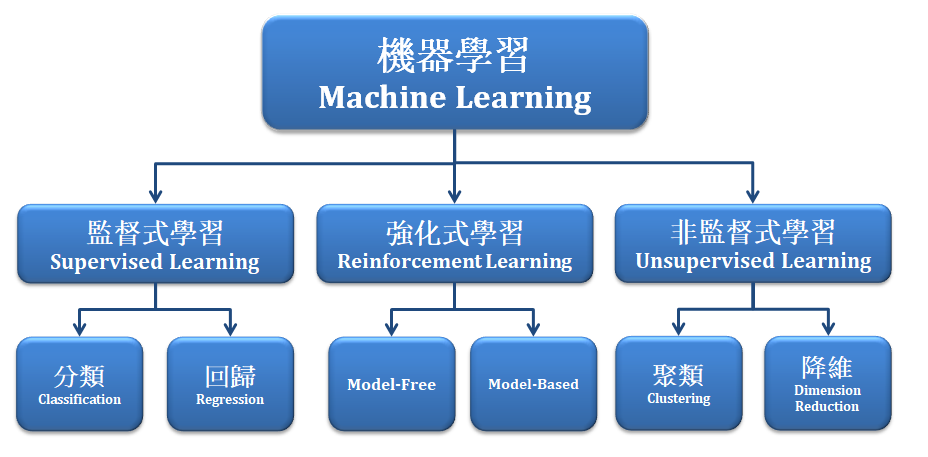

# 1. Python聚类算法概述

聚类分析是数据挖掘和无监督学习的重要组成部分,它帮助我们通过算法将数据集中的样本分组成多个簇。Python作为数据分析和机器学习的首选语言之一,拥有一系列强大的库来支持聚类算法的实现和应用。从简单的K-Means算法到复杂的层次聚类和DBSCAN,Python丰富的数据科学生态系统如Scikit-learn,为我们提供了执行这些任务的工具。

在本章中,我们将首先介绍聚类算法的基本概念和作用,然后探讨Python中实现聚类分析的方法。我们将讨论不同聚类算法的优势和局限性,以及它们在不同场景下的适用性。本章内容将为后续章节关于参数调整、性能评估和优化技巧的深入讨论奠定基础。

# 2. 高级参数调整的理论基础

## 2.1 参数调整的重要性

### 2.1.1 参数对算法性能的影响

在机器学习领域,参数调整是提升算法性能的关键步骤之一。参数,也被称作超参数,是指那些在学习过程开始前就设定好的固定值,它们决定了算法在学习过程中如何行为。例如,在K-Means聚类算法中,簇的数量(k值)就是一个重要的参数,它直接影响到聚类结果的质量。

参数调整之所以重要,是因为它们在很大程度上决定了模型的性能。好的参数设置可以帮助模型更快地收敛,避免过拟合或欠拟合,并提高其泛化能力。例如,学习率在神经网络训练中是一个关键的参数,过高的学习率可能导致模型无法收敛,而过低的学习率则可能使训练过程变得缓慢且容易陷入局部最优解。

### 2.1.2 参数调整与模型泛化能力

模型的泛化能力是指模型对未见过数据的预测能力。理想情况下,我们希望模型能够很好地泛化到新数据上,而非仅仅在训练数据上表现良好。参数调整对于提升模型的泛化能力至关重要。

调整参数可以帮助我们控制模型的复杂度。如果模型过于复杂(即参数太多或者模型结构过于庞大),那么模型可能会学习到训练数据中的噪声,导致泛化能力差。相反,如果模型过于简单,它可能无法捕捉数据中的重要特征,同样泛化能力不足。因此,恰当地调整参数是找到模型复杂度与泛化能力平衡点的关键。

## 2.2 聚类算法的参数类型

### 2.2.1 初始化参数

聚类算法在开始聚类之前,需要设定一系列的初始化参数。以K-Means算法为例,初始化参数主要包括簇的初始中心位置。这些初始中心点的选择对算法的收敛速度和最终聚类结果的质量都有重要影响。

一个常见的初始化方法是随机选择k个数据点作为初始中心点。这种方法简单,但在数据分布不均匀或者数据量很大时可能导致初始中心点的选择不够理想,进而影响算法性能。另一种方法是K-Means++,该方法通过概率的方式选择初始中心点,使得初始中心点之间的距离尽可能远,以期达到更好的聚类效果。

### 2.2.2 距离度量参数

距离度量是聚类算法用来评估数据点之间相似性的一种方式。它决定了数据点如何被分组到不同的簇中。不同的距离度量方法对聚类结果有着不同的影响。

最常用的几种距离度量包括欧氏距离、曼哈顿距离和切比雪夫距离。欧氏距离是点之间直线距离的度量,适用于大多数情况,但在数据维度很高时可能会失效,这种现象被称为“维度灾难”。曼哈顿距离是点之间在标准坐标系上的绝对轴距总和,而切比雪夫距离则是点在各个轴上距离的最大值。

每种距离度量都有其适用场景和局限性。例如,曼哈顿距离在考虑城市街区距离时更加直观,而切比雪夫距离在棋盘游戏中的移动决策中可能更为合适。选择合适的距离度量方法,是优化聚类算法性能的一个重要方面。

### 2.2.3 停止条件参数

停止条件参数是决定聚类算法何时停止迭代的关键因素。大多数聚类算法在迭代过程中会不断调整数据点的簇归属,直至满足停止条件后停止运行。

停止条件可以是迭代次数的最大值,也可以是簇中心变化量的阈值,或者是簇内距离和的减少幅度等。例如,在K-Means算法中,通常会设置一个最大迭代次数,当达到该次数时算法停止。这种方法的优点是简单且容易实现,但它可能导致算法提前停止,而没有达到最优解。另一种方法是当簇中心点的变化小于某一预设阈值时停止,这种方法往往能更好地接近最优解,但计算成本也相对较高。

## 2.3 参数调整策略

### 2.3.1 网格搜索与交叉验证

在众多的参数调整方法中,网格搜索(Grid Search)是最简单直观的一种。它通过遍历参数的所有可能组合,并在每个组合上训练模型,评估其性能,以此找到最优的参数组合。为了减少计算量,通常会使用交叉验证(Cross-Validation)来评估参数组合的性能。

交叉验证是一种统计分析方法,用于评估并比较学习算法对独立数据集的泛化能力。在k折交叉验证中,数据集被分为k个大小相似的互斥子集,其中k-1个子集用于训练,剩余的一个子集用于验证。这一过程被重复k次,每次选择不同的子集作为验证集。最终,模型的性能由k次验证的平均表现决定。

### 2.3.2 随机搜索与贝叶斯优化

虽然网格搜索简单直观,但它在参数空间较大时计算成本极高。随机搜索(Random Search)可以作为一种更加高效的参数优化策略,它随机选择参数组合进行评估,通常能找到与网格搜索相近或者更好的结果,但计算量要小得多。

贝叶斯优化(Bayesian Optimization)是一种更为高级的参数调整策略。贝叶斯优化通过构建一个目标函数的概率模型,然后使用这个模型来指导搜索过程,以期找到最优参数组合。与随机搜索相比,贝叶斯优化更加高效地探索参数空间,尤其是在评估成本高昂的情况下。

接下来,我们将探索如何使用这些参数调整策略来提升聚类算法的性能,以及如何在实践中应用这些理论知识。

# 3. 聚类算法性能评估

在聚类分析的领域内,性能评估是一项核心步骤,它可以帮助我们理解模型的划分质量并进行必要的调整。性能评估方法分为内部评价和外部评价,同时,可视化工具也起着至关重要的作用,它以直观的方式展示了聚类的结果。

## 3.1 内部评价指标

内部评价指标主要依据数据集内的信息来评估聚类结果,不需要外部的参照标准。下面将详细介绍两个常用的内部评价指标。

### 3.1.1 轮廓系数

轮廓系数是衡量聚类效果好坏的常用指标,它结合了聚类的凝聚度和分离度两个方面。轮廓系数的值介于-1到1之间,越接近1表示聚类效果越好。

公式如下:

\[ S(i) = \frac{b(i) - a(i)}{max\{a(i), b(i)\}} \]

其中,\( a(i) \) 是点i到其所在簇内其他点的平均距离(凝聚度),而\( b(i) \) 是点i到最近簇中所有点的平均距离(分离度)。整个数据集的轮廓系数是所有单个点轮廓系数的平均值。

### 3.1.2 Calinski-Harabasz指数

Calinski-Harabasz指数是另一个评估聚类效果的指标,它基于类间的离散度和类内的紧凑度。其公式如下:

\[ CH = \frac{tr(B_{k})}{tr(W_{k})} \times \frac{N - k}{k - 1} \]

其中,\( B_{k} \) 是类间散度矩阵,\( W_{k} \) 是类内散度矩阵,N是数据点总数,k是簇的个数。该指数高的聚类划分被认为是较好的。

下面是一个计算轮廓系数和Calinski-Harabasz指数的Python代码示例:

```python

from sklearn.metrics import silhouette_score

from sklearn.metrics import calinski_harabasz_score

from sklearn.datasets import make_blobs

# 创建一个含有3个簇的模拟数据集

X, _ = make_blobs(n_samples=300, centers=3, cluster_std=0.60, random_state=0)

# 使用K-Means算法进行聚类

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=3)

y_kmeans = kmeans.fit_predict(X)

# 计算轮廓系数和Calinski-Harabasz指数

print("轮廓系数: ", silhouette_score(X, y_kmeans))

print("Calinski-Harabasz指数: ", calinski_harabasz_score(X, y_kmeans))

```

代码逻辑分析:

1. 使用`make_blobs`函数生成模拟数据集。

2. 应用`KMeans`算法进行聚类。

3. 利用`silhouette_score`和`calinski_harabasz_score`函数计算轮廓系数和Calinski-Harabasz指数。

参数说明:

- `n_samples`: 生成样本的个数。

- `centers`: 簇的中心点数。

- `cluster_s

0

0