【数据预处理与聚类】:Python先验知识,解锁算法潜力

发布时间: 2024-08-31 15:13:25 阅读量: 228 订阅数: 73

kmeans聚类:一维数据的kmeans聚类算法的实现

# 1. 数据预处理与聚类的概念引入

## 1.1 数据科学中的预处理重要性

在数据科学的领域中,原始数据往往伴随着噪声、缺失值以及不一致性等问题。数据预处理是将原始数据转化为适合进行数据分析、挖掘或模型训练的格式的过程,是整个数据科学工作流程中不可或缺的一环。通过预处理,我们可以保证数据质量,进而提高数据模型的准确性和效率。

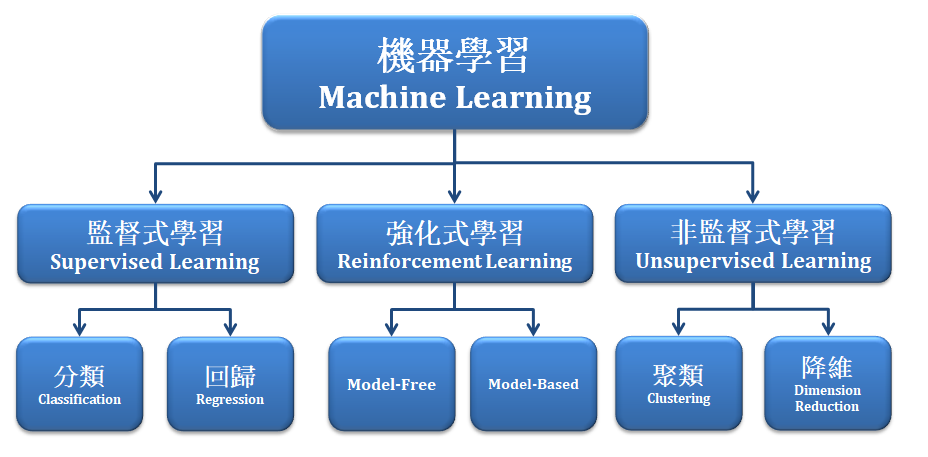

## 1.2 聚类的定义与应用场景

聚类是一种无监督学习方法,旨在将数据集中的样本根据相似性分组成多个类别。聚类技术广泛应用于市场细分、社交网络分析、图像分割、组织复杂数据等场景。理解聚类原理和实现步骤对于数据预处理至关重要,因为它直接关系到后续分析的有效性和可靠性。

## 1.3 从数据预处理到聚类分析的逻辑路径

逻辑上,数据预处理往往在聚类分析之前进行。预处理过程中,数据清洗、特征选择和变换等操作都直接影响着聚类的结果。本章将介绍数据预处理与聚类的基础知识,为后面章节中深入探讨Python在数据预处理中的应用、聚类算法实战,以及它们的优化与评估打下坚实的理论基础。

# 2. Python在数据预处理中的应用

### 2.1 Python数据结构概览

#### 2.1.1 基本数据类型与操作

Python作为一门高级编程语言,其数据结构设计简洁而强大。对于数据预处理而言,掌握其基本数据类型及其操作至关重要。Python的基本数据类型包括:整型(int)、浮点型(float)、字符串(str)和布尔型(bool)。

整型和浮点型是数值计算的基础,例如:

```python

a = 10 # 整型赋值

b = 10.5 # 浮点型赋值

# 进行基本的数学运算

print(a + b) # 输出:20.5

print(a * b) # 输出:105.0

```

字符串类型用于文本数据的处理,常用的操作有连接(`+`)、重复(`*`)、切片等。

布尔型主要表示真(True)和假(False),在逻辑判断和条件控制中非常重要。

掌握这些基本操作,能够帮助我们更好地理解和处理数据集中的数值和文本信息。

#### 2.1.2 高级数据结构:列表、元组、字典和集合

Python提供的高级数据结构包括列表(list)、元组(tuple)、字典(dict)和集合(set)。这些结构各有特点,是数据预处理中不可或缺的工具。

列表是可变的序列类型,可存储不同类型的对象:

```python

my_list = [1, "Hello", 3.14] # 列表中可以包含不同类型的数据

```

元组是不可变的序列类型,通常用于存储异构数据集合:

```python

my_tuple = (1, "World", 2.718) # 元组中的数据类型可以不同

```

字典是一种映射类型,以键值对(key-value)的方式存储数据,非常适用于需要映射关系的场景:

```python

my_dict = {"name": "Alice", "age": 25, "city": "New York"}

```

集合是一个无序且不包含重复元素的集合类型,适用于进行集合运算,如并集、交集、差集等:

```python

my_set = {1, 2, 3, 4, 5}

```

以上这些数据结构在数据预处理过程中非常实用,如列表和元组可用于存储和传递数据集的行或列,字典适用于存储配置参数或映射关系,集合在去除数据重复项和进行集合操作时很有帮助。

### 2.2 数据清洗技巧

#### 2.2.1 缺失值处理方法

在数据预处理过程中,缺失值是常见问题。缺失值可能因为数据收集不完整、错误或隐私保护等原因产生。处理缺失值的方法主要有删除记录、填充缺失值和预测缺失值。

删除记录是一种简单粗暴的方式,适用于缺失数据较少的情况:

```python

import pandas as pd

# 创建数据集

df = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, None, 8],

'C': [9, 10, 11, 12]

})

# 删除含有缺失值的记录

df_dropped = df.dropna()

```

填充缺失值通常使用固定值(如0或众数等)或采用插值方法,如向前填充或向后填充:

```python

# 使用固定值填充缺失值

df_filled = df.fillna(value=0)

# 向前填充和向后填充

df_filled_forward = df.fillna(method='ffill')

df_filled_backward = df.fillna(method='bfill')

```

预测缺失值是通过机器学习算法,根据已有数据预测缺失值。这种方法较为复杂,但在数据集较大时往往效果更好。

#### 2.2.2 异常值和噪声的识别与处理

异常值(Outliers)和噪声的识别和处理是数据清洗的重要环节。异常值可能源于测量错误或其他特殊原因,对分析结果产生负面影响。识别异常值的常见方法包括箱线图分析、标准差分析和基于聚类的方法。

使用箱线图识别异常值示例代码:

```python

import matplotlib.pyplot as plt

# 数据集

data = [10, 12, 13, 12, 25, 28, 31, 12, 10, 11, 14, 15, 18, 21, 23, 36, 40]

# 绘制箱线图

plt.boxplot(data)

plt.show()

```

在箱线图中,位于“异常区间”(1.5 * IQR之外)的数据点被认为是异常值。

处理异常值通常有删除、变换和忽略等方法。删除异常值可以使用切片或筛选条件,例如:

```python

# 删除箱线图识别的异常值

filtered_data = [x for x in data if x <= 28]

```

变换方法包括数据转换,比如对数变换、平方根变换等,目的是减少异常值对整体分布的影响。

#### 2.2.3 数据的标准化和归一化

标准化(Standardization)和归一化(Normalization)是数据预处理中的重要步骤,用于缩小特征的尺度差异,使之具有可比性。

标准化通常是指将数据调整为具有零均值(mean)和单位方差(variance)。常用的标准化方法是Z-score标准化:

```python

from sklearn.preprocessing import StandardScaler

# 假设df是一个Pandas DataFrame

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df)

```

归一化是将数据缩放到[0, 1]区间内,常用于处理线性模型的输入,防止数值问题:

```python

from sklearn.preprocessing import MinMaxScaler

# 归一化到[0, 1]

scaler = MinMaxScaler()

df_normalized = scaler.fit_transform(df)

```

这些技术在准备数据以供机器学习模型处理时特别重要,确保所有特征在相同的尺度上进行比较,提高了算法的训练效率和准确性。

# 3. Python聚类算法实战

聚类算法是数据科学中一类重要的无监督学习算法,它能够根据数据自身的分布特性,将数据划分为若干个不相交的子集。在这一章节中,我们将深入探讨如何使用Python实现三种最常见的聚类算法:K-均值、层次聚类以及密度聚类(以DBSCAN为例)。通过实战演练,我们将了解每种算法的原理、实现步骤和应用场景,同时探讨如何优化这些算法以应对实际问题。

## 3.1 K-均值聚类算法

### 3.1.1 K-均值算法原理

K-均值聚类算法是最基础也是最常用的聚类算法之一。其核心思想是将n个数据对象根据它们的属性分为k个簇,使得簇内的对象相似度较高,而簇间的对象相似度较低。算法的主要步骤包括:

1. 随机选择k个初始中心点;

2. 将每个点分配到最近的中心点所代表的簇中;

3. 更新每个簇的中心点为簇内所有点的均值;

4. 重复步骤2和步骤3,直到中心点不再发生变化,或者达到预设的迭代次数。

### 3.1.2 使用Python实现K-均值

在Python中,我们可以使用`sklearn`库中的`KMeans`类来实现K-均值聚类算法。以下是使用K-均值算法对数据集进行聚类的代码示例:

```python

from sklearn.cluster import KMeans

import numpy as np

import matplotlib.pyplot as plt

# 假设X为我们要聚类的数据集

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 设置我们要将数据聚类为3个簇

kmeans = KMeans(n_clusters=3, random_state=0).fit(X)

# 聚类中心点

print(kmeans.cluster_centers_)

# 打印每个样本的簇标签

print(kmeans.labels_)

# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=kmeans.labels_, cmap='viridis')

plt.scatter(kmeans.cluster_centers_[:, 0], kmeans.cluster_centers_[:, 1], s=300, c='red')

plt.show()

```

### 3.1.3 K-均值算法的优化与挑战

尽管K-均值算法在很多情况下都能很好地工作,但它的性能严重依赖于初始中心点的选择,有时可能会导致局部最优解。为了应对这一挑战,我们可以通过以下策略优化算法:

- **多次运行**:多次运行算法,并从中选择最好的结果;

- **K-means++**:使用改进的初始化方法K-means++来选择初始中心点,以提高收敛速度和结果的质量;

- **智能初始点选择**:例如使用层次聚类来选择初始中心点,以提高算法的鲁棒性。

## 3.2 层次聚类算法

### 3.2.1 层次聚类概念与算法类型

层次聚类算法通过构建一个分层的簇树来组织数据,无需预先指定簇的数量。该算法分为两类:

- **凝聚(Agglomerative)**:开始时每个数据点自身作为一个簇,然后逐渐合并,直到达到一个簇或者满足特定停止条件;

- **分裂(

0

0