交叉验证在回归分析中的应用:Python案例研究的全面解析

发布时间: 2024-08-31 16:34:21 阅读量: 229 订阅数: 83

《机器学习实战:Python随机森林回归》-涵盖数据分析、算法应用,助力精准预测与决策,适用于金融、科研及商业领域

# 1. 回归分析与交叉验证基础

回归分析是统计学中的一种方法,它通过已知的自变量预测因变量。在这一章中,我们将简要回顾回归分析的核心概念,并介绍交叉验证的基础知识。我们将从线性和非线性回归模型开始,详细探讨回归模型评估的关键指标。之后,我们将转向交叉验证,解释它的核心原理和不同类型的交叉验证方法,如K折、留一交叉验证和时间序列交叉验证。本章将为读者奠定理解后续内容的基础,包括如何使用这些技术进行模型评估与优化。

## 2.1 回归分析概念回顾

### 2.1.1 线性回归和非线性回归

线性回归是构建两个或多个变量间线性关系的模型。其模型形式简单,预测准确度也较高,但无法捕捉变量间更复杂的关系。非线性回归则能够描述变量间的关系更加复杂,包括二次方程、指数函数等不同形式。在选择回归模型时,需要根据数据的特征和分布选择适合的回归类型。

### 2.1.2 回归模型的评估指标

回归模型的评估指标包括均方误差(MSE)、决定系数(R²)和平均绝对误差(MAE)等。决定系数R²表示模型解释的变异量占总变异量的比例,其值越接近1表示模型拟合效果越好。MSE和MAE则从不同的角度评估模型预测值与实际值的偏差,MSE对异常值更为敏感。

通过本章学习,您将具备构建和评估基本回归模型的能力,并对交叉验证的方法有初步的了解。下一章我们将深入探讨交叉验证的理论和数学基础,为后面章节中的实践操作打下坚实的基础。

# 2. 交叉验证的理论和数学基础

### 2.1 回归分析概念回顾

#### 2.1.1 线性回归和非线性回归

回归分析是统计学中用于预测和分析变量之间关系的方法。在线性回归中,目标是找到一条直线,这条直线可以最好地描述一个因变量和一个或多个自变量之间的关系。这通常通过最小化误差的平方和来实现,以找到最佳拟合线。

```python

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

# 假设有一些简单的数据点

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([1, 2, 3, 2, 5])

# 创建一个线性回归模型

model = LinearRegression()

model.fit(X, y)

# 预测值

y_pred = model.predict(X)

# 绘制原始数据和回归线

plt.scatter(X, y, color='blue')

plt.plot(X, y_pred, color='red', linewidth=2)

plt.show()

```

非线性回归则包含任何非线性关系,这可以通过多项式回归、对数函数、指数函数等模型来实现。这些模型允许更复杂的函数形式来捕捉数据中的趋势和模式。

```python

from sklearn.preprocessing import PolynomialFeatures

# 创建一个非线性(二次)回归模型

poly_model = PolynomialFeatures(degree=2)

X_poly = poly_model.fit_transform(X)

poly_model.fit(X_poly, y)

y_poly_pred = poly_model.predict(X_poly)

# 绘制原始数据和非线性回归曲线

plt.scatter(X, y, color='blue')

plt.plot(X, y_poly_pred, color='green', linewidth=2)

plt.show()

```

在选择线性或非线性模型时,需要基于数据的实际分布和模型的适用性来决定。线性模型因其简单性和可解释性而广泛使用,而非线性模型可能提供更精确的拟合,但模型的解释性会降低。

#### 2.1.2 回归模型的评估指标

回归模型的评估指标主要有均方误差(MSE)、均方根误差(RMSE)、决定系数(R²)和调整后的R²等。MSE和RMSE衡量的是模型预测值与实际值之间的差异,R²则反映了模型对数据变异性的解释能力。调整后的R²在R²的基础上对模型的复杂度进行了惩罚,适用于比较具有不同解释变量数量的模型。

```python

from sklearn.metrics import mean_squared_error, r2_score

# 计算MSE和RMSE

mse = mean_squared_error(y, y_pred)

rmse = np.sqrt(mse)

# 计算R²值

r2 = r2_score(y, y_pred)

# 输出评估指标

print(f"MSE: {mse}")

print(f"RMSE: {rmse}")

print(f"R²: {r2}")

```

### 2.2 交叉验证的原理

#### 2.2.1 K折交叉验证的概念

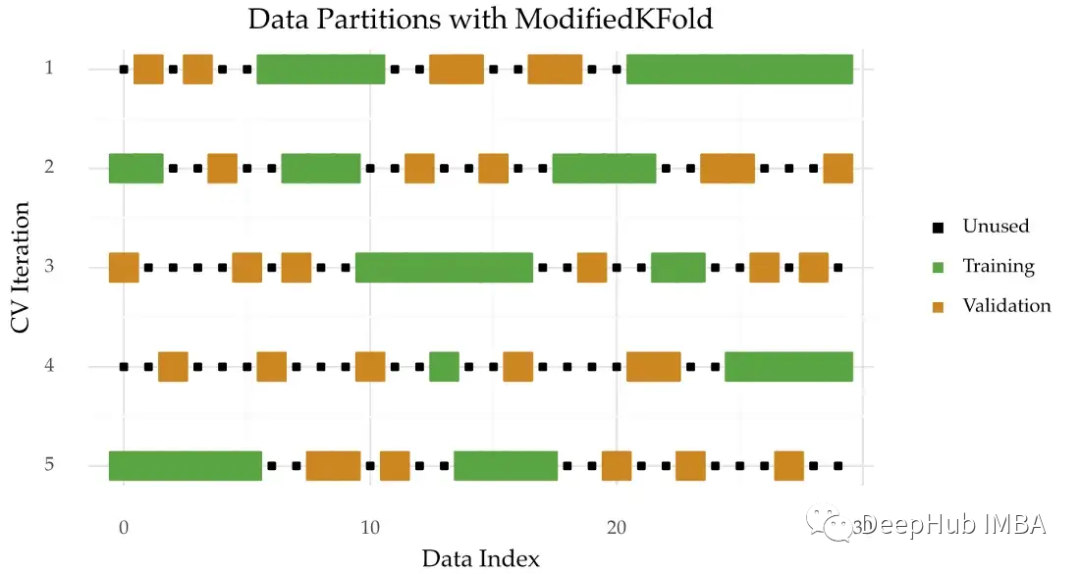

K折交叉验证是一种常用的模型评估方法,它将数据集随机分成K个大小相等的子集。模型在K-1个子集上进行训练,在剩余的一个子集上进行测试。这个过程重复K次,每次选择不同的测试集。最后,将K次的测试结果进行平均,得到模型的整体性能评估。

```mermaid

graph TD;

A[K折交叉验证] --> B[随机分割数据集];

B --> C[循环K次];

C -->|第i次| D[训练集: K-1个子集];

C -->|第i次| E[测试集: 1个子集];

D --> F[训练模型];

E --> G[评估模型];

G --> H[平均所有测试结果];

F --> I[返回模型训练步骤];

H --> J[整体性能评估];

```

#### 2.2.2 留一交叉验证和时间序列交叉验证

留一交叉验证是一种特殊形式的交叉验证,K等于数据集的样本数,即每次只有一个样本作为测试集,其余作为训练集。这种交叉验证方式提供了一个几乎无偏的模型评估,但计算成本非常高。

```python

from sklearn.model_selection import LeaveOneOut

loo = LeaveOneOut()

for train_index, test_index in loo.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 训练和测试模型

```

时间序列交叉验证特别适用于时间序列数据,其中数据的顺序很重要。在这种方法中,划分数据集的策略考虑了时间的先后顺序,以避免未来的数据影响到对过去数据的评估。

```python

from sklearn.model_selection import TimeSeriesSplit

tscv = TimeSeriesSplit(n_splits=5)

for train_index, test_index in tscv.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 训练和测试模型

```

### 2.3 交叉验证的优势与挑战

#### 2.3.1 提高模型泛化能力

交叉验证最大的优势在于能够有效地利用有限的数据资源,对模型进行更加可靠的泛化能力评估。通过多次训练和测试,交叉验证可以减少模型评估的方差,并提供对模型性能更加一致的认识。

#### 2.3.2 计算复杂度与结果可变性

然而,交叉验证也有其挑战。随着K的增加,计算复杂度随之增加,特别是当模型需要进行大量计算时,例如深度学习模型。此外,交叉验证的结果可能会受到数据划分方式的影响,有时候不同的数据划分可能会导致性能评估结果的波动。

通过本章节的介绍,我们了解了交叉验证的理论基础以及在模型评估中的优势和挑战。这为我们在后续章节中深入讨论交叉验证在Python中的实践和高级应用打下了坚实的理论基础。

# 3. Python中的回归分析实践

## 3.1 Python回归分析工具概述

### 3.1.1 Scikit-learn库的基本用法

Scikit-learn(也称为sklearn)是一个开源的Python机器学习库,它提供了简单而高效的工具用于数据挖掘和数据分析。其主要用于机器学习的监督和非监督算法,其中回归分析是监督学习的一个重要分支。在这一小节中,我们将介绍Scikit-learn库在回归分析中的基本用法。

```python

# 导入所需的库

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

# 示例数据集

# 假设X为特征数据,y为标签数据

X = [[1], [2], [3], [4], [5]]

y = [1, 2, 3, 2, 5]

# 创建回归模型实例

model = LinearRegression()

# 训练模型

model.fit(X, y)

# 使用模型进行预测

predictions = model.predict(X)

# 计算模型的均方误差(MSE)

mse = mean_squared_error(y, predictions)

print(f"模型的均方误差(MSE): {mse}")

```

在上述代码中,我们首先导入了`LinearRegression`类,该类用于创建线性回归模型。然后使用`train_test_split`方法将数据集划分为训练集和测试集。这是机器学习模型训练中的一个标准实践,目的是评估模型在未知数据上的性能。

接下来,我们调用`fit`方法对模型进行训练,该方法接受特征数据集`X`和标签数据集`y`作为输入。训练完成后,我们调用`predict`方法对同一数据集进行预测,实际上为了更好的评估,应该对测试集进行预测。最后,使用`mean_squared_error`函数计算预测结果与真实值之间的均方误差(MSE)。

### 3.1.2 Pandas在数据预处理中的应用

在使用回归模型进行分析之前,数据预处理是一个重要的步骤,这通常是通过Pandas库来完成的。Pandas是一个强大的Python数据分析工具库,提供了快速、灵活和表达式丰富的数据结构,旨在使“关系”或“标签”数据的使用变得既简单又直观。

```python

import pandas as pd

# 创建一个示例数据框

data = pd.Da

```

0

0