缓存机制与数据结构的秘密:LRU与LFU淘汰策略的深度解析

发布时间: 2024-09-10 20:07:48 阅读量: 56 订阅数: 34

# 1. 缓存机制与数据结构概述

缓存是一种存储技术,它利用快速的临时存储来加速访问频繁的数据。它在计算机科学和信息技术领域被广泛应用于各个层面,从处理器缓存到Web应用的用户会话存储。要理解缓存的工作原理,首先需要熟悉其背后的基本数据结构,比如哈希表、链表、树等。

## 1.1 缓存机制基础

缓存机制的关键在于快速的读取速度和有效的数据管理。通过减少对慢速存储(如硬盘)的访问,系统可以大幅提升性能。例如,在Web服务器中,频繁访问的网页内容通常会保存在内存中以便快速提供给用户。

## 1.2 数据结构在缓存中的角色

不同类型的缓存应用场景可能会选用不同数据结构来优化性能。例如,哈希表提供了快速的查找能力,适合用于快速键值对存储;链表常用于实现LRU(最近最少使用)缓存淘汰策略,通过维护一个有序的元素列表来确定哪些元素应该被淘汰。

缓存机制和数据结构是计算机系统性能优化的核心组成部分,它们的合理应用可以显著提升系统的响应速度和吞吐量。随着技术的进步,新的数据结构和缓存策略不断涌现,为提升系统性能提供了更多可能。接下来的章节中,我们将深入探讨两种重要的缓存淘汰策略:LRU和LFU,以及它们的实现和在实际应用中的表现。

# 2. LRU与LFU淘汰策略的理论基础

## 2.1 缓存淘汰策略简介

缓存淘汰策略是缓存机制中至关重要的组成部分,它负责在缓存空间不足时决定哪些数据应被保留,哪些数据应被移除。在这一部分,我们将从缓存的作用与重要性、淘汰策略的目标与原则两个方面进行介绍。

### 2.1.1 缓存的作用与重要性

缓存是一种存储技术,它通过将频繁使用的数据保存在距离处理器较近的位置来提高数据访问速度。缓存的引入极大地提高了系统的性能,尤其在处理大量数据时,它能够显著减少数据访问延迟,提升整体的处理效率。

缓存的重要性体现在以下几个方面:

- **加速数据访问**:缓存存储的通常是最近使用过或者最有可能再次使用的数据,这使得数据可以迅速被访问。

- **降低系统负载**:通过缓存数据,可以避免对后端存储系统的重复访问,从而减少对后端系统的压力。

- **提高数据吞吐量**:由于缓存通常位于高速存储介质中,它能够提供比传统存储更高的数据吞吐量。

### 2.1.2 淘汰策略的目标与原则

淘汰策略的目标是在有限的缓存空间中,尽可能提高缓存命中率,从而提升系统整体性能。为了达到这一目标,淘汰策略需要遵循以下原则:

- **最少使用原则**:优先移除长时间未被访问的数据。

- **最近最少使用原则**:结合了使用频率和访问时间,移除最近最少被访问的数据。

- **最不经常使用原则**:移除最不经常访问的数据,即使它最近被访问过。

淘汰策略的设计必须兼顾缓存命中率和系统开销,通过不断优化,实现性能和成本之间的平衡。

## 2.2 LRU淘汰策略深度解析

### 2.2.1 LRU的定义和工作原理

**最近最少使用(Least Recently Used, LRU)**是一种常用的缓存淘汰策略。它的核心思想是淘汰最长时间未被访问的数据。LRU算法在缓存管理中模拟了一个队列结构,记录数据项的访问顺序,队尾存放最近最少使用的数据,而队头存放最近频繁使用的数据。

### 2.2.2 LRU算法的实现方式

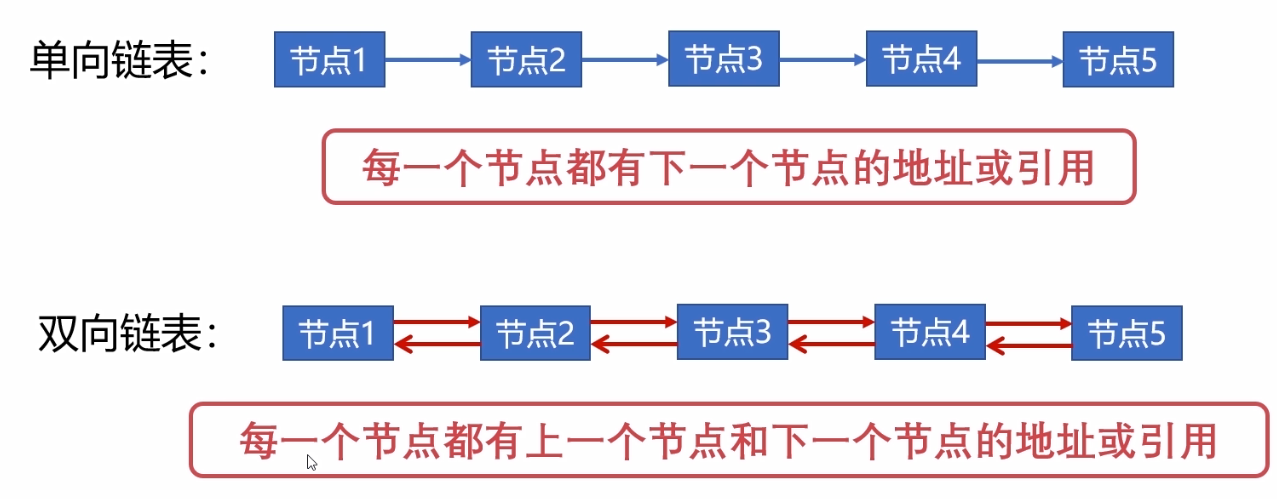

LRU算法的实现可以通过多种数据结构,如链表、栈或哈希表。这里我们详细说明使用双向链表结合哈希表的实现方式。

1. **哈希表**用来存储数据项的键和指向链表中相应节点的指针,以便在O(1)时间内定位到链表中的节点。

2. **双向链表**则维护了一个有序的节点集合,最新的数据被放在链表头部,最老的数据位于尾部。

当数据被访问时:

- 如果数据已经在缓存中,其对应的链表节点移动到链表头部,表示最近被使用。

- 如果数据不在缓存中,新节点被添加到链表头部,并从尾部淘汰掉最老的数据。

### 2.2.3 LRU的优缺点分析

LRU策略的优点显而易见:

- **局部性原理**:根据程序访问局部性原理,最近访问的数据可能在不久的将来再次被访问,LRU的使用能够较好地符合这一特性。

- **实现简单**:相较于其他复杂算法,LRU算法易于理解和实现。

然而,LRU策略同样存在一些缺点:

- **开销大**:尤其是双向链表在每次访问数据项时都需要移动节点,这增加了操作的复杂度。

- **栈溢出问题**:在多线程环境下,由于线程竞争可能导致数据不一致。

## 2.3 LFU淘汰策略深度解析

### 2.3.1 LFU的定义和工作原理

**最不经常使用(Least Frequently Used, LFU)**是一种依赖访问频率作为淘汰依据的缓存算法。不同于LRU,LFU并不关心最后一次数据项被访问的时间,而是关心数据项被访问的频率。在LFU中,被访问次数最少的数据项首先被淘汰。

### 2.3.2 LFU算法的实现方式

LFU算法的实现通常会使用以下数据结构:

- **哈希表**:用于存储数据项和它们的引用计数。

- **优先队列**:用于维护数据项的引用计数,并能够快速选出计数最小的数据项。

在LFU策略中,每当数据项被访问时,其引用计数增加1。当缓存需要淘汰数据项时,优先队列将提供引用次数最少的数据项供淘汰。

### 2.3.3 LFU的优缺点分析

LFU算法的优点主要体现在:

- **访问频率利用**:LFU算法能够较好地利用访问频率信息,在某些情况下能更准确地预测未来可能访问的数据项。

- **理论完备性**:在理想条件下,LFU可以保证命中率高于LRU。

但LFU同样存在缺点:

- **冷启动问题**:新加入缓存的数据项由于没有访问历史,很难被及时淘汰。

- **计数溢出问题**:随着时间的推移,计数器可能会溢出,需要定期调整计数器值。

通过本章内容,我们介绍了LRU和LFU两种淘汰策略的理论基础,并对它们的实现方式及优缺点进行了深入分析。在实际应用中,了解这些基础知识是实现高效缓存管理的前提。接下来的章节我们将探讨这些策略在不同场景下的应用实例,以及它们在实际操作中的性能比较。

# 3. LRU与LFU在实践中的应用

## 3.1 LRU的应用实例

### 3.1.1 LRU缓存在Web服务器中的应用

在Web服务器环境中,缓存是提高响应速度和系统吞吐量的关键组件。LRU(Least Rece

0

0