【反向传播算法】:深度理解神经网络训练的幕后推手

发布时间: 2024-09-06 01:57:33 阅读量: 75 订阅数: 47

理解与实现反向传播算法:神经网络训练指南.html

# 1. 反向传播算法简介

## 1.1 概述

反向传播算法是深度学习中用于训练神经网络的一种核心算法。它的主要作用是通过误差的反向传递来调整网络中的权重和偏置,以达到优化模型性能的目的。

## 1.2 算法的起源和重要性

算法的雏形可追溯至上世纪60年代,但直到1986年,由Rumelhart、Hinton和Williams共同提出的理论,反向传播算法才广为人知。通过这种机制,神经网络可以从大量数据中学习复杂的模式,这使得它在图像识别、语音处理等领域得到了广泛应用。

## 1.3 反向传播的原理

反向传播算法基于链式法则,通过计算损失函数相对于神经网络参数的梯度,按照梯度下降的方向逐层更新参数。具体来说,从输出层开始,逐层向前计算每个参数的梯度,然后将这些梯度作为引导,调整网络中的权重和偏置。

```python

# 伪代码示例展示反向传播过程

# 假设我们有一个简单的神经网络,输入x, 输出y,误差E

# 计算输出层误差

output_error = E

# 反向传播过程,更新最后一层权重

for each weight in last_layer_weights:

gradient = calculate_gradient(output_error, weight)

weight -= learning_rate * gradient

# 继续向前一层传播误差,并更新该层权重

for each weight in previous_layer_weights:

gradient = calculate_gradient(output_error, weight)

weight -= learning_rate * gradient

```

这段伪代码简洁地演示了反向传播算法的核心思想,实际的实现会涉及更复杂的数据结构和计算过程。通过这种方式,网络逐步调整参数以最小化输出误差,从而实现对数据的正确学习和预测。

# 2. 神经网络基础知识

### 2.1 神经网络的结构组成

神经网络由多个神经元组成,这些神经元被组织成不同的层次结构。每一个神经元都可以看作是输入数据进行加权求和,然后通过激活函数转换输出的过程。

#### 2.1.1 神经元和层的概念

一个神经元接收若干个输入,每个输入都有一个对应的权重,通过加权求和,然后加上一个偏置值,最后将结果传递给激活函数。若干个这样的神经元构成一层,层与层之间通过权重连接,形成了一个完整的神经网络。

```mermaid

graph LR

A[输入层] -->|加权求和 + 偏置| B[隐藏层]

B -->|加权求和 + 偏置| C[输出层]

```

#### 2.1.2 权重和偏置的作用

权重和偏置是神经网络训练过程中需要学习的参数。权重决定了输入对神经元输出的影响程度,而偏置则是调整神经元输出的基础位置,相当于为神经元的激活函数提供了水平偏移。优化这些参数是神经网络学习的核心。

### 2.2 激活函数的原理和选择

激活函数为神经网络引入了非线性因素,使得神经网络可以逼近任何非线性函数。

#### 2.2.1 常用激活函数概述

- Sigmoid 函数:将任意值压缩至 (0, 1) 区间内,但容易造成梯度消失问题。

- Tanh 函数:输出在 (-1, 1) 区间内,相对 Sigmoid 有中心对称性,但同样存在梯度消失问题。

- ReLU 函数:输出 0 或者输入值,缓解了梯度消失问题,但在负区间内导数为0。

- Leaky ReLU 和 Parametric ReLU:改进版本,解决了 ReLU 在负区间梯度为0的问题。

```python

import numpy as np

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def tanh(x):

return np.tanh(x)

def relu(x):

return np.maximum(0, x)

def leaky_relu(x, alpha=0.01):

return np.where(x < 0, alpha * x, x)

```

#### 2.2.2 激活函数对训练的影响

激活函数的选择直接影响模型的学习能力和泛化能力。例如,使用 ReLU 可以加速训练,但也可能导致“神经元死亡”,影响训练效果。因此,选择合适的激活函数需要根据具体任务和数据特性来决定。

### 2.3 损失函数与优化目标

损失函数衡量了模型预测值与真实值之间的差异,是优化算法的依据。

#### 2.3.1 损失函数的定义和作用

损失函数也称作代价函数,常见的有均方误差(MSE)、交叉熵等。损失函数是优化算法的目标函数,训练过程中会不断更新权重和偏置,以最小化损失函数的值。

```python

def mse_loss(y_true, y_pred):

return np.mean((y_true - y_pred) ** 2)

```

#### 2.3.2 优化算法的目标函数

优化算法通过梯度下降更新模型参数,目标是最小化损失函数。不同的优化算法有不同的速度和效果,例如SGD、Adam、RMSprop等。

```python

def gradient_descent(x, y_true, y_pred, learning_rate):

m = np.mean((y_true - y_pred) * x)

b = np.mean(y_true - y_pred)

return m, b

# 参数更新

m, b = gradient_descent(x, y_true, y_pred, learning_rate=0.01)

```

以上内容为你提供了第二章“神经网络基础知识”的详细展开,深入探讨了神经网络的结构组成,激活函数的原理和选择,以及损失函数与优化目标。希望这些内容能帮助你更深入地理解神经网络的构建和优化过程。

# 3. 反向传播算法的理论基础

## 3.1 梯度下降与误差反向传播

### 3.1.1 梯度下降算法原理

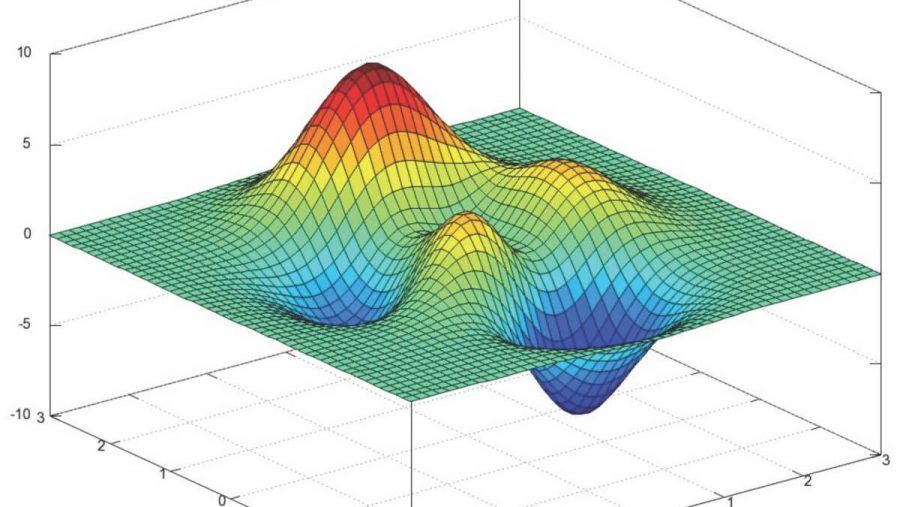

梯度下降算法是一种迭代优化算法,常用于求解机器学习中的优化问题。它基于一个简单直白的原理:如果你在一个函数的图形上,要从当前位置向最低点移动,那么你的最佳路径就是沿着当前点的梯度下降方向走。这个“梯度”是目标函数在当前点的偏导数构成的向量,它指向的是函数增长最快的方向。

在神经网络中,我们利用梯度下降算法来最小化损失函数,即实际输出与期望输出之间的误差。通过不断地调整网络权重(通常是以较小的步长进行),梯度下降算法试图找到最小化损失函数的权重值。

### 3.1.2 反向传播的过程详解

反向传播是基于链式法则进行的,它通过网络层反向传递误差,计算每一层的梯度。首先,反向传播从输出层开始,计算损失函数相对于输出层激活值的梯度。接着,它逐层向输入层方向传递,每经过一层,都会根据链式法则计算当前层权重和激活值相对于损失函数的梯度。

具体步骤通常包括:

1. **前向传播**:输入数据经过每一层神经网络,直到输出层。

2. **计算误差**:计算输出层的预测值与真实值之间的误差。

3. **反向传播误差**:从输出层开始,根据误差计算损失函数对每一层权重的偏导数。

4. **更新权重**:根据计算出的偏导数(梯度),调整权重,减少损失。

下面是一个简化的反向传播计算过程的伪代码:

```python

# 假设已经计算出前向传播的激活值和输出

# 计算输出层误差

delta_output = expected_output - actual_output

# 计算输出层权重的梯度

output_gradient = delta_output * activation_function_derivative(output_activation)

# 更新输出层权重

output_weights -= learning_rate * output_gradient

# 反向传播到隐藏层

for each hidden_layer in reversed(hidden_layers):

# 计算误差项

delta_hidden = np.dot(hidden_layer.next_weights.T, delta_hidden_next) * activation_function_derivative(hidden_layer.activation)

# 计算隐藏层权重的梯度

hidden_gradient = delta_hidden * activation_function_derivative(hidden_layer.activation)

# 更新隐藏层权重

hidden_layer.weights -= learning_rate * hidden_gradient

```

在实际操作中,我们不会手动计算这些梯度,

0

0