【算法优化策略】:特征提取效率提升的5大方法

发布时间: 2024-09-07 02:26:55 阅读量: 145 订阅数: 46

PSO提取特征_粒子群优化算法;PSO;提取特征_PSO特征_特征提取_divisionvfu_

# 1. 特征提取的理论基础和挑战

## 1.1 特征提取的重要性

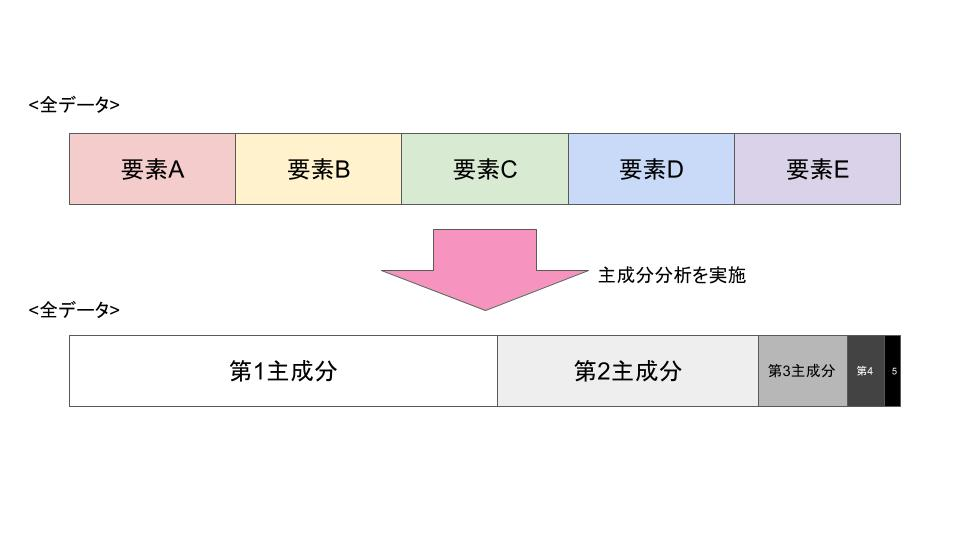

在机器学习和数据分析中,特征提取是将原始数据转换为用于模型训练的有效输入的过程。这个转换过程至关重要,因为它直接影响到模型的性能和预测结果的准确性。特征提取的核心目标是提取与预测任务最相关的数据特征,以减少数据的维度并提高计算效率。

## 1.2 特征提取的挑战

特征提取面临多个挑战,例如噪声数据的干扰、高维数据的维数灾难、以及确定哪些特征真正有助于提高模型性能。为了克服这些挑战,数据科学家需要使用不同的技术,如特征选择、特征缩放和降维技术来准备数据。本章将重点讨论这些基本理论和挑战,为后续章节的具体应用和方法论打下基础。

## 1.3 特征提取的理论基础

特征提取的理论基础涉及统计学、线性代数和信息论等多个领域。它包括对数据的理解,包括对数据的分布、方差、互信息等进行分析,以便识别和构造对预测任务最有用的特征。在处理不同类型的数据时,理论基础将引导我们选择合适的数学工具和算法来提取特征。

# 2. 数据预处理与特征缩放

数据预处理是机器学习中的重要步骤,直接影响到最终模型的性能。在这一章中,我们将详细讨论数据预处理以及特征缩放技术。数据预处理包括数据清洗和特征编码方法,而特征缩放技术涉及标准化、归一化等。

## 2.1 数据清洗的重要性

数据清洗是预处理的关键部分,其主要目的是保证数据质量。数据清洗可以提高数据的准确性,提升后续模型的预测能力。

### 2.1.1 缺失值处理方法

缺失值是数据集中常见的问题。它可能是因为数据未能记录、数据损坏、或者数据收集过程中的遗漏造成的。处理缺失值的方法很多,包括删除含有缺失值的样本、使用均值、中位数、众数进行填充,或者采用更复杂的插补方法。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 示例数据

data = pd.DataFrame({

'A': [1, 2, 3, None],

'B': [4, None, 6, 7],

'C': [7, 8, None, 10]

})

# 使用均值填充缺失值

imputer = SimpleImputer(missing_values=np.nan, strategy='mean')

data_imputed = pd.DataFrame(imputer.fit_transform(data), columns=data.columns)

```

上述代码中,`SimpleImputer`是用于填充缺失值的类。`strategy='mean'`指定了填充策略为均值。通过这种处理方式,可以显著提高数据集的质量,减少数据不一致性对模型的影响。

### 2.1.2 异常值检测与处理

异常值是与其它观测数据显著不同的值,可能是数据收集错误或真实反映了数据的异常情况。异常值检测和处理是数据清洗的重要环节,常用的方法包括标准差法、箱线图和基于统计的模型方法。

```python

import numpy as np

import matplotlib.pyplot as plt

from scipy import stats

# 使用标准差法检测异常值

z_scores = np.abs(stats.zscore(data))

threshold = 3 # 定义异常值阈值

data_outlier = data[(z_scores > threshold).any(axis=1)]

```

在上述代码中,`z_scores`代表了数据集中每个值的标准差。通过设定阈值,可以识别和处理异常值。处理方法可以是删除异常值、替换为均值或中位数等。

## 2.2 特征缩放技术

特征缩放是将数据特征缩放到统一的范围或分布,这对许多机器学习算法的收敛速度和准确性至关重要。最常见的缩放技术包括标准化和归一化。

### 2.2.1 标准化与归一化

标准化(Standardization)是将数据按比例缩放,使之均值为0,标准差为1。归一化(Normalization)是将数据缩放到[0, 1]的范围。

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 标准化

scaler_standard = StandardScaler()

data_standard = scaler_standard.fit_transform(data_imputed)

# 归一化

scaler_minmax = MinMaxScaler()

data_minmax = scaler_minmax.fit_transform(data_imputed)

```

上述代码展示了如何使用`StandardScaler`和`MinMaxScaler`来对数据进行标准化和归一化处理。处理后的数据可用于多数需要对输入特征进行缩放的机器学习算法中。

### 2.2.2 最值缩放与Z-score标准化

最值缩放是根据数据的最小和最大值来进行缩放。Z-score标准化是根据数据的均值和标准差来进行缩放。这两种方法常用于处理数据,以便于后续分析。

```python

# 最值缩放

data_range = data_imputed.max() - data_imputed.min()

data_minmax = (data_imputed - data_imputed.min()) / data_range

# Z-score标准化

data_zscore = (data_imputed - data_imputed.mean()) / data_imputed.std()

```

在最值缩放代码中,`data_range`是数据最大值与最小值的差。而Z-score标准化则使用了数据的均值和标准差。

## 2.3 特征编码方法

特征编码是将类别变量转换为机器学习算法可以理解的数值形式。常用的编码方法包括独热编码、标签编码、二进制编码和哈希编码。

### 2.3.1 独热编码与标签编码

独热编码(One-Hot Encoding)是为每个类别变量的每个值创建一个新特征,这些新特征的值为0或1。标签编码(Label Encoding)是将每个类别值映射到一个整数。

```python

from sklearn.preprocessing import OneHotEncoder, LabelEncoder

# 独热编码

encoder_ohe = OneHotEncoder()

data_ohe = encoder_ohe.fit_transform(data_imputed[['A']]).toarray()

# 标签编码

encoder_le = LabelEncoder()

data_le = encoder_le.fit_transform(data_imputed['A'])

```

在独热编码中,我们针对特定的列`'A'`进行了转换。而在标签编码中,我们直接对`'A'`列的值进行了整数映射。

### 2.3.2 二进制编码与哈希编码

二进制编码是独热编码的压缩形式,通过将每个类别值表示为二进制数来减少特征的数量。哈希编码是一种将类别特征转换为固定大小的数值特征的方法。

```python

# 二进制编码

data_bin = encoder_ohe.fit_transform(data_imputed[['B']]).toarray()

# 哈希编码

hashing_encoder = HashingVectorizer(n_features=5)

data_hash = hashing_encoder.fit_transform(data_imputed['C'])

```

二进制编码的处理方法与独热编码类似,只是转换结果为二进制形式。哈希编码使用了`HashingVectorizer`来实现,其中`n_features`参数设置了哈希后的特征数量。

特征缩放技术与特征编码方法是数据预处理的两个核心部分。通过应用这些技术,我们能够改善数据的分布和可操作性,为后续的特征提取和模型训练打下良好的基础。

# 3. 特征选择策略

在数据挖掘和机器学习领域,特征选择是一个至关重要的步骤,其目的在于选择最能代表数据特点的特征子集。通过特征选择,不仅可以减少模型训练的时间,提高预测性能,还能提升模型的可解释性。本章将深入探讨特征选择的不同策略,并分析其工作原理以及在实际问题中的应用。

## 3.1 过滤法特征选择

过滤法通过统计方法来评估特征与目标变量之间的相关性,无需训练学习模型。这些方法通常计算效率高,但往往无法考虑到特征间的相互作用。

### 3.1.1 单变量统计检验

单变量统计检验是一种简单而有效的特征选择方法。例如,卡方检验广泛应用于分类特征和目标变量之间的独立性检验。在连续型特征中,F检验和ANOV

0

0