特征提取与增强学习:打造识别系统的智能大脑

发布时间: 2024-09-07 02:30:44 阅读量: 72 订阅数: 36

# 1. 特征提取与增强学习基础

在当今信息技术迅猛发展的大背景下,特征提取与增强学习作为两个重要的研究方向,它们在模式识别、智能系统开发等领域扮演着不可或缺的角色。本章将对特征提取与增强学习的基本概念进行初步的介绍,并为读者构建一个知识框架,为后面章节的深入学习打下基础。

## 1.1 特征提取与增强学习的融合

特征提取是数据科学中的一个核心概念,它涉及将原始数据转换为一个更具有代表性和可操作性的特征集合。而增强学习,则是机器学习的一个分支,着重于智能体(agent)如何在环境中采取行动,以最大化累积奖励的概念。这两者结合起来,能够提供强大的工具集来解决复杂的识别任务。

## 1.2 特征提取的角色和重要性

在机器学习和数据分析过程中,特征提取的作用是提取原始数据中的重要信息,为后续模型的训练提供支持。通过有效的特征提取,可以降低数据的复杂性,提升模型的泛化能力,并缩短训练时间。

## 1.3 增强学习的基本原理

增强学习关注的是在给定的环境中,智能体如何学习一个策略来执行特定的任务。它通过不断与环境交互,接收反馈奖励,学习到一个策略,使得在长期中获得最大的累计奖励。这个过程模仿了人类学习的方式,是实现智能自主决策的关键技术之一。

接下来的章节将深入探讨特征提取的技术细节、增强学习的理论基础,并通过案例分析来理解这些方法是如何在实际应用中发挥作用的。

# 2. 特征提取技术的理论与实践

### 2.1 特征提取的理论基础

#### 2.1.1 特征与特征空间的定义

在机器学习与数据挖掘领域,特征(Feature)指的是能够代表或描述数据集样本本质属性的变量或数据点。特征的集合构成特征空间(Feature Space),这是一个数学上的抽象概念,可以理解为一个由所有可能的特征值构成的多维空间。每个样本点可以被看做是在这个高维空间中的一个点,而机器学习模型的任务则是学习在这个高维空间中寻找决策边界。

特征提取的目的是将原始数据转化为更有意义的特征表示,以便提高模型的泛化能力。好的特征应该能够增强学习算法区分不同类别的能力,或者使回归问题的预测更加准确。

#### 2.1.2 特征提取的重要性与目的

特征提取对于机器学习模型来说至关重要,因为它直接影响到模型的性能。良好的特征可以减少模型的复杂性,减少过拟合的风险,同时也可以降低训练时间。特征提取的最终目的是:

- **提高模型的性能**:通过减少噪声和冗余,提取出与问题最相关的信息。

- **简化模型的结构**:减少特征维度,有助于减少模型的复杂性,提高计算效率。

- **降低数据的维度**:为数据可视化提供便利,简化后续处理流程。

### 2.2 特征提取的方法与技巧

#### 2.2.1 传统特征提取方法

传统特征提取方法通常不依赖于深度学习模型,而是依靠统计学和线性代数的方法。这些方法包括但不限于:

- **主成分分析(PCA)**:通过线性变换将数据投影到一个低维空间,以最大化方差,提取最重要的特征。

- **线性判别分析(LDA)**:旨在找到最佳的特征空间,以便在新空间中数据点在类别间有最大的分离度。

- **独立成分分析(ICA)**:用于非高斯数据,目的是寻找非高斯的独立成分。

#### 2.2.2 深度学习在特征提取中的应用

随着深度学习的崛起,卷积神经网络(CNN)和循环神经网络(RNN)等模型在图像识别、语音处理和自然语言处理等任务中展现了强大的特征提取能力。深度学习模型通过多层非线性变换,可以自动学习数据的复杂表示。典型的深度学习特征提取流程包括:

- **自动编码器(Autoencoders)**:通过训练一个神经网络来学习输入数据的压缩表示。

- **预训练网络(Pretrained Networks)**:使用预训练模型进行特征提取,常见如VGG、ResNet等。

- **自监督学习(Self-supervised Learning)**:使用未标记的数据进行特征学习,通过预测数据的一部分来学习有用的特征。

### 2.3 特征提取的案例分析

#### 2.3.1 图像识别中的特征提取

在图像识别任务中,特征提取技术是核心。例如,在使用深度学习的卷积神经网络进行图像识别时,卷积层通常能够提取图像的空间特征,而池化层则有助于降低特征维度,同时保留重要信息。

#### 2.3.2 自然语言处理中的特征提取

在自然语言处理(NLP)领域,特征提取通常涉及到词向量的生成。Word2Vec、GloVe等模型可以将词语转换为连续的向量空间,从而让模型能够捕捉词汇间的语义关系。此外,如BERT和GPT等预训练模型也可以理解为一种特征提取技术,它们在大量文本上预训练,能够学习丰富的语言表示。

下文将通过具体的案例分析,展示这些理论知识在实际问题中的应用。

# 3. 增强学习的原理与方法

## 3.1 增强学习的基本概念

增强学习是机器学习的一个分支,它主要关注的是如何基于环境的反馈来改善决策。智能体(agent)在与环境的交互中通过学习来最大化某种累积奖励(cumulative reward)的过程。这里,我们首先探讨智能体与环境之间的基本交互机制,然后了解奖励函数(reward function)的角色以及策略学习(policy learning)的重要性。

### 3.1.1 智能体与环境的交互

在增强学习中,智能体是能够感知环境状态并基于此执行动作的实体。智能体的每一个动作都会影响环境,并得到相应的反馈。环境状态的变化通常遵循一定的动态规律,而智能体的目标是学习一个策略(policy),使得在长期内获得的总奖励最大化。

智能体和环境的交互可以用以下数学模型表示:

```

状态序列 S1, S2, S3, ..., ST

动作序列 A1, A2, A3, ..., AT-1

奖励序列 R2, R3, ..., RT

```

其中,$S_t$ 表示在时间步 t 的状态,$A_t$ 表示智能体在时间步 t 的动作,而 $R_{t+1}$ 表示动作 $A_t$ 导致的奖励。智能体的目标是找到一个策略 $\pi$,使得期望的累积奖励最大化:

E\left[\sum_{t=1}^{T}\gamma^{t-1}R_{t+1}|S_1=s,\pi\right]

这里的 $\gamma$ 是一个折扣因子,用于调节未来奖励相对于立即奖励的重要性。

### 3.1.2 奖励函数与策略学习

在增强学习中,奖励函数起着至关重要的角色,它是智能体学习过程中唯一的反馈信号。奖励函数设计的优劣直接影响智能体的学习效果和最终性能。一个好的奖励函数应该能够引导智能体朝着目标前进,同时还要考虑环境的稳定性和可预测性。

策略学习是指智能体如何根据当前状态选择最佳动作的过程。一个策略 $\pi$ 可以是确定性的,即给出状态直接映射到动作,也可以是随机性的,即给出状态映射到动作的概率分布。策略学习的关键在于如何利用经验来更新策略,以期望获得更高的累积奖励。

## 3.2 增强学习的关键技术

在增强学习中,智能体使用不同的方法来理解和预测与环境的交互结果,以进行更有效的决策。这里,我们将重点介绍价值函数(value function)和策略迭代(policy iteration),以及模型预测与控制的原理。

### 3.2.1 价值函数与策略迭代

价值函数是估计给定状态或状态-动作对在特定策略下的期望累积奖励。有两种常见的价值函数:状态价值函数(V(s))和动作价值函数(Q(s,a))。状态价值函数评估的是从一个状态出发,遵循特定策略,能获得的期望回报。动作价值函数不仅考虑当前状态,还包括了在该状态下采取的动作对未来回报的影响。

策略迭代包含策略评估(policy evaluation)和策略改进(policy improvement)两个步骤。策略评估涉及计算当前策略的价值函数。策略改进是指在价值函数的基础上调整策略,以期获得更高的奖励。

### 3.2.2 模型预测与控制

模型预测控制(Model Predictive Control, MPC)是一种先进的控制策略,它在每个时间步都解决一个有限范围内的优化问题。MPC使用一个模型来预测未来一段时间内的系统行为,并在一个优化问题中制定一系列动作以优化未来回报。MPC在许多实时控制问题中显示出优越性,尤其是在需要考虑约束和未来预测的场合。

## 3.3 增强学习的算法实现

不同的增强学习算法有不同的实现方式和适用场景。本节将分别介绍Q-Learning与SARSA算法,这两种是强化学习中最为经典的价值函数方法;以及策略梯度方法与Actor-Critic框架,这些是策略函数方法的代表。

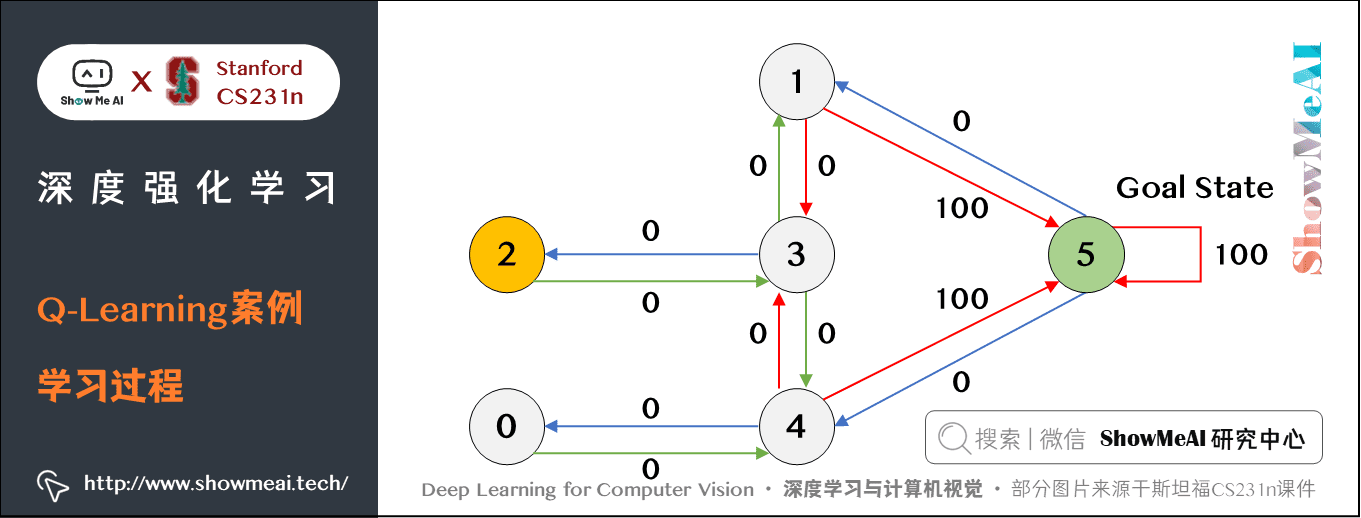

### 3.3.1 Q-Learning与SARSA

Q-Learning是目前最流行的增强学习算法之一。它是一种无需模型的离策略算法,通过更新动作价值函数Q来学习最优策略。Q-Learning的核心公式如下:

Q(S_t, A_t) \leftarrow Q(S_t, A_t) + \alpha \left[ R_{t+1} + \gamma \max_{a}Q(S_{t+1}, a) - Q(S_t, A_t) \right]

其中,$\alpha$ 是学习率,$R_{t+1}$ 是即时奖励,$\gamma$ 是折扣因子,$\max_{a}Q(S_{t+1}, a)$ 是在下一个状态采取的最优动作价值。

SARSA算法和Q-Learning类似,但是它是一种基于策略的算法,意味着它直接基于当前策略来更新Q值。SARSA考虑了在当前状态所采取动作到下一个状态可能采取动作的过渡。

### 3.3.2 策略梯度方法与Actor-Critic

策略梯度方法直接对策略进行参数化,并通过梯度上升的方式优化参数,以期望获得

0

0