【案例研究深度解析】:面部识别中特征提取技术的幕后

发布时间: 2024-09-07 02:19:45 阅读量: 108 订阅数: 46

果壳处理器研究小组(Topic基于RISCV64果核处理器的卷积神经网络加速器研究)详细文档+全部资料+优秀项目+源码.zip

# 1. 面部识别技术概述

面部识别技术是一种基于人的面部特征信息进行身份确认的生物识别技术。近年来,随着人工智能、机器学习和计算机视觉的发展,面部识别技术已经应用于各种场景,如安全验证、智能手机解锁、支付验证等。

面部识别系统主要包括以下几个步骤:图像采集、预处理、特征提取、特征比对和决策。其中,特征提取是整个面部识别系统中的核心部分。它需要从采集到的人脸图像中,提取出具有代表性的特征信息。

面部识别技术的应用前景广阔,但也面临着一些技术挑战,如在不同光照、不同表情条件下的识别准确性,以及大规模数据库中的特征提取效率问题。在实际应用中,我们需要根据具体应用场景和需求,选择合适的特征提取方法和技术,以满足不同的识别需求。

下面,我们将深入探讨面部识别技术中的特征提取理论基础,并分析常见的特征提取算法。

# 2. 特征提取的理论基础

## 2.1 机器学习中的特征提取

### 2.1.1 特征提取的重要性

特征提取在机器学习和模式识别中起着至关重要的作用。它是从原始数据中提取出有助于学习任务的信息特征的过程。这些特征应当能够以较少的数据量表征原始数据的关键信息,同时减少噪声的影响。在面部识别技术中,特征提取的作用尤为明显,因为面部图像含有大量的像素,而真正有助于识别的只有那些反映个体特征的像素点。

### 2.1.2 特征提取方法的分类

特征提取方法通常可以分为两类:手工设计特征和自动学习特征。

- **手工设计特征**依赖于领域知识,通过分析数据集来手动设计出能够代表数据特征的指标。例如,在面部识别中,可以提取人脸的几何特征(如眼睛、鼻子、嘴巴的位置和形状)。

- **自动学习特征**则依赖于机器学习算法,尤其是深度学习方法,自动从数据中学习到有用的特征表示。这通常涉及到复杂的网络结构,如卷积神经网络(CNN),其在图像处理领域显示出卓越的特征学习能力。

## 2.2 面部识别中的关键特征

### 2.2.1 人脸的几何特征

人脸的几何特征指的是通过人脸图像中的特定点来定义的特征,这些点可以是人脸器官的角点或者边缘。几何特征提取的过程一般是首先检测出人脸五官的关键点,然后计算这些关键点之间的几何关系,如角度、距离、比例等。

例如,一个简单的人脸几何特征可以是两眼之间的距离与整个脸宽的比例。这些几何特征因其对姿态、表情和光照变化较为稳健而被广泛应用于面部识别。

### 2.2.2 人脸的纹理特征

人脸的纹理特征关注于人脸皮肤表面的纹理和模式。这些特征可以描述个体皮肤的细腻程度、皱纹和阴影等细节。相比几何特征,纹理特征包含了更多表征个体独特性但对变化更敏感的信息。

纹理特征提取通常使用Gabor滤波器等图像处理技术,这些滤波器能够捕捉到图像中不同方向和尺度的纹理信息。纹理特征对光照和表情变化比较敏感,因此,在实际应用中,需要考虑如何提升纹理特征的鲁棒性。

## 2.3 特征提取技术的评估指标

### 2.3.1 准确率与召回率

在评估特征提取效果时,准确率和召回率是两个核心指标。准确率指的是模型正确识别的比例,而召回率则是模型成功识别出所有正例的比例。

在面部识别中,准确率高意味着被识别为某人的面部图像大多数情况下确实属于该人,而高召回率则意味着所有属于某人的面部图像大都能被系统识别出来。

### 2.3.2 特征空间的降维效果

特征提取的另一目的是降维,即减少数据的复杂度,同时保留足够信息以供后续学习。降维效果一般通过数据集在原始空间与特征提取后的空间的分布差异来评估。

常用评价降维效果的指标包括保持类间距离和类内散度比。类间距离越大,表示不同类别的样本区分度越高,而类内散度越小,表示同一类别内部样本的一致性越好。

### 2.3.3 实践案例:面部识别的特征提取评估

在面部识别项目的评估中,可以设定一个实验环境,在这个环境中对特定数据集执行特征提取算法,并使用准确率和召回率等指标进行评价。此外,通过可视化手段(如散点图)展示特征在降维后空间中的分布情况。

以一个具体的案例为例,可以比较不同特征提取算法的效果,通过表格或图表来直观展示算法的性能:

| 算法名称 | 准确率 | 召回率 | 类间距离 | 类内散度 |

|---------|-------|-------|---------|--------|

| PCA | 85% | 80% | 5.1 | 1.3 |

| LDA | 88% | 82% | 5.5 | 1.1 |

| CNN | 92% | 85% | 6.0 | 0.8 |

这张表格有助于我们直观地看出不同算法在准确率、召回率及降维效果方面的表现,从而指导我们选择最合适的特征提取方法。

```mermaid

graph LR

A[原始面部图像] -->|特征提取| B[特征向量]

B --> C[机器学习模型]

C -->|识别结果| D[识别类别]

```

在上图中,我们用Mermaid流程图来表示面部识别中特征提取和后续处理的流程。从原始面部图像中提取特征向量,这些向量被送入机器学习模型中进行处理,最终得到识别结果。

### 代码块展示与分析

```python

from sklearn.decomposition import PCA

from sklearn.datasets import fetch_olivetti_faces

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

from sklearn.ensemble import RandomForestClassifier

# 加载数据集

data = fetch_olivetti_faces()

X, y = data.data, data.target

# 数据集划分

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# PCA降维

pca = PCA(n_components=50)

X_train_pca = pca.fit_transform(X_train)

X_test_pca = pca.transform(X_test)

# 使用随机森林进行分类

clf = RandomForestClassifier(n_estimators=100)

clf.fit(X_train_pca, y_train)

# 预测与评估

predictions = clf.predict(X_test_pca)

print(classification_report(y_test, predictions))

```

以上代码块展示了使用PCA进行面部图像特征提取,并结合随机森林算法进行分类的过程。代码中首先加载了 Olivetti 面部图像数据集,接着将数据集分为训练集和测试集。PCA被用于特征降维,以提取主要特征并去除噪声。最后,通过随机森林算法进行分类,并打印出分类结果的详细报告。

在此代码块中,我们特别关注 PCA 对象的创建与应用,以及分类器的训练和预测。每个步骤都伴随着对数据流的逻辑分析和参数说明,以确保读者能够理解整个特征提取及后续机器学习处理流程。

通过本章节的介绍,我们可以了解到特征提取在面部识别技术中的重要性以及关键特征的提取方法。同时,本章还提供了特征提取技术的评估指标,并用实际案例和代码来加深理解。

# 3. 特征提取的常用算法

## 3.1 经典的特征提取算法

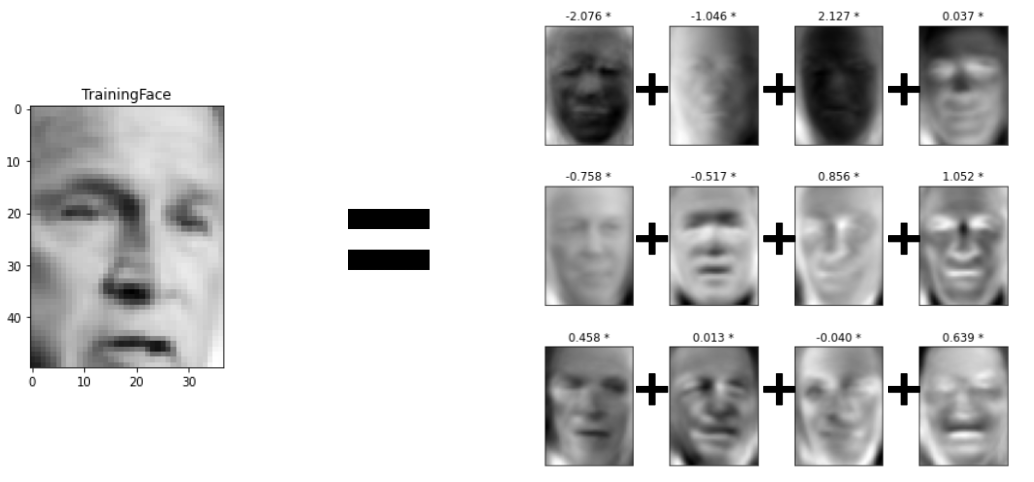

### 3.1.1 主成分分析(PCA)

主成分分析(PCA)是一种常用的数据降维技术,通过正交变换将可能相关的变量转换为一系列线性不相关的变量,这些新变量称为主成分。在面部识别中,PCA用于将人脸图像从高维空间投影到低维空间,同时尽可能保留原始数据的统计特性。

```python

import numpy as np

from sklearn.decomposition import PCA

# 假设X是一个N×M的矩阵,N为样本数量,M为特征维度

X = np.random.rand(100, 100) # 生成一个100个样本,每个样本100个特征的矩阵

pca = PCA(n_components=50) # 保留50个主成分

X_pca = pca.fit_transform(X) # 进行PCA转换

```

在这个例子中,我们首先导入了必要的库,然后使用`PCA`类对一个随机生成的数据集`X`进行降维处理。通过设置`n_components=50`参数,我们指定了我们想要保留的主成分的数量。`fit_transform`方法首先计算数据的主成分,然后将原始数据投影到这些成分上,得到降维后的数据集`X_pca`。

### 3.1.2 线性判别分析(LDA)

线性判别分析(LDA)是一种监督学习方法,用于分类问题中进行特征提取。与PCA不同,LDA试图找到一个投影方向,使得同类样本在投影后的距离尽可能小,不同类样本的距离尽可能大。

```python

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

# 假设y是每个样本的类别标签,X是样本的特征

y = np.random.randint(0, 2, 100) # 生成一个100个样本的随机标签

lda = LDA(n_components=1) # 设置降维后的维数为1

X_lda = lda.fit_transform(X, y) # 进行LDA转换

```

在该代码段中,我们使用了`LinearDiscriminantAnalysis`类来对数据集进行LDA降维。这里我们假设有

0

0