【编程实践指南】:Python实现特征提取算法的秘籍

发布时间: 2024-09-07 02:16:20 阅读量: 104 订阅数: 55

# 1. Python与数据处理基础

在当今的数据驱动时代,数据处理已成为IT和数据科学领域不可或缺的技能。本章将为您介绍Python在数据处理中的核心地位,以及如何运用Python进行基本的数据操作和分析。

## 1.1 数据处理的重要性

数据处理是一个数据从原始状态转化到可用于分析和建模状态的过程。它不仅包括数据清洗、数据转换等预处理步骤,而且还涉及到数据的整合和格式化,为后续的数据分析和机器学习模型的训练做好准备。

## 1.2 Python数据处理库简介

Python拥有众多用于数据处理和分析的库。其中最著名的包括Pandas,它提供了高性能、易于使用的数据结构和数据分析工具;NumPy,它支持高性能的多维数组对象和相关的工具;此外还有Matplotlib和Seaborn,用于数据可视化。

## 1.3 Python数据处理实战操作

实际操作中,通常首先利用Pandas库加载CSV、Excel等格式的数据文件,并通过Pandas强大的数据结构DataFrame进行数据筛选、排序和分组等操作。以下是一个简单的代码示例,展示如何使用Pandas进行数据处理:

```python

import pandas as pd

# 加载数据集

df = pd.read_csv('dataset.csv')

# 查看数据集的前几行

print(df.head())

# 数据清洗:去除重复值

df = df.drop_duplicates()

# 数据转换:创建新列或修改现有列

df['new_column'] = df['existing_column'] * 2

# 数据筛选:选取特定条件的数据

filtered_df = df[df['column_name'] > 10]

# 数据排序

sorted_df = df.sort_values(by='column_name', ascending=False)

# 数据分组

grouped = df.groupby('category_column')

```

在上述代码中,我们首先加载了一个名为'dataset.csv'的数据集,并展示了数据集的前五行。随后,我们去除数据中的重复值、创建了一个新的列、筛选了满足特定条件的记录、对数据进行了排序,并按某个类别列进行了分组。通过这些操作,我们对数据集进行了基本的处理,为进一步的分析和特征提取打下了坚实的基础。

# 2. 特征提取理论与方法

## 2.1 特征提取概念与重要性

特征提取是数据科学中的一个基本步骤,它旨在从原始数据中提取出有用的信息,用于机器学习模型训练、预测和分类等任务。在处理复杂数据集时,合理的特征提取能够提高模型的性能和效率。

### 2.1.1 数据预处理的重要性

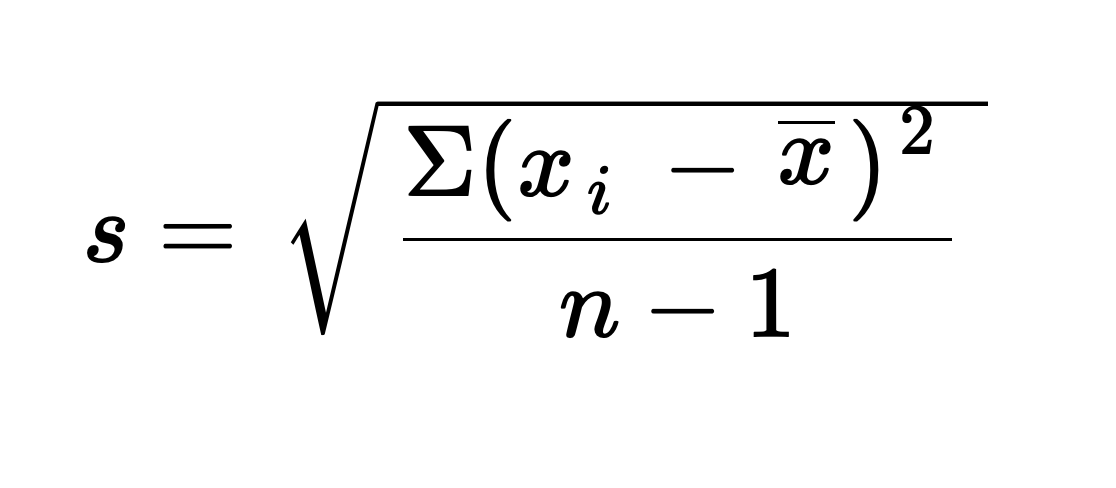

数据预处理是特征提取前的必要步骤,它包括数据清洗、数据规范化、数据归一化等。这一阶段的目标是使数据集适合于后续分析。例如,对于含有缺失值的数据集,合理的处理缺失值可避免对后续分析产生偏误。数据规范化和归一化则可以将不同范围、量纲的数据转换到统一的标准,从而保证算法的有效性和公平性。

### 2.1.2 特征提取的基本步骤

特征提取通常涉及以下基本步骤:

1. 特征选取:根据领域知识和数据特性选取有意义的特征。

2. 特征构造:创建新的特征或改变特征的表示形式,以提升模型性能。

3. 特征转换:使用数学方法将特征转换到新的空间,便于模型理解和处理。

4. 特征选择:从转化后的特征集中选择最有信息量的特征。

5. 特征降维:减少特征的数目,以降低计算复杂度和避免过拟合。

## 2.2 常用的特征提取算法

在本小节中,我们将深入探讨几种常见的特征提取算法,了解其背后的工作原理以及应用场合。

### 2.2.1 主成分分析(PCA)

主成分分析是一种统计技术,它通过线性变换将多个相关的变量转换为一组线性不相关的变量,这些变量称为主成分。PCA的核心目的是减少数据集的维数,同时尽可能保留原始数据集中的信息。

#### PCA的数学原理

PCA是基于协方差矩阵的特征值分解,或者等价地,是数据点矩阵的奇异值分解(SVD)。假设我们有一个数据矩阵X,其中每一列代表一个观测,每一行代表一个特征。PCA寻找一个正交矩阵P,使得:

\[ X \times P = T \]

其中T是一个新的矩阵,其列是原始数据的主成分。主成分的顺序是基于对应特征值的大小排列的,特征值越大,其对应的主成分包含的原始数据信息越多。

#### PCA应用示例代码

```python

import numpy as np

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 生成一个示例数据集

X = np.array([[-1, -1], [-2, -1], [-3, -2], [1, 1], [2, 1], [3, 2]])

# 应用PCA

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 打印主成分和数据点

print(***ponents_)

print(X_pca)

# 可视化结果

plt.scatter(X_pca[:, 0], X_pca[:, 1])

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.show()

```

在上述代码中,我们首先创建了一个二维数据集,然后应用PCA算法并打印出变换后的主成分以及数据点的坐标。最后,我们通过散点图可视化了PCA变换后的数据。

### 2.2.2 线性判别分析(LDA)

线性判别分析(Linear Discriminant Analysis, LDA)是一种监督学习的降维技术,用于分类问题。其目的是寻找一个投影方向,将数据投影到这个方向后,同类样本的投影点尽可能接近,而不同类样本的投影点尽可能远离。

#### LDA的工作原理

LDA算法通过最大化类间距离与类内距离的比率来寻找最佳投影方向。在数学上,它通过求解广义特征值问题来实现。

#### LDA应用示例代码

```python

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

from sklearn.datasets import load_iris

import matplotlib.pyplot as plt

# 加载Iris数据集

iris = load_iris()

X = iris.data

y = iris.target

# 应用LDA

lda = LDA(n_components=2)

X_lda = lda.fit_transform(X, y)

# 可视化结果

plt.scatter(X_lda[:, 0], X_lda[:, 1], c=y, cmap='viridis')

plt.xlabel('LD 1')

plt.ylabel('LD 2')

plt.show()

```

在这个代码段中,我们使用了Iris数据集,并应用LDA算法进行了降维处理。结果通过散点图展示,其中不同的颜色代表不同的类别。

### 2.2.3 t分布随机邻域嵌入(t-SNE)

t分布随机邻域嵌入(t-distributed Stochastic Neighbor Embedding, t-SNE)是一种用于高维数据降维的机器学习算法,它特别适用于数据可视化。t-SNE通过计算高维空间中样本间的概率分布,然后在低维空间中寻找新的分布,使得两者尽可能接近。

#### t-SNE的数学描述

t-SNE的基本思想是,保持数据点间的局部结构不变,并在低维空间中尽可能地表达数据点间的全局结构。

#### t-SNE应用示例代码

```python

from sklearn.manifold import TSNE

from sklearn.datasets import load_digits

import matplotlib.pyplot as plt

# 加载数字数据集

digits = load_digits()

X = digits.data

y = digits.target

# 应用t-SNE

tsne = TSNE(n_components=2, random_state=0)

X_tsne = tsne.fit_transform(X)

# 可视化结果

plt.figure(figsize=(15, 10))

scatter = plt.scatter(X_tsne[:, 0], X_tsne[:, 1], c=y, cmap='tab10')

legend1 = plt.legend(*scatter.legend_elements(), ti

```

0

0