【LDA编程实战】:Python实现线性判别分析的终极指南

发布时间: 2024-11-24 14:20:52 阅读量: 7 订阅数: 6

# 1. 线性判别分析(LDA)概述

线性判别分析(LDA)是一种经典的统计模式识别和机器学习算法,广泛应用于模式分类。LDA旨在找到一个最佳的线性变换,将原始数据投影到较低维空间中,使得同类样本之间的距离最小化,而不同类样本之间的距离最大化。本章将概述LDA的核心概念、其在实际应用中的重要性以及与其他算法的比较,为后续章节中深入的数学原理和实操应用提供理论基础。

LDA算法的核心在于寻找一个变换矩阵,该矩阵能够最大化类间散布矩阵与类内散布矩阵的比值。换句话说,LDA强调投影后的数据能够较好地区分不同类别,同时保持类内样本的一致性。这种技术在许多分类问题中非常有用,尤其是在那些存在大量特征和样本之间存在线性关系的数据集上。

在数据预处理和特征选择的过程中,LDA常被用作降维工具,以减少模型复杂性和过拟合的风险,同时提高后续分类器的性能。然而,值得注意的是LDA具有一定的限制,比如其假设数据必须满足线性可分性。因此,在应用LDA之前,理解其使用场景和局限性是非常重要的。在接下来的章节中,我们将详细探讨LDA的数学原理和如何在Python中实现LDA,以及它在文本分类和图像处理中的应用案例。

# 2. 线性代数基础与概率论回顾

### 2.1 线性代数基础

#### 2.1.1 向量空间和矩阵运算

向量空间是线性代数中的基本概念,它是一个由向量组成的集合,满足向量加法和数乘的八条公理。在多维空间中,向量可以表示点的位置,也可以表示具有方向和大小的量。矩阵是线性代数中另一个重要的工具,它是一种特殊的数组,可以通过行和列的形式来组织数据。

矩阵运算包括加法、减法、数乘以及乘法。矩阵加法和减法要求两个矩阵具有相同的维度,而数乘则是每个元素与一个标量的乘积。矩阵乘法是将第一个矩阵的行与第二个矩阵的列对应元素相乘后求和。这些基本的运算构成了线性代数的骨架,是进一步理解高阶概念和方法的基础。

```mermaid

graph LR

A[向量空间] -->|元素构成| B[向量]

C[矩阵运算] -->|基本操作| D[加法]

C -->|基本操作| E[减法]

C -->|基本操作| F[数乘]

C -->|基本操作| G[乘法]

```

#### 2.1.2 特征值和特征向量

特征值和特征向量是理解线性变换的关键。在数学上,如果存在非零向量v和标量λ,使得矩阵A与v的乘积等于λv,即Av=λv,那么我们称v是A的特征向量,λ是对应的特征值。特征值和特征向量在许多领域有着广泛的应用,例如在数据分析中用于特征提取,在网络分析中用于理解结构特性等。

计算特征值通常涉及到求解特征多项式,它是矩阵A减去λ倍的单位矩阵的行列式为零时的λ值。确定了特征值之后,可以将其代入原方程求解对应的特征向量。特征值的绝对值大小表明了特征向量在变换中的拉伸程度。

### 2.2 概率论基础

#### 2.2.1 随机变量和概率分布

随机变量是概率论中的基础概念,它是将随机试验的结果用数值表示出来的变量。根据随机变量的不同取值,可以定义概率分布。离散型随机变量有概率质量函数(PMF),描述了各个具体值出现的概率;连续型随机变量有概率密度函数(PDF),描述了取值落在某个区间内的概率。

概率分布不仅描述了随机变量的可能取值和取值概率,还揭示了变量的统计规律和内在特性。例如,二项分布描述了n次独立的伯努利试验中成功次数的分布,正态分布(高斯分布)则是自然界中最常见的分布,许多现象的误差和噪声都遵循正态分布。

#### 2.2.2 条件概率和独立性

条件概率是指在某个条件下,某一事件发生的概率。通常用P(A|B)来表示,在事件B发生的条件下事件A发生的概率。条件概率在很多领域都有应用,比如在信息论中,条件熵衡量了一个随机变量在已知另一个随机变量情况下的不确定性。

独立性是概率论中的一个核心概念,如果两个事件A和B满足P(A∩B) = P(A)P(B),则称这两个事件是相互独立的。独立事件的联合概率等于各自概率的乘积,这一性质在进行概率计算时非常有用。在数据分析和机器学习中,独立性假设是很多算法和模型建立的基础。

### 2.3 多变量概率分布

#### 2.3.1 正态分布的性质

正态分布是连续型随机变量中最常见的一种概率分布,它的概率密度函数由均值μ和方差σ²两个参数确定。正态分布的特点是其图形呈现为一条对称的钟形曲线,其中心位于均值μ,曲线的宽度由方差σ²决定。

正态分布在自然界和人类活动中广泛存在,这是因为许多相互独立的影响因素叠加在一起,会趋向于形成正态分布。在统计学中,中心极限定理表明,只要样本量足够大,样本均值的分布接近正态分布,无论原始分布是什么样的。

#### 2.3.2 协方差矩阵的意义

协方差矩阵是描述多个随机变量之间相互关系的重要工具。它是一个对称矩阵,对角线上的元素是各个变量的方差,非对角线上的元素是变量间的协方差。协方差描述了两个变量之间的线性相关程度,正的协方差表示正相关,负的表示负相关。

协方差矩阵在多变量数据分析中尤其重要,例如在主成分分析(PCA)中,协方差矩阵的特征向量决定了数据变换的方向,特征值的大小表明了数据在这些方向上的方差大小。理解协方差矩阵对于深入研究变量间的关系、进行降维分析和特征提取都至关重要。

# 3. LDA理论详解

## 3.1 LDA的数学原理

### 3.1.1 LDA的目标函数推导

线性判别分析(Linear Discriminant Analysis, LDA)是一种经典的线性分类器,其核心思想是寻找最佳的线性组合,使得数据在低维空间中具有最大的类间距离和最小的类内距离。为了深入理解LDA的工作原理,我们先从其目标函数推导开始。

在LDA中,我们假设有 $c$ 个类别,每个类别 $k$ 中有 $n_k$ 个样本,样本在 $d$ 维空间中的均值为 $\vec{\mu}_k$,所有类别的样本均值为 $\vec{\mu}$。LDA的目标是找到一个投影方向(或线性组合) $\vec{w}$,使得在新的特征空间中,类间距离最大化,同时类内距离最小化。

目标函数可以表示为两个部分的比值:类间散布矩阵(Between-class Scatter Matrix, $S_B$)和类内散布矩阵(Within-class Scatter Matrix, $S_W$)的比值。

$$ S_B = \sum_{k=1}^{c} n_k (\vec{\mu}_k - \vec{\mu})(\vec{\mu}_k - \vec{\mu})^T $$

$$ S_W = \sum_{k=1}^{c} \sum_{x_i \in X_k} (x_i - \vec{\mu}_k)(x_i - \vec{\mu}_k)^T $$

其中,$X_k$ 是属于类别 $k$ 的样本集合,$x_i$ 是类别 $k$ 中的一个样本。目标函数可以写作:

$$ J(\vec{w}) = \frac{\vec{w}^T S_B \vec{w}}{\vec{w}^T S_W \vec{w}} $$

通过求解广义特征值问题:

$$ S_B \vec{w} = \lambda S_W \vec{w} $$

可以找到最大化类间距离与类内距离比值的权重向量 $\vec{w}$。最小的特征值对应的特征向量是LDA的解之一。

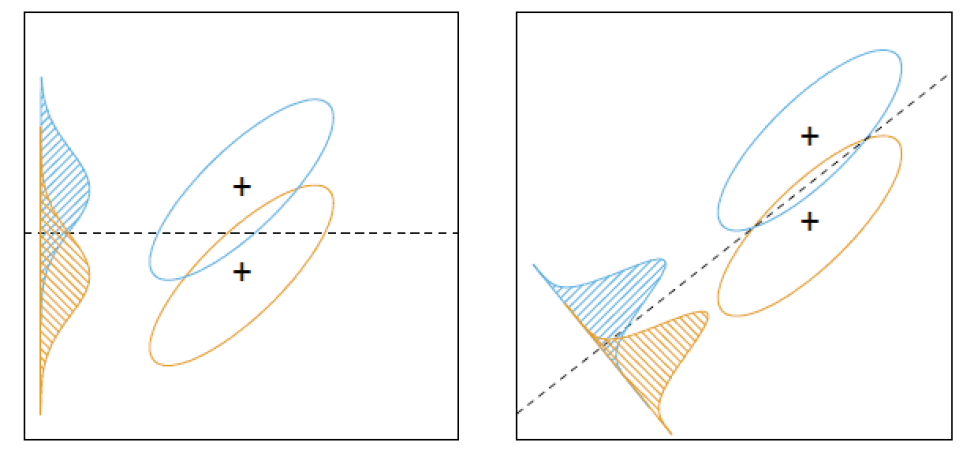

### 3.1.2 LDA的几何解释

LDA通过寻求一个最佳的投影方向,将原始数据映射到低维空间中,其目的是在新空间中将不同类别的样本点分隔得尽可能远,同时同一个类别的样本点尽可能紧凑。从几何上讲,LDA试图找到一个超平面,能够最好地区分不同类别的数据点,而保持同一类别内部的相似性。

在低维空间中,每个类别的均值点在超平面上的投影点被称为“判别点”。投影后,不同类别的判别点之间的距离最大化,这意味着通过一个简单的阈值决策规则,可以容易地区分不同类别。

在数据点的投影中,类内距离可以表示为数据点到其类别判别点的距离,而类间距离则是不同类别判别点之间的距离。LDA努力最大化的是类间距离和类内距离的比值,也就是最大化类间的分离度,从而提高分类的准确率。

## 3.2 LDA与其他降维方法的比较

### 3.2.1 主成分分析(PCA)与LDA

主

0

0