Hadoop硬件选择指南:为datanode挑选最佳硬件配置

发布时间: 2024-10-30 09:24:02 阅读量: 3 订阅数: 14

# 1. Hadoop数据节点(Datanode)概述

在数据存储和处理的宏伟画卷中,Hadoop 数据节点(Datanode)扮演着基础支撑的角色。Datanode 是 Hadoop HDFS(Hadoop Distributed File System)中的重要组成部分,它的主要职责是存储实际的数据块,执行数据的创建、删除和复制等任务。理解 Datanode 的工作原理和重要性,对于构建和维护一个高效稳定的 Hadoop 环境至关重要。

Datanode 作为 HDFS 的核心组件,需要保持高可用性和可靠性。它需要能够处理大量并发数据访问请求,并保证数据的持久性和一致性。本章节我们将深入了解 Datanode 的基本概念、工作流程以及它在 Hadoop 生态系统中的作用。我们会探讨数据节点如何通过心跳机制与主节点(NameNode)通信,以及如何管理数据块的副本,确保系统的高可用性和容错能力。

### 1.1 Hadoop数据节点的角色

在 Hadoop 集群中,Datanode 负责:

- **存储数据块**:HDFS 将大文件分割成固定大小的数据块(默认为 128MB),Datanode 负责存储这些数据块。

- **响应读写请求**:客户端通过 NameNode 了解到数据块存储在哪些 Datanode 上,之后直接与这些 Datanode 通信以读取或写入数据。

- **数据复制**:Datanode 还负责在多个节点间复制数据块,保证数据的副本数量符合设定的要求,实现数据的冗余存储。

### 1.2 Datanode的工作原理

Datanode 的工作机制大致如下:

- **初始化和启动**:启动时,Datanode 向 NameNode 注册,告知它自己存储的数据块信息。

- **心跳和块报告**:Datanode 定期向 NameNode 发送心跳包,表示它仍然活跃。同时,它还会发送一个块报告,列出它存储的所有数据块。

- **读写操作**:客户端通过 NameNode 得知数据块的位置后,直接联系相应的 Datanode 进行读写操作。

- **数据复制和恢复**:如果一个数据块的副本数量不足,NameNode 会指示一些 Datanode 创建额外的副本。如果某个 Datanode 发生故障,NameNode 会安排其他 Datanode 创建丢失的副本。

通过了解 Datanode 的角色和工作原理,我们可以更好地理解 Hadoop 如何利用大规模的廉价硬件提供可靠的存储解决方案。接下来的章节将深入探讨影响 Datanode 性能的各种因素,以及如何优化这些因素以构建出一个稳定高效的 Hadoop 集群。

# 2. 理论基础与硬件选择原则

### 2.1 Hadoop硬件性能理论基础

在Hadoop生态系统中,硬件是支撑大规模数据存储与计算的基础。理解硬件性能理论基础对于高效地搭建和优化Hadoop集群至关重要。本小节将深入探讨Hadoop的存储与计算模型,以及硬件性能如何影响整体系统的表现。

#### 2.1.1 Hadoop的存储与计算模型

Hadoop采用分布式存储和计算模型,它将数据分割成多个块(block),存储在集群中的多个数据节点(Datanode)上。MapReduce作为核心计算模型,它将任务分解为Map和Reduce两个阶段进行处理。为了支撑这种模式,硬件必须满足以下要求:

- **高吞吐量的存储系统**:由于数据块分散存储,读写操作通常需要在多个节点间并发进行,因此磁盘的I/O吞吐量必须足够高,以减少延迟和提高数据处理速度。

- **良好的网络连接**:数据节点间需要频繁交换中间计算结果,网络的带宽和延迟对性能影响巨大。

这些存储和计算模型带来的需求对硬件选择提出了具体的要求,比如高速网络接口卡、高性能磁盘阵列等。

#### 2.1.2 硬件对性能的影响分析

硬件性能直接影响到Hadoop集群的处理能力和响应速度。以下几点是硬件影响性能的主要方面:

- **CPU的处理能力**:CPU是执行任务的核心,Hadoop对CPU的要求不是特别高,但高频率的CPU可以提高MapReduce任务的处理速度。

- **内存的容量与速度**:内存用作数据缓存和任务执行过程中的临时存储,更大的内存可以让更多数据驻留在内存中,减少磁盘I/O操作,加速计算过程。

- **磁盘的类型和数量**:不同类型和数量的磁盘决定了数据读写的速率和存储的可靠性。SSD相较于HDD有更快的读写速度,但成本更高。

### 2.2 硬件选择的基本原则

选择适合Hadoop的硬件,需要在性能与成本之间取得平衡,同时考虑系统的可扩展性和维护性。

#### 2.2.1 成本效益分析

在构建Hadoop集群时,应考虑以下成本效益分析:

- **硬件成本**:硬件的初始投资与维护成本是考量的重要方面,尤其是对于大数据存储和计算,磁盘容量是成本的主要组成部分。

- **能源消耗**:高性能硬件往往伴随着高能耗,因此在长期使用过程中,能源成本需要被纳入总成本计算中。

#### 2.2.2 可扩展性与维护性考量

硬件的选择需要预留一定的可扩展性,以便未来增加容量或性能。

- **模块化设计**:可扩展性好的硬件通常采用模块化设计,允许用户根据需要逐步添加资源。

- **标准化组件**:使用标准化的硬件组件可以降低维护的复杂度和成本。

### 2.3 Hadoop集群架构对硬件的影响

Hadoop集群架构的选择对硬件配置有直接影响。本小节将探讨不同的集群架构模式以及它们对硬件的具体要求。

#### 2.3.1 集群架构模式对比

不同的集群架构模式适合不同的业务场景,因此硬件配置也会有所差异。

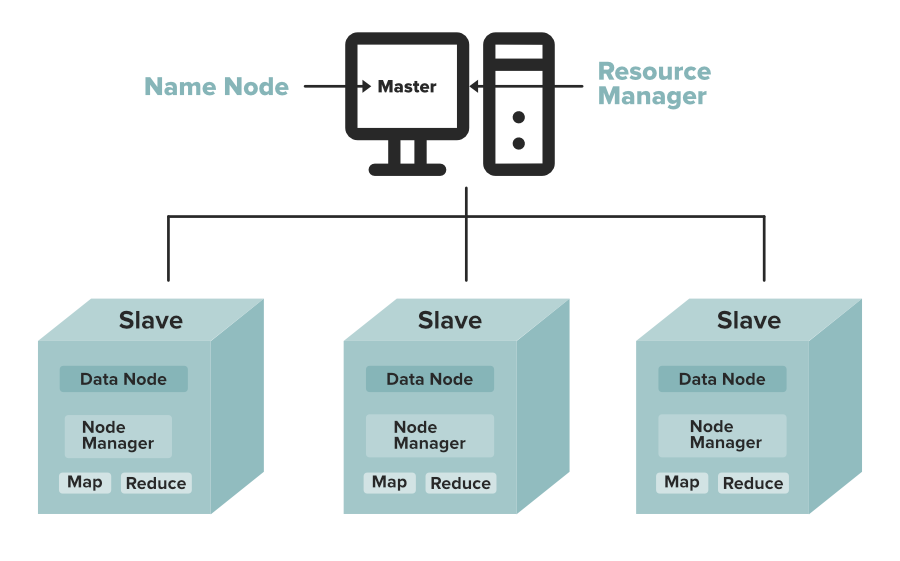

- **Hadoop经典架构**:由Master节点和多个Slave节点组成,Master节点主要负责协调工作,Slave节点负责数据存储和计算。

- **YARN架构**:引入了资源管理器(ResourceManager)和节点管理器(NodeManager),对硬件的处理能力有更高的要求。

#### 2.3.2 集群规模对硬件的需求

随着集群规模的扩大,硬件需求也会相应增长。

- **小规模集群**:适合研究和测试,硬件需求不高,但为了保证数据的可靠性,至少需要三个数据节点。

- **大规模集群**:面向生产环境,需要高性能的CPU、大容量内存以及高性能的存储系统来支撑海量数据处理。

由于Hadoop的硬件选择原则与架构模式紧密相关,理解硬件性能理论基础是选择合适硬件的前提。在下一章节,我们将更深入地探讨核心硬件组件的选择与配置,以及如何根据实际业务需求进行合理规划。

# 3. 核心硬件组件选择与配置

## 3.1 处理器(CPU)的选择与配置

### 3.1.1 CPU性能与核心数的重要性

在构建高效能的Hadoop数据节点时,选择合适的处理器(CPU)是关键因素之一。CPU是执行所有计算任务的核心,其性能直接影响到数据节点处理数据的效率。核心数(核心数即为CPU内所含处理核心的数量)的多少决定了CPU处理多个任务的能力。

在选择CPU时,我们需要考虑数据节点将要执行的任务类型。对于高计算强度的任务,一个具有更高时钟频率的CPU将更有助于提升性能,因为时钟频率(通常以GHz为单位)直接反映了CPU的处理速度。相反,如果任务更多的是并行处理,那么拥有更多核心的CPU将是更好的选择。在并行处理场景中,更多的核心可以让数据节点同时处理更多的计算任务,从而提升整体的效率。

### 3.1.2 高频率CPU与多核心CPU的比较

高频率CPU通常可以提供更快的执行速度,适合执行单个或少数几个计算密集型任务。它可以让单个任务的响应时间显著缩短。然而,对于需要同时处理多个任务的情况,核心数量多的CPU可以提供更好的并行处理能力。多核心CPU通过分散计算负

0

0