【自编码器大数据挑战应对】

发布时间: 2024-09-05 18:18:48 阅读量: 54 订阅数: 22

# 1. 自编码器在大数据中的作用和挑战

在数据科学领域,自编码器(Autoencoder)已成为处理大数据的重要工具之一。自编码器通过无监督学习的方式,能够有效提取数据中的特征,并将其压缩到更小的维度,这对于大数据分析来说具有极大的应用价值。然而,随着数据量的增加,如何使自编码器更高效地处理数据,同时保持信息的完整性和准确性,成为了一个重要的挑战。

## 1.1 自编码器在数据处理中的优势

自编码器的核心优势在于其能够自动学习数据的内在结构。与传统的数据降维技术(如PCA)相比,自编码器可以捕捉非线性关系,更适合复杂数据结构的处理。在处理大规模数据集时,自编码器显示出较强的泛化能力和鲁棒性,能有效提取有用信息,为后续的数据分析和模式识别打下基础。

## 1.2 自编码器面临的挑战

尽管自编码器在处理大数据方面展现出巨大潜力,但它们也面临多方面的挑战。例如,数据的噪声和异常值可能会影响自编码器的学习效果,导致重构数据的质量下降。此外,选择合适网络结构和超参数设定,以及避免过拟合等也是在应用自编码器时需要解决的问题。此外,大数据环境下的计算资源消耗也是一个不容忽视的因素,这需要我们找到更高效的训练算法和优化策略。

## 1.3 自编码器的优化方向

针对上述挑战,自编码器的优化方向主要集中在模型结构设计、训练算法改进以及计算资源优化等方面。例如,引入正则化项、使用更先进的优化器(如Adam),或是采用分布式计算技术,都可以在一定程度上提高自编码器在大数据环境下的性能。研究者也在尝试将自编码器与其他深度学习技术结合起来,例如生成对抗网络(GAN)和变分自编码器(VAE),以求达到更好的数据表达和压缩效果。

# 2. 自编码器的基础理论和模型构建

自编码器(Autoencoder)是一种无监督的深度学习模型,它通过学习输入数据的高效表示(编码)来进行数据压缩,或者重构输入数据本身。在数据挖掘、模式识别和大数据分析等领域有着广泛的应用。本章将深入探讨自编码器的基础理论,包括它的定义、原理以及与其它神经网络的比较。同时,针对不同类型自编码器的特点和适用场景进行比较,讨论模型选择的标准和方法,并详细介绍训练和优化过程中需要关注的关键技术和优化策略。

### 2.1 自编码器的基本概念

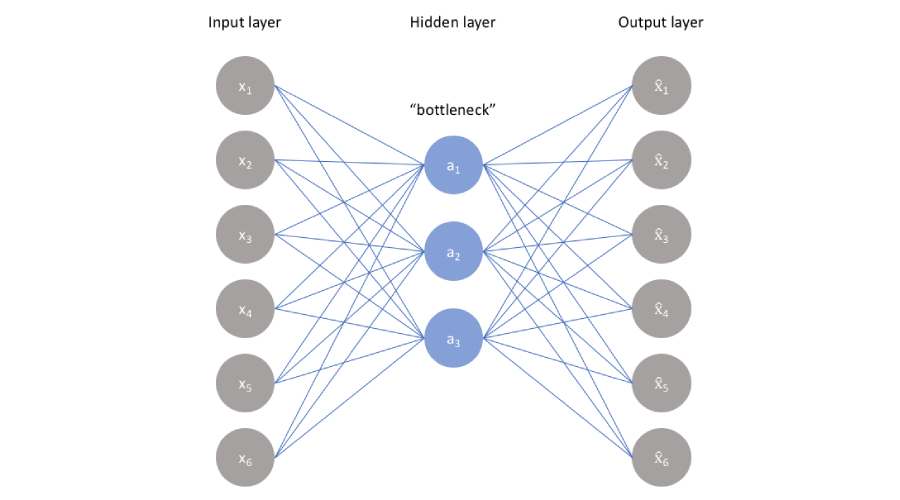

#### 2.1.1 自编码器的定义和原理

自编码器是一种特殊的前馈神经网络,它的目标是使输出尽可能地复现输入,通常是通过一个低维的隐藏层来捕捉输入数据的特征。基本的自编码器包括编码器(encoder)和解码器(decoder)两部分。编码器负责将输入数据压缩成一个内部表示(即编码),而解码器则将这个内部表示重构回原始输入数据。

数学上,设输入数据为 \( x \in \mathbb{R}^n \),编码器 \( f \) 和解码器 \( g \) 分别映射输入数据到低维表示 \( z \in \mathbb{R}^d \) 和从低维表示重构到输出数据 \( \hat{x} \in \mathbb{R}^n \)。优化的目标是最小化输入和输出之间的差异,常用损失函数为均方误差(MSE):

\[ \mathcal{L}(x, \hat{x}) = ||x - \hat{x}||^2 \]

自编码器的训练过程是一个迭代过程,不断通过反向传播算法调整网络权重,最小化上述损失函数。

#### 2.1.2 自编码器与其他神经网络的比较

自编码器与传统的神经网络有所区别,特别是在目标函数和训练方式上。比如,与用于分类的卷积神经网络(CNN)或用于序列分析的循环神经网络(RNN)不同,自编码器的目标函数不是分类或者回归的损失函数,而是输入和输出之间的重构误差。此外,自编码器是一种无监督学习模型,不需要标签数据,其训练数据是未标记的原始数据。

自编码器也常与生成对抗网络(GAN)相比较。尽管两者都是通过学习输入数据的分布来实现数据处理,但GAN依赖于一个判别器网络来引导生成器网络,而自编码器主要通过编码和解码过程来学习输入数据的内在结构。

### 2.2 自编码器的模型类型和选择

#### 2.2.1 不同类型自编码器的特点和适用场景

自编码器有多种不同的类型,包括基础自编码器、稀疏自编码器、去噪自编码器和变分自编码器等。每种类型根据其结构和训练过程,具有不同的特点和适用场景。

- **基础自编码器**:最简单的自编码器结构,适合基础的数据压缩和特征提取任务。

- **稀疏自编码器**:引入稀疏性惩罚项到损失函数中,使得隐藏层节点在训练过程中保持稀疏激活,有助于学习更具判别力的特征表示。

- **去噪自编码器**:通过向输入数据添加噪声,并训练自编码器以学习恢复原始数据,增强模型的鲁棒性和泛化能力。

- **变分自编码器(VAE)**:引入随机潜在变量,通过最大化重构数据的似然率和潜在空间分布的平滑性,实现数据的生成和压缩。

选择哪种类型的自编码器取决于具体的应用需求,例如需要处理的噪声水平、对压缩比的要求以及是否需要数据生成能力等。

#### 2.2.2 模型选择的标准和方法

模型选择的标准和方法需要根据任务特性和数据特点来决定。在选择自编码器模型时,通常考虑以下因素:

- **数据特性**:例如数据是否含有噪声、数据维度大小等,对选择模型类型有直接影响。

- **任务目标**:是否需要数据重建、压缩比要求有多高,或者是否关注生成模型。

- **计算资源**:不同类型和大小的自编码器对计算资源的需求不同,需要根据实际情况进行权衡。

在实际应用中,一般通过交叉验证等模型评估方法来确定最佳的自编码器模型。此外,预处理步骤(如标准化、去噪)也对模型性能有着显著影响,应该在选择模型之前考虑。

### 2.3 自编码器的训练和优化

#### 2.3.1 训练过程中的关键技术

自编码器的训练过程涉及到多个关键技术,包括数据预处理、权重初始化、优化器的选择和正则化等。

- **数据预处理**:标准化输入数据可以帮助加速收敛并提高模型的泛化能力。

- **权重初始化**:良好的权重初始化策略有助于避免梯度消失或爆炸问题,常用的初始化方法包括Xavier和He初始化。

- **优化器的选择**:优化器是影响模型收敛速度和性能的关键因素。常见的优化器包括SGD、Adam和RMSprop等。

- **正则化**:为了防止过拟合,常用的技术包括L1和L2正则化、Dropout等。

#### 2.3.2 优化策略和常见问题解决

在自编码器的优化过程中,通常会遇到过拟合、梯度消失或爆炸等问题。为了解决这些问题,可以采用以下策略:

- **提前停止**:在验证集上监控性能,一旦发现性能不再提升则停止训练。

- **学习率衰减**:在训练过程中逐步降低学习率,有助于模型在优化过程后期精细化调整。

- **批量归一化(Batch Normalization)**:在训练过程中标准化每一批次的输入数据,有助于稳定学习过程。

- **自编码器的正则化变体**:比如稀疏自编码器和去噪自编码器,通过引入额外的约束条件来提升模型的泛化能力。

通过上述策略的综合使用,可以有效地提升自编码器模型的性能,并解决在训练过程中遇到的常见问题。

# 3. 自编码器的大数据实践应用

在大数据的浪潮中,自编码器不仅是一个理论上的模型,它在实际应用中也展现出了巨大的价值。通过前面章节对自编码器原理和模型的介绍,本章将深入探讨自编码器在大数据中的实践应用,着重于其在数据去噪、特征提取和数据压缩这三方面的具体应用和案例分析。

## 3.1 自编码器在数据去噪中的应用

数据去噪是一个将信号中的噪声去除的过程,目的是获得更纯净的数据信号。自编码器作为一种强大的特征学习工具,在数据去噪方面表现出了其独特的优势。

### 3.1.1 数据预处理的去噪原理

在数据预处理阶段,去噪的目的在于提高数据的质量,从而使得后续的分析工作更加准确和高效。自编码器利用其编码器部分对输入数据进行压缩,再通过解码器部分重构数据,从而实现对噪声的有效过滤。其核心在于训练过程中,自编码器学习到的是输入数据的潜在特征,而非噪声。因此,在重构阶段,噪声成分相对较低,以此达到去噪的目的。

### 3.1.2 实际数据去噪案例分析

在实际应用中,数据去噪通常涉及到大量的非结构化数据,比如语音信号、图像数据等。例如,在处理遥感图像数据时,噪声可能来自于多种干扰,包括大气扰动、设备缺陷等。下面的代码示例展示了如何使用自编码器对图像进行去噪处理:

```python

import numpy as np

from keras.layers import Input, Dense

from keras.models import Model

# 假设输入数据是已经加载并且被处理成适合神经网络输入的格式

input_dim = 784 # 以MNIST数据集为例,每张图像是28*28像素,展平后是784个元素

encoding_dim = 32 # 假设编码后的数据是32维

# 此为一个简单的自编码器模型

input_img = Inp

```

0

0