【自编码器项目构建经验】

发布时间: 2024-09-05 18:00:05 阅读量: 38 订阅数: 22

# 1. 自编码器的理论基础与应用

## 自编码器简介

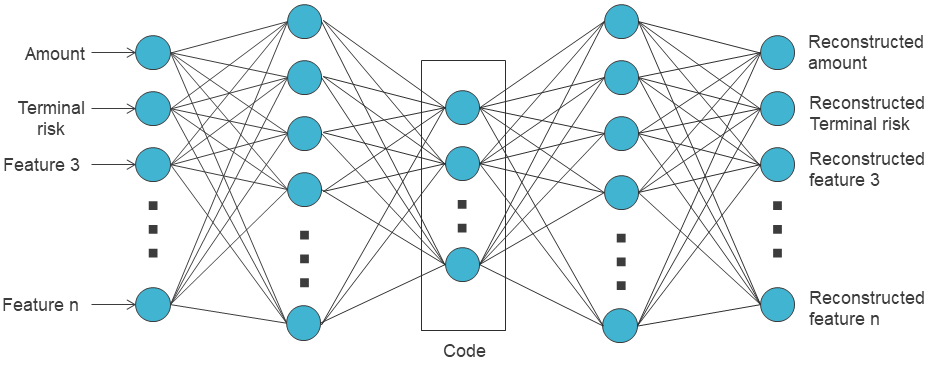

自编码器是一种无监督的神经网络,它通过学习输入数据的压缩表示来进行特征学习。核心思想是将原始数据编码成一种内部表示,再解码回数据本身,从而实现数据的降维或特征提取。

## 基本原理

自编码器由编码器(encoder)和解码器(decoder)两部分组成。编码器的作用是将输入数据转换为一个压缩的表示形式,而解码器则将这个压缩形式再转换回与原始输入尽可能相似的数据。其训练过程通过最小化重构误差来实现,常用的损失函数有均方误差(MSE)或交叉熵。

## 应用领域

自编码器在各种数据处理领域中都有应用,如图像去噪、异常检测、数据压缩等。它特别适用于数据降维,可以用于学习数据的有效表示,从而在监督学习任务中提高性能。通过适当的调整和优化,自编码器还能应用于更加复杂的数据结构,如视频帧、声音信号等。

# 2. 构建自编码器前的准备工作

自编码器(Autoencoder)是一种广泛使用的无监督学习网络结构,用于学习输入数据的高效表示。在正式构建自编码器模型之前,需要进行一系列准备工作,包括数据的收集与预处理、环境搭建与工具选择等。

### 2.1 数据收集与预处理

在开始构建自编码器模型之前,数据是构建任何机器学习模型的基石。数据收集和预处理是构建高效自编码器模型的重要步骤。

#### 2.1.1 数据的收集途径和方法

收集数据是任何数据驱动模型的第一步。对于自编码器而言,高质量的数据收集尤为重要,因为它是模型学习的基础。

- **网络爬虫**: 这是获取大量在线数据的常用方法,通过编写脚本来自动化地从网站上抓取数据。

- **开放数据集**: 互联网上存在着大量开放的数据集,它们通常由研究机构、政府或企业公开发布,可以利用这些现成的数据集来训练模型。

- **API**: 许多在线服务提供了API接口,可以直接从应用程序中获取数据,例如社交媒体平台、金融市场数据等。

数据收集过程中,确保数据的多样性和质量至关重要,因为这直接影响到模型的泛化能力。

#### 2.1.2 数据清洗和预处理技巧

在收集了原始数据后,接下来需要进行数据清洗和预处理。这一步骤会直接影响到自编码器训练过程的稳定性和模型的性能。

- **异常值处理**: 异常值可能会对模型的性能产生负面影响,需要通过统计方法(如 Z-score、IQR)识别并处理这些异常值。

- **归一化/标准化**: 数据往往需要被缩放到一个标准的范围,比如从0到1之间,或者符合一定的标准分布,以加速模型的收敛速度。

- **数据增强**: 在某些情况下,数据量可能不足。数据增强可以通过改变现有数据的某些属性来人为增加数据集的大小和多样性。

数据预处理完成后,可以确保输入到自编码器的数据是整洁和一致的,这对于后续模型的训练和验证至关重要。

### 2.2 环境搭建与工具选择

构建自编码器模型时,选择合适的编程语言和深度学习框架是十分重要的。此外,合理配置计算资源对于模型的训练效率也有显著的影响。

#### 2.2.1 选择合适的编程语言和库

在搭建深度学习项目时,通常会从几种流行的语言中选择:Python、C++或Java等。

- **Python**: 由于其简洁易读的语法和丰富的数据科学库(如NumPy、Pandas、SciPy),Python成为最流行的机器学习语言之一。

- **TensorFlow/Keras** 和 **PyTorch**: 这是目前深度学习领域内最流行的两个框架。TensorFlow由谷歌开发,支持静态图计算;而PyTorch由Facebook开发,支持动态图计算,具有更直观的接口。

#### 2.2.2 配置深度学习框架和环境

在确定了编程语言和深度学习库之后,下一步是配置开发环境,确保可以顺利进行模型开发。

- **安装依赖**: 通过包管理工具(如Python的pip)安装深度学习框架及相关依赖。

- **设置虚拟环境**: 使用虚拟环境(如Python的venv或conda)可以隔离项目依赖,避免不同项目之间的依赖冲突。

#### 2.2.3 资源管理与分配

在模型训练过程中,合理地分配和管理计算资源是提高效率的关键。

- **GPU/TPU支持**: 对于大规模的深度学习任务,使用GPU或TPU可以大幅提高训练速度。

- **分布式训练**: 当数据集非常庞大时,可以通过分布式训练来分散计算任务,从而加快训练速度。

通过以上步骤,我们可以确保在构建自编码器模型之前,已经做好了充分的准备。接下来,就可以开始设计自编码器的架构,并进行模型训练了。

# 3. 自编码器模型的构建与训练

## 3.1 自编码器架构设计

### 3.1.1 确定编码器和解码器的结构

自编码器(Autoencoder, AE)是一种无监督的神经网络,它通过学习输入数据的压缩表示来进行特征学习。其基本结构由编码器(Encoder)和解码器(Decoder)组成。编码器将输入数据编码成一个低维表示(隐层),而解码器则将这个低维表示重建回原始输入数据。

在设计编码器和解码器时,需要考虑的因素包括网络深度、激活函数、网络宽度等。通常,编码器和解码器的网络结构是镜像对称的,即解码器的每一层与编码器的对应层神经元数量相同,但方向相反。例如,如果编码器的第一层有512个神经元,则解码器的最后一层也应有512个神经元。

**代码块示例**:

```python

from tensorflow.keras.layers import Input, Dense

from tensorflow.keras.models import Model

# 定义编码器和解码器的结构

encoding_dim = 32 # 编码后的维度

# 输入层

input_img = Input(shape=(784,))

encoded = Dense(128, activation='relu')(input_img)

encoded = Dense(64, activation='relu')(encoded)

encoded = Dense(encoding_dim, activation='relu')(encoded) # 编码器输出

# 复制编码器的输出作为解码器的输入

decoded = Dense(64, activation='relu')(encoded)

decoded = Dense(128, activation='relu')(decoded)

decoded = Dense(784, activation='sigmoid')(decoded) # 解码器输出

# 创建自编码器模型

autoencoder = Model(input_img, decoded)

```

### 3.1.2 损失函数和优化器的选择

在训练自编码器时,一个关键的决定是选择合适的损失函数和优化器。对于大多数重建任务,常用的损失函数是均方误差(MSE)或交叉熵损失。均方误差适用于连续值数据(如图像像素值),而交叉熵损失则适用于分类问题。

优化器的选择取决于具体任务和网络结构,常见的优化器包括SGD、Adam和RMSprop等。Adam优化器通常是一个不错的选择,因为它结合了RMSprop和动量优化的优点。

**代码逻辑分析**:

在上述代码中,我们构建了一个简单的自编码器模型,使用了连续的三个全连接层(Dense层)来实现编码器和解码器。在定义模型时,我们使用了`Model`类,它接受输入和输出层作为参数,以创建训练过程中的自编码器。

## 3.2 模型训练过程

### 3.2.1 训练数据的划分与批次处理

在训练模型之前,需要将数据集划分为训练集和验证集。批次处理是深度学习中常用来提高内存效率和模型泛化能力的一种技术。通常情况下,批次(batch)是数据集的一个子集,模型在每个训练周期(epoch)中使用一个批次的数据进行一次权重更新。

**代码块示例**:

```python

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

# 加载MNIST数据集

(x_train, _), (x_test, _) = mnist.load_data()

# 数据预处理:归一化、重塑

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

x_train = x_train.reshape((len(x_train), np.prod(x_train.shape[1:])))

x_test = x_test.reshape((len(x_test), np.prod(x_test.shape[1:])))

x_train = to_categorical(x_train)

x_test = to

```

0

0