【CART决策树的Python实现】:使用scikit-learn构建决策树

发布时间: 2024-09-04 14:41:34 阅读量: 45 订阅数: 28

# 1. 决策树算法简介

决策树算法是一种基本的分类与回归方法,它模仿人类的决策过程,将数据集划分成不同规则的分支,形成树形结构。这种算法直观且易于理解,广泛应用于数据挖掘和机器学习领域。其核心思想是通过选择特征进行数据划分,从而最大化分类或预测的准确度。决策树算法包括ID3、C4.5和CART等多种变体。本章将重点介绍决策树的理论基础,并对比这些算法的特点,为进一步深入了解CART算法打下坚实的基础。

# 2. CART算法基础与理论

### 2.1 CART算法的概念和原理

#### 2.1.1 决策树的构建过程

分类与回归树(CART)算法是一种经典的决策树学习方法,它通过递归地选择最优特征并对数据进行分割,构建二叉决策树。在CART算法中,决策树的构建过程可以概括为以下四个基本步骤:

1. **数据准备和预处理**:选择合适的训练数据集,并进行数据清洗、特征选择、编码转换等预处理步骤,为树的构建打下基础。

2. **树的生长**:从根节点开始,递归地对每个节点应用分裂标准,选择最优特征并对数据进行二分,形成左子树和右子树。

3. **树的剪枝**:为了避免过拟合,需要在树生长的过程中或之后对树进行剪枝,移除一些没有显著提升模型泛化能力的分支。

4. **模型评估与优化**:利用交叉验证等方法对决策树模型进行评估,并根据评估结果调整模型参数,优化模型性能。

#### 2.1.2 CART算法的特点和优势

CART算法主要有以下几个特点和优势:

- **二叉树结构**:CART构建的是二叉决策树,相比于多叉树而言,更易于理解和实现。

- **递归分裂**:CART使用递归的方法对特征进行分裂,每次分裂都是在最优特征和最优分裂点上进行,确保了树结构的优化。

- **分类与回归通用**:CART算法不仅可以用于分类问题,还可以通过回归树解决回归问题。

- **剪枝策略**:CART通过剪枝来避免过拟合,提供了一种有效控制模型复杂度的方法。

- **可解释性**:决策树模型具有较高的可解释性,能够通过树形结构清晰地展示决策过程。

### 2.2 决策树的数学模型

#### 2.2.1 树结构表示

在数学上,决策树可以看作是一个条件概率模型,树的每个节点对应一个条件概率分布。在CART算法中,决策树被表示为一个嵌套的if-else决策规则集:

- 根节点对应于整个样本集。

- 每个内部节点对应于对某个特征的测试,该测试将样本划分为两个子集。

- 每个叶节点对应于最终的决策结果。

树结构可以表示为:

```

决策树 = (节点集合, 边集合, 叶节点集合)

```

其中,节点集合包含所有非叶节点和叶节点,边集合代表节点间的连接关系,叶节点集合包含了所有可能的决策结果。

#### 2.2.2 节点分裂的数学原理

节点分裂是一个关键步骤,其目标是选择最合适的特征和分裂点,使得分裂后子节点的纯度提高。纯度的衡量通常使用基尼不纯度(Gini impurity)或者信息增益(Entropy)等指标。

以基尼不纯度为例,对于一个给定的节点N,其基尼不纯度计算公式为:

```

Gini(N) = 1 - Σ(p(i)²)

```

其中,`p(i)`是节点N中第i类样本所占的比例。基尼不纯度越小,表示节点的纯度越高。

### 2.3 CART算法的决策规则

#### 2.3.1 二叉树的生成

CART算法在每次分裂时都产生两个子节点,这与ID3或C4.5等多叉树算法不同。在CART中,分裂的标准不仅要求子节点的纯度提高,还要求能够最大化左右子节点之间的不纯度差异。

分裂的具体过程可以概括为:

1. **遍历特征**:遍历所有特征,对于数值型特征,尝试每一个可能的分裂值;对于类别型特征,尝试每一个可能的分类方式。

2. **计算分裂点**:对于每个特征,计算可能的分裂点,并计算由此分裂引起的不纯度减少量。

3. **选择最佳分裂**:选择使不纯度减少最多的特征和分裂点作为当前节点的分裂标准。

4. **递归分裂**:对左右子节点重复上述过程,直到满足停止条件。

#### 2.3.2 决策规则的优化

CART算法构建决策树的过程不是一蹴而就的,需要对决策规则进行优化,以得到最佳的模型表现。优化的主要手段包括:

- **剪枝**:通过预剪枝或后剪枝策略去除不必要的分支,避免过拟合现象。

- **参数调整**:调整如树的深度、最小分裂样本数、最小叶节点样本数等超参数,来控制树的复杂度和泛化能力。

- **集成学习**:通过随机森林等集成学习方法,组合多个决策树的预测结果,以提高模型的准确性和鲁棒性。

以上章节详细介绍了CART算法的基础知识和理论,接下来的章节会探讨如何在Python中实践CART算法,以及一个具体的案例分析。

# 3. Python与scikit-learn简介

Python作为一种编程语言,在数据分析中扮演着极为重要的角色。由于其简洁明了的语法和强大的库支持,使得Python逐渐成为数据科学领域的首选语言。本章将从Python在数据分析中的作用、scikit-learn库的概述以及使用scikit-learn进行数据预处理等方面,系统介绍Python及其库在构建CART决策树模型中的应用。

## 3.1 Python在数据分析中的作用

### 3.1.1 Python的数据分析生态

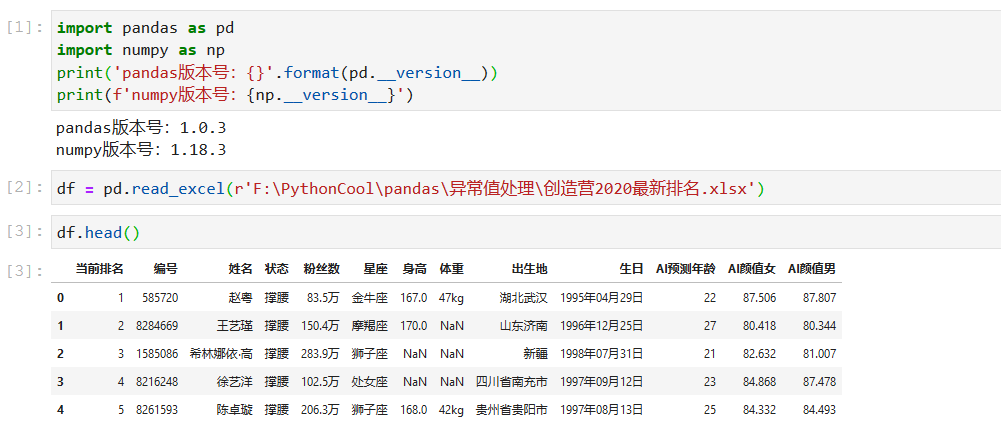

Python之所以能在数据分析领域中获得如此广泛的青睐,很大程度上得益于其强大的社区支持和丰富的数据处理库。其中,Pandas库提供了高效的数据结构和数据分析工具,NumPy库用于高效地进行数值计算,而Matplotlib和Seaborn库则为数据可视化提供了便利。此外,IPython和Jupyter Notebook为交互式数据分析提供了友好的界面。

```python

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# 示例:使用Pandas读取CSV文件数据

data = pd.read_csv('data.csv')

# 使用NumPy创建一个数组

array = np.array([1, 2, 3, 4, 5])

# 使用Matplotlib绘制一个简单的图形

plt.plot(array)

plt.show()

# 使用Seaborn查看数据集的分布情况

sns.displot(data['column_name'])

```

### 3.1.2 Python的数据结构和类型

Python的数据结构丰富多样,包括列表(List)、元组(Tuple)、字典(Dictionary)和集合(Set),这些结构对于处理不同类型的数据非常有帮助。列表和元组是序列类型,可以包含任意的数据类型,而字典则是一个键值对集合。在数据分析中,字典可以用来存储列名和数据对应关系,从而方便地处理数据集中的字段。

```python

# 列表示例

list_example = [1, 2, 3, 'a', 'b', 'c']

# 元组示例

tuple_example = (1, 2, 3)

# 字典示例

dict_example = {'one': 1, 'two': 2, 'three': 3}

# 集合示例

set_example = {1, 2, 3, 4, 5}

```

## 3.2 scikit-learn库概述

### 3.2.1 scikit-learn的功能和模块

scikit-learn是一个开源的机器学习库,它提供了大量的算法和工具,用于数据挖掘和数据分析。主要功能包括分类、回归、聚类算法以及数据预处理等。scikit-learn的设计遵循着一

0

0