可解释人工智能:如何评估和选择可解释模型:打造符合需求的可解释解决方案

发布时间: 2024-08-22 23:40:27 阅读量: 51 订阅数: 35

2021最新直播系统+短视频源码+教程+演示APP+开发文档+IOS与安卓源码

# 1. 可解释人工智能概述**

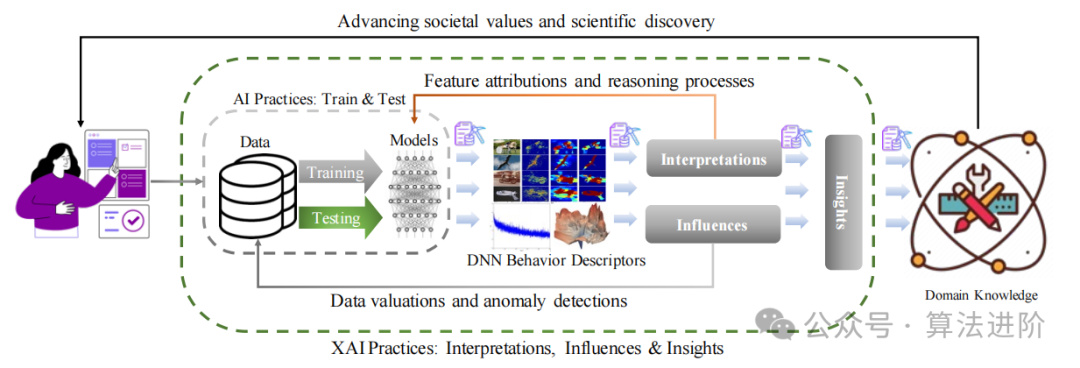

可解释人工智能 (XAI) 是人工智能 (AI) 的一个子领域,它专注于开发和部署能够解释其决策和预测的 AI 模型。XAI 对于建立对 AI 系统的信任和理解至关重要,因为它使利益相关者能够了解模型如何工作以及为什么做出特定决策。

XAI 具有广泛的应用,包括医疗保健、金融和制造业。在医疗保健中,XAI 可以帮助医生理解 AI 模型如何做出诊断,从而提高决策的透明度和可信度。在金融业,XAI 可以帮助银行和金融机构解释风险评估和欺诈检测模型,从而提高决策的公平性和可审计性。

# 2. 评估可解释模型的指标

### 2.1 可解释性指标的类型

可解释性指标用于评估可解释模型的性能,分为局部可解释性指标和全局可解释性指标两类。

#### 2.1.1 局部可解释性指标

局部可解释性指标衡量单个预测的解释性,适用于解释个别实例的预测结果。

- **SHAP 值(SHapley Additive Explanations):**度量每个特征对预测的影响,表示为每个特征的加权和。

- **LIME(Local Interpretable Model-Agnostic Explanations):**通过局部线性模型来解释预测,生成一个简化的模型来解释单个预测。

- **ICE(Individual Conditional Expectation):**计算预测值在给定特征条件下的期望值,展示特征对预测的影响。

#### 2.1.2 全局可解释性指标

全局可解释性指标衡量整个模型的解释性,适用于评估模型对整体数据集的解释能力。

- **FID(Feature Importance):**衡量每个特征对模型预测的影响,通常使用信息增益或基尼不纯度等度量。

- **Fidelity:**度量模型预测与真实值的相似性,通常使用均方误差或准确率等度量。

- **Stability:**衡量模型预测在小扰动下的稳定性,通过比较不同数据集或特征扰动下的预测结果来评估。

### 2.2 可解释性指标的比较和选择

可解释性指标的选择取决于模型类型、任务要求和可解释性需求。

| 指标类型 | 优点 | 缺点 |

|---|---|---|

| 局部可解释性 | 解释个别预测 | 计算成本高 |

| 全局可解释性 | 评估整体模型 | 无法解释个别预测 |

在选择指标时,需要考虑以下因素:

- **任务类型:**分类模型需要不同的指标来评估解释性,例如准确率和召回率。

- **模型复杂度:**复杂的模型可能需要更复杂的指标来评估解释性。

- **可解释性需求:**不同的业务目标和监管要求对可解释性有不同的要求。

例如,在医疗保健领域,需要局部可解释性指标来

0

0