揭秘可解释人工智能:如何让机器学习模型说出自己的理由:赋能决策,提升信任

发布时间: 2024-08-22 23:27:29 阅读量: 31 订阅数: 27

# 1. 可解释人工智能概述

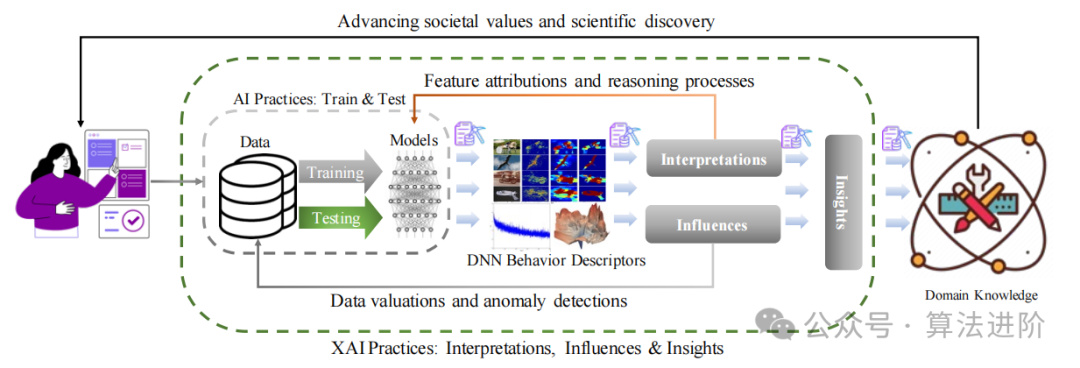

可解释人工智能(XAI)是人工智能(AI)的一个分支,它旨在开发和部署能够解释其决策过程的AI模型。与传统的AI模型不同,XAI模型能够提供对模型预测的见解,从而增强对模型行为的理解和信任。

XAI在各个领域具有广泛的应用,包括医疗保健、金融和制造业。通过提供可解释的决策,XAI可以提高决策的透明度,增强对AI系统的信心,并促进人工智能的道德发展。

# 2. 可解释人工智能的理论基础

### 2.1 可解释性定义和分类

可解释性是指模型能够以人类可以理解的方式解释其决策过程和结果。可解释人工智能(XAI)旨在开发和部署可解释的机器学习模型,以提高模型的透明度、可信度和可接受性。

可解释性可分为以下几个层次:

- **可理解性:**模型的决策过程和结果可以被人类理解。

- **可解释性:**模型可以提供有关其决策原因的解释。

- **可预测性:**模型可以预测其决策结果。

### 2.2 可解释模型的类型

可解释模型可分为两类:

#### 2.2.1 局部可解释模型

局部可解释模型解释单个预测。它们包括:

- **决策树:**以树形结构表示决策过程,易于理解和解释。

- **规则集:**将预测表示为一组规则,易于理解和解释。

- **线性模型:**预测是输入变量的线性组合,易于解释系数。

#### 2.2.2 全局可解释模型

全局可解释模型解释整个模型的行为。它们包括:

- **SHAP(Shapley Additive Explanations):**计算每个特征对预测的影响,提供全局解释。

- **LIME(Local Interpretable Model-Agnostic Explanations):**在局部扰动数据的基础上构建简单模型,提供局部解释。

- **Anchors:**识别对预测影响最大的数据子集,提供全局解释。

### 2.3 可解释性评估指标

评估可解释模型的指标包括:

- **准确性:**模型的预测准确度。

- **可解释性:**模型解释的清晰度和可理解性。

- **可信度:**模型解释的可靠性和可信度。

- **效率:**生成解释所需的时间和计算资源。

#### 代码示例:

```python

import shap

# 训练一个线性回归模型

model = LinearRegression()

model.fit(X_train, y_train)

# 计算SHAP值

explainer = shap.Explainer(model)

shap_values = explainer.shap_values(X_test)

# 可视化SHAP值

shap.plots.waterfall(shap_values)

```

#### 逻辑分析:

SHAP值计算每个特征对预测的影响。瀑布图可视化SHAP值,显示每个特征对预测的正负贡献。

#### 参数说明:

- `model`:要解释的模型。

- `X_train`:训练数据特征。

- `y_train`:训练数据标签。

- `X_test`:测试数据特征。

# 3.1 可解释机器学习模型的构建

#### 3.1.1 模型选择和训练

在构建可解释机器学习模型时,模型选择至关重要。不同的模型类型具有不同的可解释性特征。对于局部可解释模型,如决策树和规则集,它们的决策过程相对容易理解。对于全局可解释模型,如线性回归和逻辑回归,它们的系数或权重可以提供对模型行为的洞察。

训练数据的选择和准备也对模型的可解释性有影响。训练数据应代表目标域,并且不应包含噪音或异常值。特征工程技术,如特征选择和降维,可以帮助去除不相关的或冗余的特征,从而提高模型的可解释性。

#### 3.1.2 可解释性方法的应用

一旦训练了机器学习模型,就可以应用可解释性方法来提取其决策背后的原因。这些方法可以分为两类:

* **局部可解释性方法**:这些方法解释单个预测或实例的决策。常见的局部可解释性方法包括:

* **SHAP (Shapley Additive Explanations)**:一种基于博弈论的方法,计算每个特征对预测的影响。

* **LIME (Local Interpretable Model-Agnostic Explanations)**:一种基于扰动的方法,通过创建局部线性模型来解释预测。

* **决策树解释**:对于决策树模型,可以通过可视化决策路径和计算特征重要性来解释其决策。

* **全局可解释性方法**:这些方法解释整个模型的决策过程。常见的全局可解释性方法包括:

* **特征重要性**:计算每个特征对模型预测的影响,从而识别最重要的特征。

* **偏倚-方差权衡**:分析模型的偏倚和方差,以了解模型的泛化能力。

* **可视化**:使用图表和图形来可视化模型的决策过程,如决策边界和特征交互。

### 3.2 可解释性报告的生成

#### 3.2.1 可解释性结果的呈现

可解释性报告是将可解释性结果传达给利益相关者的文档。报告应清晰简洁,并根据受众的知识水平进行定制。可解释性结果可以以多种方式呈现,包括:

* **文本解释**:使用自然语言描述模型的决策过程。

* **可视化**:使用图表和图形来可视化模型的决策边界、特征交互和特征重要性。

* **交互式工具**:允许用户探索模型的决策过程并生成自己的解释。

#### 3.2.2 可解释性报告的解读

可解释性报告的解读需要对可解释性方法和机器学习模型有深入的理解。解读报告时应考虑以下因素:

* **模型的可解释性水平**:不同的模型类型具有不同的可解释性水平。局部可解释模型更容易解释,而全局可解释模型可能需要更复杂的解释。

* **可解释性方法的局限性**:可解释性方法并不能总是完全解释模型的决策过程。重要的是要了解方法的局限性并谨慎解释结果。

* **利益相关者的知识水平**:可解释性报告应根据利益相关者的知识水平进行定制。对于技术受众,可以提供更详细的技术解释。对于非技术受众,可以提供更简单的解释。

# 4. 可解释人工智能在决策中的应用

### 4.1 可解释人工智能赋能决策

可解释人工智能通过提供对模型决策过程的深入理解,为决策者赋能,使其能够:

#### 4.1.1 提升决策透明度

可解释人工智能使决策者能够了解模型如何得出其结论。这提高了决策的透明度,使决策者能够:

- **识别模型偏差:**可解释人工智能可以揭示模型中可能存在的偏差或偏见,从而帮助决策者避免做出不公平或歧视性的决策。

- **建立信任:**通过提供对模型决策过程的清晰理解,可解释人工智能可以建立决策者对模型的信任,从而提高决策的接受度。

#### 4.1.2 增强决策信心

可解释人工智能通过提供证据来支持模型的决策,从而增强决策者的信心。这使得决策者能够:

- **做出明智的决定:**通过了解模型的推理过程,决策者可以做出更加明智的决定,因为他们可以评估模型决策的合理性。

- **减少不确定性:**可解释人工智能可以减少决策中的不确定性,因为决策者可以确信模型的决策是基于可靠的信息和推理。

### 4.2 可解释人工智能在不同领域的应用

可解释人工智能在各种领域都有广泛的应用,包括:

#### 4.2.1 医疗保健

- **诊断疾病:**可解释人工智能可以帮助医生诊断疾病,通过提供对模型决策过程的解释,医生可以了解模型如何识别和解释患者的症状。

- **个性化治疗:**可解释人工智能可以帮助医生为患者制定个性化的治疗计划,通过了解模型如何考虑患者的个人信息和病史,医生可以做出更明智的治疗决策。

#### 4.2.2 金融

- **欺诈检测:**可解释人工智能可以帮助金融机构检测欺诈行为,通过了解模型如何识别和解释可疑交易,金融机构可以提高欺诈检测的准确性。

- **信用评分:**可解释人工智能可以帮助金融机构评估借款人的信用风险,通过了解模型如何考虑借款人的财务历史和个人信息,金融机构可以做出更公平的信用评分决策。

#### 4.2.3 制造业

- **预测性维护:**可解释人工智能可以帮助制造商预测机器故障,通过了解模型如何识别和解释机器传感器数据,制造商可以提前计划维护,从而减少停机时间。

- **质量控制:**可解释人工智能可以帮助制造商识别和解决质量问题,通过了解模型如何识别和解释产品缺陷,制造商可以提高产品质量。

# 5. 可解释人工智能的未来发展

### 5.1 可解释人工智能的研究趋势

#### 5.1.1 新的可解释性方法

随着人工智能技术的发展,不断涌现出新的可解释性方法。这些方法旨在提高模型的可解释性,同时保持模型的性能。例如:

- **SHAP (SHapley Additive Explanations)**:一种基于博弈论的解释方法,可以解释模型预测的每个特征的贡献。

- **LIME (Local Interpretable Model-Agnostic Explanations)**:一种局部可解释方法,可以解释模型在特定输入数据点附近的预测。

- **ELI5 (Explain Like I'm 5)**:一种自然语言处理方法,可以将模型的预测转换成易于理解的自然语言。

#### 5.1.2 可解释性评估的标准化

目前,可解释性评估缺乏标准化。不同的研究人员使用不同的指标来评估可解释性,这使得比较不同方法变得困难。为了解决这个问题,研究人员正在努力制定标准化的可解释性评估指标。

### 5.2 可解释人工智能的应用前景

可解释人工智能具有广阔的应用前景,可以提升人工智能的社会接受度和推动人工智能的道德发展。

#### 5.2.1 提升人工智能的社会接受度

人工智能的广泛应用引发了人们对人工智能黑箱性质的担忧。可解释人工智能可以帮助人们理解人工智能的决策过程,从而提高人们对人工智能的信任和接受度。

#### 5.2.2 推动人工智能的道德发展

人工智能的道德发展至关重要,可解释人工智能可以帮助我们识别和解决人工智能的潜在道德问题。通过理解人工智能的决策过程,我们可以制定政策和准则来确保人工智能的公平、公正和透明。

0

0