神经网络的伦理影响:偏见、公平性和透明度的5个关键问题

发布时间: 2024-07-15 04:53:22 阅读量: 91 订阅数: 35

# 1. 神经网络的伦理影响概述**

神经网络,作为人工智能(AI)的一个强大分支,在各个领域取得了显著进展。然而,随着神经网络的广泛应用,其伦理影响也引起了越来越多的关注。

神经网络的伦理影响涉及广泛的方面,包括:

* **偏见和公平性:**神经网络模型可能从训练数据中继承偏见,导致对某些群体的不公平结果。

* **透明度和可解释性:**神经网络的复杂性往往使其难以理解其决策过程,这会损害公众对 AI 的信任。

* **社会应用:**神经网络在医疗保健、金融等领域有着广泛的应用,其伦理影响需要仔细考虑,以确保公平和负责任的使用。

# 2. 神经网络偏见与公平性

神经网络作为强大的机器学习工具,在各种应用中取得了显著的成功。然而,随着其应用的不断深入,人们逐渐意识到神经网络也存在着潜在的偏见和公平性问题。

### 2.1 偏见产生的原因和影响

神经网络偏见产生的原因主要有以下两个方面:

#### 2.1.1 训练数据的偏见

训练数据是神经网络学习的基础。如果训练数据存在偏见,那么神经网络很可能也会继承这些偏见。例如,如果训练数据中女性较少,那么神经网络在识别女性时可能会出现错误。

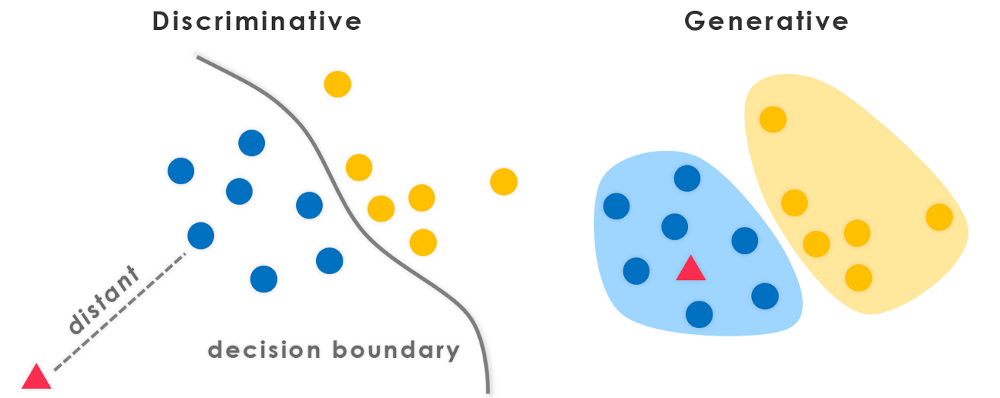

#### 2.1.2 模型架构和算法的偏见

神经网络的架构和算法也可能导致偏见。例如,如果神经网络的架构过于复杂,那么它可能会过拟合训练数据,从而导致对测试数据的泛化能力较差。此外,某些算法,如支持向量机,可能更容易受到偏见的影响。

### 2.2 公平性评估和缓解措施

为了解决神经网络的偏见问题,需要对神经网络的公平性进行评估和缓解。

#### 2.2.1 公平性指标

公平性指标用于衡量神经网络的公平性。常用的公平性指标包括:

- **准确率差异(Accuracy Disparity)**:不同群体之间的准确率差异。

- **错误率差异(Error Rate Disparity)**:不同群体之间的错误率差异。

- **假阳性率差异(False Positive Rate Disparity)**:不同群体之间假阳性率的差异。

- **假阴性率差异(False Negative Rate Disparity)**:不同群体之间假阴性率的差异。

#### 2.2.2 缓解偏见的技术

缓解神经网络偏见的技术包括:

- **重新采样(Resampling)**:通过对训练数据进行重新采样,以确保不同群体的数据分布更加均衡。

- **加权(Weighting)**:为不同群体的数据分配不同的权重,以减少偏见的影响。

- **正则化(Regularization)**:通过正则化项惩罚模型的复杂度,以防止过拟合和减少偏见。

- **对抗训练(Adversarial Training)**:使用对抗样本训练神经网络,以提高其对偏见的鲁棒性。

**代码块:**

```python

import numpy as np

from sklearn.linear_model import LogisticRegression

# 训练数据

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8]])

y = np.array([0, 0, 1, 1])

# 创建逻辑回归模型

model = LogisticRegression()

# 训练模型

model.fit(X, y)

# 评估模型的公平性

accuracy_disparity = np.abs(model.score(X[y == 0], y[y == 0]) - model.score(X[y == 1], y[y == 1]))

print("准确率差异:", accuracy_disparity)

```

**逻辑分析:**

该代码段使用逻辑回归模型训练了一个二分类器,并评

0

0