构建高效数据交换系统:揭秘Python与JSON的策略与工具

发布时间: 2024-09-20 04:47:12 阅读量: 146 订阅数: 67

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 数据交换系统的基本概念和重要性

数据交换系统作为信息流动的枢纽,其核心在于实现不同系统、不同格式数据的有效传输和转换。在信息化和数字化时代,数据交换系统对于促进业务协同、提高工作效率、拓展市场范围等方面具有不可估量的重要性。

数据交换系统设计的基本概念涵盖了数据格式标准化、数据传输协议、数据转换规则和数据集成策略。这些概念对于构建一个高效、稳定和可扩展的数据交换系统至关重要。

随着技术的发展,数据交换系统的重要性更加凸显。无论是内部系统之间的信息共享,还是在供应链管理中与外部合作伙伴的交互,都需要依赖于可靠的数据交换系统。因此,了解和掌握数据交换系统的基本概念和重要性,对于IT专业人员来说是一项基本且关键的技能。

# 2. Python中的JSON处理基础

### 2.1 Python与JSON数据格式

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。由于其轻量级和良好的跨语言支持,JSON成为在不同编程语言间进行数据交换的常用格式。

#### 2.1.1 JSON数据格式概述

JSON数据格式基于文本,使用键值对来存储数据对象,可以嵌套以表达更复杂的数据结构。JSON格式支持的数据类型有:字符串(string)、数字(number)、数组(array)、布尔值(boolean)、null,以及对象(object)。例如:

```json

{

"name": "John Doe",

"age": 30,

"is_student": false,

"courses": ["Math", "Physics"],

"address": {

"street": "123 Main St",

"city": "Anytown"

}

}

```

在这个例子中,我们定义了一个包含姓名、年龄、是否为学生、课程列表和地址的对象。地址本身也是一个对象。

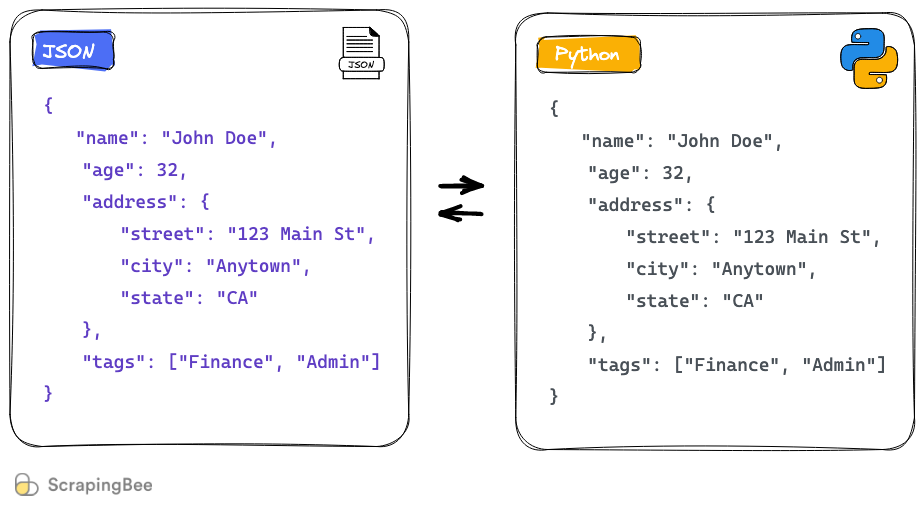

#### 2.1.2 Python中JSON的序列化与反序列化

在Python中,我们可以使用内置的`json`模块来处理JSON数据。序列化是指将Python对象转换成JSON格式的字符串的过程,而反序列化则是将JSON字符串转换回Python对象的过程。

下面是一个序列化和反序列化的例子:

```python

import json

# 创建一个Python字典

data = {

"name": "John Doe",

"age": 30,

"courses": ["Math", "Physics"],

"address": {

"street": "123 Main St",

"city": "Anytown"

}

}

# 将字典序列化为JSON字符串

json_str = json.dumps(data)

print(json_str)

# 将JSON字符串反序列化为Python字典

json_data = json.loads(json_str)

print(json_data)

```

### 2.2 Python中的JSON数据解析

解析JSON数据意味着我们将从JSON格式的字符串中提取数据,并将其转换为Python能够操作的数据结构。Python中处理JSON数据解析的方法主要有两种。

#### 2.2.1 解析JSON数据的方法

最常用的方法是使用`json`模块中的`json.loads()`函数。当我们从文件、网络等来源接收到JSON格式的字符串时,可以使用该方法将其转换为Python字典或列表。

```python

# 从JSON字符串解析数据

import json

# 假设json_str是从外部来源获得的JSON数据

json_str = '{"name": "John Doe", "age": 30}'

# 使用loads方法将JSON字符串解析为Python字典

data = json.loads(json_str)

# 打印解析后的数据

print(data)

```

#### 2.2.2 处理嵌套JSON数据

当JSON数据包含嵌套的对象或数组时,处理起来可能会稍微复杂一些。在Python中,嵌套的JSON数据会被转换为嵌套的字典和列表结构。

```python

import json

# 嵌套的JSON数据

nested_json_str = '{"name": "John Doe", "age": 30, "courses": ["Math", "Physics"], "address": {"street": "123 Main St", "city": "Anytown"}}'

# 解析嵌套的JSON数据

data = json.loads(nested_json_str)

# 打印嵌套的字典数据

print(data["address"])

```

### 2.3 Python与JSON的数据验证

为了确保数据的准确性和一致性,数据验证是一个不可或缺的步骤。在处理JSON数据时,我们常常需要确保数据满足预定义的结构和规则。

#### 2.3.1 使用JSON Schema进行数据验证

JSON Schema是一种用于验证JSON文档的结构和内容的规范。我们可以定义一个JSON Schema来指定哪些数据是必需的,哪些是可选的,数据的类型是什么,以及数据的值应该如何约束。

下面是一个简单的JSON Schema例子,用于验证上述`nested_json_str`中的数据:

```json

{

"$schema": "***",

"title": "Person",

"type": "object",

"properties": {

"name": {

"type": "string",

"description": "The person's name"

},

"age": {

"type": "number",

"description": "The person's age"

},

"courses": {

"type": "array",

"items": {

"type": "string"

},

"description": "The list of courses the person is taking"

},

"address": {

"type": "object",

"properties": {

"street": {

"type": "string",

"description": "The street address"

},

"city": {

"type": "string",

"description": "The city"

}

},

"required": ["street", "city"]

}

},

"required": ["name", "age", "address"]

}

```

在Python中,我们可以使用`jsonschema`库来执行数据验证:

```python

from jsonschema import validate

from jsonschema.exceptions import ValidationError

# 定义schema

schema = {

# ... (此处省略了前面定义的JSON Schema)

}

# 待验证的数据

data = {

# ... (此处省略了前面解析的Python字典数据)

}

# 执行验证

try:

validate(instance=data, schema=schema)

print("Data is valid.")

except ValidationError as e:

print("Data is not valid:", e)

```

#### 2.3.2 错误处理和异常管理

在进行数据验证时,可能会出现数据不符合Schema的情况。因此,我们需要妥善处理可能出现的`ValidationError`异常。通过错误处理,我们可以捕获异常并提供有用的调试信息,从而帮助开发者理解数据验证失败的原因。

以上内容覆盖了Python中处理JSON的基础知识,包括JSON数据格式的概述,Python与JSON数据的序列化与反序列化,JSON数据解析方法,以及如何使用JSON Schema进行数据验证。掌握这些知识对于进行有效且准确的数据交换是至关重要的。

# 3. Python在数据交换中的高级应用

## 3.1 使用Python进行数据转换

### 3.1.1 数据格式转换策略

在现代数据处理中,数据格式转换是一项至关重要的任务,通常涉及将数据从一种格式转换为另一种格式,以便于数据的交换和处理。Python提供了多种机制和库来处理这类转换。了解不同数据格式的特性和转换策略,能够让我们更好地设计数据交换系统。

常见的数据格式包括CSV、XML、JSON、HTML等。在转换过程中,我们通常需要考虑到以下几个方面:

- **数据结构的映射**:理解不同格式间数据结构的映射关系,例如JSON的键值对映射到XML的标签。

- **数据类型一致性**:确保在转换过程中数据类型保持一致,例如日期和时间的格式化问题。

- **错误处理**:在转换过程中如何处理数据丢失、格式不匹配等问题。

- **性能优化**:针对大量数据的转换,如何优化以减少转换时间。

在设计转换策略时,需要对目标数据格式有充分的了解,并且能够灵活运用Python的数据处理库。

### 3.1.2 Python库在数据转换中的应用

Python的第三方库提供了强大的数据处理功能。在数据转换方面,我们可以利用这些库来简化任务和提高效率。下面是几个常用的数据转换库及其用法:

#### `pandas`

`pandas`是一个强大的数据分析和操作库,特别适合处理表格数据。对于CSV文件,我们可以使用`pandas`快速进行数据读取和转换:

```python

import pandas as pd

# 读取CSV文件

df = pd.read_csv('source.csv')

# 将DataFrame转换为JSON格式

json_data = df.to_json(orient='records')

# 将DataFrame转换为XML格式

xml_data = df.to_xml('output.xml', root_name='data', row_name='record')

```

在上述代码中,`to_json`方法用于将`DataFrame`转换为JSON格式,`to_xml`方法则用于转换为XML格式。`orient`参数用于指定JSON输出的格式类型,而`root_name`和`row_name`则用于自定义XML的根节点和记录节点名称。

#### `xmltodict`

`xmltodict`是一个简单而强大的库,将XML转换为Python字典和从字典转换回XML:

```python

import xmltodict

# XML到字典

with open('source.xml', 'r') as f:

xml_dict = xmltodict.parse(f.read())

# 字典到XML

with open('output.xml', 'w') as f:

xmltodict.unparse(xml_dict, f)

```

#### `ijson`

`ijson`提供了一个流式解析JSON数据的方式,适用于处理大型JSON文件:

```python

import ijson

# 流式解析JSON文件

with open('large.json', 'rb') as f:

parser = ijson.parse(f)

for prefix, event, value in parser:

print(event, value)

```

通过使用这些库,我们可以高效地实现不同数据格式之间的转换,从而在数据交换中构建一个灵活而强大的后端系统。

## 3.2 构建健壮的数据交换管道

### 3.2.1 数据管道的设计原则

在构建数据交换系统时,数据管道是核心组件之一。数据管道的设计需要遵循一些关键原则,以保证数据在转换过程中的完整性和效率。以下是构建高效数据管道的几个关键点:

1. **模块化**:将数据处理分解成独立的模块或步骤,每个步骤处理一部分逻辑。

2. **可扩展性**:设计时考虑未来可能的需求变化,使得系统易于扩展。

3. **容错性**:确保系统在处理数据时能够处理异常情况,例如数据格式错误或缺失值。

4. **性能监控**:监控数据管道的性能指标,如处理时间、内存消耗和吞吐量。

5. **数据完整性和一致性**:保持数据在整个处理过程中的准确性和一致性。

### 3.2.2 构建Python数据管道的实践

构建实际的数据管道需要将上述原则具体化为一系列的步骤和代码实现。这里展示一个简单的Python数据管道实践,使用`pandas`库来实现数据的读取、清洗、转换和输出:

```python

import pandas as pd

# 读取数据源(例如CSV文件)

df = pd.read_csv('source.csv')

# 数据清洗和转换步骤

def preprocess(df):

# 清洗步骤:填充缺失值、删除重复项等

df.fillna(method='ffill', inplace=True)

df.drop_duplicates(inplace=True)

# 转换步骤:格式化日期、字符串等

df['date'] = pd.to_datetime(df['date']).dt.strftime('%Y-%m-%d')

return df

# 应用预处理函数

df_cleaned = preprocess(df)

# 数据转换步骤

def transform(df):

# 转换逻辑,例如将一列拆分为多列

df = df.assign(new_column=df['existing_column'].str.split(','))

return df

# 应用转换函数

df_transformed = transform(df_cleaned)

# 输出处理后的数据到新的CSV文件

df_transformed.to_csv('output.csv', index=False)

```

上述代码中,我们定义了两个函数`preprocess`和`transform`,分别用于数据清洗和转换。整个流程是模块化的,易于扩展和维护。此外,通过记录函数的输入输出,我们可以轻松地追踪数据流经管道的每一个步骤,从而确保数据的完整性和一致性。

构建健壮的数据交换管道不仅要求我们遵循设计原则,更需要在实际操作中不断优化和调整,以适应数据处理需求的变化。

## 3.3 数据交换的性能优化

### 3.3.1 识别性能瓶颈

性能优化是任何数据处理系统中不可或缺的环节。在数据交换系统中,性能瓶颈通常表现为数据处理速度慢、内存使用过高、数据处理延迟大等问题。识别性能瓶颈是优化的第一步,需要我们对数据管道中的每个环节进行分析和评估。

我们可以通过以下步骤来识别瓶颈:

1. **监控资源使用情况**:使用工具监控CPU、内存、磁盘I/O等资源的使用情况。

2. **日志分析**:检查系统和应用日志,寻找异常的错误信息和性能告警。

3. **性能测试**:对数据处理流程进行压力测试,找出系统的最大承载能力。

4. **瓶颈定位**:使用分析工具(如Python的`cProfile`或`line_profiler`)对瓶颈代码进行剖析。

### 3.3.2 优化技巧和方法

在识别出性能瓶颈后,我们可以采取多种优化方法来改进系统性能。以下是一些常见的优化技巧:

#### 代码优化

- **避免不必要的数据复制**:在数据处理中,避免频繁创建大型数据对象的副本。

- **使用高效的算法和数据结构**:例如使用`set`而不是`list`进行成员检查,利用`collections.Counter`统计元素出现频率。

```python

import collections

# 使用Counter优化计数操作

data = ['apple', 'banana', 'apple', 'orange', 'banana', 'apple']

counter = collections.Counter(data)

```

#### 并行处理

- **利用多核CPU**:使用Python的`multiprocessing`模块来并行处理数据,提高计算效率。

```python

from multiprocessing import Pool

def process_data(data):

# 数据处理逻辑

return data.upper()

if __name__ == '__main__':

data_list = ['apple', 'banana', 'cherry']

pool = Pool(4) # 创建一个有4个进程的进程池

results = pool.map(process_data, data_list)

pool.close()

pool.join()

```

#### 缓存和预计算

- **缓存经常访问的数据**:使用`functools.lru_cache`来缓存函数结果,减少重复计算。

```python

from functools import lru_cache

@lru_cache(maxsize=100)

def expensive_function(x):

# 昂贵的计算操作

return x * x

```

#### 数据存储优化

- **优化数据存储格式**:例如使用压缩格式(如Parquet或HDF5)来减少磁盘I/O和提高读写速度。

```python

import pandas as pd

df.to_parquet('output.parquet')

```

通过上述方法的组合应用,我们可以有效地提升数据交换系统的性能。优化是一个持续的过程,需要不断地监控、评估和调整来应对数据量增长和新需求的出现。

在这一章节中,我们讨论了使用Python进行数据转换和构建健壮的数据交换管道,以及如何优化数据交换的性能。这些知识不仅涉及了具体的技术细节,还包含了解决问题和优化性能的思路,是构建高效数据交换系统的关键所在。下一章节,我们将进入Python数据交换系统的实践案例,看看在真实世界中如何运用这些理论知识。

# 4. Python数据交换系统的实践案例

## 4.1 实现数据交换系统的API接口

### 4.1.1 设计RESTful API接口

RESTful API设计是现代Web服务中的核心概念,它使用HTTP协议提供的标准方法(如GET、POST、PUT、DELETE等)来实现客户端与服务器之间的无状态通信。RESTful接口应遵循“统一接口”原则,每个资源都有唯一的URI(统一资源标识符),并且每个资源通过HTTP方法以统一的方式进行交互。

设计RESTful API时,应注意以下几点:

- **资源的抽象**: 使用名词来表示资源,例如`/users`代表用户集合,`/users/{id}`代表特定用户。

- **无状态操作**: 每个请求都应包含客户端需要的所有信息,服务器不需要存储客户端的状态。

- **使用HTTP动词**: GET用于读取资源,POST用于创建资源,PUT用于更新资源,DELETE用于删除资源。

- **使用HTTP状态码**: 通过状态码来传达请求的结果,例如200表示成功,404表示资源未找到。

- **版本控制**: 在API URL中使用版本号(如`/api/v1`)以区分API的不同版本。

### 4.1.2 使用Flask和Django构建API

Python社区提供了丰富的Web框架来构建RESTful API,其中Flask和Django是最受欢迎的两个框架。下面将分别展示如何使用这两个框架来快速搭建API。

#### 使用Flask构建API

Flask是一个轻量级的框架,非常适合快速开发简单的API。下面是一个简单的Flask API示例:

```python

from flask import Flask, jsonify, request

app = Flask(__name__)

# 简单的用户数据结构

users = [

{'id': 1, 'name': 'Alice', 'email': '***'},

{'id': 2, 'name': 'Bob', 'email': '***'},

]

@app.route('/users', methods=['GET'])

def get_users():

return jsonify({'users': users})

@app.route('/users', methods=['POST'])

def add_user():

new_user = request.get_json()

users.append(new_user)

return jsonify(new_user), 201

@app.route('/users/<int:user_id>', methods=['GET'])

def get_user(user_id):

user = next((user for user in users if user['id'] == user_id), None)

if user:

return jsonify(user)

return jsonify({'message': 'User not found'}), 404

if __name__ == '__main__':

app.run(debug=True)

```

在这个例子中,我们定义了三个路由来处理用户的获取、添加和获取特定用户。Flask的`@app.route`装饰器用于绑定URL到对应的处理函数。

#### 使用Django构建API

Django是一个全功能的Web框架,它自带了一个强大的ORM系统,能够轻松处理数据库操作。Django REST framework(DRF)是基于Django的一个第三方库,专门用于构建Web API。以下是使用DRF实现的API示例:

```python

from rest_framework import serializers, viewsets

from django.http import JsonResponse

class UserSerializer(serializers.ModelSerializer):

class Meta:

model = User

fields = '__all__'

class UserViewSet(viewsets.ModelViewSet):

queryset = User.objects.all()

serializer_class = UserSerializer

# URLs

from rest_framework.routers import DefaultRouter

router = DefaultRouter()

router.register(r'users', UserViewSet)

urlpatterns = router.urls

```

在这个例子中,我们使用了Django的模型(`User`)和序列化器(`UserSerializer`),并通过Django REST framework提供的`ModelViewSet`类来自动实现对用户资源的增删改查操作。

通过这些代码块和逻辑说明,可以看出,无论是使用Flask还是Django框架,都能以相对简单和直观的方式实现RESTful API的设计与开发。这为在实际项目中快速搭建数据交换系统提供了强有力的工具。

在接下来的小节中,我们将探讨数据交换系统的安全性和合规性,以及在实际场景中如何应用数据交换策略。

# 5. Python与JSON数据交换的未来趋势和工具

随着信息技术的快速发展,Python与JSON数据交换正在迎来新的变革。本章节将探索新兴技术、自动化工具的发展趋势,以及跨平台和跨语言数据交换策略。

## 5.1 新兴Python库和框架

### 5.1.1 现代数据处理库的发展

Python作为数据处理的利器,一直在不断地推陈出新。新兴的数据处理库如Pandas、Dask,以及机器学习库scikit-learn和TensorFlow等,它们正不断优化,使得处理JSON数据更加高效。这些库不仅提高了数据分析和处理的速度,还在数据清洗、转换以及模型训练等方面提供了强大的功能。

例如,在处理大量JSON数据时,Pandas库能够通过其DataFrame数据结构,轻松实现数据的导入、查询、分析和输出。这一节将详细介绍如何使用Pandas读取JSON数据,并进行数据处理。

```python

import pandas as pd

# 从JSON文件读取数据到DataFrame

data = pd.read_json('data.json')

# 显示前5条记录

print(data.head())

# 数据筛选

filtered_data = data[data['age'] > 30]

# 输出筛选后的数据

print(filtered_data)

```

### 5.1.2 对接现代数据库技术

随着NoSQL数据库如MongoDB、Cassandra的流行,Python社区也提供了相应的接口和工具,如PyMongo、Cassandra-driver,来简化与这些数据库的交互。这些工具利用Python的易用性和灵活性,为数据库操作带来更大的便利。

MongoDB作为一个广泛使用的文档型数据库,其与Python的交互是现代数据处理的典型范例。下面的代码块展示了如何使用PyMongo与MongoDB进行交互。

```python

from pymongo import MongoClient

# 连接到MongoDB数据库

client = MongoClient('mongodb://localhost:27017/')

db = client['testdb']

collection = db['testcol']

# 插入JSON数据

collection.insert_one({'name': 'Alice', 'age': 30})

# 查询数据

result = collection.find_one({'name': 'Alice'})

# 打印查询结果

print(result)

```

## 5.2 数据交换的自动化和智能化

### 5.2.1 自动化数据映射和转换

在数据交换中,自动化工具可以显著提高效率和准确性。Python的自动化工具,如Apache NiFi、Airflow等,通过可视化的界面和强大的工作流设计功能,简化了数据流程的开发和管理。

### 5.2.2 智能化数据交换的探索

智能化数据交换是使用机器学习等技术来识别数据模式、预测数据变化,并自动化处理数据交换过程中可能遇到的问题。这方面的探索还处于起步阶段,但是已经有一些初步的尝试,例如使用Python的机器学习库scikit-learn进行数据分类和回归分析,从而自动调整数据交换策略。

## 5.3 跨平台和跨语言数据交换策略

### 5.3.1 跨平台数据交换的解决方案

在跨平台数据交换中,XML、CSV、JSON等多种数据格式都可能需要处理。JSON因其简洁和灵活性成为跨平台数据交换的首选格式之一。Python能够通过各种库和工具来支持不同平台间的数据交换,如使用requests库进行HTTP数据传输,或者使用SQLAlchemy来跨平台操作数据库。

### 5.3.2 跨语言数据交换工具和最佳实践

跨语言数据交换通常需要数据格式的通用性和工具的互操作性。Python可以与Java、C#等其他语言进行交互,例如使用Jython可以在Python环境中直接运行Java代码,或者借助gRPC实现多语言服务。这一部分将探讨在多语言环境下的数据交换最佳实践。

通过以上章节的介绍,我们对Python与JSON数据交换系统的未来趋势和工具有了更深入的了解。在下一章节中,我们将通过实践案例来进一步阐释这些概念。

0

0