【Python JSON数据处理秘籍】:从入门到精通的10大技巧

发布时间: 2024-09-20 04:41:38 阅读量: 94 订阅数: 67

基于纯verilogFPGA的双线性差值视频缩放 功能:利用双线性差值算法,pc端HDMI输入视频缩小或放大,然后再通过HDMI输出显示,可以任意缩放 缩放模块仅含有ddr ip,手写了 ram,f

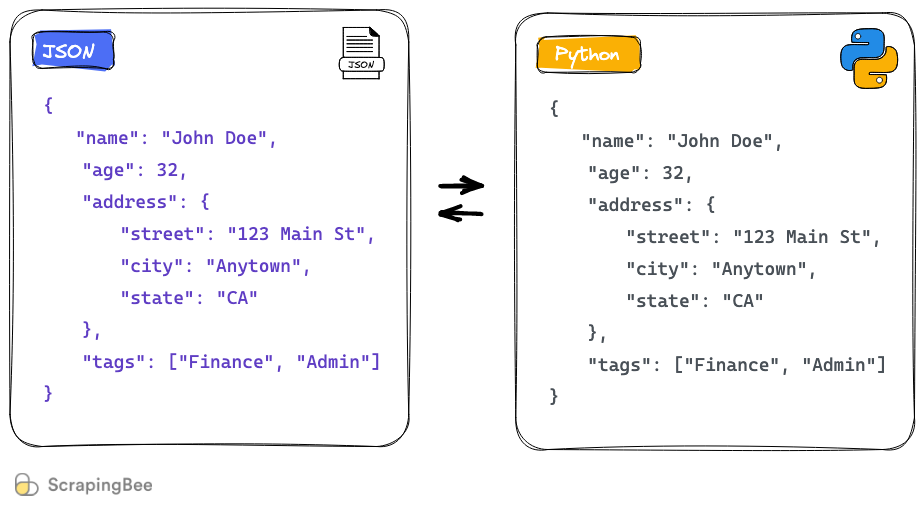

# 1. Python中JSON数据格式概述

在现代编程和数据处理中,JSON(JavaScript Object Notation)已经成为一种广泛使用的数据交换格式。它是轻量级的、易于人阅读和编写,同时也易于机器解析和生成。Python作为一种高级编程语言,在处理JSON数据方面提供了非常便捷和高效的方法。

JSON数据格式以其简洁和通用性,在Web开发、API数据交互、配置文件以及数据存储等多个领域中都有着重要的应用。而Python,作为一门功能强大的编程语言,内置了对JSON格式的处理能力,使得开发者能够更加轻松地读写JSON数据。

在本文中,我们将探讨JSON数据格式的基本概念,介绍Python如何处理JSON数据,并为后续章节的学习打下坚实的基础。我们将从JSON数据结构的特点开始,逐步深入到JSON数据与Python数据类型之间的映射,以及如何在Python中读取和生成JSON数据。这一章是整个文章的基础,为读者理解后续章节的内容做好铺垫。

# 2. Python与JSON数据的交互基础

在当今的软件开发领域,JSON已经成为数据交换的标准格式之一。Python,作为一种广泛使用的编程语言,对JSON数据提供了原生的支持。本章我们将深入探讨Python如何处理JSON数据,包括如何在Python中读取和写入JSON数据,如何将JSON数据转换为Python的数据结构,以及如何将Python的数据结构转换回JSON数据。同时,我们还将了解在处理JSON数据时常见的异常和错误以及应对策略。

## 2.1 Python中的JSON模块

Python标准库中的`json`模块提供了处理JSON数据的功能。这一小节我们将探讨如何使用`json`模块进行JSON数据与Python数据结构之间的转换,以及序列化与反序列化的具体方法。

### 2.1.1 JSON数据与Python数据结构的转换

JSON数据以字符串形式表示,而Python将其转换为Python能够处理的数据结构。反之,Python的数据结构也可以转换成JSON字符串。下面是具体转换方法的介绍:

```python

import json

# 将Python字典转换为JSON字符串

python_dict = {'name': 'John', 'age': 30, 'city': 'New York'}

json_str = json.dumps(python_dict)

print(json_str) # 输出:'{"name": "John", "age": 30, "city": "New York"}'

# 将JSON字符串转换为Python字典

python_dict_from_json = json.loads(json_str)

print(python_dict_from_json) # 输出:{'name': 'John', 'age': 30, 'city': 'New York'}

```

**逻辑分析和参数说明:**

`json.dumps()` 函数用于将Python对象编码成JSON字符串。`json.loads()` 函数则执行相反的操作,它把一个JSON格式的字符串解码为Python的字典或其他数据类型。通过这两个函数,我们可以轻松地在JSON格式与Python数据结构之间转换。

### 2.1.2 序列化与反序列化的的方法

序列化(Serialization)是将对象状态信息转换为可以存储或传输的形式的过程。在Python中,这个过程也常被称为编码(encoding)。而反序列化(Deserialization)则是将这个过程反过来,它将存储或传输的状态信息转换回对象的过程,也常被称为解码(decoding)。下面是序列化和反序列化的具体操作代码:

```python

import json

# 序列化

class Person:

def __init__(self, name, age):

self.name = name

self.age = age

person = Person('Alice', 25)

json_str = json.dumps(person.__dict__, indent=4) # 使用__dict__来获取对象的属性字典进行序列化

print(json_str)

# 输出:

# {

# "name": "Alice",

# "age": 25

# }

# 反序列化

new_person = json.loads(json_str)

new_person_obj = Person(**new_person)

print(new_person_obj.name) # 输出:Alice

print(new_person_obj.age) # 输出:25

```

**逻辑分析和参数说明:**

在序列化例子中,我们创建了一个`Person`类,并通过`__dict__`属性获取了对象的属性字典,然后使用`json.dumps()`进行序列化。在反序列化例子中,我们先用`json.loads()`将JSON字符串转换为字典,然后通过解包操作符`**`将字典作为参数传递给`Person`类的构造函数,从而创建了一个新的实例。

## 2.2 JSON数据在文件中的读写

在处理JSON数据时,经常需要将数据保存到文件中,或是从文件中加载JSON数据。本小节将介绍如何实现从文件中加载JSON数据以及如何将Python对象保存为JSON文件。

### 2.2.1 从文件加载JSON数据

从文件中读取JSON数据时,可以使用`json.load()`函数。这个函数与`json.loads()`类似,不同之处在于它直接读取文件对象而不是字符串。

```python

import json

with open('data.json', 'r') as f:

python_dict = json.load(f)

print(python_dict)

```

**逻辑分析和参数说明:**

`open()`函数用于打开文件,返回一个文件对象。在`with`语句块中,文件在操作完成后会自动关闭,提高了代码的健壮性。`json.load(f)`函数从文件对象`f`中读取JSON数据并将其解码成Python字典。

### 2.2.2 将Python对象保存为JSON文件

将Python数据结构保存为JSON文件时,可以使用`json.dump()`函数。这个函数与`json.dumps()`类似,但它将编码后的JSON字符串写入到文件中。

```python

import json

python_dict = {'name': 'Bob', 'age': 29, 'city': 'Los Angeles'}

with open('data.json', 'w') as f:

json.dump(python_dict, f, indent=4)

```

**逻辑分析和参数说明:**

在上面的代码示例中,`json.dump()`函数的`indent`参数用来设置输出的JSON字符串的格式化风格。这里设置为`4`,意味着每个层级的缩进为四个空格。这不仅使得生成的JSON文件更易读,也方便了后续的数据查看和编辑。

## 2.3 Python中处理JSON数据的异常与错误

在处理JSON数据时,可能会遇到各种异常和错误。本小节将介绍如何处理JSON解析错误以及在序列化时数据类型限制导致的错误。

### 2.3.1 JSON解析错误的处理方式

解析JSON数据时,可能会遇到格式不正确或其他错误。此时,我们需要通过异常处理机制来捕获这些错误并进行相应的处理。

```python

import json

try:

with open('invalid_data.json', 'r') as f:

data = json.load(f)

except json.JSONDecodeError as e:

print(f"解析错误: {e}")

```

**逻辑分析和参数说明:**

在上面的代码中,我们使用了`try...except`语句来捕获`json.JSONDecodeError`异常。当遇到错误的JSON格式时,`json.load()`会抛出这个异常,我们可以捕获它并打印出错误信息,从而避免程序因错误而崩溃。

### 2.3.2 序列化中的数据类型限制

JSON模块在序列化Python对象时有一定的限制。例如,它不能直接序列化Python中的`datetime`对象。对于这些类型,我们需要使用`json.JSONEncoder`类的`default()`方法来实现自定义的序列化。

```python

import json

from datetime import datetime

class CustomEncoder(json.JSONEncoder):

def default(self, obj):

if isinstance(obj, datetime):

return obj.isoformat()

return json.JSONEncoder.default(self, obj)

now = datetime.now()

json_str = json.dumps(now, cls=CustomEncoder)

print(json_str) # 输出格式类似:'2023-04-05T12:34:56.789123'

```

**逻辑分析和参数说明:**

在上述代码中,`CustomEncoder`继承自`json.JSONEncoder`并重写了`default()`方法。我们检查传入对象的类型,如果是`datetime`对象,则返回其ISO格式的字符串表示。这样,在使用`json.dumps()`时,通过`cls`参数指定我们的`CustomEncoder`来处理特定类型的数据。

通过本小节的介绍,我们已经了解了Python与JSON数据交互的基础操作。接下来的章节将继续深入讨论JSON数据结构及其操作的高级技巧,并提供提升处理效率的方法。

# 3. 深入理解JSON数据结构及其操作

深入理解JSON数据结构及其操作是实现高效、准确处理数据的关键。在本章节中,我们将详细探讨JSON的复合数据类型,如何在Python中查询和过滤JSON数据,以及如何进行JSON数据的修改和更新。通过本章节内容的学习,你将能够掌握在Python环境下对JSON数据结构进行高级操作的技巧。

## 3.1 JSON中的复合数据类型

### 3.1.1 对象和数组的操作

JSON中的对象类似于Python中的字典,而数组则与列表类似。在处理复合数据类型时,操作这些对象和数组是基本任务之一。

```python

import json

# 示例JSON数据

json_data = '{"name": "Alice", "age": 30, "is_student": false, "courses": ["Math", "Science", "History"]}'

# 将JSON字符串转换为Python字典

data = json.loads(json_data)

# 对象操作示例:访问对象的属性

name = data["name"]

print(f"Name: {name}")

# 数组操作示例:访问数组的元素

first_course = data["courses"][0]

print(f"First course: {first_course}")

# 修改数组中的元素

data["courses"][2] = "English"

# 将更新后的字典转换回JSON字符串

updated_json = json.dumps(data)

print(updated_json)

```

在这个例子中,我们首先加载了一个JSON字符串到Python字典中。然后,我们访问了对象的"name"属性和数组"courses"的第一个元素。之后,我们修改了数组中的第三个元素,并将更新后的字典转换回JSON字符串。

### 3.1.2 嵌套数据的处理策略

嵌套的数据结构在JSON中非常常见,正确处理嵌套结构是高效数据处理的关键。

```python

# 嵌套数据示例

nested_json_data = '{"company": {"name": "TechCorp", "employees": [{"name": "Alice", "position": "Engineer"}, {"name": "Bob", "position": "Manager"}]}}'

# 加载嵌套JSON

nested_data = json.loads(nested_json_data)

# 访问嵌套对象

company_name = nested_data["company"]["name"]

print(f"Company name: {company_name}")

# 访问嵌套数组中的对象

employee_name = nested_data["company"]["employees"][0]["name"]

print(f"Employee name: {employee_name}")

# 修改嵌套数组中的对象属性

nested_data["company"]["employees"][0]["position"] = "Senior Engineer"

# 输出修改后的JSON数据

print(json.dumps(nested_data, indent=4))

```

在上述代码中,我们处理了一个包含嵌套对象和数组的复杂JSON数据结构。通过嵌套的路径访问和修改数据。

## 3.2 Python中对JSON数据进行查询和过滤

### 3.2.1 使用循环和条件语句进行筛选

当JSON数据结构较大或者复杂时,我们需要利用循环和条件语句来查询和过滤所需的数据。

```python

# 筛选特定条件的数据

filtered_data = []

for employee in nested_data["company"]["employees"]:

if employee["position"] == "Engineer":

filtered_data.append(employee)

print(json.dumps(filtered_data, indent=4))

```

### 3.2.2 使用内置函数和模块简化处理

Python提供了许多内置函数和模块来简化对JSON数据的查询和过滤,例如使用`filter`、`map`和列表推导式等。

```python

# 使用列表推导式进行筛选

engineers = [emp for emp in nested_data["company"]["employees"] if emp["position"] == "Engineer"]

# 使用map和filter函数

positions = list(map(lambda x: x["position"], engineers))

print(positions)

```

## 3.3 在Python中修改和更新JSON数据

### 3.3.1 字典和列表方法的运用

在Python中,字典和列表的方法是修改JSON数据的基本工具。

```python

# 修改字典中的值

data = {"a": 1, "b": 2, "c": 3}

data["b"] = 4

print(data)

# 修改列表中的元素

my_list = [1, 2, 3]

my_list[1] = 5

print(my_list)

```

### 3.3.2 保持数据结构完整性的策略

在修改JSON数据时,保持数据结构的完整性和一致性是非常重要的。

```python

def update_json_object(json_data, key, value):

data = json.loads(json_data)

data[key] = value

return json.dumps(data)

# 保持数据结构完整性的函数

json_str = '{"name": "Alice", "age": 30}'

updated_str = update_json_object(json_str, "age", 31)

print(updated_str)

```

在这个示例中,我们定义了一个函数`update_json_object`,它接受原始JSON数据、要更新的键和新的值。函数内部首先将JSON字符串解析为字典,然后更新字典中相应的键,最后再将更新后的字典转回JSON字符串。通过这种封装方法,我们确保了数据结构的完整性。

以上便是深入理解JSON数据结构及其操作的详细解读。掌握这些基础内容后,你将能够更好地处理复杂的JSON数据,并将其有效地应用到实际开发工作中。

# 4. 提升JSON数据处理效率的高级技巧

## 4.1 使用递归方法处理复杂的JSON结构

### 4.1.1 递归函数的编写与应用

递归方法是处理具有层级或嵌套结构数据的强大工具。在处理JSON数据时,递归可以帮助我们轻松地访问和操作嵌套的对象和数组。考虑以下具有嵌套结构的JSON数据:

```json

{

"company": "TechCorp",

"employees": [

{

"name": "Alice",

"department": "R&D",

"projects": ["Alpha", "Omega"]

},

{

"name": "Bob",

"department": "Sales",

"projects": ["Bravo"]

}

]

}

```

若需要访问所有员工的项目名称,我们可以编写一个递归函数来实现:

```python

def get_projects(data):

projects = []

if isinstance(data, dict):

for value in data.values():

projects.extend(get_projects(value))

elif isinstance(data, list):

for item in data:

projects.extend(get_projects(item))

elif isinstance(data, str):

return [data]

return projects

```

此函数遍历了嵌套的字典和列表,寻找类型为字符串的项目名称,并将它们添加到项目列表中。

### 4.1.2 处理嵌套数据的递归策略

递归策略的核心在于定义何时进行递归调用和如何合并结果。在实际应用中,递归函数应考虑以下几点:

- **基准情况:** 定义一个或多个停止递归的条件,避免无限循环。

- **递归步骤:** 确定如何将问题分解为更小的子问题,并对每个子问题调用自身。

- **结果合并:** 确定如何将递归调用返回的结果合并为最终结果。

对于前面的示例,递归策略是:

- 如果当前数据是字典或列表,则对其每个值递归调用`get_projects`。

- 如果当前数据是字符串,则返回包含该字符串的列表。

- 将所有递归调用的结果合并为一个最终列表。

通过这种方式,我们能够以模块化的方式处理任意深度的嵌套JSON数据结构。

## 4.2 使用第三方库进行JSON数据操作

### 4.2.1 介绍常用的JSON处理库

除了Python标准库中的`json`模块外,许多第三方库提供了额外的特性来简化JSON处理工作。例如:

- `ujson`:更快的JSON编码和解码。

- `ijson`:逐个处理流式JSON文件,适用于处理大型文件。

- `simplejson`:一个兼容标准json模块的备选实现,通常更灵活。

以下是`simplejson`库的一个使用示例:

```python

import simplejson as json

data = '{"company": "TechCorp", "employees": [{"name": "Alice", "department": "R&D"}]}'

data_loaded = json.loads(data)

```

使用`simplejson.dumps()`方法可以将Python对象转换为JSON字符串,其工作方式与标准库的`json.dumps()`类似,但是添加了一些额外的特性,如更灵活的编码器选择。

### 4.2.2 库函数与原生模块性能对比

第三方库常常对性能进行了优化,尤其适合在对性能要求较高的场景中使用。以下是使用第三方库进行JSON处理可能带来的性能改进的一个简单对比:

- **编码与解码速度:** `ujson`通常比标准库快很多,因为它使用了C扩展。

- **内存消耗:** 一些库实现了更高效的内存管理,比如`simplejson`在某些情况下使用更少的内存。

- **流式处理:** `ijson`能够逐个处理大型JSON文件,无需一次性加载整个文件到内存。

下面是一个简单的性能对比测试,使用Python的`timeit`模块进行基准测试:

```python

import timeit

import json

import ujson

# 编码性能测试

json_encode = timeit.timeit('json.dumps({"key": "value"})', number=10000)

ujson_encode = timeit.timeit('ujson.dumps({"key": "value"})', number=10000)

# 解码性能测试

json_decode = timeit.timeit('json.loads(\'{"key": "value"}\')', number=10000)

ujson_decode = timeit.timeit('ujson.loads(\'{"key": "value"}\')', number=10000)

print(f'json encode: {json_encode} seconds')

print(f'ujson encode: {ujson_encode} seconds')

print(f'json decode: {json_decode} seconds')

print(f'ujson decode: {ujson_decode} seconds')

```

结果通常显示`ujson`在编码和解码操作上的速度优势。

## 4.3 JSON数据处理的性能优化

### 4.3.1 代码优化技巧

优化JSON数据处理的代码可以显著提高应用性能,特别是当处理大量数据时。以下是一些常见的代码优化技巧:

- **避免不必要的类型转换:** 在处理数据前,检查数据类型是否符合预期,避免在循环中进行不必要的类型转换。

- **减少内存分配:** 使用生成器、列表推导式或集合推导式来减少内存的使用。

- **利用内置函数和模块:** Python的内置函数和标准库模块经过优化,应该优先使用。

例如,假设有一个大型JSON数组需要处理,我们可以使用列表推导式进行快速处理:

```python

import json

large_json_string = '{"items": [{"id": 1}, {"id": 2}, ...]}'

data = json.loads(large_json_string)

# 使用列表推导式提取id

ids = [item['id'] for item in data['items']]

```

### 4.3.2 利用缓存和异步处理提高效率

当处理复杂的JSON数据时,涉及大量的I/O操作,例如从网络或文件系统加载数据,这时可以使用缓存来减少重复的计算:

- **内存缓存:** 对于计算密集型的操作,可以使用内存缓存来存储结果,以便之后快速访问。

- **文件缓存:** 当数据不常变化时,可以将处理后的数据保存到文件中,再次需要时直接读取。

此外,利用异步编程可以提高性能,特别是在I/O密集型的应用中:

- **异步I/O操作:** 在Python中,`asyncio`库可以用来进行异步I/O操作,它提供了并发执行I/O密集型任务的能力。

- **并行处理:** 在多核处理器上,使用多线程或多进程可以进一步提高数据处理能力。库如`concurrent.futures`或`multiprocessing`能够帮助我们轻松实现并行处理。

下面是一个使用`concurrent.futures`进行异步加载JSON数据的示例:

```python

import json

from concurrent.futures import ThreadPoolExecutor

def load_json(json_file_path):

with open(json_file_path, 'r') as ***

***

***

***

***

* 并发加载多个JSON文件

json_file_paths = ['file1.json', 'file2.json', ...]

results = [async_load_json(path) for path in json_file_paths]

```

这段代码演示了如何使用线程池来并行加载多个JSON文件。通过将I/O密集型的任务分配给多个线程,可以显著减少整体的处理时间。

# 5. JSON数据处理的实战应用案例

## 5.1 构建RESTful API中的JSON处理

在构建RESTful API时,JSON数据处理是一个核心环节。RESTful API 常使用 JSON 作为数据交互格式,因为其轻量、易于读写且具有良好的跨平台支持。下面我们将探讨如何在构建API时进行有效的JSON数据处理。

### 5.1.1 JSON与API数据交互的实例

假设我们正在构建一个简单的图书管理系统 API,我们需要处理图书数据的增删改查(CRUD)操作。下面是一个使用 Flask 框架的示例代码:

```python

from flask import Flask, request, jsonify

from flask_sqlalchemy import SQLAlchemy

app = Flask(__name__)

app.config['SQLALCHEMY_DATABASE_URI'] = 'sqlite:///books.db'

db = SQLAlchemy(app)

class Book(db.Model):

id = db.Column(db.Integer, primary_key=True)

title = db.Column(db.String(80), nullable=False)

author = db.Column(db.String(120), nullable=False)

year_published = db.Column(db.Integer, nullable=False)

@app.route('/books', methods=['GET'])

def get_books():

books = Book.query.all()

return jsonify([{'id': book.id, 'title': book.title, 'author': book.author, 'year_published': book.year_published} for book in books])

@app.route('/books/<int:book_id>', methods=['GET'])

def get_book(book_id):

book = Book.query.get_or_404(book_id)

return jsonify({'id': book.id, 'title': book.title, 'author': book.author, 'year_published': book.year_published})

@app.route('/books', methods=['POST'])

def add_book():

data = request.get_json()

new_book = Book(title=data['title'], author=data['author'], year_published=data['year_published'])

db.session.add(new_book)

***mit()

return jsonify({'id': new_book.id}), 201

@app.route('/books/<int:book_id>', methods=['PUT'])

def update_book(book_id):

book = Book.query.get_or_404(book_id)

data = request.get_json()

book.title = data['title']

book.author = data['author']

book.year_published = data['year_published']

***mit()

return jsonify({'id': book.id})

@app.route('/books/<int:book_id>', methods=['DELETE'])

def delete_book(book_id):

book = Book.query.get_or_404(book_id)

db.session.delete(book)

***mit()

return jsonify({'result': True})

if __name__ == '__main__':

db.create_all()

app.run(debug=True)

```

### 5.1.2 数据验证和安全性考虑

在处理JSON数据时,数据验证是一个不可忽视的环节。我们需要确保传入的数据是预期的格式,并且进行必要的数据清洗,以防止SQL注入等安全问题。在上述例子中,我们可以使用Flask-RESTful扩展,或者手动验证每个字段。

```python

# 示例:手动验证JSON数据

def validate_book_data(data):

if 'title' not in data or 'author' not in data or 'year_published' not in data:

return False

if not isinstance(data['title'], str) or not isinstance(data['author'], str) or not isinstance(data['year_published'], int):

return False

return True

@app.route('/books', methods=['POST'])

def add_book():

data = request.get_json()

if not validate_book_data(data):

return jsonify({'error': 'Invalid data provided'}), 400

# ...后续代码同上

```

我们还可以通过使用SQLAlchemy的ORM特性来避免SQL注入等安全问题,因为它为我们提供了对象关系映射的安全性。

## 5.2 数据分析与可视化中的JSON应用

### 5.2.1 JSON数据在数据分析工具中的运用

数据分析工具如Pandas,可以将JSON数据直接读入DataFrame对象,这样可以进行高效的统计分析。Pandas提供了`read_json()`和`to_json()`函数,可以轻松地在DataFrame和JSON数据之间转换。

```python

import pandas as pd

# 读取JSON数据

df = pd.read_json('books.json')

# 展示前5行数据

print(df.head())

# 将DataFrame保存为JSON文件

df.to_json('books_output.json', orient='records')

```

### 5.2.2 JSON数据的可视化展示方法

JSON数据经过分析处理后,通常需要可视化展示。常用的可视化工具如Matplotlib和Seaborn,可以通过Pandas与JSON数据交互后进行数据的可视化展示。

```python

import matplotlib.pyplot as plt

# 假设我们有一个根据年份统计的书籍数量的DataFrame

books_by_year = df['year_published'].value_counts().reset_index()

books_by_year.columns = ['Year', 'Number of Books']

# 绘制条形图

plt.figure(figsize=(10, 6))

plt.bar(books_by_year['Year'], books_by_year['Number of Books'])

plt.xlabel('Year Published')

plt.ylabel('Number of Books')

plt.title('Number of Books Published Over Time')

plt.show()

```

## 5.3 处理复杂数据集的策略

### 5.3.1 大数据量JSON文件的分批处理

处理大数据量的JSON文件,一次性加载可能会导致内存溢出。我们可以编写一个分批处理的函数,逐步读取并处理文件。

```python

def batch_process_json(file_path, batch_size):

with open(file_path, 'r') as ***

***

***

***

***

* 处理每批次数据

process这批lines()

# 清理内存

del lines

gc.collect() # 可选的垃圾回收

def process这批lines():

for line in lines:

data = json.loads(line)

# 处理每一行的JSON数据

```

### 5.3.2 多源JSON数据的整合与同步

在处理来自不同源的数据时,整合与同步是重要环节。我们需要定义一个策略来整合不同格式的JSON数据,并同步它们到一个统一的结构中。

```python

def sync_json_data(json_data_list):

master_data = []

for json_data in json_data_list:

for item in json_data:

# 整合逻辑,比如合并相同属性的数据

master_data.append(item)

return master_data

# 示例用法

json_data_from_source_1 = [{'name': 'Alice', 'age': 25}, {'name': 'Bob', 'age': 30}]

json_data_from_source_2 = [{'name': 'Alice', 'job': 'Engineer'}, {'name': 'Bob', 'job': 'Designer'}]

master_data = sync_json_data([json_data_from_source_1, json_data_from_source_2])

print(master_data)

```

通过这些实战案例,我们可以看到JSON数据处理在实际应用中的重要性和多样性。掌握它们,将有助于我们在数据处理、API构建和数据分析等方面的工作。

0

0