大数据分析中的Python JSON应用:分布式处理与性能优化实战

发布时间: 2024-09-20 05:00:29 阅读量: 203 订阅数: 73

python大数据处理与分析数据集与源代码.zip

# 1. Python与JSON在大数据分析中的基础

## 1.1 Python与JSON简介

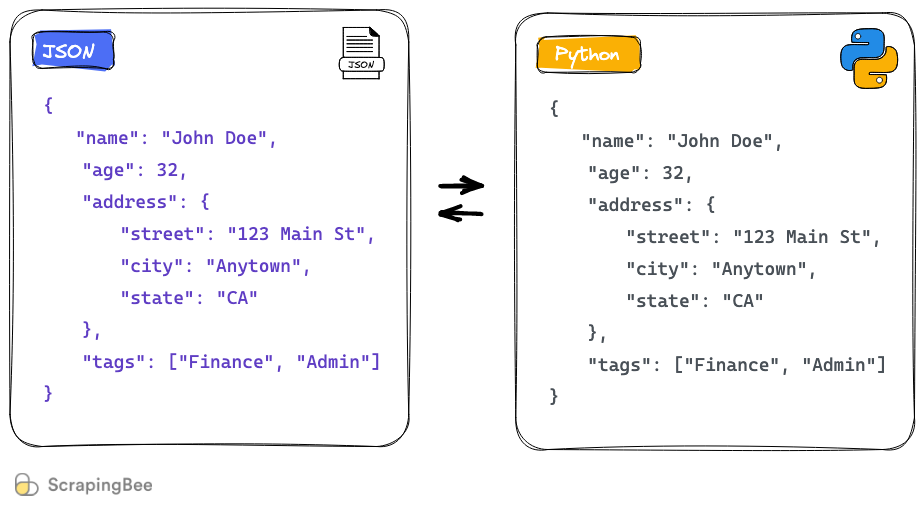

Python是一种广泛用于数据分析的高级编程语言,因其简洁的语法和强大的库生态系统而受到喜爱。JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成,成为数据传输的通用语言。

## 1.2 Python与JSON在大数据中的应用

Python因其数据处理库如Pandas、NumPy的高效处理能力,以及丰富的数据可视化工具如Matplotlib和Seaborn,成为了大数据分析的首选语言。同时,由于JSON的格式简单、易于处理的特性,在大数据分析中,JSON常用于数据的序列化和反序列化,使得数据能够在不同的系统和平台之间轻松传输和处理。

## 1.3 大数据分析的基础准备工作

大数据分析的前期准备工作通常包括数据收集、清洗、转换和存储。Python可以利用诸如BeautifulSoup、Scrapy等库方便地进行网页数据的抓取;Pandas库可以处理和分析存储在CSV、Excel以及数据库中的数据。这些库与JSON的结合使用,能够有效地提升数据准备阶段的效率。

在下一章节中,我们将深入探讨分布式JSON数据处理的理论与实践。

# 2. ```

# 第二章:分布式JSON数据处理的理论与实践

随着大数据技术的快速发展,分布式计算已成为处理海量数据的主要方式之一。在本章节中,我们将深入探讨分布式JSON数据处理的理论基础和实际应用。

## 2.1 分布式计算框架概述

### 2.1.1 分布式处理的基本概念

分布式处理涉及将数据和计算任务拆分成更小的部分,并在多个计算节点上并行执行。这一过程旨在减少处理大规模数据集所需的时间,提高数据处理的吞吐量。

分布式计算框架通常具有以下特点:

- **高容错性**:节点故障是常态,框架需要能够自动处理故障并确保数据不丢失。

- **可伸缩性**:系统应能够灵活地增加或减少资源,以应对不同的负载需求。

- **弹性**:框架可以动态地管理资源,以适应数据和计算需求的变化。

### 2.1.2 常见的分布式计算框架对比

在众多的分布式计算框架中,Hadoop、Spark 和 Flink 是最为流行且广泛使用的三种。

- **Apache Hadoop** 是一个开源框架,它允许使用简单的编程模型跨多个计算节点分布式存储和处理大数据。

- **Apache Spark** 专注于内存计算,相比Hadoop MapReduce能显著提高数据处理速度。

- **Apache Flink** 是一种开源流处理框架,具有低延迟和高吞吐量的特点,特别适合处理实时数据流。

下面我们利用mermaid流程图展示这三种框架的大致工作原理:

```mermaid

graph LR

A[数据输入] -->|存储| B[HDFS]

A -->|处理| C[MapReduce]

A -->|实时处理| D[Spark]

A -->|流处理| E[Flink]

```

## 2.2 Python在分布式系统中的角色

### 2.2.1 Python的多进程与多线程

Python支持多线程和多进程,这使得它在分布式系统中充当了重要的角色。多线程适用于I/O密集型任务,而多进程适合CPU密集型任务。Python的`multiprocessing`模块使得多进程编程变得简单。

```python

from multiprocessing import Process, Queue

def f(name, q):

q.put(f'hello {name}')

if __name__ == '__main__':

queue = Queue()

processes = [Process(target=f, args=('world', queue)), Process(target=f, args=('python', queue))]

for p in processes:

p.start()

for p in processes:

p.join()

print(queue.get())

print(queue.get())

```

上述代码段展示了如何在Python中使用多进程模块创建和管理进程。

### 2.2.2 Python与Hadoop、Spark的集成

Python与Hadoop和Spark的集成,使得Python开发者可以方便地使用分布式计算资源,执行大规模数据处理任务。PySpark是Python接口,提供了Spark的API,极大降低了使用门槛。

```python

from pyspark import SparkContext

sc = SparkContext('local', 'Simple App')

rdd = sc.parallelize([1, 2, 3, 4])

print(rdd.collect())

```

这里,我们展示了如何使用PySpark创建一个本地的简单应用程序,并并行化一个数值列表,然后收集结果。

## 2.3 JSON数据在分布式环境中的处理

### 2.3.1 JSON数据流的导入导出技巧

在分布式环境中处理JSON数据时,通常需要导入和导出大量JSON数据流。为此,我们可以使用Python中的`json`模块进行高效地序列化和反序列化。

```python

import json

# 示例JSON数据

data = [{"name": "John", "age": 30}, {"name": "Jane", "age": 25}]

# 将Python对象转换为JSON字符串

json_string = json.dumps(data)

# 将JSON字符串转换回Python对象

python_obj = json.loads(json_string)

```

### 2.3.2 利用分布式缓存进行JSON数据处理

在处理大数据集时,利用分布式缓存可以有效地减少数据的重复加载和处理时间。Apache Ignite 是一个分布式数据网格平台,它可以用来缓存JSON数据,以便在不同计算节点间共享。

```yaml

# Apache Ignite配置示例

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="cacheConfiguration">

<list>

<bean class="org.apache.ignite.configuration.CacheConfiguration">

<property name="name" value="jsonCache"/>

<property name="cacheStoreFactory">

<bean class="org.apache.ignite.cache.store.fs.FsUrlCacheStoreFactory">

<property name="path" value="/tmp/data"/>

</bean>

</property>

</bean>

</list>

</property>

</bean>

```

通过上述配置,Ignite会创建一个名为`jsonCache`的缓存,该缓存将使用`/tmp/data`目录来存储缓存数据。这个缓存可以被多个节点共享,从而提高JSON数据处理的效率。

以上内容为第二章的详细介绍,接下来我们将继续深入探讨JSON数据的解析与生成优化。

```

# 3. JSON数据的解析与生成优化

在第三章中,我们将深入探讨JSON数据在Python中的解析与生成优化策略。JSON作为一种轻量级的数据交换格式,在Web开发和大数据处理中得到了广泛应用。本章将从解析库的选择、数据结构的优化、以及数据的生成与写入技术三个方面进行详细分析。

## 3.1 JSON解析库的选择与性能比较

### 3.1.1 Python标准库中的json模块

JSON数据的解析和生成是处理JSON数据时最基本的操作。Python标准库中的json模块是一个功能强大的工具

0

0