Python高级JSON处理:嵌套结构和大数据量的挑战解决方案

发布时间: 2024-09-20 04:53:30 阅读量: 174 订阅数: 82

WindowsQwen2.5VL环境搭建-执行脚本

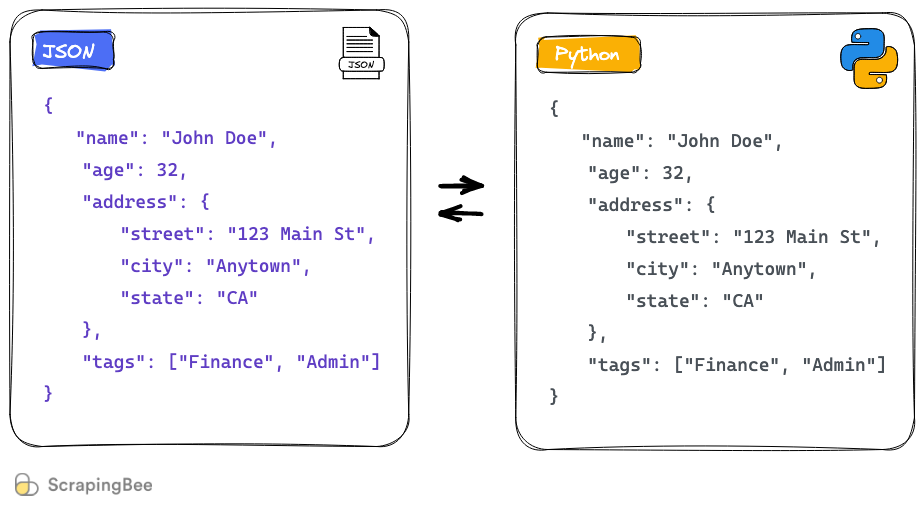

# 1. Python中的JSON处理概述

在Python中处理数据时,JSON(JavaScript Object Notation)因其轻量级和易于读写的特点成为广泛使用的数据交换格式。JSON不仅简单,而且跨平台,适用于不同的编程语言,使其成为了数据序列化的首选格式。本章节首先简要介绍JSON的基本概念,然后着重讨论如何在Python中读取和生成JSON数据,以及如何将JSON数据转换为Python对象,反之亦然。我们将通过示例代码展示如何使用Python的内置json模块处理JSON数据,包括序列化和反序列化操作,为接下来深入探讨JSON处理的高级主题奠定基础。

# 2. 嵌套JSON结构的解析与生成

### 2.1 JSON数据模型和嵌套结构

#### 2.1.1 JSON数据模型简介

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。JSON格式基于键值对(key-value pairs),可嵌套以构建复杂的数据结构。在Python中,JSON常被用来存储配置信息、网络数据交换或数据库存储。

#### 2.1.2 理解嵌套JSON结构

嵌套JSON结构通常意味着JSON对象内部包含了其他对象或数组,构成层级结构。这种结构可以反映复杂的数据关系,比如一个包含用户信息的JSON对象,可能嵌套了另一个表示地址的对象,甚至包含一个代表订单的数组。了解嵌套结构对于解析和生成嵌套JSON至关重要。

### 2.2 解析嵌套JSON

#### 2.2.1 Python中的JSON解析方法

在Python中,可以使用内置的`json`模块来处理JSON数据。对于嵌套JSON的解析,首先需要导入`json`模块并调用`loads()`函数将JSON字符串转换为Python字典。如果遇到嵌套结构,需要递归地遍历字典和列表。

示例代码:

```python

import json

# 假设json_str是包含嵌套JSON数据的字符串

json_str = '{"user": {"name": "John", "address": {"city": "New York"}}}'

# 解析JSON字符串

data = json.loads(json_str)

# 递归遍历嵌套的JSON数据

def parse_nested_json(data):

if isinstance(data, dict):

for key, value in data.items():

print(f"Key: {key}")

parse_nested_json(value)

elif isinstance(data, list):

for item in data:

parse_nested_json(item)

parse_nested_json(data)

```

#### 2.2.2 处理嵌套结构的技巧

处理嵌套JSON数据时,一种常用技巧是编写递归函数,该函数能够识别数据类型(字典或列表),并相应地处理。对于每个字典项,遍历键值对;对于列表,遍历元素。这种方法特别适用于不确定数据嵌套深度的情况。

### 2.3 生成嵌套JSON

#### 2.3.1 构建复杂JSON数据

生成复杂JSON数据通常涉及到构建嵌套的数据结构。在Python中,可以手动构建字典和列表的层级结构,然后使用`json.dumps()`方法将这些结构转换成JSON格式的字符串。

示例代码:

```python

# 构建嵌套字典

user = {

"name": "John",

"age": 30,

"address": {

"city": "New York",

"zip": "10001"

}

}

# 构建包含用户的订单列表

orders = [

{"id": "123", "amount": 100, "items": ["item1", "item2"]},

{"id": "456", "amount": 200, "items": ["item3", "item4"]}

]

# 创建更复杂的JSON结构

profile = {

"user": user,

"orders": orders

}

# 将Python对象转换为JSON字符串

json_str = json.dumps(profile, indent=4)

print(json_str)

```

#### 2.3.2 使用类和对象生成嵌套结构

为了提高代码的可读性和可维护性,可以使用Python类来表示JSON对象,利用对象的属性和方法来生成嵌套的JSON结构。这种方法不仅使代码更加模块化,还易于扩展。

示例代码:

```python

class Address:

def __init__(self, city, zip_code):

self.city = city

self.zip_code = zip_code

class User:

def __init__(self, name, age, address):

self.name = name

self.age = age

self.address = address

def to_json(self):

return {

"name": self.name,

"age": self.age,

"address": self.address.to_json()

}

# 创建实例

john_address = Address("New York", "10001")

john_user = User("John", 30, john_address)

# 转换为JSON格式

john_user_json = john_user.to_json()

# 输出JSON字符串

print(json.dumps(john_user_json, indent=4))

```

通过上述代码示例,可以了解如何在Python中利用内置的`json`模块来解析和生成嵌套的JSON结构,以及如何通过递归函数和类来处理更复杂的JSON数据。

# 3. 大数据量JSON数据的处理

在当今的数字时代,数据驱动的决策成为了企业和研究机构的核心战略。Python作为数据分析与处理领域的强大工具,它在处理大数据量JSON数据方面有着天然的优势。在本章节中,我们将深入探讨如何有效加载、存储、分析、查询以及优化大数据量JSON数据,以此来满足不同场景下的数据处理需求。

## 3.1 大数据量JSON的加载和存储

### 3.1.1 使用流式处理

在处理大规模JSON文件时,一次性将整个文件加载到内存中会遇到内存不足的问题。流式处理提供了一种逐步读取和解析数据的方法,使我们能够边读边处理数据,大大降低了内存使用。

```python

import json

def process_large_json(file_path):

with open(file_path, 'r', encoding='utf-8') as ***

***

***

* 在此处处理每一个JSON对象

process_json(json_data)

def process_json(json_data):

# 对json_data进行处理

pass

# 假设我们有一个大型JSON文件"large_data.json",它被格式化为多行

process_large_json("large_data.json")

```

在上述代码中,`process_large_json`函数通过逐行读取JSON文件,使用`json.loads()`将每行的字符串解析为Python字典或列表,并调用`process_json`函数进行进一步处理。这种方式有效地减少了内存的使用,并允许处理超过内存容量限制的文件。

### 3.1.2 分块加载和处理数据

流式处理虽有效,但有时需要根据数据块进行特定操作。Python标准库中的`iter()`函数可以配合自定义的`callable`来实现分块加载数据,这允许我们在解析整个文件之前检查每一块数据的结构。

```python

def chunked_json_iterator(file_path, chunk_size=1024):

"""Yields JSON objects from file."""

with open(file_path, 'r', encoding='utf-8') as ***

*** ''

while True:

while len(buffer) < chunk_size:

try:

buffer += file.next()

except StopIteration:

break

buffer, json_str = buffer[:chunk_size], buffer[chunk_size:]

json_obj = json.loads(json_str)

yield json_obj

if not file.next():

break

# 使用分块加载数据

for json_obj in chunked_json_iterator("large_data.json"):

process_json(json_obj)

```

这个例子中的`chunked_json_iterator`函数通过分块读取文件内容,并在达到一定大

0

0