GPU内存碎片处理:PyTorch分布式训练中的内存管理策略

发布时间: 2024-12-12 06:30:25 阅读量: 6 订阅数: 16

YOLO算法-城市电杆数据集-496张图像带标签-电杆.zip

# 1. GPU内存碎片问题概述

在现代高性能计算中,深度学习模型的训练依赖于大规模并行处理能力,其中GPU(图形处理单元)内存管理成为优化的重要环节。GPU内存碎片问题在长期间歇性或连续性训练任务中尤为突出,会显著降低计算效率和内存利用率。内存碎片是指GPU内存中出现大量未连续分配的小块内存,这种现象使得即便总体上存在足够内存,仍难以分配到足够大的连续内存块来满足某些特定计算需求,从而导致训练过程中的延迟甚至失败。

此问题的出现,归咎于内存分配和释放操作的不连续性以及缺乏有效的内存回收机制,特别是在大规模的深度学习应用中,不恰当的内存使用和管理策略会加剧内存碎片的产生。本章旨在从理论和实践两个层面,简要阐述GPU内存碎片的成因、影响及解决方案。

# 2. PyTorch内存管理理论基础

## 2.1 GPU内存架构与工作原理

### 2.1.1 GPU内存组件解析

在深入了解PyTorch内存管理之前,首先需要对GPU内存架构有一个基础的理解。现代GPU由多个流处理器(Streaming Multiprocessors,简称SM)组成,每个SM包含多个执行单元。GPU内存主要分为几个部分:全局内存(Global Memory)、共享内存(Shared Memory)、常量内存(Constant Memory)、纹理内存(Texture Memory)和寄存器(Registers)。

- **全局内存**:它是GPU上最大的内存池,可以被GPU中的任意线程访问。全局内存是所有并行执行单元共享的资源,它具有较高的延迟和较高的带宽,因此在性能调优时需要特别注意全局内存的访问模式。

- **共享内存**:对于每个SM而言,它拥有一个较小但速度非常快的内存区域,称为共享内存。共享内存用于线程间的通信,访问速度远远高于全局内存。合理利用共享内存,可以显著提高性能。

- **常量和纹理内存**:这两种内存主要用于存储只读数据。它们通过缓存机制提供了比全局内存更快的数据访问速度,但它们的空间较小,且不适合大规模数据访问。

- **寄存器**:寄存器是GPU上最快的内存类型,位于每个执行单元中,用于存储局部变量和中间结果。因为其速度快,数量有限,所以需要精心设计并行算法以减少寄存器溢出。

### 2.1.2 内存分配与释放机制

在GPU中,内存分配和释放机制依赖于GPU驱动程序和硬件。当GPU执行计算任务时,会根据需要从全局内存中分配空间。这些内存分配是由CUDA运行时API(如`cudaMalloc`)管理的。分配的内存在使用结束后应通过相应的释放函数(如`cudaFree`)进行释放。

在PyTorch中,GPU内存分配通常由框架自动处理。当调用`.to(device)`将张量(Tensor)分配到GPU时,CUDA运行时会在后台管理内存。例如:

```python

import torch

# 创建一个张量并分配到GPU

tensor = torch.tensor([1, 2, 3], device='cuda')

```

在上述代码中,`tensor`张量实际上是在GPU上进行内存分配的结果。PyTorch内部实现了内存池化和缓存机制来优化内存的使用,减少内存碎片的产生。

## 2.2 PyTorch中的内存管理机制

### 2.2.1 内存池化与缓存机制

PyTorch使用内存池化来避免频繁的内存分配和释放操作,这样可以显著提高内存管理的效率,减少内存碎片的产生。内存池化确保内存的重用,避免每次请求都进行全新分配。

当需要分配内存时,PyTorch会首先检查是否有足够的空闲内存可以重用。如果存在足够空闲的内存块,就会直接使用这些内存块而不需要调用CUDA API来分配新的内存。这一机制通过`MemoryAllocator`类来实现,它允许PyTorch追踪和管理内存。

### 2.2.2 PyTorch内存分配策略

PyTorch使用策略化的内存分配方法来处理内存的使用和重用。在运行时,PyTorch会基于操作的类型和大小来做出内存分配决策。为了减少内存碎片,PyTorch尝试优先满足大的内存请求,并在满足当前请求后留出足够的空间供将来使用。

当处理不同类型的张量操作时,PyTorch的内存分配器会根据预设的策略来决定是否进行内存重分配。例如,当一个操作需要的内存超出当前可用空闲内存时,内存分配器会尽可能地寻找一个足够大的空闲内存块进行分配。

### 2.2.3 内存碎片产生的原因分析

内存碎片是一个常见问题,它会导致可用内存总量减少。在PyTorch中,内存碎片可以由多种因素引起,包括频繁的内存分配和释放、内存分配大小不一致、以及在已有的内存中尝试分配一个不连续的空间等。

为了避免或减少内存碎片,开发者应尽量减少小块内存的分配,使用内存池化机制,以及确保内存分配请求的大小尽可能一致。此外,PyTorch提供了自定义的内存分配器,允许开发者根据具体的应用场景实现更细致的内存管理策略。

```python

# 通过自定义内存分配器来优化内存使用

import torch

def customAllocator(size):

# 自定义内存分配逻辑

# ...

return allocatedPointer

# 注册自定义内存分配器

torch.cuda.set allocator(customAllocator)

```

通过上述代码,开发者可以实现一个自定义的内存分配器,并通过`torch.cuda.set_allocator`方法注册到PyTorch中以优化内存分配。

在下一节中,我们将探索PyTorch在分布式训练环境中的内存管理策略,并深入讨论如何优化和处理内存碎片问题。

# 3. PyTorch分布式训练内存管理实践

## 3.1 分布式训练的基本原理与挑战

### 3.1.1 分布式训练架构简介

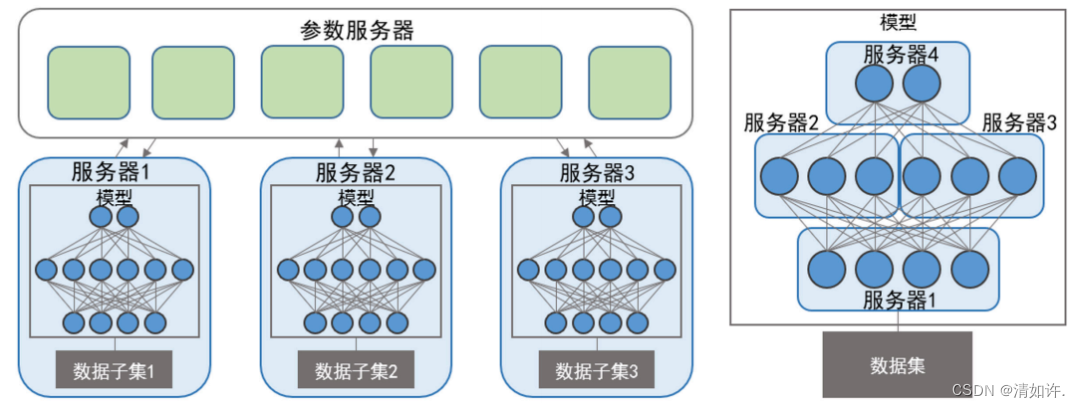

分布式训练是深度学习领域的一项关键技术,它允许在多个GPU上并行地训练模型,从而显著减少训练时间,并提高模型的规模和性能。PyTorch通过提供`torch.nn.parallel`模块,使得用户可以轻松实现数据并行和模型并行。

**数据并行**是指将训练数据集分割成多个批次(batch),然后将它们并行地发送到不同的GPU上进行处理。每个GPU负责计算前向传播和反向传播,然后梯度从各GPU上汇总,更新模型参数。

**模型并行**则是将模型的不同部分分配到不同的GPU上,通常用于模型过于庞大以至于无法完全加载到单个GPU的情况。

### 3.1.2 分布式训练中的内存问题

尽管分布式训练提供了强大的计算能力,但也带来了一系列内存管理上的挑战。内存碎片问题在分布式训练中尤为显著,因为模型需要在多个设备间频繁迁移数据。此外,不同GPU上的内存使用可能不均衡,导致某些设备过早耗尽内存。

内存管理在分布式训练中涉及诸多方面,例如,如何有效地在多个设备间同步和分配数据、如何处理不同设备间的内存占用差异以及如何减少内存使用、优化内存碎片等。

## 3.2 PyTorch内存管理策略优化

### 3.2.1 针对GPU内存碎片的优化技巧

为了解决GPU内存碎片问题,PyTorch社区提出了一系列优化技巧。首先,确保合理地设置内存预分配策略,例如预先分配一个足够大的内存池,以减少动态内存分配的次数。

其次,可以利用PyTorch提供的`torch.cuda.empty_cache()`函数周期性地清理未使用的内存,以释放内存碎片。此外,通过设置`pin_memory=True`可以优化数据加载到GPU的过程,减少内存拷贝次数。

### 3.2.2 动态内存分配与去碎片化技术

PyTorch提供了动态内存分配的策略,通过`torch.no_grad()`和`torch.set_grad_enabled()`来控制梯度计算的内存使用,以减少不必要的内存占用。

去碎片化技术通常由内存管理库实现,例如CUDA中的`cudaMallocMa

0

0