【LightGBM模型调优实战】:网格搜索VS随机搜索,技术对比与选择

发布时间: 2024-09-30 14:22:28 阅读量: 39 订阅数: 46

# 1. LightGBM模型调优概述

在机器学习领域,模型调优是提高预测性能的关键环节。对于梯度提升决策树模型LightGBM而言,合理的调优方法可以显著提升模型的准确性和效率。本章将概述LightGBM模型调优的重要性和基本策略,为后续章节中详细介绍网格搜索和随机搜索等具体方法奠定基础。

LightGBM是微软开发的一个高效、分布式、高性能的梯度提升框架,广泛应用于分类、排序、以及其他机器学习任务中。它专为处理大规模数据而设计,通过直方图算法加速了训练过程,并减少了内存消耗。然而,即使是高效的LightGBM,也需要通过精心的超参数调优来实现最佳性能。

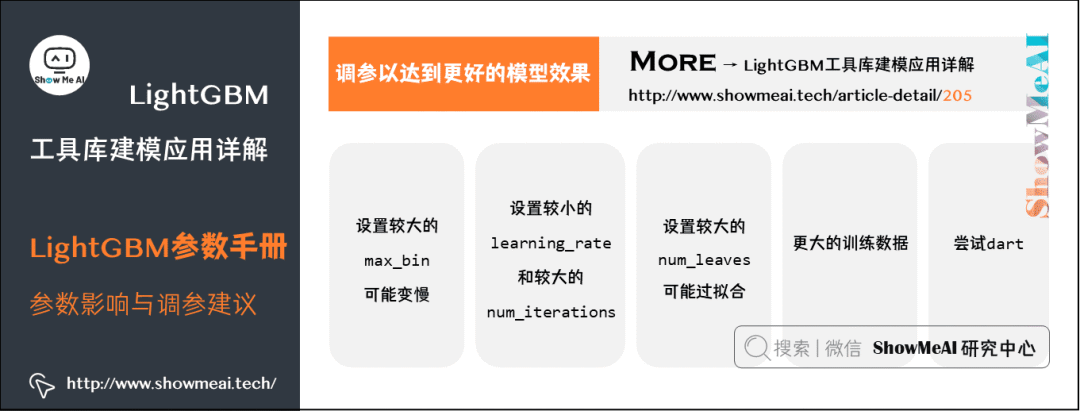

模型调优通常涉及对学习率、树的数量、树的深度等超参数的选择。这些超参数的设置直接影响模型的泛化能力和计算成本。因此,找到一个平衡点,即在资源允许的情况下达到最好的性能,是调优过程的主要目标。

# 2. 网格搜索在LightGBM中的应用

在介绍网格搜索在LightGBM中的应用前,理解LightGBM模型是至关重要的。LightGBM是微软推出的一种基于梯度提升框架的高效机器学习算法,特别适合处理大规模数据集。它通过使用基于直方图的算法减少了内存消耗,并通过避免不必要的比较来提高了速度。

## 2.1 网格搜索基本原理与优势

### 2.1.1 网格搜索的工作流程

网格搜索是超参数优化的穷举方法,其主要思想是遍历预设的参数组合。在LightGBM模型中应用网格搜索需要以下步骤:

1. **定义参数网格**:首先,明确你需要优化的LightGBM参数及其值的范围。

2. **交叉验证**:为了更准确地评估模型性能,通常在网格搜索过程中结合交叉验证。

3. **搜索过程**:通过遍历所有参数组合,模型会对每一组合进行训练和验证。

4. **结果选择**:最后,根据评估指标选择最佳参数组合。

### 2.1.2 网格搜索的优势分析

网格搜索在理论简单性和结果的可靠性方面有明显优势:

- **全面性**:覆盖了参数空间中的所有可能组合,避免了错过最佳参数设置。

- **直观性**:对参数优化空间进行可视化,便于理解和解释。

- **易于实现**:基于简单的循环遍历,易于用任何编程语言实现。

## 2.2 网格搜索实践:LightGBM超参数调优

### 2.2.1 选择超参数范围

为了进行网格搜索,需要先确定你想要调整的LightGBM参数。这些参数可能包括但不限于:

- `num_leaves`

- `max_depth`

- `learning_rate`

- `n_estimators`

- `min_data_in_leaf`

- `bagging_fraction`

对于这些参数,你需要根据问题的性质、数据集的规模和已有的实验经验来设定一个合理的取值范围。

### 2.2.2 实现网格搜索流程

使用Python的`sklearn`库结合`GridSearchCV`可以方便地实现网格搜索,以下是一个基本的例子:

```python

from lightgbm import LGBMClassifier

from sklearn.model_selection import GridSearchCV

# 定义模型

model = LGBMClassifier()

# 参数网格

param_grid = {

'num_leaves': [15, 31, 63],

'max_depth': [3, 5, 7],

'learning_rate': [0.01, 0.1],

'n_estimators': [100, 200]

}

# 网格搜索

grid_search = GridSearchCV(model, param_grid, cv=5, scoring='accuracy')

# 执行网格搜索

grid_search.fit(X_train, y_train)

# 获取最佳参数

best_params = grid_search.best_params_

```

### 2.2.3 结果分析与优化建议

网格搜索完成后,我们需要对结果进行分析,并给出进一步的优化建议:

- **结果分析**:检查`best_params_`来了解哪些参数组合表现最佳。

- **性能评估**:通过`grid_search.best_score_`来评估模型在最佳参数下的性能。

- **优化建议**:如果性能未达到预期,可能需要重新考虑参数范围、增加更多的计算资源或者尝试其它的优化方法。

## 2.3 网格搜索的局限性与挑战

### 2.3.1 计算资源的高消耗

由于网格搜索需要尝试参数空间中的每一个可能组合,因此计算资源的消耗与参数范围的大小成指数关系。

- **内存限制**:训练大量的模型可能导致内存不足。

- **时间成本**:在大规模数据集和复杂模型上,网格搜索可能需要非常长的时间。

### 2.3.2 高维度超参数空间的处理

当参数数量增加时,网格搜索的效率会急剧下降。

- **维度的诅咒**:随着参数维度的增加,需要评估的组合数量将呈指数级增长。

- **策略调整**:在高维参数空间中,可能需要转向更高效的搜索方法,比如随机搜索或贝叶斯优化。

通过这些信息,你已经了解到网格搜索在LightGBM模型调优中的应用。尽管网格搜索在理论上具有吸引力,但它的实际应用受限于计算资源和问题的复杂性。在下一章节中,我们将探讨随机搜索在LightGBM中的应用,以及它如何解决网格搜索的一些不足。

# 3. 随机搜索在LightGBM中的应用

## 3.1 随机搜索基本原理与优势

随机搜索是一种超参数优化策略,与网格搜索等基于穷举的方法不同,它在指定的超参数空间内随机选择参数组合进行模型训练。随机搜索的工作流程较为简单,通常涉及以下步骤:定义超参数空间,随机生成参数组合,使用这些参数组合训练模型,并记录性能指标。通过这种方式,随机搜索避免了穷举所有可能性,从而在计算资源消耗上具有明显优势。

### 3.1.1 随机搜索的工作流程

在随机搜索的实施过程中,首先需要定义一个超参数搜索空间,这通常涉及确定每一个超参数可能的取值范

0

0