【Python3与tokenize的兼容之路】:版本差异及其在新环境下的适配

发布时间: 2024-10-05 16:05:07 阅读量: 48 订阅数: 45

# 1. Python3与tokenize概述

Python是一种广泛使用的高级编程语言,其简洁明了的语法和强大的功能库让它在众多领域得到了广泛的应用。随着Python2与Python3的不断演进,了解它们之间的差异以及如何利用tokenize模块进行代码处理变得尤为重要。tokenize模块是Python标准库中的一个工具,它能够将Python源代码分解成一个个的token(词法单元),这对于代码分析、静态检查和安全审计等领域都有着不可忽视的作用。本章节将介绍Python3与tokenize的基础知识,为后续的深入讨论打下基础。

# 2. Python2与Python3的tokenize差异

## 2.1 语法层面的变化

### 2.1.1 字符串与编码的变化

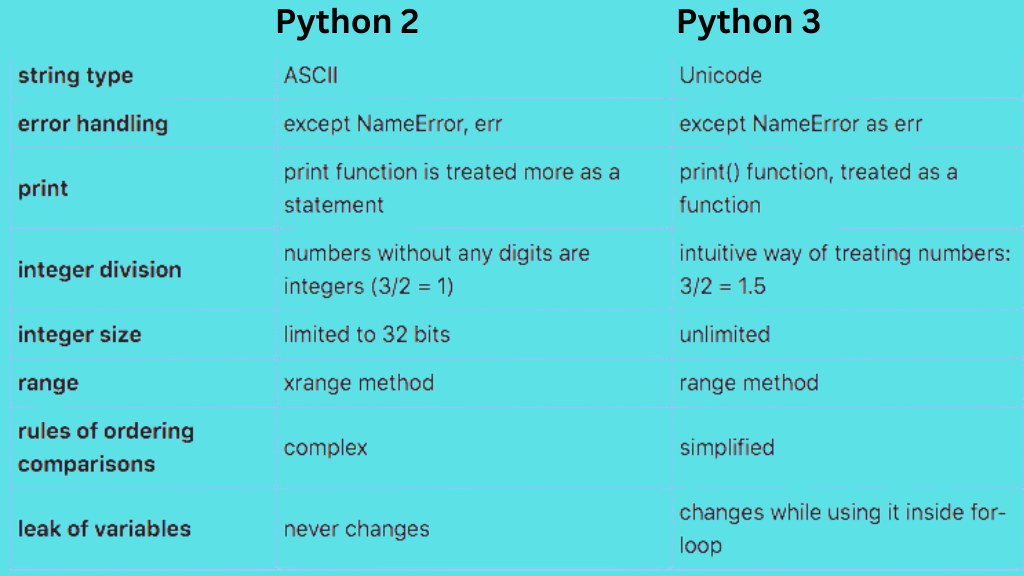

Python 3对字符串和编码做了重大改进,以更好地支持国际化。Python 2中,字符串分为普通字符串和Unicode字符串,而Python 3则统一使用Unicode字符串。这意味着在Python 3中,所有的字符串默认为Unicode,而bytes类型则用于二进制数据。这一改变导致了在Python 3中使用字符串操作时,必须进行一些调整。

一个主要的差异是字符串字面量的处理。在Python 2中,字符串默认为ASCII编码,而在Python 3中,它们默认为Unicode。例如:

```python

# Python 2

s = '中文'

print type(s) # 输出: <type 'str'>

# Python 3

s = '中文'

print(type(s)) # 输出: <class 'str'>

```

在Python 3中,由于所有字符串默认为Unicode,这就简化了对非ASCII字符的处理。而Python 2中的编码问题经常导致难以察觉的错误,因为在许多情况下,开发者会忘记正确处理Unicode。

### 2.1.2 迭代器和生成器的区别

Python 3引入了一些变化,使得迭代器和生成器的使用更加直观和一致。这些变化包括去除了一些在Python 2中存在但不推荐使用的过时方法,并提供了一些新的语法糖,使得迭代器的使用更加自然。

在Python 2中,`next()` 函数用于获取迭代器的下一个元素,但在Python 3中,引入了`__next__()` 方法来替代。同时,Python 3支持`for...in...`循环直接与迭代器一起工作,不再需要调用`iter()`函数。

例如,在Python 2中迭代一个列表:

```python

# Python 2

aList = [1, 2, 3]

it = iter(aList)

print next(it) # 输出: 1

```

在Python 3中:

```python

# Python 3

aList = [1, 2, 3]

print(next(it)) # 输出: 1

```

### 2.1.3 函数与装饰器的改变

Python 3对函数和装饰器的语法也做了优化,特别是引入了新的`print`函数和一些装饰器语法的变化。在Python 2中,`print`是一个语句,而在Python 3中,它变成了一个函数,这允许它接受可变数量的参数和关键字参数,使得自定义`print`行为变得更加容易。

```python

# Python 2

print "Hello, world!"

# Python 3

print("Hello, world!")

```

## 2.2 标准库的演进

### 2.2.1 标准库的新增与弃用

随着Python 3的发布,标准库也发生了演进,一些过时的模块被弃用,新的模块被加入以满足现代编程的需求。在Python 3中,一些在Python 2中过时的模块如`httplib`和`urlparse`已被重构或替换,分别由`http.client`和`urllib.parse`替代。

Python 3还引入了一些新的模块,如`statistics`,它提供了各种统计数据的计算功能,而这些功能在Python 2中是缺失的。此外,像`enum`模块提供枚举类型的官方支持,而`pathlib`提供了面向对象的文件系统路径操作。

### 2.2.2 兼容性问题的解决方法

迁移Python 2代码到Python 3时,开发者会遇到一些兼容性问题。一个常见的解决策略是使用`2to3`工具,它是Python 3的一部分,用于自动化地将Python 2代码转换为Python 3代码。`2to3`能够处理大多数常见的兼容性问题,但它不能解决所有问题。开发者需要手动调整一些涉及语言核心变化的代码段。

例如,`2to3`工具能自动处理`print`语句的转换,但对于某些过时的模块使用,则需要人工介入进行替换或重写。

## 2.3 tokenize模块的升级

### 2.3.1 tokenize模块在Python3中的改进

Python 3对`tokenize`模块进行了一些改进以支持新的语言特性。这些改进包括对新语法的识别,例如async/await异步编程语法,以及对Python 3特有的字符串字面量的处理。

Python 3的`tokenize`模块能够更准确地识别Unicode字符串和bytes字面量,这对于处理包含非ASCII字符的源代码非常有用。模块中增加的`tokenize.generate_tokens()`函数提供了一个迭代器,可以用来逐个地生成源代码中的token。

### 2.3.2 Python2到Python3迁移中的问题与解决方案

迁移过程中,开发者可能会遇到的一个主要问题是语法差异导致的错误。例如,在Python 2中有效的语法在Python 3中可能已经不再使用或有所改变。`tokenize`模块在这里可以发挥作用,通过生成源代码的token流,帮助开发者理解Python 3中代码的行为。

开发者可以通过比较token流来检查源代码中的不兼容部分。例如,Python 2中的`print`语句在Python 3的token流中会表现出不同的token类型。了解这些差异,开发者可以使用`2to3`工具或手动进行调整,确保代码的正确迁移。

在此过程中,一些常见的解决方案包括:

- 使用`2to3`工具自动转换代码。

- 采用`AST`(抽象语法树)分析工具手动检查并修改代码。

- 在持续集成(CI)系统中集成`tokenize`检查,确保新的代码提交符合Python 3的语法标准。

通过这些方法,开发者可以有效地解决迁移过程中遇到的兼容性问题,并确保代码的顺利迁移到Python 3环境。

# 3. 新环境下tokenize的应用实践

随着Python在各个领域不断普及,其版本也在不断更新。Python 3带来了很多改进,其中tokenize模块在代码分析、安全审计和第三方工具开发中扮演了重要角色。在本章中,我们将深入了解tokenize模块在新环境下的应用实践,涵盖从代码分析到安全审计以及第三方工具开发中使用tokenize的实例。

## 3.1 tokenize在代码分析中的使用

### 3.1.1 代码静态分析的实例

tokenize模块能够将Python源代码分解为一个个有意义的语法单元,称为tokens。在静态分析中,程序员可以利用tokenize模块提取出代码的结构信息,进行代码质量评估,甚至自动化重构。

以下是使用tokenize模块进行代码静态分析的一个简单示例:

```python

import tokenize

# 定义一个函数,用于输出tokens

def print_tokens(source_code):

tokens = tokenize.generate_tokens(source_code.splitlines().__next__)

for toknum, tokval, _, _, _ in tokens:

print(f"Token: {tokval}({toknum})")

# 示例代码

code = """

def hello_world():

print("Hello, world!")

# 执行静态分析

print_tokens(code)

```

上述代码将源代码字符串分解为tokens,并打印出来。这是利用tokenize进行静态分析的基础操作。通过分析不同的token类型和值,可以进一步设计出复杂的静态分析工具。

### 3.1.2 重构和代码质量改进

静态分析的一个重要应用是自动化重构和代码质量改进。通过tokenize提取代码信息,开发者可以检测代码风格的不一致性、潜在的错误以及其他可优化的地方。

这里展示一个简单的重构例子,将Python 2代码中的老式类声明转换为Python 3的风格:

```python

import tokenize

import io

def upgrade_to_new_style_class(source_code):

tokens = tokenize.generate_tokens(io.StringIO(source_code).readline)

upgraded_code = ''

for toknum, tokval, _, _, _ in tokens:

# 当遇到class关键字时,确保后面跟的是新式类声明

if toknum == tokenize.NAME and tokval == 'class':

upgraded_code += tokval + ' ' + tokval.upper() + ' '

else:

upgraded_code += tokval

return upgraded_code

original_code = """

class MyClass(object):

pass

# 执行代码升级

new_code = upgrade_to_new_style_class(original_code)

print(new_code)

```

此段代码展示了如何利用tokenize进行简单的代码重构。通过检测`class`关键字并确保其后跟的是新式类声明,可以实现代码风格的升级。

## 3.2 tokenize在安全审计中的应用

### 3.2.1 审计Python代码的安全性

在软件开发中,安全审计是确保代码质量的重要环节。通过tokenize模块,可以逐token检查代码,识别潜在的安全问题,如SQL注入、跨站脚本攻击(XSS)等。

例如,以下代码段展示了如何使用tokenize来查找Python代码中的硬编码密码:

```python

import tokenize

# 假设硬编码密码的token值是“password”

HARDCODED_PASSWORD_TOKEN_VALUE = 'password'

# 定义检查函数

def find_hardcoded_passwords(source_code):

tokens = tokenize.generate_tokens(io.StringIO(source_code).readline)

for toknum, tokval, _, _, _ in tokens:

if tokval == HARDCODED_PASSWORD_TOKEN_VALUE:

print(f"Found hardcoded password: {tokval}")

# 模拟源代码

code_with_password = """

user = 'admin'

password = 'password'

# 执行安全审计

find_hardcoded_passwords(code_with_password)

```

此例中,通过定义特定的token值并进行检索,可以简单地检测硬编码密码。在实际应用中,审计规则会更复杂,可能需要考虑上下文和多种潜在的危险模式。

### 3.2.2 token级别安全扫描的实现

更深入的安全审计可以采用更细粒度的token级别检查。这涉及到解析token序列以检测复杂的模式和代码结构

0

0