【Python字符串处理高手】:使用tokenize库解析复杂的代码结构

发布时间: 2024-10-05 15:35:46 阅读量: 37 订阅数: 42

无需编写任何代码即可创建应用程序:Deepseek-R1 和 RooCode AI 编码代理.pdf

# 1. Python字符串处理和tokenize库简介

Python作为一种流行的编程语言,在文本处理方面具有强大的功能。字符串作为文本的基本单位,其处理方式直接影响到数据的清洗、分析和展示等多个环节。在本章节中,我们将首先探讨Python字符串处理的基础知识,并简要介绍tokenize库在字符串和代码分析中的重要作用。

## 1.1 Python字符串的多样性与灵活性

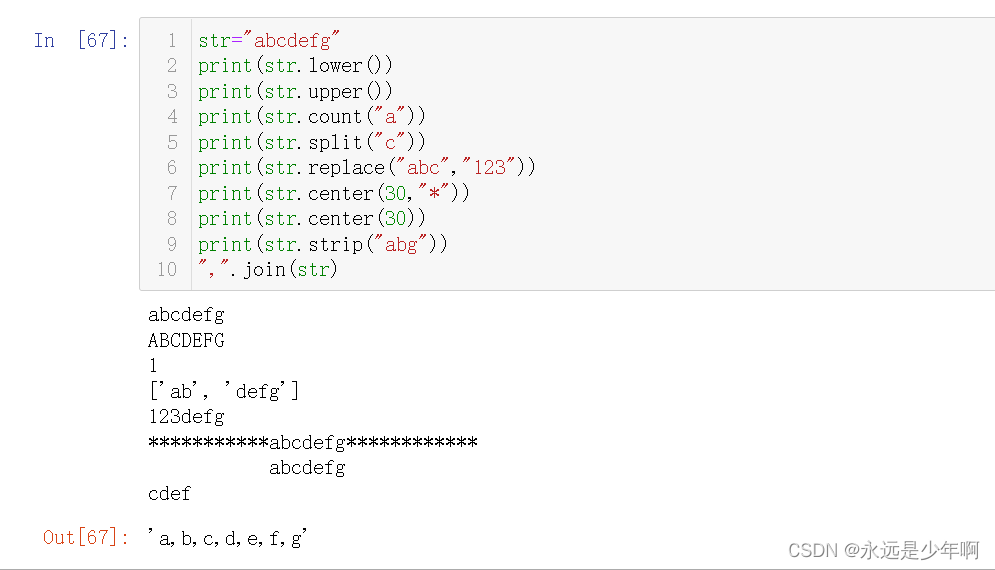

Python字符串可以通过多种方式定义,如单引号、双引号、三引号等,同时支持Unicode编码。在处理字符串时,Python提供了丰富的内建方法,如`replace`, `split`, `join`等,使得字符串的分割、替换和连接操作变得简单快捷。

## 1.2 tokenize库的引入和作用

当涉及到Python代码的分析和处理时,字符串处理就显得尤为重要。Python的tokenize库允许开发者将源代码分解成一个个的token(令牌),这些令牌可以是关键字、标识符、字面量等。通过理解tokenize库的工作机制,开发者可以更深入地分析代码结构,实现如代码高亮、静态分析、重构和自动生成代码等高级功能。在接下来的章节中,我们将进一步探索tokenize库的使用原理及其在不同场景下的应用。

# 2. 深入理解Python的字符串处理

字符串是程序设计中最基础且常见的数据类型之一,尤其在文本处理和分析任务中,字符串操作的性能与技巧往往直接影响到整个应用的效率和质量。本章将详细介绍Python字符串处理的各个方面,从基础到高级应用,使读者能够灵活运用字符串处理技术解决复杂问题。

## 2.1 Python字符串基础

### 2.1.1 字符串定义和基本操作

Python中字符串是不可变序列,以单引号(' ')或双引号(" ")定义。字符串的基本操作包括索引、切片、连接、重复等。例如:

```python

s = "Hello, World!"

print(s[0]) # 输出: H

print(s[7:]) # 输出: World!

print(s * 2) # 输出: Hello, World!Hello, World!

```

字符串操作的性能考量,需要避免重复创建和销毁字符串对象,尤其是在循环和大量数据处理时,使用更高效的数据结构如`str.join()`方法或`io.StringIO`。

### 2.1.2 字符串的编码和解码

Python字符串支持多种编码格式,如UTF-8、ASCII等。编码是将字符串转化为字节序列,解码则是逆过程。在处理国际化文本时,正确使用编码解码尤其重要。

```python

# 将字符串编码为UTF-8字节序列

utf8_encoded = 'Hello, 世界!'.encode('utf-8')

print(utf8_encoded) # 输出: b'Hello, \xe4\xb8\x96\xe7\x95\x8c!'

# 将UTF-8字节序列解码为字符串

utf8_decoded = utf8_encoded.decode('utf-8')

print(utf8_decoded) # 输出: Hello, 世界!

```

在编码和解码时需要注意字符集兼容性和异常处理,如遇到无法解码的字节序列时,应提供合理的错误处理机制。

## 2.2 高级字符串处理技巧

### 2.2.1 字符串格式化方法对比

Python提供了多种字符串格式化方法,包括`%`格式化、`str.format()`方法和f-string。每种方法有其特点和适用场景。

```python

# 使用%格式化

old_style = "Name: %s, Age: %d" % ('Alice', 25)

print(old_style)

# 使用str.format()

new_style = "Name: {}, Age: {}".format('Bob', 30)

print(new_style)

# 使用f-string(Python 3.6+)

fstring_style = f"Name: {name}, Age: {age}" # name和age需提前定义

print(fstring_style)

```

f-string提供了最快和最简洁的格式化方式,但它依赖于Python 3.6以上版本。

### 2.2.2 正则表达式在字符串处理中的应用

正则表达式是处理字符串的强大工具,它通过模式匹配来搜索、替换和提取字符串中的信息。Python通过`re`模块提供正则表达式功能。

```python

import re

# 使用正则表达式查找字符串中的数字

text = "The year is 2023."

numbers = re.findall(r'\d+', text)

print(numbers) # 输出: ['2023']

```

在使用正则表达式时,需注意表达式的复杂性和性能开销,尤其是无限回溯问题和贪婪/懒惰匹配的区别。

## 2.3 字符串处理的最佳实践

### 2.3.1 性能考量与优化

在字符串处理中,性能优化通常关注内存使用和执行时间。例如,在处理大型文件时,逐行读取文件比一次性读取整个文件更节省内存。

```python

with open('large_file.txt', 'r') as ***

***

* 处理每一行

pass

```

### 2.3.2 安全性考量与防护策略

字符串处理还涉及安全性问题,特别是在用户输入处理和网络通信中。防止注入攻击、数据泄露等是必要的。

```python

# 使用字符串格式化时避免使用 %s, 而使用更安全的方法如str.format()或f-string

safe_format = "Hello, {}!".format(name)

print(safe_format)

```

本章节深入讲解了Python字符串处理的基础知识、高级技巧、性能考量以及安全性防护,旨在帮助读者掌握字符串处理的核心技能,并在实际开发中灵活运用。

# 3. tokenize库的使用原理

## 3.1 tokenize库解析机制

### 3.1.1 tokenize库的工作流程

Python的解释器在执行源代码之前,会将其分解成一系列的令牌(tokens)。这个分解过程由内置的`tokenize`库来实现,其工作流程如下:

1. **源代码输入**:首先,`tokenize`库接收源代码作为输入。这些源代码是字符串形式的Python代码。

2. **词法分析**:随后,源代码通过一个词法分析器(lexer),它会逐字符读取代码,并将字符序列转换成有意义的符号或令牌(token),例如变量名、关键字、操作符、括号等。

3. **令牌生成**:词法分析器产生一个令牌流,这些令牌按照源代码的逻辑结构排列,比如表达式、语句等。

4. **令牌类型分类**:每个令牌都被赋予一个类别,如`NUMBER`、`NAME`、`OP`等,这些类别有助于进一步的语法分析。

为了更好地理解`tokenize`库的工作流程,下面是一个简单的代码示例:

```python

import tokenize

# 源代码字符串

source_code = "print('Hello, World!')"

# 解析源代码并打印令牌信息

tokens = tokenize.tokenize(iter(source_code).__next__)

for token in tokens:

print(token)

```

这段代码将会输出如下令牌列表:

```

TokenInfo(type=62 (NAME), string='print', start=(1, 0), end=(1, 5), line="print('Hello, World!')")

TokenInfo(type=54 (LPAR), string='(', start=(1, 5), end=(1, 6), line="print('Hello, World!')")

TokenInfo(type=3 (STRING), string="'Hello, World!'", start=(1, 6), end=(1, 17), line="print('Hello, World!')")

TokenInfo(type=55 (RPAR), string=')', start=(1, 17), end=(1, 18), line="print('Hello, World!')")

TokenInfo(type=0 (NEWLINE), string='\n', start=(1, 18), end=(1, 19), line="print('Hello, World!')")

TokenInfo(type=-1 (ENDMARKER), string='', start=(1, 19), end=(1, 19), line='')

```

### 3.1.2 令牌(token)类型详解

Python中定义了不同的令牌类型,用以表示不同的语法元素。令牌类型是`tokenize`库中的一个枚举,可以通过`tokenize`模块的`token`属性访问。下面是一些常用的令牌类型:

- `NAME`:表示一个名字,如变量名、函数名等。

- `NUMBER`:表示一个数值,比如整数或浮点数。

- `STRING`:表示一个字符串。

- `OP`:表示一个操作符,比如`+`, `-`, `*`, `/`等。

- `NEWLINE`:表示新行的开始。

- `INDENT`和`DEDENT`:表示代码块的缩进和取消缩进。

- `LPAR`, `RPAR`, `LBRACE`, `RBRACE`:分别表示小括号、大括号的开闭。

- `COLON`:表示冒号,比如在`if`语句中。

- `ENDMARKER`:表示源代码结束的特殊标记。

令牌类型对于理解`tokenize`库如何将代码分解为可管理的部分至关重要。理解这些类型有助于开发者开发出更精确的代码分析工具。

## 3.2 tokenizing Python源代码

### 3.2.1 从语法树到令牌流的转换

在深入探讨如何处理不同类型的Python语句之前,了解从语法树到令牌流的转换过程是很有帮助的。

Python代码在执行前被转换成抽象语法树(Abstract Syntax Tree,简称AST),之后`tokenize`模块将AST转换为令牌流。这一过程允许开发者能够对程序代码进行底层分析。

语法树是一个树状结构,节点表示了程序中的不同语法成分。例如,函数调用将是一个树节点,其子节点可能包括函数名称、括号以及括号内表达式的AST结构。

通过`tokenize`库,我们可以轻松地将源代码转换为令牌流,然后再将其转换回AST。但通常情

0

0