tokenize库高级技巧揭秘:自定义Token解析器提升代码分析效率

发布时间: 2024-10-05 15:21:12 阅读量: 31 订阅数: 27

# 1. tokenize库简介与原理

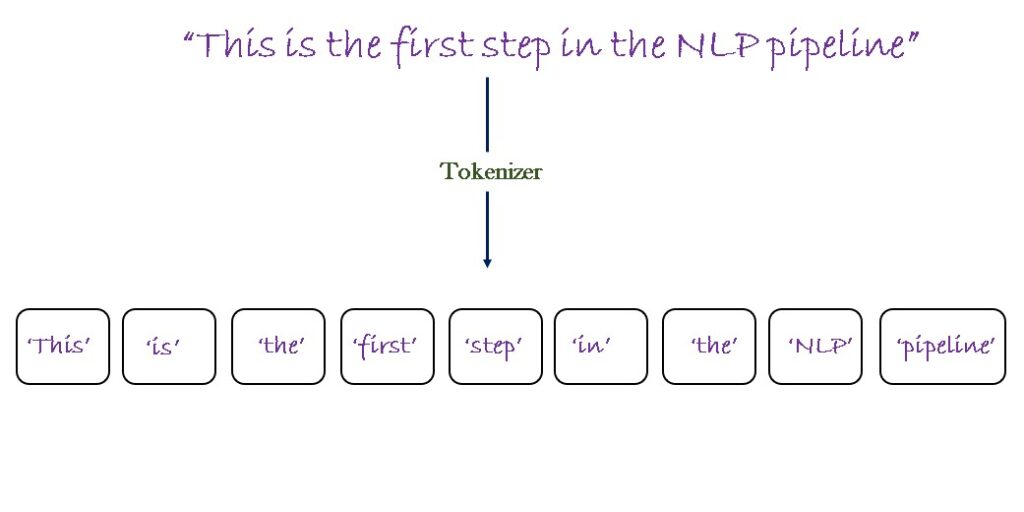

## 1.1 tokenize库是什么

tokenize库是一个用于在编程语言处理中将源代码分解成一个个具有独立意义的符号(Token)的工具库。其基本功能包括将源代码文本转换为Token列表,以便进一步的语法分析、代码分析或代码生成等处理。

## 1.2 tokenize的工作原理

工作原理上,tokenize库通常包含两个主要步骤:扫描(Scanning)和解析(Parsing)。扫描步骤会将源代码文本逐字符读取并转换成Token。解析步骤则是根据语言的语法规则,将Token转化为抽象语法树(AST)等结构。

## 1.3 tokenize库的应用场景

在众多应用中,tokenize库被广泛应用于编译器前端处理、代码静态分析、IDE代码智能提示以及脚本语言的解释执行。通过理解tokenize库的原理和使用方法,开发者能够提高代码处理的自动化水平和效率。

# 2. 自定义Token解析器的构建基础

自定义Token解析器是程序语言处理工具的核心组件之一,它能够将源代码文本分解成一系列的标记(Token),这些标记是编译器、解释器和其他语言处理工具进行进一步分析和处理的依据。为了构建一个高效、可维护的解析器,理解其设计原则、分类识别方法以及编译过程是至关重要的。

## 2.1 解析器设计原则

设计一个自定义Token解析器时,有几个核心原则需要考虑。这些原则决定了解析器的灵活性、扩展性和健壮性。

### 2.1.1 可扩展性与模块化

解析器的可扩展性指的是在不改变现有代码结构的情况下,容易地添加新的功能或对现有功能进行修改。模块化是可扩展性的基础,它允许开发者将解析器划分成独立的模块,每个模块负责处理一种或一类Token。

为了实现模块化,设计时应该:

- 定义清晰的接口和抽象类,为不同类型的Token处理提供统一的操作方法。

- 使用依赖注入和工厂模式等设计模式,让模块间的耦合度最小化。

- 使用测试驱动开发(TDD)的方法,编写可重用的单元测试,确保新增功能不会破坏现有的功能。

### 2.1.2 解析器的错误处理机制

在解析源代码的过程中,经常会遇到格式错误、关键字误用等情况。一个良好的解析器需要能够准确地定位到错误发生的位置,并给出合理的错误提示信息。

解析器的错误处理机制应该包括:

- 错误捕获:通过异常处理机制来捕获解析过程中可能出现的异常。

- 错误定位:记录错误发生的位置,以便于开发者能够迅速定位问题。

- 错误恢复:提供策略来尽可能地恢复解析过程,例如跳过当前行或自动修正某些类型的错误。

## 2.2 Token的分类与识别

Token是程序语言处理的基本单元,它们代表了源代码中的标识符、关键字、运算符等元素。理解Token的分类以及如何准确识别它们是构建解析器的关键步骤。

### 2.2.1 常见的Token类型

常见的Token类型包括:

- 标识符:变量名、函数名等。

- 关键字:程序语言中的保留字,如 `if`、`else`、`return`。

- 字面量:数字、字符串等。

- 运算符:加减乘除、逻辑运算符等。

- 分隔符:括号、逗号、分号等。

### 2.2.2 正则表达式在Token识别中的应用

正则表达式是识别Token的强大工具。它能够根据预定的模式匹配字符串,从而识别出各种类型的Token。

使用正则表达式进行Token识别时,需要注意:

- 确保正则表达式能够覆盖所有可能的Token类型,并且彼此之间不会发生冲突。

- 对于复杂的Token识别规则,应该考虑性能因素,避免过于复杂的正则表达式导致性能下降。

- 在实现时,要考虑到转义字符、前后文相关性等因素。

## 2.3 解析器的编译过程

解析器的编译过程通常包括两个主要阶段:词法分析和语法分析。这个过程将源代码文本转换为抽象语法树(AST),后续的语义分析、代码生成等步骤都将基于这个树结构进行。

### 2.3.1 词法分析与语法分析的原理

- **词法分析(Lexical Analysis)**:这个过程将源代码文本分解成一个个Token。例如,通过空格、换行等分隔符将语句分开,再通过正则表达式匹配识别出具体的Token类型。

- **语法分析(Syntax Analysis)**:在词法分析的基础上,根据语言的语法规则将Token序列组合成抽象语法树。这一步骤通常使用递归下降解析、LL(1)、LR(1)等算法。

### 2.3.2 解析器状态机的设计与实现

解析器的状态机模型是实现词法分析的关键。状态机包含一系列的状态,每个状态代表解析过程中的一个阶段。输入Token时,状态机会根据当前状态和Token类型转换到下一个状态。

实现状态机时,应该:

- 定义清晰的状态转换规则,确保状态机能够正确地在不同状态间移动。

- 处理各种边缘情况,例如遇到无效的Token序列时应该返回错误。

- 状态机的实现应尽可能地简洁高效,避免过于复杂的逻辑。

## 示例代码

```python

import re

class Token:

def __init__(self, type_, value):

self.type = type_

self.value = value

class Lexer:

def __init__(self, text):

self.text = text

self.pos = 0

self.current_char = self.text[self.pos]

def error(self):

raise Exception('Invalid character')

def advance(self):

"""Advance the `pos` pointer and set the `current_char` variable."""

self.pos += 1

if self.pos > len(self.text) - 1:

self.current_char = None # Indicates end of input

else:

self.current_char = self.text[self.pos]

def skip_whitespace(self):

while self.current_char is not None and self.current_char.isspace():

self.advance()

def integer(self):

"""Return a multi-digit integer or float from the input."""

result = ''

while self.current_char is not None and self.current_char.isdigit():

result += self.current_char

self.advance()

if self.current_char == '.':

result += self.current_char

self.advance()

while self.current_char is not None and self.current_char.isdigit():

result += self.current_char

self.advance()

return float(result)

return int(result)

def _id(self):

"""Handle identifiers and reserved keywords"""

result = ''

while self.current_char is not None and re.match(r'[a-zA-Z_]', self.current_char):

result += self.current_char

self.advance()

return result

def get_next_token(self):

"""Lexical analyzer (also known as scanner or tokenizer)"""

while self.current_char is not None:

if self.current_char.isspace():

self.skip_whitespace()

continue

if self.current_char.isdigit():

return Token('INTEGER', self.integer())

if re.match(r'[a-zA-Z_]', self.current_char):

return Token('ID', self._id())

if self.current_char == '+':

self.advance()

return Token('PLUS', '+')

if self.current_char == '-':

self.advance()

return Token('MINUS', '-')

if self.current_char == '*':

self.advance()

return Token('MUL', '*')

if self.current_char == '/':

self.advance()

return Token('DIV', '/')

self.error()

return Token('EOF', None)

# 使用示例

if __name__ == '__main__':

text = "x = 100 + 200 * 300"

lexer = Lexer(t

```

0

0