Python自动化工具开发新篇章:结合tokenize实现代码自动化处理

发布时间: 2024-10-05 15:24:51 阅读量: 19 订阅数: 27

# 1. Python自动化工具开发新篇章介绍

Python作为一门广泛使用的编程语言,其强大的自动化能力在各个领域都展现出了独特的优势。随着技术的发展,对自动化工具的需求不断提高,Python在自动化工具的开发领域中也迎来了新的篇章。本章我们将探讨Python自动化工具开发的现状与未来的发展趋势,以及如何利用Python的高级特性来构建更为高效和强大的自动化工具。我们将从自动化工具的基本概念出发,深入分析其在代码处理、测试、部署等不同场景下的应用,为读者展示一个立体的Python自动化工具开发蓝图。

# 2. tokenize模块深入理解

## 2.1 tokenize模块概述

### 2.1.1 tokenize模块的定义和作用

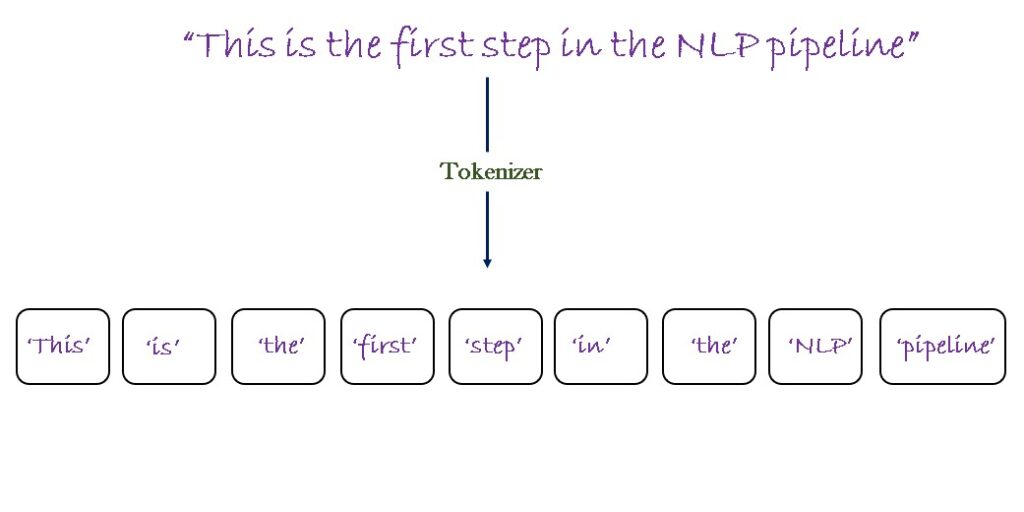

Python的`tokenize`模块是Python标准库的一部分,它提供了一个接口来将Python源代码分解成一个个的标记(tokens)。这些标记是Python代码的最小构成元素,如关键字、标识符、字面量和运算符。`tokenize`模块常被用于代码分析、代码格式化、代码转换、语法检查等场景。

理解`tokenize`模块对于进行Python代码的自动化处理至关重要,因为一切的自动化逻辑都建立在对代码构成元素的解析基础之上。通过`tokenize`模块,开发者可以详细了解代码的结构,并在此基础上实现复杂的代码操作。

### 2.1.2 tokenize模块与其他模块的比较

除了`tokenize`模块,Python还有其他的模块可用于代码分析,如`ast`模块用于生成抽象语法树(Abstract Syntax Tree),`inspect`模块可以用来检查对象的内部结构。`tokenize`模块与它们相比,更贴近于源代码的原始形态,提供的信息更为底层和原始。

`ast`模块更多地用于高级的代码分析和转换,而`tokenize`模块更适用于低级的源码分析。例如,在一个需要追踪Python源码中的每个元素的场景中,`tokenize`模块会是更合适的选择。

## 2.2 tokenize模块的核心组成

### 2.2.1 token类型和生成过程

`tokenize`模块将Python源代码分解成多个token,每个token都有一个类型,它用一个特定的字符串来表示。例如,`NAME`用于表示变量名,`NUMBER`用于表示数字字面量,`STRING`用于表示字符串字面量等。

生成token的过程通常分为以下步骤:

1. 读取源代码。

2. 分析源代码中的字符,并根据Python语言的语法规则判断字符的组合是否形成有效的token。

3. 根据识别到的token类型,创建相应的token对象。

### 2.2.2 token生成器的使用方法

`tokenize`模块提供了一个生成器函数`tokenize.tokenize()`,它接受源代码作为输入并产生一个迭代器,每次迭代返回一个包含token类型、值和行号等信息的元组。

以下是一个使用token生成器的基本示例代码:

```python

import tokenize

# 读取一段Python源代码

source_code = open('example.py', 'rb').read()

# 使用tokenize模块的tokenize方法

tokens = tokenize.tokenize(source_code.readline)

for toknum, tokval, _, _, _ in tokens:

print('%-20s %-20s' % (toknum, tokval))

```

这段代码将打开名为`example.py`的文件,并逐行读取内容,然后使用`tokenize.tokenize()`函数生成token,并打印每个token的类型和值。

## 2.3 tokenize模块的实际应用

### 2.3.1 常见代码解析案例分析

使用`tokenize`模块可以进行一系列的代码解析操作。例如,可以用来检测源代码中的语法错误,或者分析代码中使用的API。下面的代码片段展示了如何使用`tokenize`模块来检测源代码中的语法错误:

```python

import tokenize, io

source = """def foo():

print("hello world!")

tokens = tokenize.tokenize(io.BytesIO(source.encode('utf-8')).readline)

try:

for toknum, tokval, _, _, _ in tokens:

if toknum == tokenize.NL:

continue

print(tokval)

except tokenize.TokenError as err:

print('Invalid token:', err)

```

此代码读取源代码字符串,并尝试逐个token地解析它们。如果遇到非法的token,`tokenize`模块会抛出`TokenError`异常。

### 2.3.2 tokenize模块在代码分析中的优势

在进行代码分析时,`tokenize`模块提供了一个丰富的接口来处理代码。它的优势在于直接操作底层的token,而不是直接处理抽象语法树(AST)或源代码文本。这使得`tokenize`在以下几个方面具有优势:

- **精确性**:直接操作token意味着可以精确地控制和分析代码的语法结构。

- **灵活性**:不同类型的token可以用于不同的分析目的,例如,可以单独检查注释、字符串字面量或者复杂的表达式。

- **性能**:对于一些简单的代码检查和分析任务,直接使用token可能比构建和遍历AST更高效。

在进行代码自动化处理的项目中,开发者需要根据项目需求来选择最合适的工具。`tokenize`模块在进行细粒度的代码分析时,可以提供强大的支持。通过理解token的构成和类型,开发者可以进行更高效的代码解析和自动化处理。

# 3. 代码自动化处理的理论基础

## 3.1 代码自动化处理的需求与挑战

### 3.1.1 自动化处理的定义和优势

代码自动化处理是一种将人工干预从软件开发和维护过程中剥离出来的技术手段。这一过程涉及编写脚本或使用工具,以实现重复性任务的自动化,比如构建、测试、部署、监控等。自动化处理的优势在于减少人为错误、提升效率、确保过程的一致性,以及通过持续的反馈循环来加速开发周期。此外,它为开发者提供了更多时间去专注于创新和解决更复杂的编程问题。

### 3.1.2 自动化处理面临的技术挑战

尽管自动化带来了许多好处,但它也面临诸多技术挑战。首先,需要设计和实施一套有效的自动化策略,这可能包括选择合适的工具和框架。其次,必须确保自动化脚本或工具的健壮性和可靠性,因为一个

0

0