大数据与机器学习:在R语言中使用randomForest进行分布式计算

发布时间: 2024-11-02 02:11:03 阅读量: 35 订阅数: 37

# 1. 大数据与机器学习概述

## 1.1 大数据时代与机器学习

大数据与机器学习已成为IT行业发展最快的领域之一。随着互联网的普及和各种设备的连接,数据量呈指数级增长。机器学习作为大数据分析的关键技术,能够从这些海量数据中提取有价值的信息。

## 1.2 机器学习的应用场景

机器学习被广泛应用于个性化推荐、图像识别、自然语言处理、金融风险预测等多个领域。通过训练模型识别数据中的模式,机器学习在提高生产效率、降低成本等方面发挥着重要作用。

## 1.3 大数据与机器学习的挑战

尽管如此,大数据与机器学习也面临着数据隐私保护、算法的可解释性、模型的泛化能力等挑战。如何高效地处理大规模数据,优化模型性能,成为了研究者与工程师们努力解决的问题。

大数据与机器学习的关系日益密切,它们相辅相成,共同推动了信息技术的持续进步。

# 2. R语言基础及randomForest算法介绍

### 2.1 R语言简介及其在数据分析中的应用

#### 2.1.1 R语言的核心特性和优势

R语言自1997年由Ross Ihaka和Robert Gentleman开发以来,已经发展成为数据科学领域内不可或缺的工具之一。R语言的核心特性及优势在于以下几个方面:

- **统计和图形能力:** R语言最初是作为统计软件来设计的,因此在统计分析领域具有丰富的函数库和方法。其内置的图形功能非常强大,可以轻松绘制高质量的统计图表。

- **社区支持和扩展包:** R语言拥有一个庞大且活跃的社区,定期发布各种扩展包,涵盖从基础统计到深度学习的各类算法。

- **开源和自由:** R语言是完全开源的,任何人都可以自由地使用、修改和分发。

- **跨平台性:** R语言支持多种操作系统,包括Windows、MacOS以及各种UNIX/Linux系统。

#### 2.1.2 R语言在机器学习中的地位

在机器学习领域,R语言同样扮演着重要的角色。由于其与生俱来的统计背景,R语言在模型的开发、评估和可视化方面表现得尤为出色。众多的机器学习算法已经在R语言的扩展包中实现,其中最著名的如`caret`、`randomForest`、`xgboost`等。R语言的脚本语言特点,使得用户能够快速编写自定义模型,并且易于进行算法实验。同时,R语言也支持数据预处理、特征选择和模型调优等环节,为机器学习工程师提供了全方位的支持。

### 2.2 randomForest算法原理与实现

#### 2.2.1 随机森林算法基本概念

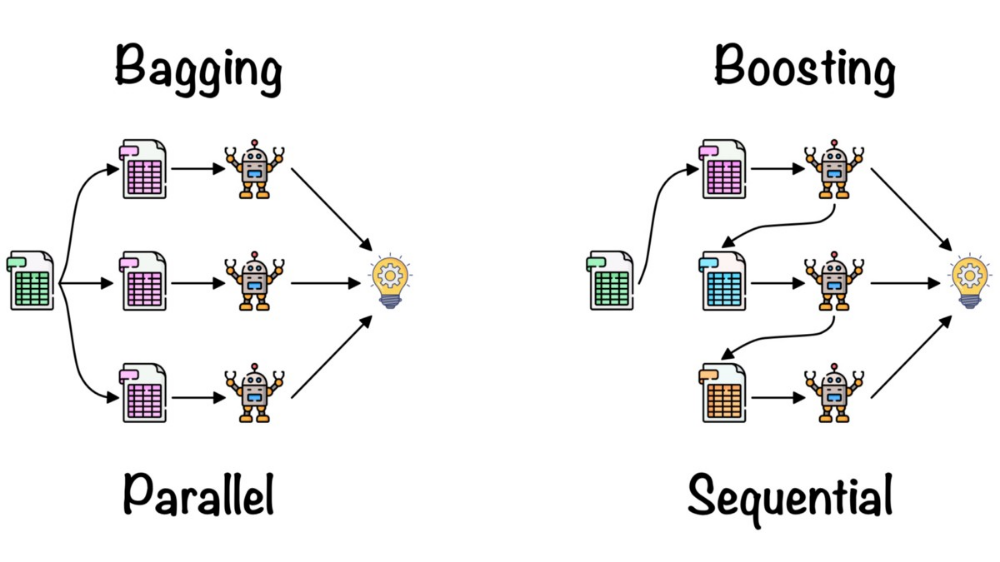

随机森林(randomForest)是一种集成学习方法,它由多个决策树组成,每个决策树对数据集进行独立学习,并最终通过对所有决策树的预测结果进行投票或平均来得到最终的预测结果。这种集成方法的优势在于通过组合多个弱学习器提高了整体的预测性能。

随机森林的基本原理是基于决策树的,它利用自助法(bootstrap aggregating,bagging)来构建每棵树,同时在选择分裂特征时引入了随机性。这种随机选择的特性使得随机森林对噪声和异常值具有很好的鲁棒性。

#### 2.2.2 randomForest包的安装与配置

为了在R语言中使用randomForest算法,首先需要安装`randomForest`包。可以使用以下R语言的命令进行安装:

```r

install.packages("randomForest")

```

安装完毕后,加载该包以备使用:

```r

library(randomForest)

```

加载了`randomForest`包后,就可以利用其中的`randomForest()`函数构建随机森林模型了。在进行模型训练之前,需要准备好数据集,确保数据已经被预处理过,如处理缺失值、标准化等。

### 2.3 随机森林算法的参数调优与应用实践

#### 2.3.1 常用参数及调优策略

`randomForest`函数提供了许多参数用于控制模型训练,其中一些常用的参数包括:

- `ntree`:森林中决策树的数量。

- `mtry`:在建立每棵决策树时考虑的随机变量数。

- `nodesize`:叶节点中最小的案例数。

- `importance`:是否在输出中评估变量的重要性。

调优策略通常涉及到对这些参数进行网格搜索(grid search),以找到最优参数组合。可以通过交叉验证的方式来评估不同参数设置下模型的预测性能,并选取效果最佳的参数配置。

#### 2.3.2 随机森林在小数据集上的应用实例

尽管随机森林在大数据集上的表现更为出色,但它同样适用于小数据集。以下是使用`randomForest`进行模型训练和预测的一个简单实例:

```r

# 加载数据集

data(iris)

# 分割数据集为训练集和测试集

set.seed(123)

trainIndex <- sample(1:nrow(iris), 0.7 * nrow(iris))

irisTrain <- iris[trainIndex, ]

irisTest <- iris[-trainIndex, ]

# 训练随机森林模型

rfModel <- randomForest(Species ~ ., data = irisTrain, ntree = 100, mtry = 3)

# 查看模型输出

print(rfModel)

# 对测试集进行预测

irisPred <- predict(rfModel, irisTest)

# 计算预测准确率

table(irisPred, irisTest$Species)

```

以上代码演示了如何使用随机森林算法对鸢尾花数据集进行分类,并在测试集上评估模型性能。在实际应用中,我们可以通过调整参数和增加数据预处理步骤来进一步优化模型性能。

# 3. 分布式计算基础与Hadoop平台介绍

## 3.1 分布式计算基础概念

### 3.1.1 分布式计算的定义与重要性

分布式计算是一个由物理上分散的多个计算单元组成,并通过网络连接协同工作,解决大规模计算问题的计算范式。在IT领域,随着数据量的增长和计算需求的提升,传统的集中式计算模型无法高效处理庞大数据集,这就凸显了分布式计算的重要性。

分布式系统能够在多个处理器之间分配计算和存储任务,提高了系统的可扩展性和容错能力。这样的特性使得分布式计算非常适合处理大数据,并且能够支持复杂的计算任务,比如机器学习算法的训练过程。相比于传统单机计算,分布式计算能显著降低计算时间,同时也可以处理超出单机内存限制的大数据集。

### 3.1.2 常见的分布式计算模型

在分布式计算领域,几种常见的模型被广泛用于设计和实现分布式系统,其中包括:

- MapReduce模型:由Google提出,是分布式计算中最流行的一种编程模型。它将复杂的数据处理任务分解为两个步骤:Map(映射)和Reduce(归约)。Map阶段并行处理输入数据,产生中间数据,而Reduce阶段则汇总中间数据,生成最终结果。

- 分布式存储模型:如HDFS(Hadoop Distributed File System),它是一个高容错性的分布式文件系统,设计用于运行在廉价硬件上,能够提供高吞吐量的数据访问。

- 数据流模型:适用于实时计算场景,数据流模型通过数据流图(如Apache Flink)表示计算任务,其中的节点表示操作,边表示数据流动。

## 3.2 Hadoop生态系统概述

### 3.2.1 Hadoop核心组件介绍

Hadoop是一个开源框架,允许用户在分布式环境中存储和处理大

0

0