PyTorch CNN损失函数的选择与优化:提升准确率的艺术

发布时间: 2024-12-11 15:26:05 阅读量: 10 订阅数: 15

# 1. PyTorch CNN损失函数概述

在深度学习尤其是卷积神经网络(CNN)的训练过程中,损失函数扮演着至关重要的角色。它不仅是衡量模型预测值与真实值差异的工具,还是指导模型优化的“指挥棒”。本章我们将从基础概念出发,探讨PyTorch中CNN损失函数的通用知识,为后续章节中更深入的分析和实际应用打下坚实的基础。

## 1.1 损失函数在PyTorch中的地位

在PyTorch框架中,损失函数通常由一个或多个基本的数学函数构成,能够对预测结果进行评分。在训练过程中,通过梯度下降算法,损失函数的值会被用来反向传播,从而更新网络的权重参数。这使得损失函数成为连接网络预测和真实标签的关键桥梁。

## 1.2 PyTorch支持的主要CNN损失函数

PyTorch提供多种预定义的损失函数,包括但不限于:

- 均方误差(MSE):常用于回归问题,衡量预测值与真实值差的平方。

- 交叉熵损失(Cross-Entropy):广泛用于分类问题,衡量的是预测概率分布与真实标签概率分布的差异。

- BCEWithLogitsLoss:结合了sigmoid激活函数与交叉熵损失,适用于二分类问题。

```python

import torch

import torch.nn as nn

# 交叉熵损失函数示例

criterion = nn.CrossEntropyLoss()

```

PyTorch通过其简洁的API设计,简化了损失函数的使用流程,但了解背后的工作原理和适用场景,对于优化模型性能同样重要。在接下来的章节中,我们将进一步探讨损失函数的理论基础、选择策略以及在实际应用中的调整和优化方法。

# 2. 损失函数的理论基础与选择

损失函数在深度学习模型的训练中起着至关重要的作用,它衡量了模型预测值与真实值之间的差异。损失函数的设计与选择直接影响模型的性能和训练过程的稳定性。在这一章节中,我们将深入探讨损失函数的理论基础,包括数学原理、常见的损失函数类型以及如何根据不同问题选择合适的损失函数。

## 2.1 损失函数的数学原理

### 2.1.1 损失函数定义及目的

损失函数(Loss Function)是用来估计模型预测值与实际值之间差异的函数。在机器学习中,我们希望找到一个模型,能够最小化损失函数,从而使得模型的预测值尽可能接近实际值。换言之,损失函数告诉我们模型的预测有多糟糕,我们希望通过优化算法来最小化这个“糟糕”的程度。

在数学上,损失函数可以表示为:

\[ L(y, \hat{y}) = \sum_{i=1}^{N} l(y_i, \hat{y}_i) \]

其中 \( y \) 是实际值,\(\hat{y}\) 是模型预测值,\( l \) 是单个样本的损失,\( N \) 是样本数量。

### 2.1.2 常见损失函数比较

在不同的深度学习任务中,有多种损失函数可以选择。以下是一些常见的损失函数及其适用情况的比较:

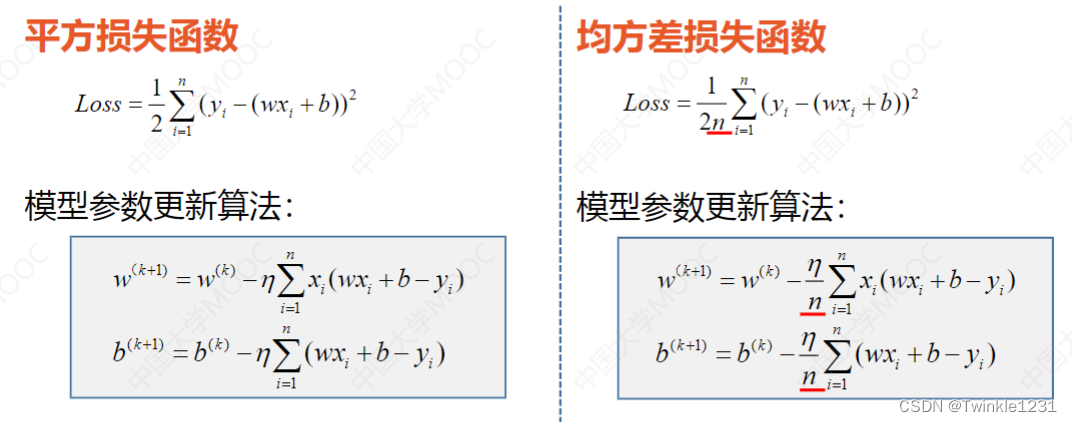

- 均方误差损失(MSE):通常用于回归问题中,因为它能够对预测误差进行平方,对较大的误差进行惩罚。

- 交叉熵损失(Cross-Entropy):主要用于分类问题,特别是多分类问题,它可以衡量两个概率分布之间的差异。

- 平均绝对误差(MAE):对于异常值不是特别敏感,相比于MSE可以提供更为鲁棒的训练过程。

## 2.2 CNN中的典型损失函数

### 2.2.1 均方误差损失(MSE)

MSE损失函数是一种衡量连续值预测错误的常用方式。对于回归问题,MSE通过计算预测值和真实值差的平方来定义损失。

数学表达式为:

\[ L(y, \hat{y}) = \frac{1}{N} \sum_{i=1}^{N} (y_i - \hat{y}_i)^2 \]

MSE的优缺点如下:

- **优点**:

- 计算简单,易于理解。

- 对于异常值较为敏感,有助于提升模型对这些点的预测精度。

- **缺点**:

- 对于大误差的惩罚过重,可能会导致梯度消失的问题。

- 在梯度下降过程中可能过于强调某些极端的误差值。

### 2.2.2 交叉熵损失(Cross-Entropy)

交叉熵是衡量两个概率分布之间差异的一种方式。在分类问题中,我们经常使用交叉熵作为损失函数。它的数学表达式为:

\[ L(y, \hat{y}) = - \frac{1}{N} \sum_{i=1}^{N} \sum_{c=1}^{M} y_{ic} \log(\hat{y}_{ic}) \]

其中 \( M \) 是分类的类别数,\( y_{ic} \) 表示第 \( i \) 个样本是否属于类别 \( c \) 的指示变量(是则为1,否则为0),\(\hat{y}_{ic}\) 是模型对于第 \( i \) 个样本属于类别 \( c \) 的预测概率。

交叉熵损失函数的优点在于:

- 可以加速模型的学习过程,特别是在类别不平衡的情况下。

- 对于概率预测值,当预测概率接近真实概率时,损失增加较小,有利于模型精细调整。

## 2.3 损失函数的选择策略

### 2.3.1 分类问题的损失函数选择

对于分类问题,选择合适的损失函数至关重要。在多分类问题中,交叉熵损失是主流的选择。然而,在某些特定情况下,也可以考虑其他损失函数,如Focal Loss,它主要用于处理类别不平衡的问题。

Focal Loss通过减少易分类样本的权重,增加难分类样本的权重,以解决类别不平衡问题。其表达式如下:

\[ FL(p_t) = -\alpha_t (1 - p_t)^\gamma \log(p_t) \]

其中 \( p_t \) 是预测概率,\( \alpha \) 是平衡参数,\( \gamma \) 是调节难易样本权重的参数。

### 2.3.2 回归问题的损失函数选择

对于回归问题,损失函数的选择相对直接一些。MSE是最常用的损失函数,适用于连续值的预测。然而,在某些情况下,比如数据中存在异常值时,可以考虑使用平均绝对误差(MAE)来减少异常值的影响:

\[ L(y, \hat{y}) = \frac{1}{N} \sum_{i=1}^{N} |y_i - \hat{y}_i| \]

MAE相较于MSE来说,对异常值的敏感性较低,但梯度信息相对较少,可能影响训练过程的稳定性。

通过对比不同类型的损失函数,我们可以根据具体问题和数据特点选择适合的损失函数,以优化模型性能。在下一章节中,我们将探讨如何实现自定义损失函数以及如何在实践中调优损失函数的参数。

# 3. 损失函数的实践应用与调优技巧

## 3.1 实现自定义损失函数

在深度学习中,有时候我们需要超越传统的损失函数,以适应特定的需求或解决特定的问题。自定义损失函数是实现这一目标的有效方法。它允许我们对模型的训练过程进行更细致的控制,并根据实际情况调整学习过程。

### 3.1.1 自定义损失函数的构建方法

构建一个自定义损失函数,首先需要理解损失函数在训练过程中的角色和目的。损失函数衡量的是模型预测值与实际值之间的差异,指导模型参数的优化。自定义损失函数的构建步骤可以概括为:

1. 明确目标:首先需要明确我们希望损失函数达成的目标。例如,是否希望对某些错误类型给予更大的惩罚,或者是否希望损失函数对异常值更为鲁棒。

2. 定义数学表达:根据目标定义损失函数的数学表达式。这可能涉及到对现有损失函数的修改或创新。

3. 编码实现:将数学表达式转换为代码,并集成到训练循环中。

### 3.1.2 实例:基于PyTorch的自定义损失函数

下面通过一个实例来演示如何在PyTorch中实现自定义损失函数:

```python

import torch

import torch.nn as nn

import

```

0

0