【PyTorch CNN进阶】:揭秘前向传播与反向传播的神秘面纱

发布时间: 2024-12-11 13:45:40 阅读量: 12 订阅数: 15

MicroPythonforESP32快速参考手册1.9.2文档中文pdf版最新版本

# 1. PyTorch CNN基础介绍

PyTorch是一个在深度学习领域被广泛使用的开源机器学习库。它使用动态计算图,允许对计算图进行任意操作,非常灵活且易于理解。CNN(Convolutional Neural Networks)即卷积神经网络,是深度学习中一种用于图像识别和处理的神经网络结构,以其高效的参数共享和空间不变特性在图像和视频识别,自然语言处理等方面展现出卓越的性能。接下来,我们将对PyTorch中CNN的基础内容进行详细介绍,帮助初学者构建模型并理解其工作原理。

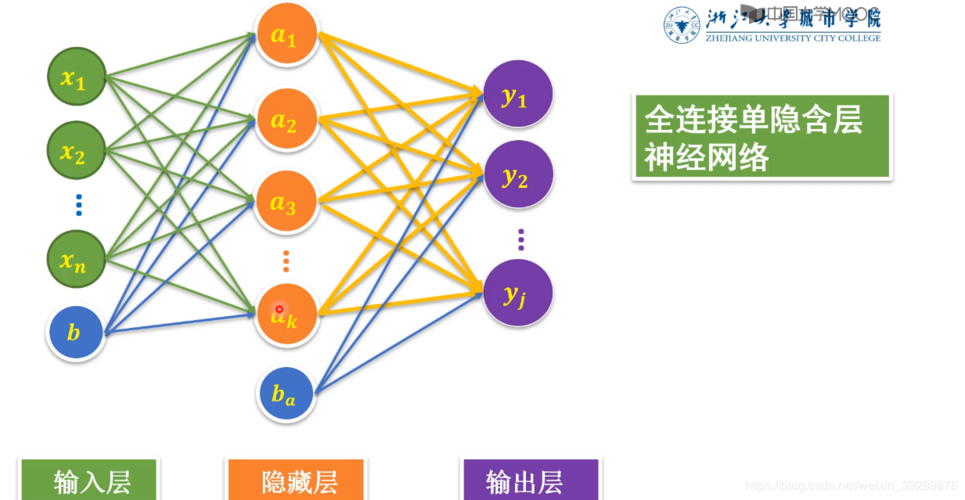

# 2. 前向传播的深入解析

在上一章中,我们对PyTorch的基本概念和CNN的基础知识进行了介绍。现在,我们深入到CNN的核心工作流程之一:前向传播。前向传播是神经网络中信息流动的主方向,从输入层经过隐藏层,最终输出结果。本章将详细解析前向传播的各个环节,包括其基本概念、关键技术以及性能优化。

## 2.1 前向传播的基本概念

### 2.1.1 理解前向传播的角色和重要性

前向传播是在神经网络中数据流动的基本路径。在这一步,输入数据通过网络结构的每一层,每一层中的神经元会对输入数据进行加权求和,加上偏置后通过激活函数产生输出。理解前向传播的重要性,关键在于明白它是实现数据处理和特征提取的机制。

前向传播在CNN中尤为重要,因为它直接决定着模型的预测能力和最终输出。了解前向传播的工作原理,对于后期调整网络结构和改进模型性能至关重要。

### 2.1.2 前向传播在CNN中的实现

在CNN中,前向传播的实现涉及到卷积层、池化层和全连接层等主要组成部分。下面是这些层在前向传播中的具体作用:

- **卷积层**:负责提取输入数据的局部特征,通过滤波器(核)与输入数据进行卷积操作。

- **池化层**:对卷积层的输出进行下采样,减少特征图的空间尺寸,同时保留重要信息。

- **全连接层**:在CNN的最后阶段,将特征图转换为最终的输出结果。

## 2.2 前向传播中的关键技术

### 2.2.1 卷积层的工作原理

卷积层是CNN的核心,其工作原理是通过卷积核在输入数据上滑动,并对滑动窗口内的元素进行点乘加权求和操作。下面是卷积操作的一个简化代码示例,用以展示其在PyTorch中的实现:

```python

import torch

import torch.nn as nn

# 创建一个随机输入数据

x = torch.randn(1, 1, 28, 28) # Batch size 1, 1 channel, 28x28 image

conv = nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3, stride=1, padding=1)

# 前向传播

output = conv(x)

print(output.shape) # 输出的特征图尺寸

```

以上代码定义了一个卷积层,并在一张随机生成的图像数据上进行前向传播。输出的形状取决于卷积层的参数,如`out_channels`、`kernel_size`、`stride`和`padding`等。

### 2.2.2 池化层的作用和实现

池化层,又称为下采样层,主要作用是减小特征图的尺寸,以降低计算复杂度和防止过拟合。最常见的池化操作是最大池化和平均池化。以下是最大池化操作的一个代码示例:

```python

pool = nn.MaxPool2d(kernel_size=2, stride=2)

# 使用池化层

output = pool(x)

print(output.shape) # 输出的特征图尺寸

```

在这段代码中,我们使用`MaxPool2d`定义了一个最大池化层,然后将其应用到输入数据`x`上。输出的特征图尺寸是原始尺寸的一半。

### 2.2.3 全连接层的构建和作用

全连接层是将卷积层和池化层提取的特征进行整合,并转化为最终的预测输出。在PyTorch中,全连接层由`nn.Linear`模块实现,下面是一个代码示例:

```python

fc = nn.Linear(in_features=32*7*7, out_features=10)

# 假设x为卷积层和池化层处理后的输出

x = torch.flatten(x, 1)

output = fc(x)

print(output.shape) # 输出的尺寸为1x10,对应10个类别的预测概率

```

在这段代码中,我们首先将卷积层和池化层的输出通过`flatten`操作转换为一维向量,然后通过全连接层进行分类。`in_features`是全连接层输入特征的数量,它通常等于最后一个卷积层输出特征图的元素总数。

## 2.3 前向传播的性能优化

### 2.3.1 理解并解决前向传播中的瓶颈

在前向传播中,性能瓶颈往往出现在卷积操作中,因为卷积操作往往需要大量的计算资源。要解决这一问题,我们可以采用一些优化技巧,比如使用稀疏卷积、分组卷积或者引入高效的卷积算法。

### 2.3.2 前向传播中硬件加速的应用

硬件加速,尤其是利用GPU加速,是提高前向传播性能的重要手段。现代深度学习框架都支持GPU运算,PyTorch中的`torch.cuda`模块提供了GPU加速的功能。以下是如何将模型移到GPU上运行的代码示例:

```python

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model = nn.Sequential(

nn.Conv2d(...), # 卷积层

nn.MaxPool2d(...), # 池化层

nn.Linear(...), # 全连接层

).to(device)

# 将数据移动到GPU上

x = x.to(device)

output = model(x)

```

通过上述方法,前向传播的速度可以显著提升,这对于处理大规模数据集尤为关键。

# 3. 反向传播的机制与应用

## 3.1 反向传播的理论基础

### 3.1.1 梯度下降法和链式法则

反向传播是神经网络训练的核心算法之一,它基于梯度下降法,通过计算损失函数相对于网络参数(权重和偏置)的梯度,以最小化损失函数值。链式法则是反向传播的基础,它允许我们通过链式法则计算复合函数的导数,也就是网络中每一层输出相对于输入的导数。这些导数是调整权重和偏置以减少误差的关键所在。

梯度下降法可以通过以下公式表示:

```

theta = theta - learning_rate * dLoss/dtheta

```

其中,`theta`代表网络参数,`learning_rate`是学习率,`dLoss/dtheta`是损失函数关于参数的梯度。

### 3.1.2 反向传播算法的数学原理

在数学层面,反向传播算法涉及偏导数和全导数的计算,这可以通过链式法则来实现。假设我们有一个由多个层组成的神经网络,其中第`l`层的激活函数表示为`a^l`,权重矩阵为`W^l`,偏置向量为`b^l`,输入向量为`x`,那么每一层的前向传播可以表示为:

```

z^l = W^l * a^(l-1) + b^l

a^l = f(z^l)

```

其中`f`是激活函数,通常是非线性的。当计算损失函数`L`关于参数`W^l`和`b^l`的梯度时,需要对每一层进行反向传播。这一过程通常涉及以下步骤:

1. 从输出层开始,计算损失函数`L`关于`z^l`的导数。

2. 利用链式法则计算损失函数关于`a^(l-1)`的导数。

3. 重复以上步骤,逐步向输入层反向计算。

4. 使用得到的梯度信息更新网络参数。

反向传播算法的每一次迭代都涉及这样的计算,目的是找到参数的一个小的更新方向,使得损失函数减小。

## 3.2 反向传播的实践步骤

### 3.2.1 计算损失函数的梯度

在实践中,计算损失函数的梯度通常涉及自动微分工具,如PyTorch中的`torch.autograd`模块。计算过程是自动化的,但在理解反向传播时,我们仍然需要了解基本原理。

以下是一个简单的例子,展示如何使用PyTorch计算损失函数关于权重的梯度:

```python

import torch

# 假设我们有一个简单模型和损失函数

w = torch.tensor([3.0], requires_grad=True)

x = torch.tensor([2.0], requires_grad=True)

y = torch.tensor([5.0], requires_grad=False)

# 定义损失函数

def compute_loss(w, x, y):

return (w * x - y)**2

# 计算损失

loss = compute_loss(w, x, y)

# 反向传播:计算梯度

loss.backward()

# 输出梯度

print('梯度:', w.grad)

```

在这个例子中,`backward()`函数被调用来执行反向传播,并计算损失函数相对于权重`w`的梯度。

### 3.2.2 更新权重和偏置

在梯度计算之后,更新权重和偏置是通过梯度下降或其变种(如Adam、RMSprop等优化算法)来完成的。权重更新的通用步骤如下:

```python

# 设置学习率

learning_rate = 0.1

# 更新权重

w -= learning_rate * w.grad

# 清除梯度缓存

w.grad.zero_()

```

上面的代码展示了如何在计算梯度后使用学习率来更新权重。`zero_()`函数用于清除梯度,以避免在下一次迭代中累加梯度。

## 3.3 反向传播中的高级策略

### 3.3.1 批量归一化(Batch Normalization)的原理与应用

批量归一化是一种在深度学习中广泛使用的技术,它通过对每个小批量数据进行归一化来解决内部协变量偏移问题,并可以提高模型的泛化能力。批量归一化的公式如下:

```

BN(x) = gamma * (x - mean(x)) / sqrt(var(x) + epsilon) + beta

```

其中,`mean(x)`和`var(x)`分别是批量数据的均值和方差,`gamma`和`beta`是可训练的参数,用于控制归一化的缩放和偏移。通过在每个卷积层或全连接层之后添加批量归一化层,可以加快训练速度并允许使用更高的学习率。

批量归一化的一个关键好处是它减少了模型对输入数据尺度和分布的依赖,从而使得训练更加稳定。

### 3.3.2 正则化技术和防止过拟合

在神经网络训练中,正则化技术用于防止过拟合,即模型在训练数据上表现良好,但在未见过的数据上泛化能力差的情况。正则化可以通过修改损失函数来实现,通常有以下几种方式:

- L1正则化:在损失函数中加入权重的L1范数

- L2正则化:在损失函数中加入权重的L2范数

- Dropout:在训练过程中随机“丢弃”(设置为0)一些神经元的激活

正则化通过惩罚模型复杂度来防止过拟合,通常在损失函数中添加额外的项来实现。例如,L2正则化的加入可以表示为:

```python

def l2_regularized_loss(model, loss_function, lambda_l2):

reg_loss = torch.tensor(0.).to(device)

for param in model.parameters():

reg_loss += torch.norm(param, p=2)

return loss_function + (lambda_l2 * reg_loss)

```

在这个函数中,`model`是我们的神经网络模型,`loss_function`是用于计算原始损失的函数,`lambda_l2`是L2正则化的强度。通过这种方式,我们既考虑了模型对训练数据的拟合程度,也考虑了模型参数的大小,从而可以提高模型的泛化能力。

# 4. CNN进阶技巧与实战案例

## 4.1 CNN的高级架构和优化技术

### 4.1.1 残差网络(ResNet)和其变种

残差网络(Residual Network,简称ResNet)是一种突破传统卷积网络深度限制的重要架构。其核心思想是引入了“残差学习”的概念,通过引入跳过一层或多层的“捷径”(也称为“跳跃连接”或“短路连接”)来解决深层网络训练中梯度消失或爆炸的问题。ResNet的一个关键特征是它允许网络层直接学习残差映射,而不是期望每层都去直接拟合所需的映射。

残差块(Residual Block)是ResNet架构的核心,它将输入数据加到卷积层的输出上,通过这种方式可以帮助梯度直接回流到前面的层,解决了训练深度网络时的困难。

```python

class ResidualBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1, downsample=None):

super(ResidualBlock, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1, bias=False)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace=True)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1, bias=False)

self.bn2 = nn.BatchNorm2d(out_channels)

self.downsample = downsample

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

if self.downsample:

residual = self.downsample(x)

out += residual

out = self.relu(out)

return out

```

参数说明:

- `in_channels`: 输入特征图的通道数。

- `out_channels`: 输出特征图的通道数。

- `stride`: 卷积操作的步长。

- `downsample`: 一个可选模块,用来调整输入特征图的维度,以匹配残差块输出的维度。

该代码段展示了ResNet中的一个典型残差块的实现,它由两层卷积组成,每层后面都有一个批量归一化层(Batch Normalization)和ReLU激活函数。如果残差块的输入和输出维度不同,`downsample`模块(通常是一个卷积层)会用来将输入进行适当的变换。

### 4.1.2 神经网络压缩与加速技术

随着深度学习模型变得越来越复杂,它们对计算资源的需求也在不断增加。神经网络压缩和加速技术的目的是减少模型的大小和提高计算效率,从而使得模型能够运行在硬件资源有限的设备上,例如手机、嵌入式设备和物联网设备。

网络压缩技术主要包括参数剪枝(Pruning)、权重共享(Weight Sharing)、知识蒸馏(Knowledge Distillation)和低秩分解(Low-rank Factorization)等。

```python

def prune_model(model, pruning_rate):

pruned_weights = []

for name, module in model.named_modules():

if isinstance(module, nn.Conv2d):

prune_rate = pruning_rate

total_weights = module.weight.numel()

num_pruned = int(total_weights * prune_rate)

flattened = module.weight.view(-1)

threshold, _ = torch.topk(flattened.abs(), num_pruned, largest=False, sorted=False)

prune_value = threshold[-1]

mask = flattened.le(prune_value).float()

pruned_weights.append(mask)

module.register_buffer('weight_mask', mask.view_as(module.weight))

module.weight.data *= mask

return pruned_weights

```

参数说明:

- `model`: 要进行剪枝的模型。

- `pruning_rate`: 要剪枝的比例,是一个介于0到1之间的数,表示要剪枝掉权重的比例。

该函数通过设定一个阈值,将低于阈值的权重设置为0,实现了网络权重的剪枝。这是通过计算每个卷积层权重的绝对值,然后根据剪枝比例找到一个阈值,并将所有小于这个阈值的权重置零实现的。剪枝后的模型将只保留重要的权重,从而减少模型的存储需求和计算复杂度。

## 4.2 实际应用中的CNN模型调整

### 4.2.1 数据增强技术

数据增强(Data Augmentation)是深度学习中广泛使用的一种技术,用于扩大训练数据集的多样性,以此来提升模型的泛化能力。通过应用一系列变换(如旋转、缩放、翻转、裁剪等)到训练数据上,可以生成新的训练样本,减少模型对训练数据的过拟合,并提高其在未见数据上的表现。

```python

class CustomAugmentation:

def __call__(self, image, label):

if random.random() > 0.5:

image = TF.rotate(image, angle=15)

if random.random() > 0.5:

image = TF.hflip(image)

return image, label

transform = transforms.Compose([

transforms.Resize((224, 224)),

CustomAugmentation(),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

```

参数说明:

- `transforms.Compose()`: 将多个图像变换操作组合起来。

- `transforms.Resize()`: 将输入图像调整为指定的大小。

- `CustomAugmentation()`: 自定义的图像增强函数,包含旋转和水平翻转操作。

- `transforms.ToTensor()`: 将PIL图像或NumPy数组转换为Tensor。

- `transforms.Normalize()`: 对输入张量进行归一化处理。

数据增强通过定义一系列的图像变换操作,并使用PyTorch的`transforms`模块组合这些操作来实现。在这个例子中,我们创建了一个自定义的数据增强类`CustomAugmentation`,它在训练过程中随机应用旋转和水平翻转操作来增加数据多样性。

### 4.2.2 超参数的调整与优化

超参数是学习算法在学习之前就需要设定好的参数,与模型内部参数不同,超参数不能通过训练得到。超参数的调整对模型的性能有重要的影响,因此找到一组良好的超参数是非常关键的。超参数的调整通常需要大量的实验,并结合领域知识和经验。

超参数的调整可以采用手动调整、网格搜索(Grid Search)、随机搜索(Random Search)和贝叶斯优化(Bayesian Optimization)等方法。

```markdown

| 超参数 | 描述 | 可能的值或范围 |

| --- | --- | --- |

| Learning Rate | 控制模型权重更新的速度 | [1e-4, 1e-1] |

| Batch Size | 训练数据集中每次训练的样本数 | [16, 128] |

| Number of Epochs | 训练过程中整个数据集被遍历的次数 | [10, 50] |

| Optimizer | 权重优化算法 | [SGD, Adam] |

```

表格说明了在训练深度学习模型时需要调整的一些关键超参数。学习率决定了模型权重更新的速度,影响收敛速度和最终性能;批大小决定了每次更新权重时所用的样本数量,影响内存占用和训练稳定性;训练周期(Epochs)的次数决定了模型从训练数据中学习的总次数,影响训练时间;优化器(Optimizer)用于更新模型权重,不同的优化器有不同的性能表现。

在实际操作中,我们往往需要对这些超参数进行反复试验,并利用验证集的性能反馈来指导调整。在一些情况下,贝叶斯优化等更智能的参数搜索方法可以有效地在超参数空间中进行搜索,找到最优或接近最优的超参数组合。

## 4.3 深入理解CNN模型的泛化能力

### 4.3.1 模型的验证与测试

在深度学习模型训练的过程中,模型的性能通常需要在验证集上进行评估。验证集用来评估模型对未见数据的泛化能力,同时也可以用来进行超参数调整。在训练完成后,最终的模型评估通常在测试集上进行,确保模型的评估结果是独立和客观的。

```python

class ModelEvaluation:

def __init__(self, model, criterion):

self.model = model

self.criterion = criterion

def validate(self, dataloader):

self.model.eval()

total_loss = 0

correct = 0

with torch.no_grad():

for inputs, labels in dataloader:

outputs = self.model(inputs)

loss = self.criterion(outputs, labels)

total_loss += loss.item()

_, predicted = torch.max(outputs.data, 1)

correct += (predicted == labels).sum().item()

val_loss = total_loss / len(dataloader)

val_accuracy = correct / len(dataloader.dataset)

return val_loss, val_accuracy

model = ... # 某已训练好的模型

criterion = nn.CrossEntropyLoss()

evaluator = ModelEvaluation(model, criterion)

val_loss, val_accuracy = evaluator.validate(val_dataloader)

print(f"Validation Loss: {val_loss}, Validation Accuracy: {val_accuracy}")

```

参数说明:

- `model`: 待评估的模型。

- `criterion`: 用于计算损失的函数,例如交叉熵损失。

- `dataloader`: 提供数据的迭代器,可以是验证集或测试集。

这个代码段展示了如何使用一个简单的`ModelEvaluation`类在验证集上评估CNN模型。它计算了平均损失和准确率,这两个指标通常用于衡量模型的性能。`model.eval()`告诉模型进入评估模式,关闭如Dropout和Batch Normalization等层的随机行为。

### 4.3.2 迁移学习在CNN中的应用

迁移学习是一种机器学习方法,允许我们在一个任务上学习的知识应用到另一个不同但相关的任务上。在深度学习中,通常是指将一个在大型数据集上预先训练好的模型(如ImageNet)应用到一个数据量较少的新任务上。通过这种方式,可以利用预先学习到的特征表示来加速和改善新任务的学习效果。

```python

import torchvision.models as models

import torch.nn as nn

def transfer_learning_model(num_classes):

model = models.resnet18(pretrained=True)

model.fc = nn.Linear(model.fc.in_features, num_classes)

return model

num_classes = ... # 新任务的类别数

model_transfer = transfer_learning_model(num_classes)

for param in model_transfer.parameters():

param.requires_grad = False

model_transfer.fc.requires_grad = True

```

参数说明:

- `num_classes`: 新任务的数据集包含的类别总数。

- `pretrained=True`: 表示使用预训练的权重初始化模型。

- `model.fc.in_features`: 预训练模型的最后全连接层的输入特征数,需要根据新任务的类别数进行调整。

在迁移学习中,通常冻结预训练模型的大部分参数,并替换最后的全连接层来适应新任务的类别数。这样,模型可以快速适应新任务,同时保留对原始任务的有效特征提取能力。

在实际操作中,我们还可以对模型的某些层进行微调(fine-tuning),也就是让其在新的数据集上继续学习,以进一步提高模型对新任务的性能。这通常需要小心地选择哪些层进行微调,以及调整学习率等超参数,以避免破坏已有的有用特征。

# 5. PyTorch CNN进阶项目实践

## 5.1 项目准备和环境搭建

在开始进行CNN模型的进阶项目实践之前,环境搭建是必不可少的步骤。无论是新手还是资深开发者,在实践之前需要保证环境的稳定性和配置的正确性。

### 5.1.1 安装PyTorch环境和依赖库

PyTorch是一个开源的机器学习库,基于Python,广泛应用于计算机视觉和自然语言处理等任务。安装PyTorch和相关的依赖库是进行项目实践的第一步。

首先,访问PyTorch官方网站,根据你的系统环境(操作系统、CUDA版本等)选择合适的安装命令。安装命令通常以`pip`或`conda`开始。例如,使用`pip`安装命令可能如下:

```shell

pip install torch torchvision torchaudio

```

或者,如果你使用的是`conda`环境,安装命令可能是:

```shell

conda install pytorch torchvision torchaudio -c pytorch

```

在安装了PyTorch之后,你还需要安装一些额外的库,例如`numpy`用于数值计算,`pandas`用于数据处理,以及`matplotlib`和`seaborn`用于数据可视化等。

```shell

pip install numpy pandas matplotlib seaborn

```

### 5.1.2 数据集的选取和处理

模型训练需要大量的数据。对于CNN模型而言,一个常见和易于获取的数据集是ImageNet,但是为了进行进阶实践,你可以选择更有挑战性的数据集,如CIFAR-100或Kaggle上的自定义数据集。

数据集的处理通常包括以下步骤:

1. 下载数据集,并解压缩到本地。

2. 对数据进行预处理,如图像的归一化处理,转化为模型可以接受的格式。

3. 构建数据加载器,以便于后续批量加载数据进行训练。

使用PyTorch进行数据处理的代码示例如下:

```python

import torch

from torchvision import datasets, transforms

# 数据预处理

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

# 加载数据集

train_dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

# 构建数据加载器

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=64, shuffle=False)

```

请注意,以上代码仅用于演示目的。在实际项目中,你可能还需要考虑数据增强、多线程读取等优化手段来提高模型训练的效率和效果。

## 5.2 定制化CNN模型开发

模型是任何机器学习项目的灵魂。为了在PyTorch中定制化你的CNN模型,你需要掌握如何设计一个合适的网络架构,以及如何训练和验证模型以确保其性能。

### 5.2.1 设计模型架构

设计一个有效的CNN模型架构需要对模型的深度、宽度、层数以及层与层之间的连接方式有深入的理解。现代的深度学习框架,如PyTorch,允许我们通过定义类和继承`nn.Module`来定制化地构建模型。

以下是一个简单的CNN模型架构的设计示例:

```python

import torch.nn as nn

import torch.nn.functional as F

class CustomCNN(nn.Module):

def __init__(self):

super(CustomCNN, self).__init__()

self.conv1 = nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(in_channels=32, out_channels=64, kernel_size=3, padding=1)

self.fc1 = nn.Linear(in_features=64*56*56, out_features=1024)

self.fc2 = nn.Linear(in_features=1024, out_features=10)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.dropout = nn.Dropout(0.5)

def forward(self, x):

x = F.relu(self.conv1(x))

x = self.pool(x)

x = F.relu(self.conv2(x))

x = self.pool(x)

x = x.view(-1, 64*56*56) # Flatten the tensor for the fully connected layer

x = F.relu(self.fc1(x))

x = self.dropout(x)

x = self.fc2(x)

return x

model = CustomCNN()

```

这个简单的CNN架构包含了两个卷积层、两个最大池化层以及两个全连接层。输出层有10个神经元,对应于CIFAR-10数据集中的10个类别。

### 5.2.2 模型训练与验证

模型训练的目的是通过优化算法调整模型权重,使其在训练数据上表现良好。这通常涉及到前向传播和反向传播两个过程。

模型验证则是在保持不变的验证数据集上测试模型的泛化能力,确保模型不仅仅是在训练数据上过拟合。

以下是一个模型训练和验证的代码示例:

```python

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model.to(device)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(num_epochs):

running_loss = 0.0

for i, data in enumerate(train_loader, 0):

inputs, labels = data

inputs, labels = inputs.to(device), labels.to(device)

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 2000 == 1999: # 每2000个小批量打印一次

print(f'Epoch: {epoch + 1}, Batch: {i + 1}, Loss: {running_loss / 2000}')

running_loss = 0.0

print('Finished Training')

# 验证模型

correct = 0

total = 0

with torch.no_grad():

for data in test_loader:

images, labels = data

images, labels = images.to(device), labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct // total} %')

```

## 5.3 模型部署和应用扩展

在模型开发完成后,你可能想要将模型部署到生产环境中去。这一步涉及模型的导出与部署。此外,你还可以探讨模型在实际问题中的应用和调优。

### 5.3.1 模型导出与部署

模型一旦训练完成并验证其准确性,下一步就是将其部署到生产环境中。在PyTorch中,你可以使用`torch.save`将训练好的模型保存到磁盘,或者使用`torch.jit`进行模型的脚本化和优化。

```python

torch.save(model.state_dict(), 'model_weights.pth') # 保存模型权重

```

如果你想要导出整个模型,可以使用如下代码:

```python

torch.jit.save(torch.jit.script(model), 'model_scripted.pth')

```

模型部署到生产环境可以采用多种方式,例如使用Flask或FastAPI搭建一个简单的Web服务来提供模型预测的API接口。

### 5.3.2 模型在实际问题中的应用与调优

部署模型之后,模型在实际问题中的应用和调优是保证模型持续有效性的关键。你需要根据模型在实际应用中的表现进行调优。

1. **收集反馈**:持续收集用户反馈,了解模型在实际使用中遇到的问题。

2. **性能监控**:监控模型的性能指标,如准确性、响应时间等。

3. **数据更新**:根据新的数据不断更新和优化模型。

4. **优化策略**:对于模型的调优,可以尝试包括调整学习率、增加网络深度、改变激活函数等策略。

调优模型是一个循环迭代的过程,需要不断地测试、评估和改进。

请注意,以上章节内容紧密相连,贯穿了从项目准备、模型开发到部署的整个过程。在进行实际项目实践时,建议每个步骤都要深入理解并按照具体情况进行调整优化。

0

0