【模型评估指标】:深度学习与传统机器学习的评价方法比较

发布时间: 2024-09-02 07:56:19 阅读量: 219 订阅数: 83

# 1. 模型评估指标概述

在模型构建与优化的过程中,选择合适的评估指标至关重要。评估指标不仅帮助我们量化模型性能,也为模型的选择和比较提供了依据。本章将介绍评估指标的基本概念,并从广义上概述模型评估的重要性和相关性。

## 1.1 为何需要模型评估指标

为了确保模型能够准确地反映数据中的关系,我们需要定量的方法来衡量其性能。评估指标可以提供这种度量,并指导我们进行模型改进。指标的选择反映了模型优化的目标,如减少错误分类的数量或是最小化预测误差。

## 1.2 模型评估指标的作用

评估指标的作用体现在多个层面:

- **性能度量**:它们提供了一个量化模型表现的方式。

- **决策支持**:在不同模型间做出选择时,评估指标能提供决策依据。

- **优化目标**:在模型训练过程中,这些指标通常作为损失函数的代理,帮助算法优化模型参数。

随着模型变得越来越复杂,评估指标的重要性也日益凸显。下一章节,我们将详细探讨传统机器学习模型评估指标,并通过具体实例展示这些指标如何应用于实践。

# 2. 传统机器学习模型评估指标

在传统机器学习领域,评估指标的选择至关重要,因为它们可以直观地反映出模型的性能。本章将深入探讨分类问题和回归问题的评估指标,以及集成学习的评估方法。

## 2.1 分类问题的评估指标

### 2.1.1 准确率、精确率、召回率和F1分数

在分类问题中,准确率、精确率、召回率和F1分数是评估模型性能的常用指标。

- **准确率(Accuracy)** 表示模型预测正确的样本数占总样本数的比例。它是对模型整体预测正确性的最直观反映。

```python

from sklearn.metrics import accuracy_score

# 假设 y_true 是真实的标签,y_pred 是模型预测的标签

accuracy = accuracy_score(y_true, y_pred)

print(f"模型的准确率为: {accuracy}")

```

- **精确率(Precision)** 是指模型预测为正的样本中,实际为正的样本所占的比例。它衡量的是模型预测正样本的准确性。

```python

from sklearn.metrics import precision_score

precision = precision_score(y_true, y_pred)

print(f"模型的精确率为: {precision}")

```

- **召回率(Recall)** 又称为真正率,表示在所有实际为正的样本中,模型预测为正的比例。它衡量的是模型对于正样本的识别能力。

```python

from sklearn.metrics import recall_score

recall = recall_score(y_true, y_pred)

print(f"模型的召回率为: {recall}")

```

- **F1分数(F1 Score)** 是精确率和召回率的调和平均值,用于衡量模型的精确度和召回率的平衡。F1分数越接近1,表示模型越好。

```python

from sklearn.metrics import f1_score

f1 = f1_score(y_true, y_pred)

print(f"模型的F1分数为: {f1}")

```

在使用这些指标时,需要注意的是,它们之间的关系并不是线性的,而是一个平衡的过程。例如,在一些需要对正样本非常敏感的场景下,我们会更加关注召回率。

### 2.1.2 ROC曲线和AUC值

ROC曲线(Receiver Operating Characteristic curve)和AUC值(Area Under Curve)是用于分类模型性能评估的另一种方法。

- **ROC曲线** 是一个以真正率(召回率)为纵轴,假正率(1-特异度)为横轴的曲线。它通过改变阈值来描绘模型预测正样本的能力。

- **AUC值** 是ROC曲线下的面积,用于评估模型的整体性能。AUC值越大,表示模型性能越好。

```python

from sklearn.metrics import roc_curve, auc

import matplotlib.pyplot as plt

fpr, tpr, thresholds = roc_curve(y_true, y_pred)

roc_auc = auc(fpr, tpr)

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

```

ROC曲线和AUC值可以有效地解决类别不平衡问题。在不同场景下,我们可以通过对比不同的模型的ROC曲线来选择最佳模型。

## 2.2 回归问题的评估指标

### 2.2.1 均方误差(MSE)、均方根误差(RMSE)

回归问题中,最常用的评估指标是均方误差(MSE)和均方根误差(RMSE)。

- **均方误差(MSE)** 是预测值与实际值差的平方的均值。它对大的误差给予了更大的惩罚。

```python

from sklearn.metrics import mean_squared_error

mse = mean_squared_error(y_true, y_pred)

print(f"模型的MSE为: {mse}")

```

- **均方根误差(RMSE)** 是MSE的平方根,具有与原数据相同的度量单位,便于解释。

```python

rmse = mean_squared_error(y_true, y_pred, squared=False)

print(f"模型的RMSE为: {rmse}")

```

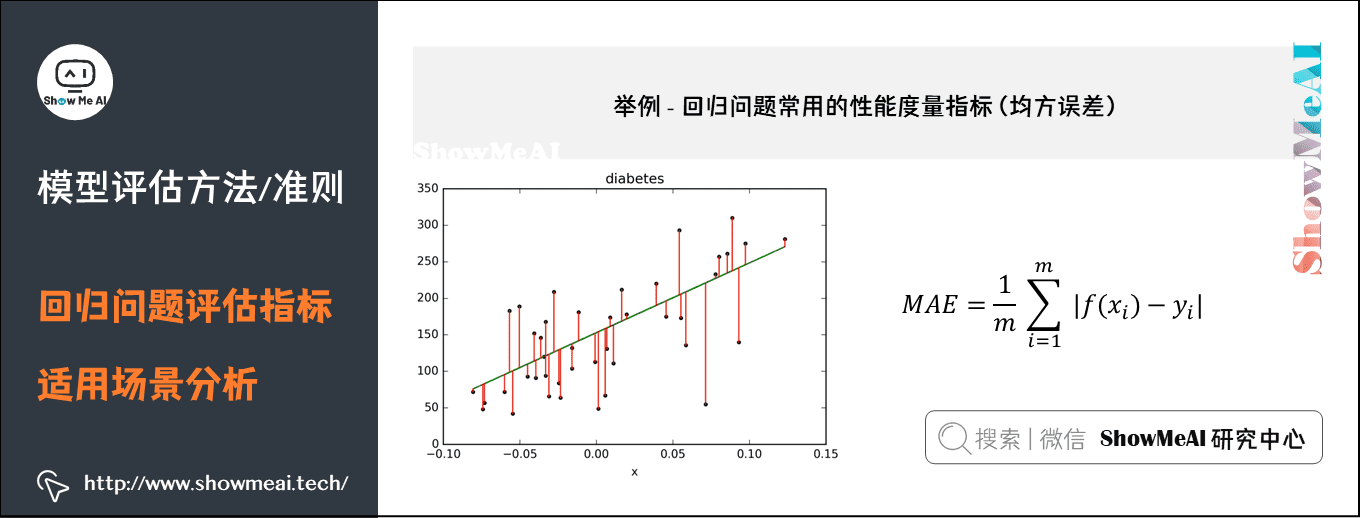

### 2.2.2 决定系数(R²)和平均绝对误差(MAE)

- **决定系数(R²)** 表示模型对实际数据的拟合程度。它的值越接近1,表示模型拟合越好。

```python

from sklearn.metrics import r2_score

r_squared = r2_score(y_true, y_pred)

print(f"模型的R²为: {r_squared}")

```

- **平均绝对误差(MAE)** 表示预测值与实际值差的绝对值的均值。它对误差的大小不敏感,适合异常值较多的数据集。

```python

from sklearn.metrics import mean_absolute_error

mae = mean_absolute_error(y_true, y_pred)

print(f"模型的MAE为: {mae}")

```

在回归问题中,选择合适的评估指标需要考虑到数据的特性以及模型的目标。例如,在金融领域,模型预测的精确度要求较高,可以优先考虑RMSE指标;而在对异常值不敏感的情况下,MAE可能更为适用。

## 2.3 集成学习的评估方法

### 2.3.1 堆叠、提升和bagging方法的评估

集成学习通过组合多个模型来提高总体性能,其评估方法通常包括堆叠(Stacking)、提升(Boosting)和bagging等策略。

- **堆叠(Stacking)** 是一种元学习方法,通过训练一个模型来组合其他模型的预测结果。对于堆叠模型的评估,我们不仅需要关注单个模型的性能,还要考虑最终融合后模型的表现。

- **提升(Boosting)** 是一种逐步改进模型性能的方法。提升方法中,如AdaBoost和Gradient Boosting,通过迭代地调整样本的权重和模型的参数来提升整体性能。评估提升方法时,通常需要关注模型在多个迭代轮次的性能变化。

- **Bagging**,即自助聚集,是通过并行地训练多个模型,并通过投票或平均的方式集成预测结果。对于bagging模型,如Random Forest,我们可以通过观察单个决策树的性能,和整合后模型的性能来评估。

### 2.3.2 OOB评分和交叉验

0

0